☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

本文作者来自香港科技大学、香港大学和华为诺亚方舟实验室等机构。其中第一作者陈铠、苟耘豪、刘智立为香港科技大学在读博士生,黄润辉为香港大学在读博士生,谭达新为诺亚方舟实验室研究员。

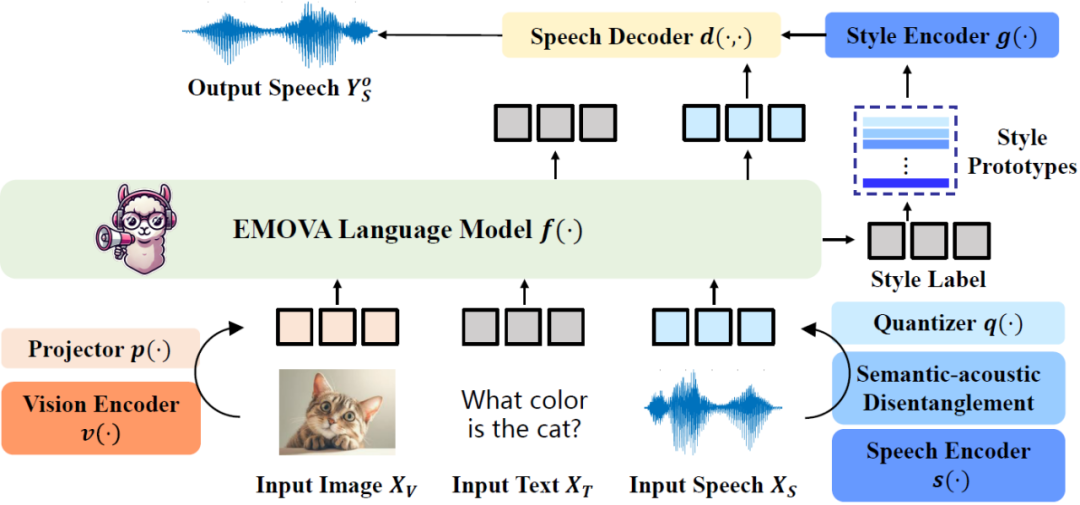

随着 OpenAI GPT-4o 的发布,大语言模型已经不再局限于文本处理,而是向着全模态智能助手的方向发展。这篇论文提出了 EMOVA(EMotionally Omni-present Voice Assistant),一个能够同时处理图像、文本和语音模态,能看、能听、会说的多模态全能助手,并通过情感控制,拥有更加人性化的交流能力。以下,我们将深入了解 EMOVA 的研究背景、模型架构和实验效果。

[详细内容](https://mp.weixin.qq.com/s?__biz=MzA3MzI4MjgzMw==&mid=2650936793&idx=3&sn=55e737d060d80fed7c3f69797403dcf3&chksm=84e7d1a7b39058b1f1f0f53fd73dbefef7b63c31599e5260f58487bc87c9614be1f8c1179c9d&token=554618254&lang=zh_CN#rd)

EMOVA 提出了数据高效的全模态对齐,以文本模态作为媒介,通过公开可用的图像文本和语音文本数据进行全模态训练,而不依赖稀缺的图像 - 文本 - 语音三模态数据。实验发现:

- 模态间的相互促进:在解耦语义和声学特征的基础上,语音文本数据和图像文本不仅不会相互冲突,反而能够互相促进,同时提升模型在视觉语言和语音语言任务中的表现;

- 同时对齐优于顺序对齐:联合对齐图像文本和语音文本数据的效果明显优于顺序对齐(先图像文本对齐,再语音文本对齐,或反之),有效避免“灾难性遗忘”;

- 全模态能力激发:少量多样化的全模态指令微调数据,可以有效激发模型面对图像、文本和语音组合指令的响应能力和遵从性。

这种双模态对齐方法利用了文本作为桥梁,避免了全模态图文音训练数据的匮乏问题,并通过联合优化,进一步增强了模型的跨模态能力。

实验效果:性能领先,情感丰富

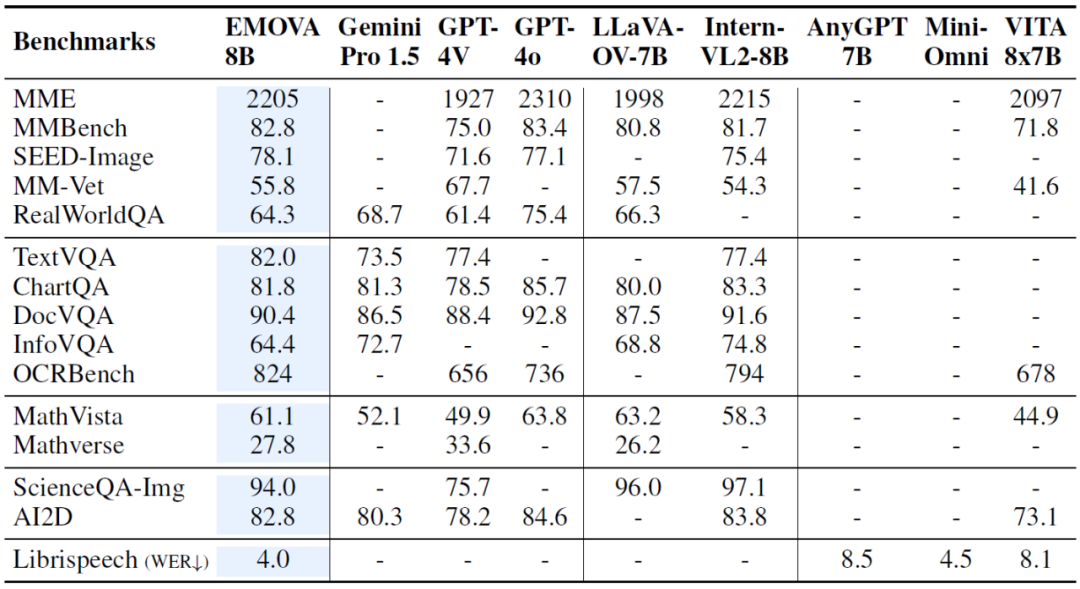

在多个图像文本、语音文本的基准测试中,EMOVA 展现了优越的性能:

- 视觉理解任务:EMOVA 在多个数据集上达到了当前的最佳水平,特别是在复杂的图像理解任务中表现尤为突出,如在 SEED-Image、OCR Bench 等榜单的性能甚至超过了 GPT-4o;

- 语音任务:EMOVA 不仅在语音识别任务上取得最佳性能,还能生成情感丰富、自然流畅的语音,展示了其语义声学分离技术和情感控制模块的有效性;

总的来说,EMOVA 是首个能够在保持视觉文本和语音文本性能领先的同时,支持带有情感的语音对话的模型。这使得它不仅可以在多模态理解场景表现出色,还能够根据用户的需求调整情感风格,提升交互体验。

总结:为 AI 情感交互提供新思路

EMOVA 作为全模态的情感语音助手,可实现端到端的语音、图像、文本处理。通过创新的语义声学分离和轻量化的情感控制模块,展现出优越的性能。EMOVA 在实际应用和研究前沿都具有巨大潜力,为未来 AI 提供了更加人性化的情感表达新思路。

参考文献:

[1] Liu, H., Li, C., Wu, Q., & Lee, Y. J. (2024). Visual instruction tuning. In NeurIPS.

[2] Chen, Z., Wu, J., et al. (2024). InternVL: Scaling up vision foundation models and aligning for generic visual-linguistic tasks. In CVPR.

[3] Xie, Z., & Wu, C. (2024). Mini-Omni: Language Models Can Hear, Talk While Thinking in Streaming. arXiv preprint arXiv:2408.16725.