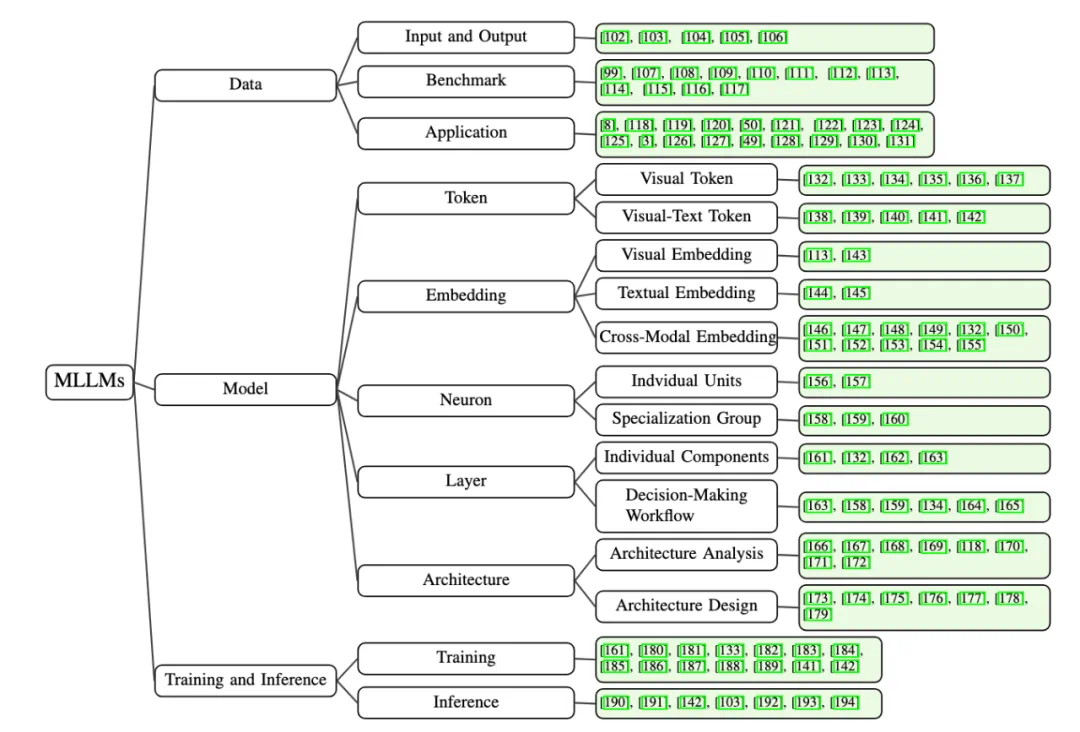

这篇综述论文探讨了多模态大型语言模型(mllm)的可解释性。研究人员来自香港科技大学(广州)、上海人工智能实验室、中国人民大学和南洋理工大学。该论文对 mllm 可解释性的研究进展进行了系统性梳理,并从数据、模型和训练/推理三个维度进行了深入分析。

本站 AIxiv 专栏长期报道全球顶级实验室的学术和技术成果,旨在促进学术交流。欢迎投稿或联系报道。联系邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

论文要点:

该论文提出了首个关于多模态大模型可解释性的全面综述。文章从三个维度探讨了 MLLM 的可解释性:

论文还深入分析了当前研究面临的核心挑战,并展望了未来的发展方向,旨在提高多模态大模型的透明度和可信度。

多模态大模型可解释性研究

近年来,大型语言模型(LLM)和计算机视觉(CV)技术的融合催生了多模态AI的蓬勃发展。多模态大模型在各种任务中展现出强大的能力,但其决策过程的缺乏透明度成为一个关键挑战。 这篇综述旨在解决这一问题,提升多模态大模型的可解释性和可信度。

研究维度:

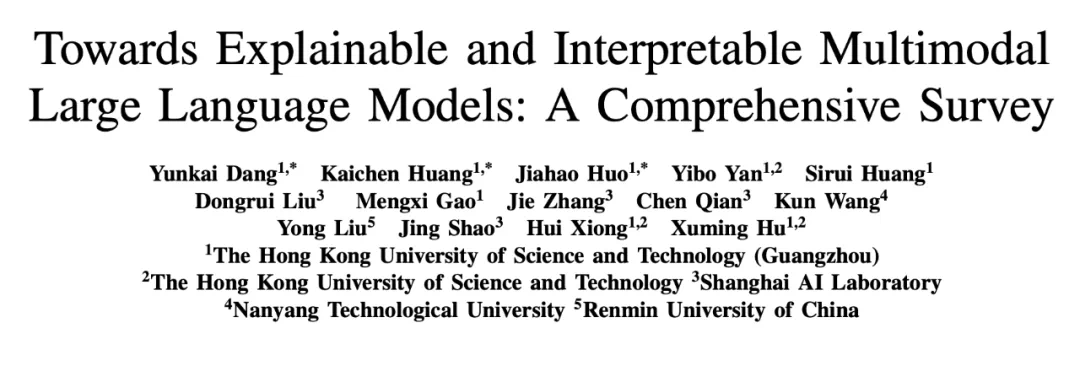

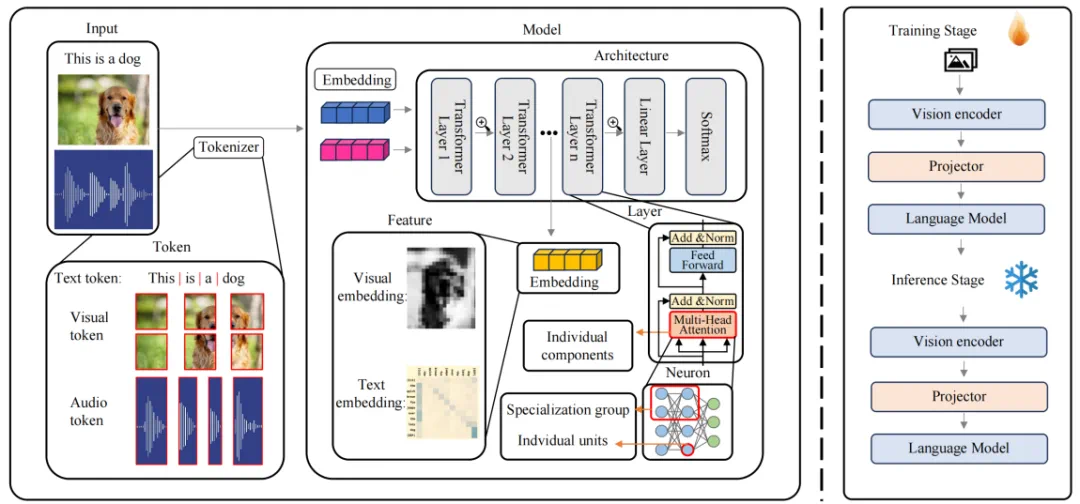

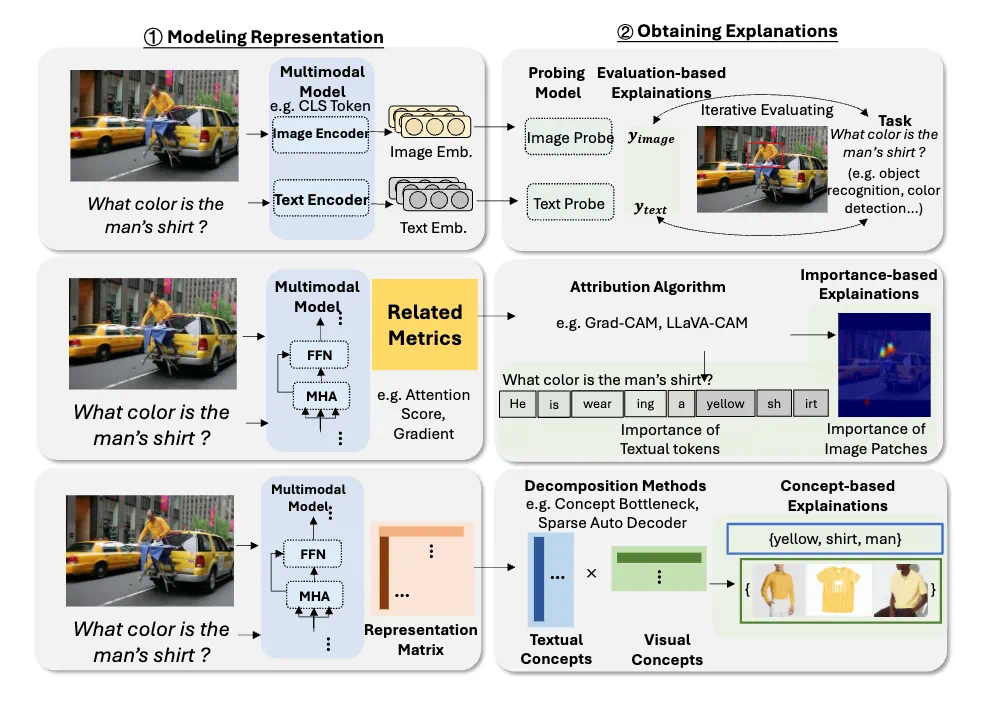

论文将现有的方法分为三个视角:数据、模型和训练/推理。

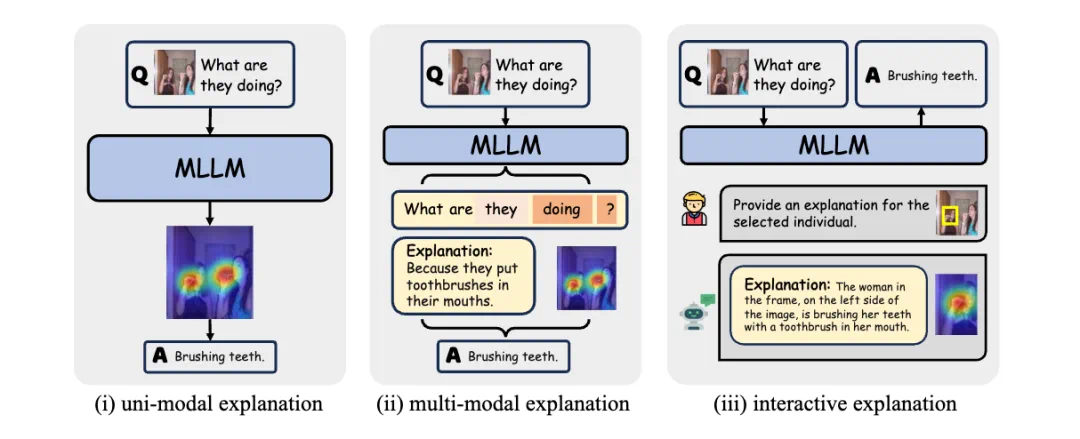

1. 数据视角: 关注输入和输出数据,不同数据集和多模态应用如何影响模型的可解释性。

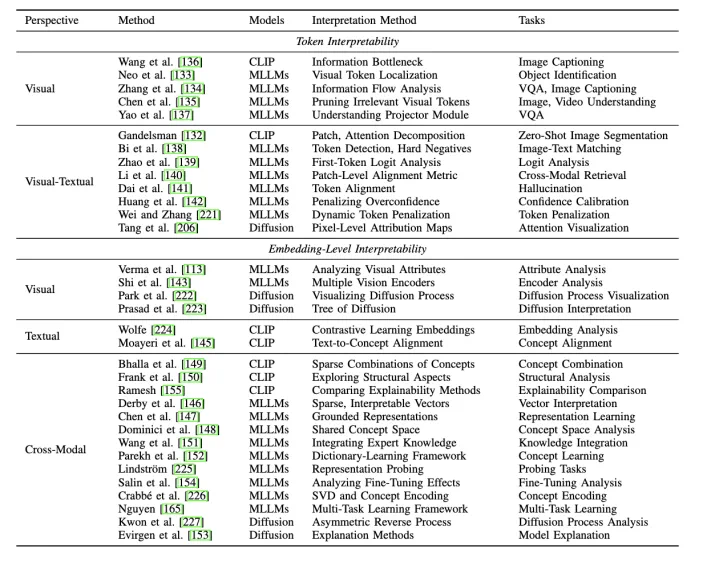

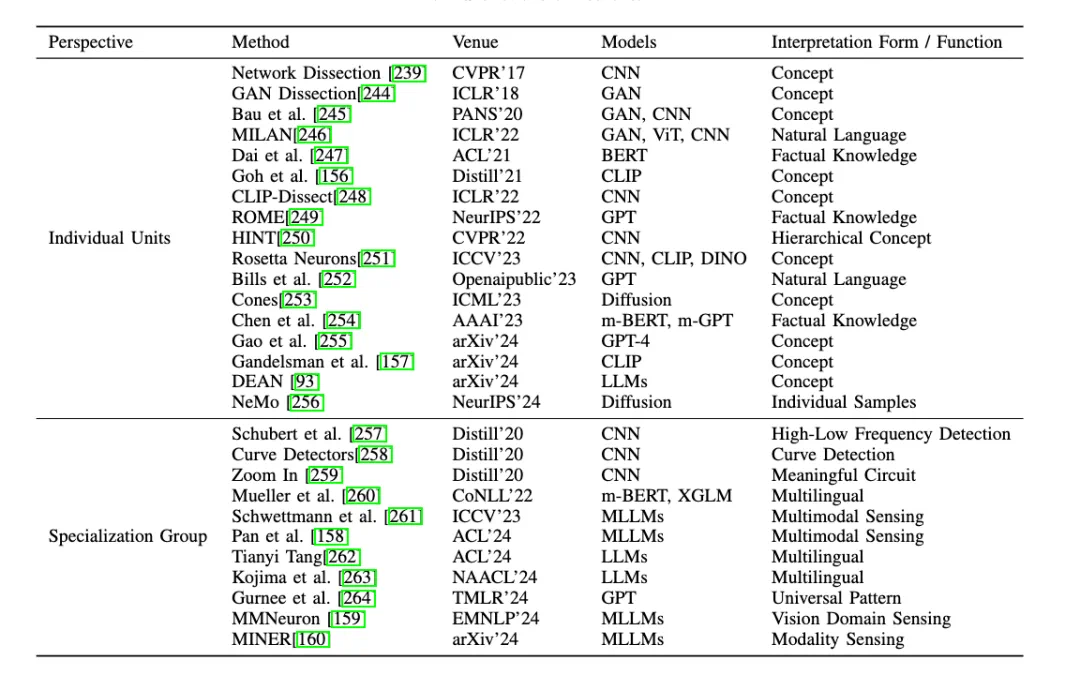

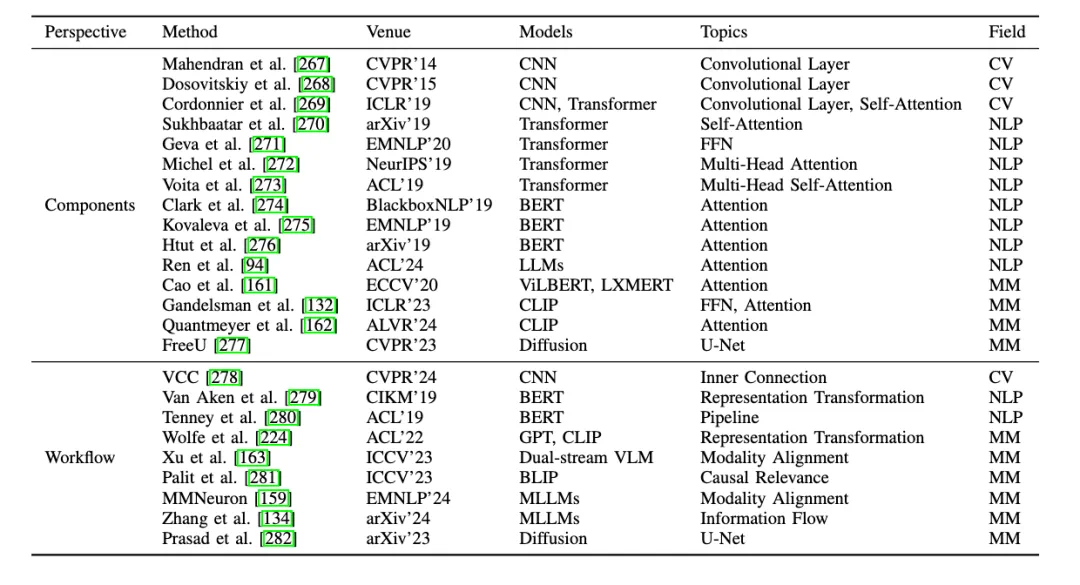

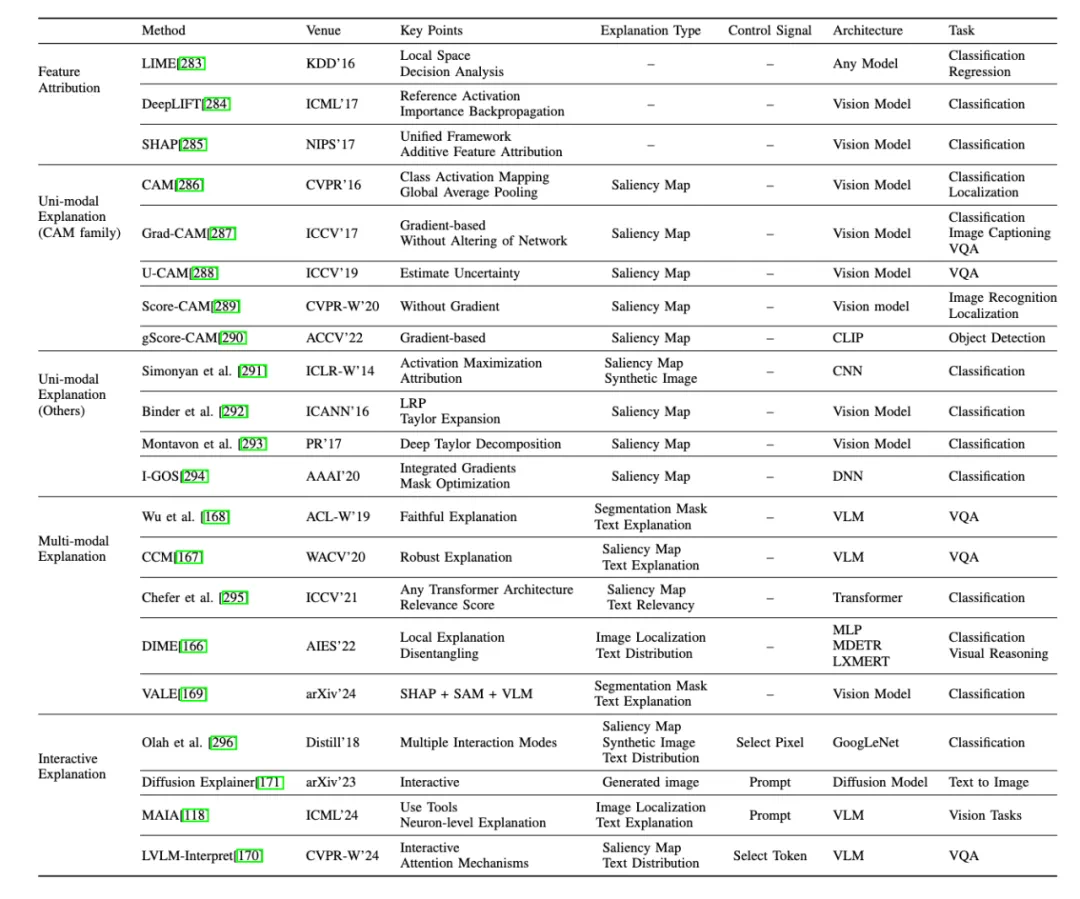

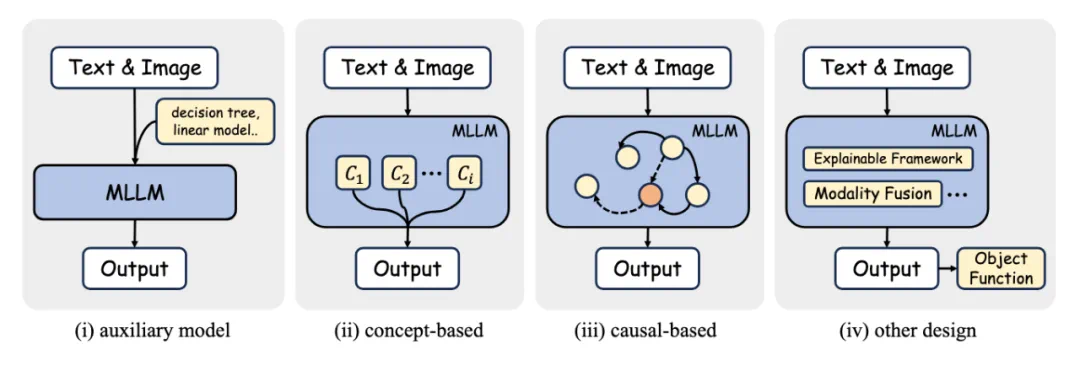

2. 模型视角: 深入分析模型内部组件,包括:

3. 训练与推理视角: 探讨训练和推理阶段如何影响可解释性,例如预训练策略、多模态对齐、减少幻觉等。

(以下部分包含论文中大量的图片,为了简化输出,我将用文字概述图片内容,保留图片链接)

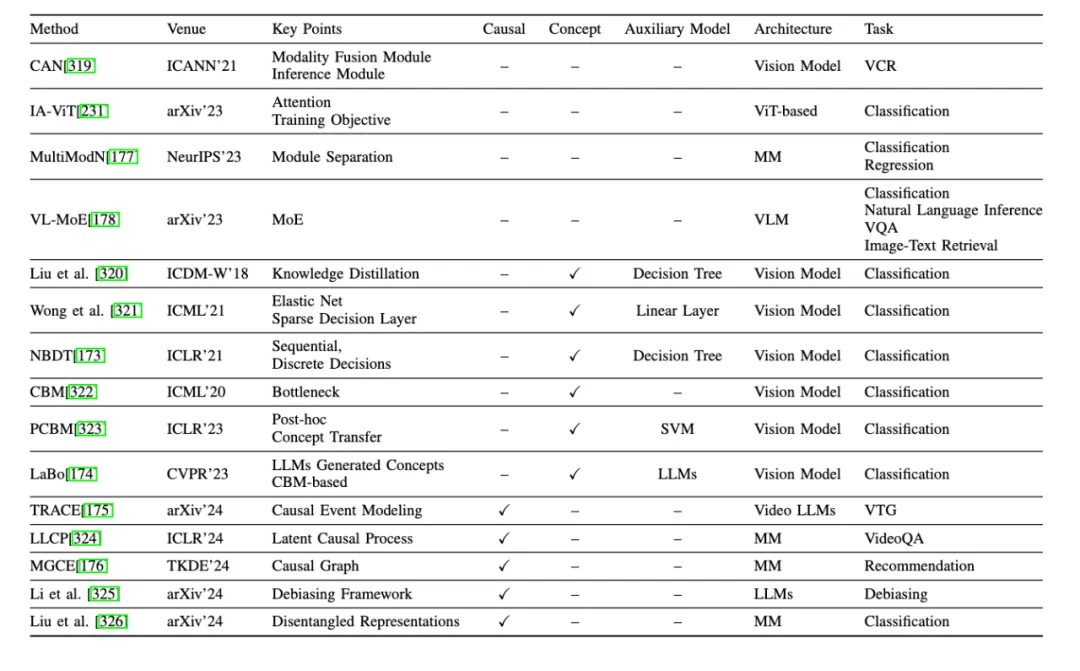

论文中包含大量图表,详细阐述了不同方法在词元、嵌入、神经元、层级和架构层面如何提升多模态大模型的可解释性。 这些图表分别从不同角度展示了模型内部机制,以及各种可解释性技术的应用效果。 (此处省略对每张图片的详细描述,保留图片链接,请参考原文图片。)

未来展望:

论文最后展望了多模态大模型可解释性的未来研究方向,包括改进数据集、优化嵌入和特征表示、增强模型架构的透明度、以及建立训练和推理的统一解释框架等。 这些努力将有助于构建更透明、可靠和可信的多模态AI系统。

以上就是决策过程是魔法还是科学?首个多模态大模型的可解释性综述全面深度剖析的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号