微信ai团队最新研究成果drt-o1:赋予大型语言模型(llm)长链思维能力,显著提升机器翻译效果!该研究巧妙地将长链思维(cot)应用于神经机器翻译(mt),尤其在处理文学作品中复杂的比喻和隐喻时,展现出显著优势。

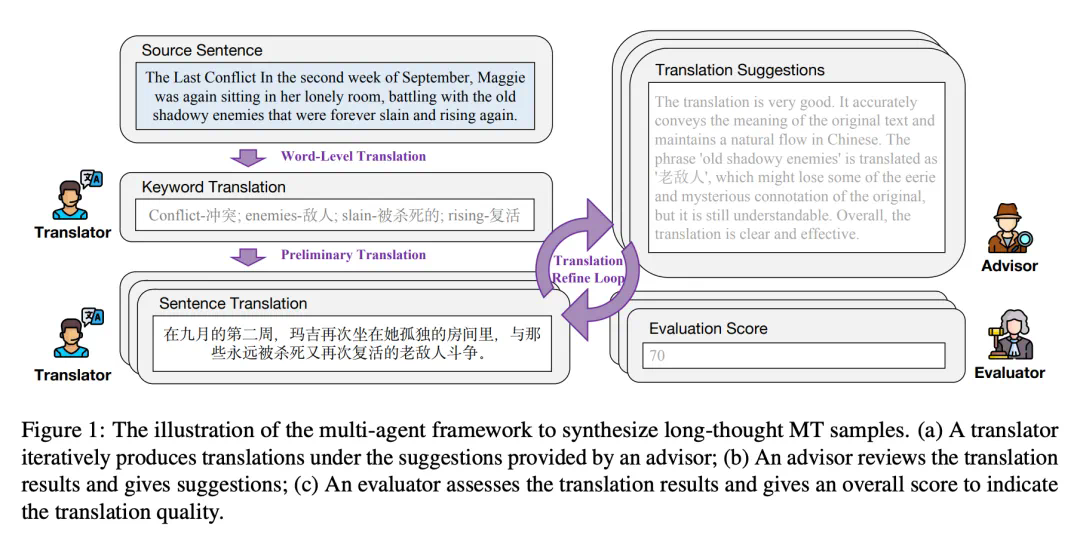

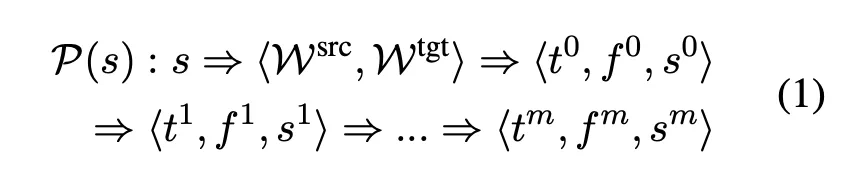

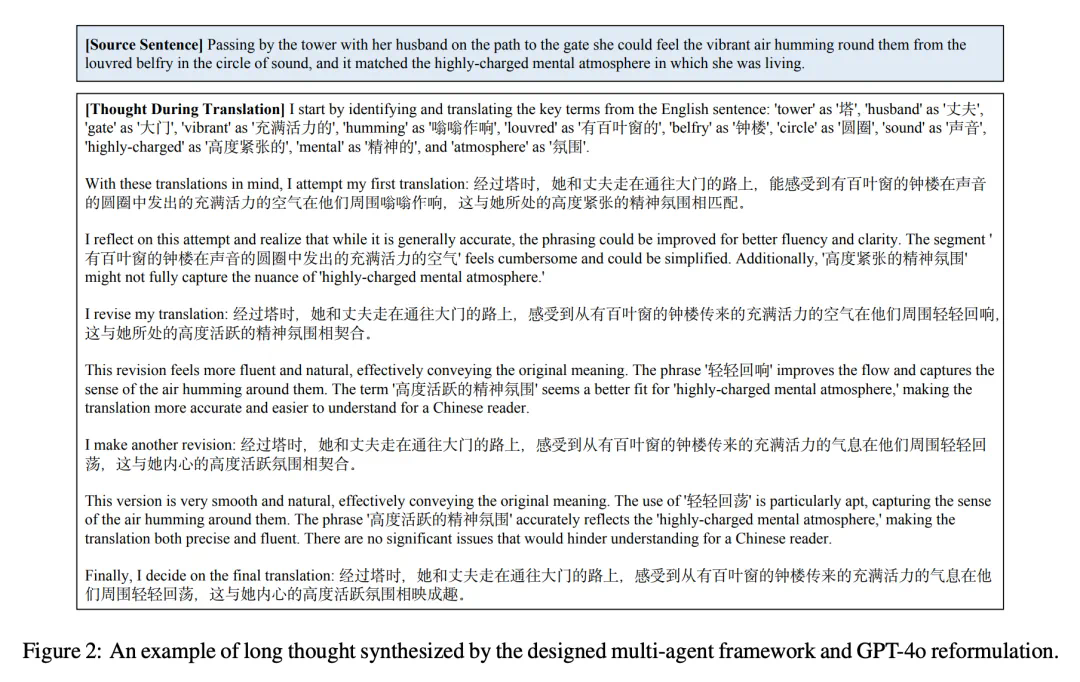

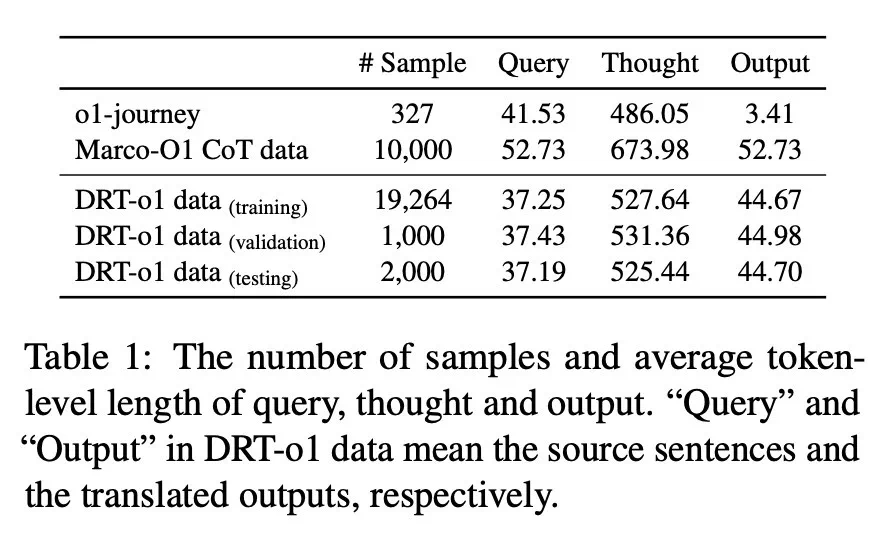

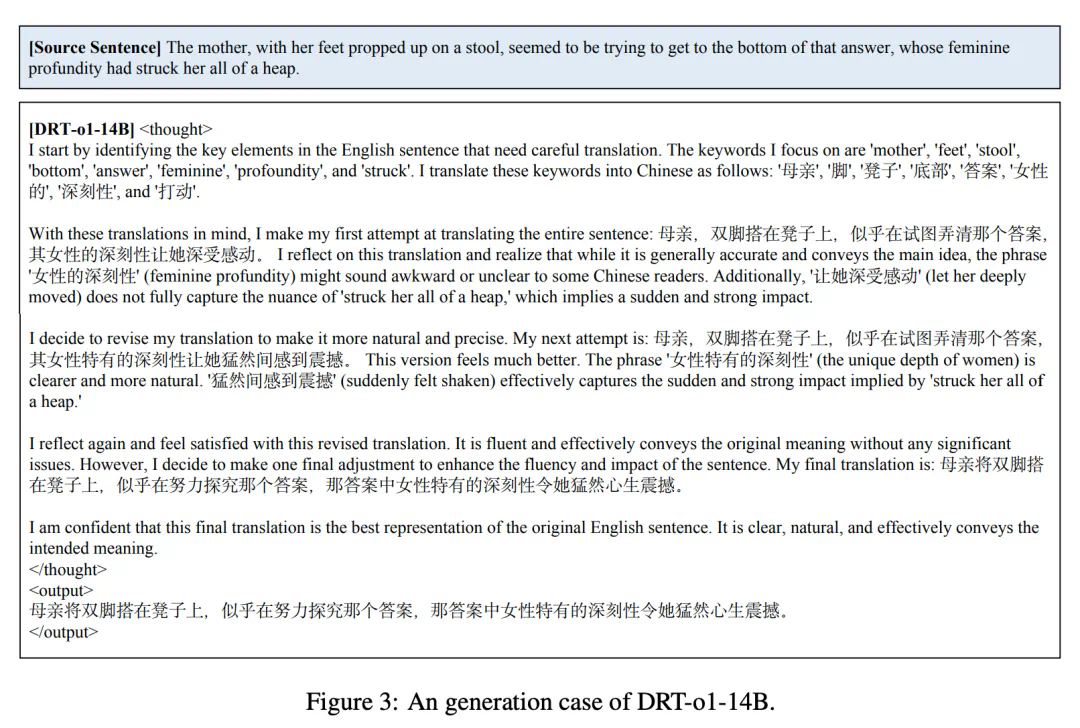

DRT-o1的核心在于其创新的数据合成方法。研究团队并非直接训练模型进行长链思维,而是构建了一个多智能体框架,模拟人类翻译过程中的思考和迭代改进。该框架包含三个智能体:翻译者、顾问和评估者,它们协同工作,逐步完善翻译结果。 这三个智能体通过迭代式地进行词语级翻译、初步翻译和翻译完善,最终生成包含详细思考过程的翻译样本。为了提高样本的可读性和流畅性,研究人员还利用GPT-4o对生成的文本进行润色。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

这项研究的关键突破在于:

针对性数据选择: 并非所有翻译场景都需要长链思维。DRT-o1专注于处理那些需要深入理解语境和文化内涵才能准确翻译的文本,例如包含比喻和隐喻的文学作品。研究人员从古腾堡计划中筛选出大量包含比喻或隐喻的句子,并通过Qwen2.5-72B-Instruct模型进行筛选,最终得到用于训练的数据集。

多智能体协同翻译: 该框架模拟了人类翻译过程中反复推敲、寻求改进的过程,生成包含详细思考步骤的翻译样本,这与以往直接训练模型进行长链思维的方法截然不同。

GPT-4o优化: 利用GPT-4o对生成的翻译样本进行润色,确保最终数据的质量和流畅性。

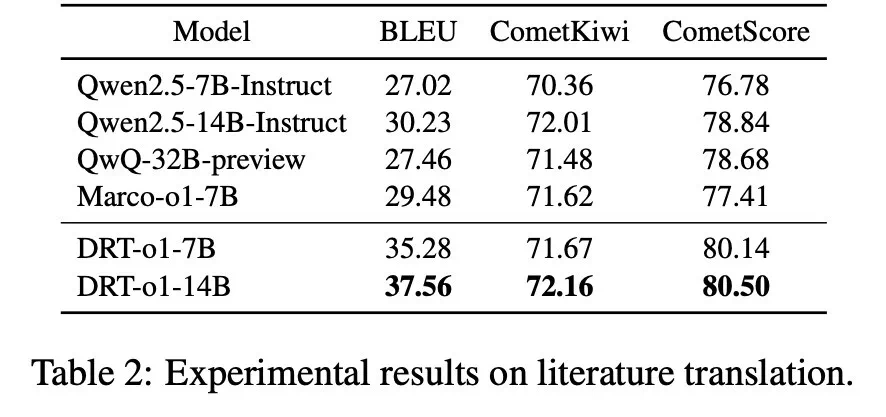

实验结果表明,基于该数据集训练的DRT-o1模型(使用Qwen2.5-7B-Instruct和Qwen2.5-14B-Instruct作为基础模型)在文学翻译任务上取得了显著的性能提升,在BLEU、CometKiwi和CometScore等多个评估指标上均优于基线模型。例如,DRT-o1-7B的BLEU分数比Qwen2.5-7B-Instruct高出8.26。

论文信息:

DRT-o1的研究为提升LLM在复杂翻译任务中的性能提供了新的思路,也为未来研究提供了宝贵的参考价值。

以上就是引入长思维链!微信基于阿里千问大模型搞出个翻译版o1的详细内容,更多请关注php中文网其它相关文章!

微信是一款手机通信软件,支持通过手机网络发送语音短信、视频、图片和文字。微信可以单聊及群聊,还能根据地理位置找到附近的人,带给大家全新的移动沟通体验,有需要的小伙伴快来保存下载体验吧!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号