关于大模型核心理论“scaling law”起源的争议正席卷全球科技界。新证据表明,百度可能比openai更早地发现了这一关键原则。

《南华早报》报道指出,尽管美国长期以来被认为在AI模型创新方面处于领先地位,但最新讨论显示中国在这一领域可能更具前瞻性。

“Scaling Law”的核心思想是:模型参数和训练数据规模越大,模型能力越强。这一理论通常被认为源于OpenAI 2020年发表的论文。

然而,OpenAI论文合著者、Anthropic创始人Dario Amodei近期透露,他在2014年与吴恩达在百度合作期间,就已观察到这一现象。他指出,增加数据量、扩大模型规模和延长训练时间均能显著提升模型性能。这一经验性发现后来在OpenAI的GPT-1模型中得到验证,并成为大模型发展的基石。

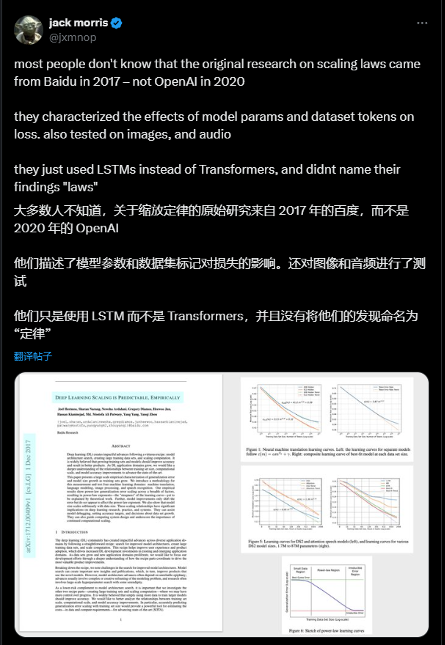

此外,业内人士指出,百度早在2017年就发表了相关论文《Deep Learning Scaling is Predictable, Empirically》,比OpenAI 2020年的论文更早地探讨了Scaling Law现象。 OpenAI 2020年的论文引用了百度2019年的研究,却忽略了2017年的先期工作,引发争议。

一些研究者认为,百度的早期研究为大模型发展奠定了理论基础。百度在2019年发布了第一代文心大模型,与OpenAI几乎同步。百度世界大会2024上,百度展示了其在降低图像生成模型“幻觉”问题上的新进展,并宣布文心大模型日均调用量已达15亿次,较去年增长30倍。

这些进展表明,中国在全球AI领域的影响力日益增强。

以上就是中国引领全球AI理论突破!百度2014年就已发现Scaling Law的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号