mha2mla:高效微调transformer模型的利器

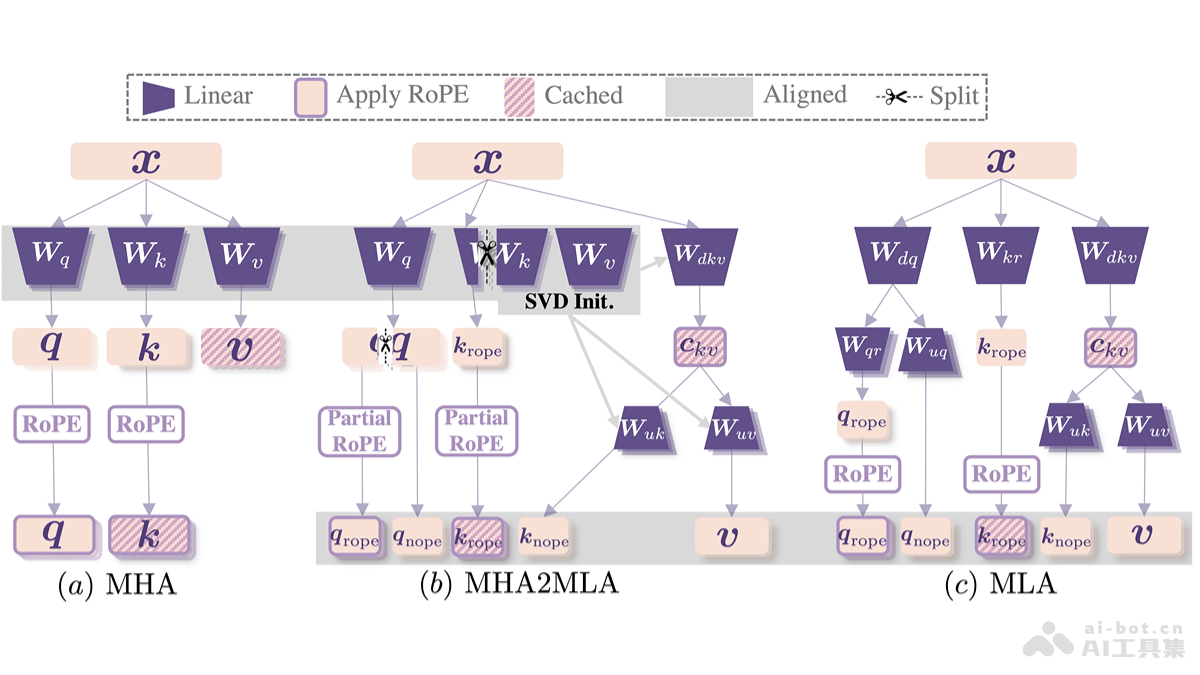

MHA2MLA是由复旦大学、华东师范大学和上海AI Lab等机构联合研发的一种数据高效的微调方法,它能够显著提升基于Transformer的大型语言模型(LLM)的推理效率,并降低推理成本。 该方法的核心在于引入DeepSeek的多头潜在注意力机制(MLA),并通过两个关键策略实现:部分旋转位置编码(Partial-RoPE)和低秩近似(Low-Rank Approximation)。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

核心功能与优势:

- 大幅缩减KV缓存: 通过低秩压缩技术,最大程度地减少KV缓存大小(最高可达96.87%),有效降低内存占用。

- 性能损耗极低: 仅需使用原始数据的0.3%到0.6%进行微调,即可将性能损失控制在极小范围内(例如,LongBench性能仅下降0.5%)。

- 兼容性强: 可与量化技术(如4-bit量化)结合使用,进一步提升推理效率。

- 数据高效: 在资源受限的环境下,也能快速完成从多头注意力机制(MHA)到MLA的架构转换。

技术原理详解:

MHA2MLA的效率提升主要源于以下两项技术:

- Partial-RoPE: 旋转位置编码(RoPE)在MHA中用于编码位置信息。Partial-RoPE通过分析每个维度对注意力分数的贡献,移除贡献较小的维度,从而减少计算和内存开销,同时保留关键位置信息。

- 低秩近似 (Low-Rank Approximation with Joint SVD): MLA利用低秩近似来压缩键值矩阵(KV),减少内存占用。MHA2MLA采用联合奇异值分解(Joint SVD)对键和值矩阵进行联合分解,而非分别处理,从而更好地保留键值间的交互信息,并实现更有效的压缩。

项目信息与应用场景:

- GitHub仓库: https://www.php.cn/link/be6ea238d9be0fc60080a6f8a8188817

- arXiv论文: https://www.php.cn/link/8534faf0b0b4a15ae79f1434ddcb94f1

MHA2MLA的应用场景广泛,包括:

- 边缘设备部署: 适用于资源受限的智能终端和物联网设备。

- 大规模模型推理: 降低硬件成本和能耗。

- 结合量化技术: 进一步优化推理性能,适用于实时应用场景,如实时对话和在线翻译。

- 长文本处理: 有效缓解长文本任务的内存瓶颈。

- 快速模型迁移: 降低模型迁移成本。

总而言之,MHA2MLA提供了一种高效且经济的微调方法,为在各种资源受限的环境中部署和使用大型语言模型提供了强有力的支持。