python中读取和写入csv文件主要使用csv模块和pandas库。1) 使用csv模块可以进行基本操作,如读取和写入csv文件。2) pandas库提供了更强大的功能,特别适合大规模数据处理。掌握这些方法能显著提升数据处理效率。

在数据处理和分析的领域中,CSV(Comma-Separated Values)文件是一种常见的文件格式,它以其简单性和广泛的兼容性而受到青睐。无论你是进行数据科学研究,还是需要处理业务数据,掌握如何读取和写入CSV文件都是一项基本技能。本文将带你深入了解如何在Python中高效地操作CSV文件,提供从基础到高级的用法,并分享一些我在实际项目中积累的经验和技巧。

通过阅读本文,你将学会如何使用Python的内置库和第三方库来处理CSV文件,了解常见的陷阱和最佳实践,并掌握一些性能优化的小技巧。

CSV文件本质上是一种文本文件,其中数据以逗号分隔,每行代表一个数据记录。这种格式简单易懂,但也有一些需要注意的地方,比如处理引号、逗号和换行符。

Python提供了多种方法来处理CSV文件,其中最常用的是csv模块和pandas库。csv模块是Python标准库的一部分,适用于基本的CSV操作,而pandas则提供了更强大的数据处理功能,特别是在处理大规模数据时。

读取CSV文件是数据处理的第一步。使用csv模块,你可以轻松地将CSV文件的内容读取到Python中。

import csv

with open('data.csv', 'r') as file:

csv_reader = csv.reader(file)

for row in csv_reader:

print(row)这个简单的代码片段展示了如何读取CSV文件并打印每一行。csv.reader对象会自动处理逗号分隔的数据。

写入CSV文件同样简单,使用csv.writer对象可以将数据写入到CSV文件中。

import csv

data = [

['Name', 'Age'],

['Alice', 30],

['Bob', 25]

]

with open('output.csv', 'w', newline='') as file:

csv_writer = csv.writer(file)

for row in data:

csv_writer.writerow(row)这个例子展示了如何将一个包含两列数据的列表写入到CSV文件中。注意newline=''参数,这是在Windows系统上避免额外换行符的常见做法。

csv模块的工作原理是通过解析CSV文件中的逗号和换行符来分隔数据。它会自动处理引号和转义字符,使得读取和写入CSV文件变得更加简单。

pandas库则更进一步,它不仅可以读取和写入CSV文件,还提供了强大的数据处理功能,如数据清洗、统计分析等。pandas使用read_csv和to_csv函数来处理CSV文件,这些函数内部调用了csv模块,但提供了更多的选项和更高的性能。

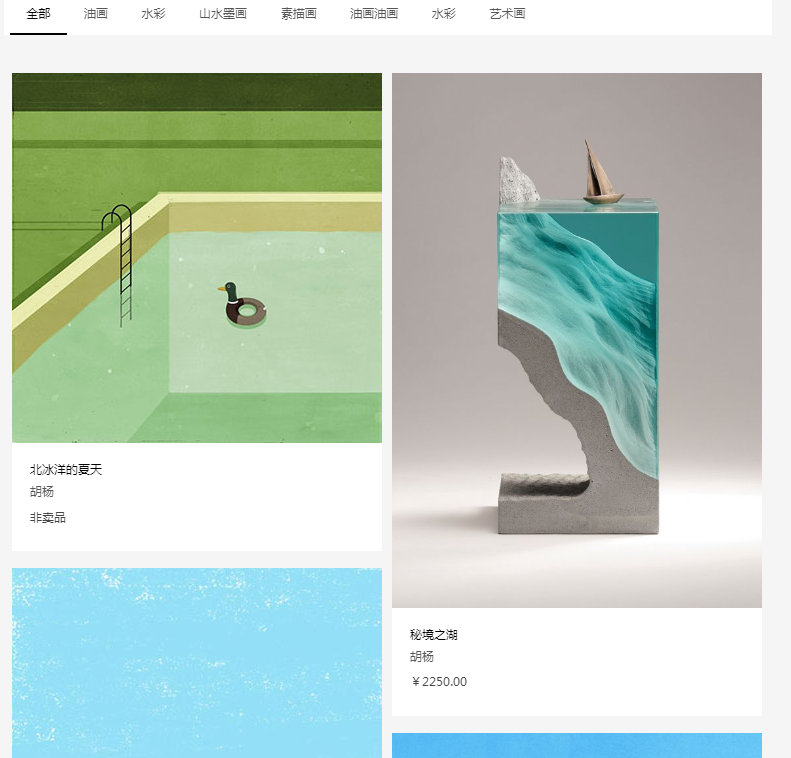

里面有2个文件夹。其中这个文件名是:finishing,是我项目还没有请求后台的数据的模拟写法。请求后台数据之后,瀑布流的js有一点点变化,放在文件名是:finished。变化在于需要穿参数到后台,和填充的内容都用后台的数据填充。看自己项目需求来。由于chrome模拟器是不允许读取本地文件json的,所以如果你要进行测试,在hbuilder打开项目就可以看到效果啦,或者是火狐浏览器。

93

93

使用pandas读取CSV文件是一个常见的操作,它可以快速将CSV文件转换为DataFrame对象。

import pandas as pd

df = pd.read_csv('data.csv')

print(df)这个代码片段展示了如何使用pandas读取CSV文件并打印DataFrame的内容。

在处理大规模数据时,pandas的chunksize参数可以帮助你逐块读取CSV文件,节省内存。

import pandas as pd

chunksize = 10 ** 6 # 每块100万行

for chunk in pd.read_csv('large_data.csv', chunksize=chunksize):

process_chunk(chunk) # 处理每块数据这个例子展示了如何使用chunksize参数逐块读取大文件,这在处理数百万行数据时非常有用。

在处理CSV文件时,常见的错误包括编码问题、分隔符错误和数据格式问题。以下是一些调试技巧:

encoding参数指定正确的编码,如encoding='utf-8'。sep参数指定,如sep=';'。pandas的dtype参数指定列的数据类型,如dtype={'Age': int}。在处理CSV文件时,性能优化是一个重要的话题。以下是一些我在实际项目中积累的经验和最佳实践:

pandas:pandas在处理大规模数据时比csv模块更高效,特别是在需要进行数据清洗和分析时。chunksize参数逐块读取可以显著减少内存使用。import pandas as pd

from multiprocessing import Pool

def process_file(file_path):

df = pd.read_csv(file_path)

# 处理数据

return df

if __name__ == '__main__':

file_paths = ['file1.csv', 'file2.csv', 'file3.csv']

with Pool() as pool:

results = pool.map(process_file, file_paths)

# 合并结果这个例子展示了如何使用多进程并行处理多个CSV文件,这在处理大量数据时可以显著提高效率。

在实际项目中,我发现使用pandas和多进程结合,可以大大提高数据处理的速度和效率。同时,注意数据的完整性和一致性,确保在处理过程中不会丢失或损坏数据。

总之,掌握如何读取和写入CSV文件不仅能提高你的数据处理能力,还能在实际项目中带来显著的效率提升。希望本文能为你提供有价值的指导和启发。

以上就是如何读取和写入CSV文件?的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号