cloudflare autorag:简化ai集成,提升应用体验

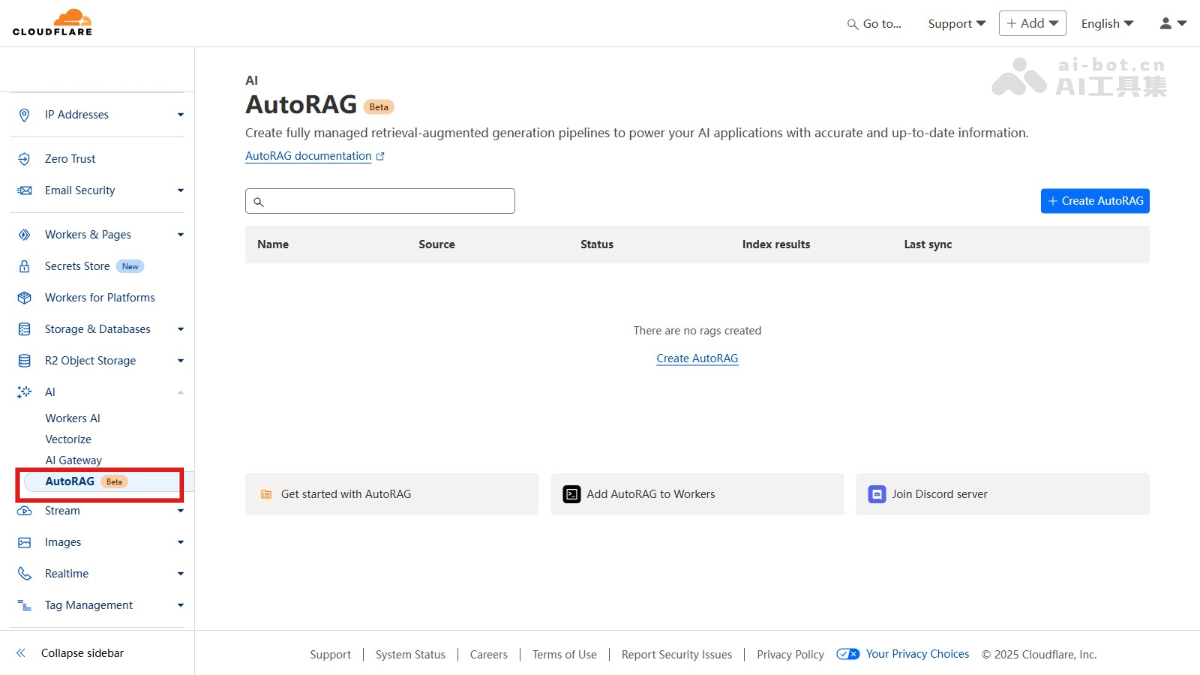

Cloudflare推出的AutoRAG是一个全托管的检索增强生成(RAG)管道,让开发者能轻松地将上下文感知的AI集成到应用中,无需自行管理基础设施。它利用Cloudflare的Workers AI、Vectorize等技术,自动索引数据源并持续更新内容,从而实现高效的数据检索和高质量的AI响应。AutoRAG非常适合构建聊天机器人、内部知识工具和企业知识搜索等应用,显著简化开发流程,并提升应用性能和用户体验。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

AutoRAG核心功能

AutoRAG核心功能

AutoRAG的主要功能包括:

AutoRAG的工作流程分为索引和查询两个阶段:

索引过程:

查询过程:

AutoRAG适用于多种应用场景:

访问Cloudflare官网了解更多信息 (请注意:cloudflare.AutoRAG 并非一个有效的URL,此处应替换为实际的官网链接)。

以上就是AutoRAG— Cloudflare 推出的全托管检索增强生成服务的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号