概述

DeepSeek-R1模型在各项指标上直逼甚至超越了OpenAI及同类产品,迅速成为业界关注的焦点。更令人惊喜的是,该模型基于MIT协议免费开源,允许任何公司或个人自由商用,无需任何授权限制,这在AI界引起了巨大轰动。

最近,由于DeepSeek服务遭受外海攻击,访问有时会受到影响。但由于DeepSeek-R1是开源的,我们可以选择部署自己的DeepSeek-R1模型。如果再结合Webman AI,效果将更加出色。

以下是关于如何在本地部署DeepSeek-R1服务的教程。

前提条件是您的电脑需要配备显卡,显卡性能越好,效果越佳。

一、安装ollama:请访问https://ollama.com/download进行下载和安装。

二、根据您的配置选择合适的版本:

| 参考量 | 显存需求 | 显卡推荐 | 命令 |

|---|---|---|---|

| 1.5B | 通常4GB左右 | GTX 1050 | ollama run deepseek-r1:1.5b |

| 8B | 一般8-10GB | GTX 1660 | ollama run deepseek-r1:8b |

| 14B | 12GB以上,16GB以上运行流畅 | RTX 3060 | ollama run deepseek-r1:14b |

| 32B | 16GB以上,21GB以上运行流畅 | RTX 3060 | ollama run deepseek-r1:32b |

| 70B | 24GB以上,40GB以上运行流畅 | RTX 3090、RTX 4090 | ollama run deepseek-r1:70b |

| 671B | 1342GB | 16张NVIDIA A100 80GB显卡 | ollama run deepseek-r1:671b |

根据您的显存选择合适的版本。如果条件允许,建议使用32B或70B版本,效果非常好。如果显存不足,并且使用了高版本,系统会自动使用CPU+显存的方式来运行,但输出速度会很慢,每秒仅1-2个字。

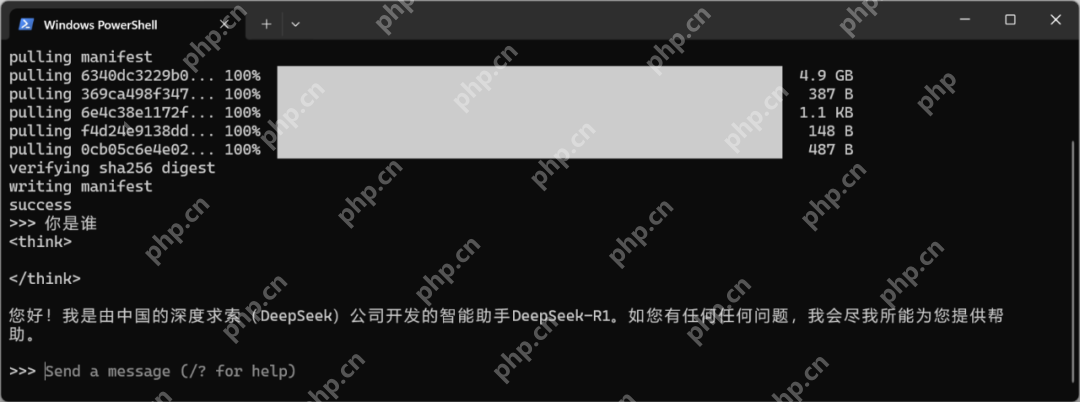

三、对话:

安装完成后,您就可以直接在命令行进行对话。

以下内容为可选项,配合 Webman AI (可选):

本文档是Websphere教程;WebSphere 是因特网的基础架构软件,也就是我们所说的中间件。它使企业能够开发、部署和集成新一代电子商务应用(如 B2B 的电子交易),并且支持从简单的 Web 发布到企业级事务处理的商务应用。希望本文档会给有需要的朋友带来帮助;感兴趣的朋友可以过来看看

0

0

如果您已经拥有Webman AI程序,可以接入自己的deepseek-r1,在提升用户体验的同时,您还可以从中获取收益。

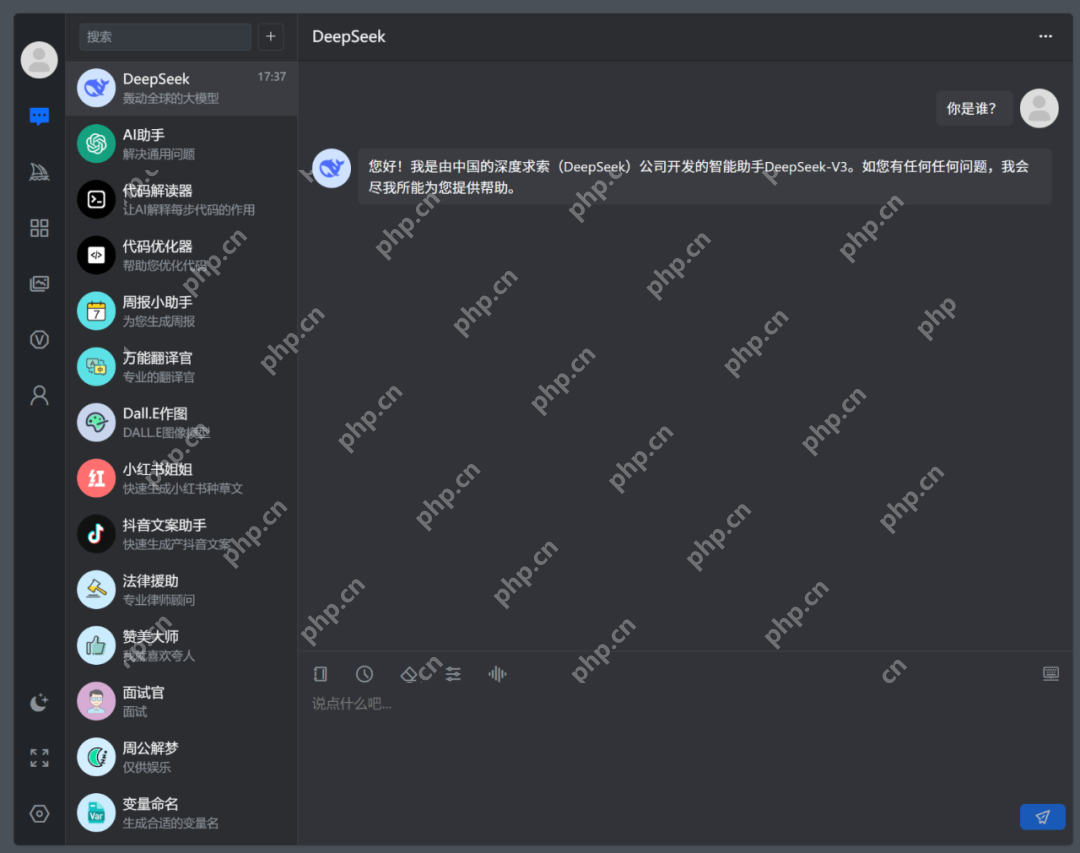

ollama默认在命令行中进行对话,UI界面并不友好。如果配合Webman AI,可以获得更好的交互体验。

假设您已经部署了Webman AI程序,通过以下步骤接入DeepSeek-R1。

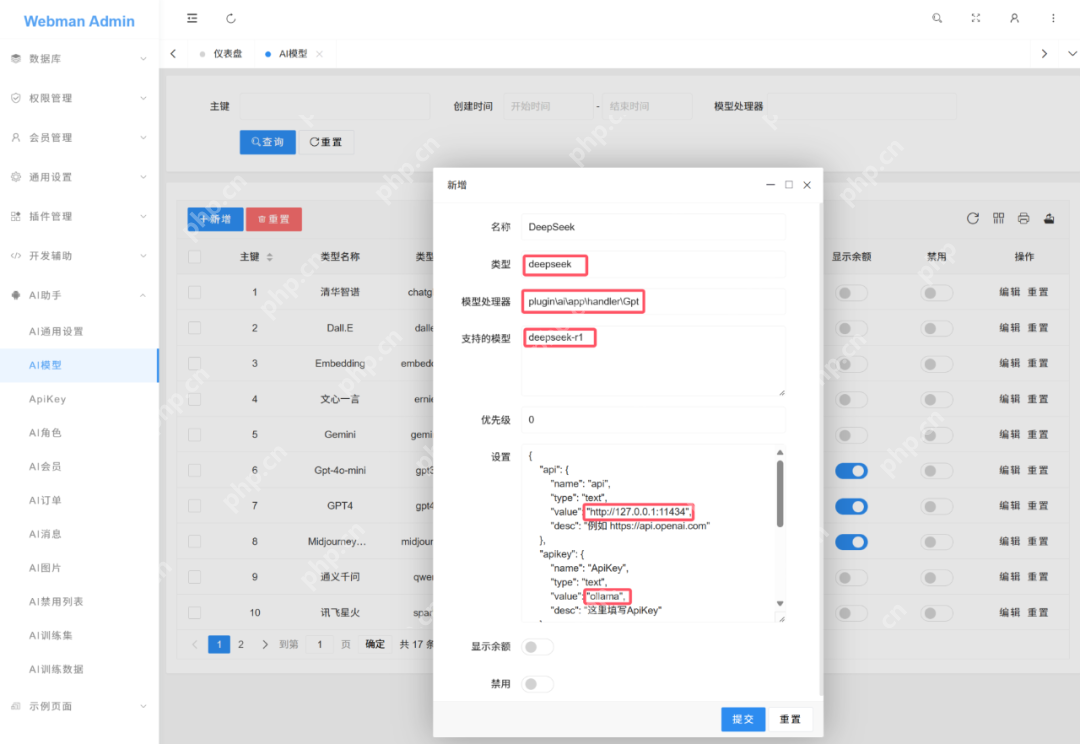

进入Webman AI管理后台,添加新模型:

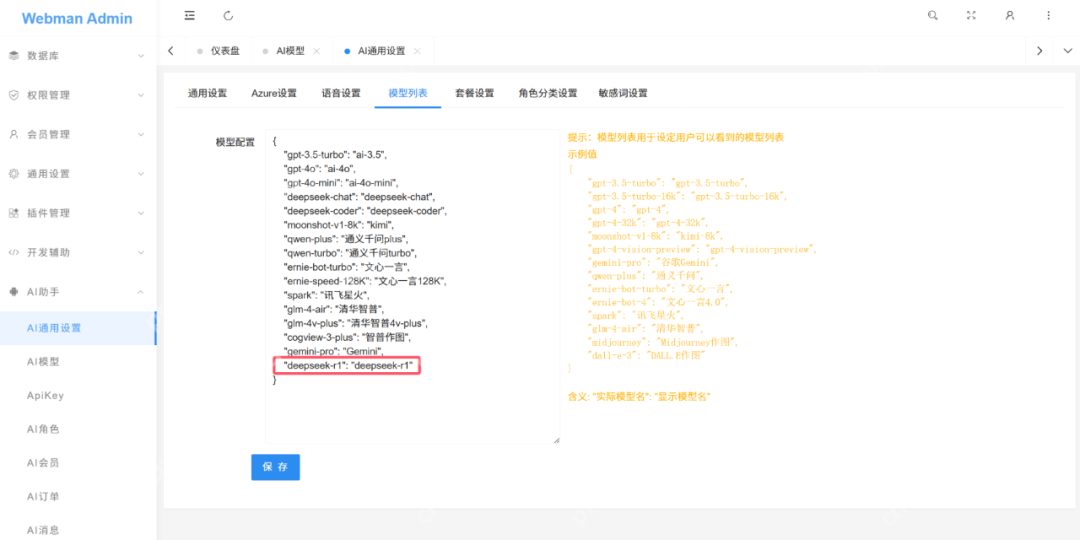

设置对外模型名称:

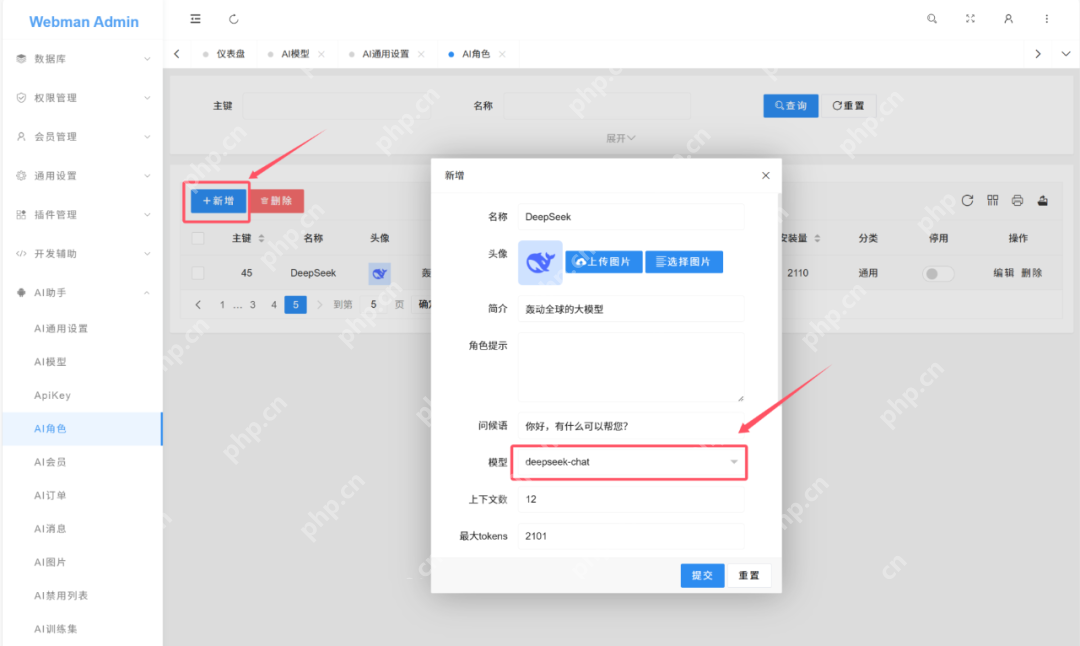

新建角色:

测试:

以上就是一文读懂!DeepSeek超简易本地部署教程的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号