01

背景

AI已成为当今的热门话题。过去,由于私有化部署成本高昂,大多数用户仅限于简单的问答阶段,很少有人尝试训练大型模型。然而,随着DeepSeek R1的出现,其部署成本仅为chatGPT的十分之一,这为许多企业和个人带来了参与的希望。未来,必将有越来越多的垂直领域AI大模型或应用涌现,这可能是一个巨大的机遇。那么,普通人如何参与呢?如何训练自己的AI呢?本文将介绍一种简单且无需编写代码的方法,帮助您轻松训练AI应用。

02

Ollama的安装

Ollama 是一个用go语言开发的开源框架,可用于本地运行和管理大语言模型(LLM)。我们将使用Ollama来运行和管理DeepSeek大模型。Ollama支持在CPU或GPU环境下运行,具体安装步骤如下。

1. 基于CPU运行

DeepSeek R1:7b大模型在CPU环境下也能运行,但不是很流畅,个人或实验用途倒也无妨。运行Ollama的指令如下:

docker run -d -v /data/ollama:/root/.ollama -p 11434:11434 --name ollama registry.cn-hangzhou.aliyuncs.com/yilingyi/ollama

2. 基于GPU运行

经测试,DeepSeek R1:7b大模型在10G以上显存的环境下可以流畅运行。使用GPU需要先配置依赖环境。

2.1. 使用apt方式安装

配置仓库:

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list sudo apt-get update

安装NVIDIA Container Toolkit:

sudo apt-get install -y nvidia-container-toolkit

2.2. 使用yum或dnf方式安装

配置仓库:

curl -s -L https://nvidia.github.io/libnvidia-container/stable/rpm/nvidia-container-toolkit.repo | sudo tee /etc/yum.repos.d/nvidia-container-toolkit.repo

安装NVIDIA Container Toolkit:

sudo yum install -y nvidia-container-toolkit

配置docker,使其支持NVIDIA驱动:

sudo nvidia-ctk runtime configure --runtime=docker sudo systemctl restart docker

3. 运行Ollama

完成上述依赖环境配置后,运行如下指令,比CPU的方式多了一个参数--gpus,用于指定使用宿主机的GPU。

docker run -d --gpus=all -v /data/ollama:/root/.ollama -p 11434:11434 --name ollama registry.cn-hangzhou.aliyuncs.com/yilingyi/ollama

03

运行DeepSeek大模型

通过如下指令下载并运行DeepSeek R1:7b大模型:

docker exec -it ollama ollama run deepseek-r1:7b

下载可能需要一些时间,但没关系,我们可以边下载边继续部署Dify,搭建一个可视化的管理平台。

04

Dify的安装

Dify是一款开源的大语言模型(LLM)应用开发平台。它结合了后端即服务(Backend as a Service)和LLMOps的理念,使开发者能够快速构建生产级的生成式AI应用。即使是非技术人员,也可以参与到AI应用的定义和数据运营中。通过Dify,不仅可以实现知识库应用,还能开发更多功能。

1. 使用Docker-Compose安装

这里使用Docker-Compose V2进行安装,V1时会遇到异常。

mkdir -p ~/.docker/cli-plugins/ curl -SL https://github.com/docker/compose/releases/download/v2.20.2/docker-compose-linux-x86_64 -o ~/.docker/cli-plugins/docker-compose

2. 克隆Dify仓库

git clone https://github.com/langgenius/dify.git

3. 运行Dify

进入Dify源代码的Docker目录:

cd dify/docker

复制环境配置文件:

cp .env.example .env

启动Docker容器:

docker compose up -d

Dify初始化后,替换成您的服务器IP,访问并设置您的账号和密码。

http://your_server_ip/install

至此,我们完成了Dify和DeepSeek大模型的部署,接下来需要在Dify进行大模型配置和创建我们的AI应用。

05

Dify添加大模型

完成上述安装后,我们需要在Dify控制台上添加我们部署的DeepSeek R1:7b大模型,操作如下:

登录控制台后,点击右上角-->设置

在弹窗左侧栏目选择“模型供应商”,然后添加Ollama配置

06

创建AI应用

终于到了这个环节,我们可以借助Dify快速创建我们的AI应用,并赋予它处理的逻辑。

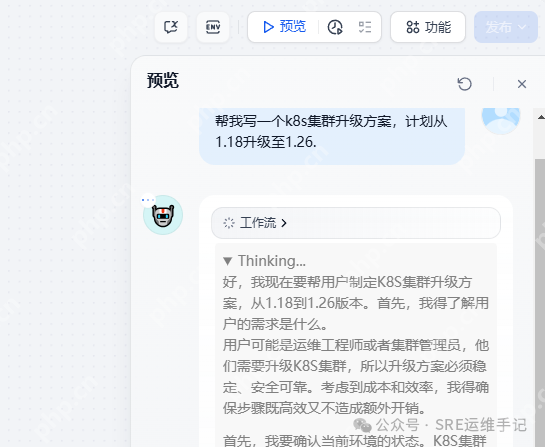

创建一个空白应用,选择Chatflow

创建后,在LLM节点选择deepseek-r1:7b大模型,然后设置上下文为用户查询变量sys.query,接着在SYSTEM处设置提示词(Prompt)赋予它处理逻辑。

在预览没问题后,发布应用即可

07

结语

通过上述内容,我们了解了DeepSeek大模型的部署和AI应用的搭建,并尝试了Chatflow和Prompt的使用。由于一些条件限制,许多人无法进行基础模型的开发或微调,但Chatflow和Prompt为我们展示了另一种训练的方向。本期内容到此为止,下一期我们将深入探讨Chatflow和Prompt的高级应用。