随着ai大模型的快速发展,deepseek作为一款备受瞩目的开源大模型,吸引了众多开发者的关注。你想知道如何在本地搭建deepseek推理环境,以便更高效地进行ai研究和应用开发吗?本文将为你详细讲解本地部署deepseek的完整流程,让你轻松打造属于自己的ai推理环境。

首先,我们需要准备一台电脑,配置越高当然越好。不过我的测试本是一台较为老旧的MBP,配置如图所示:

同时,需要在本地搭建好Python环境,这里不详细展开。

接下来,本文将详细介绍如何在本地部署DeepSeek蒸馏模型,内容主要包括Ollama的介绍与安装、如何通过Ollama部署DeepSeek,以及在Cherry Studio中使用DeepSeek。

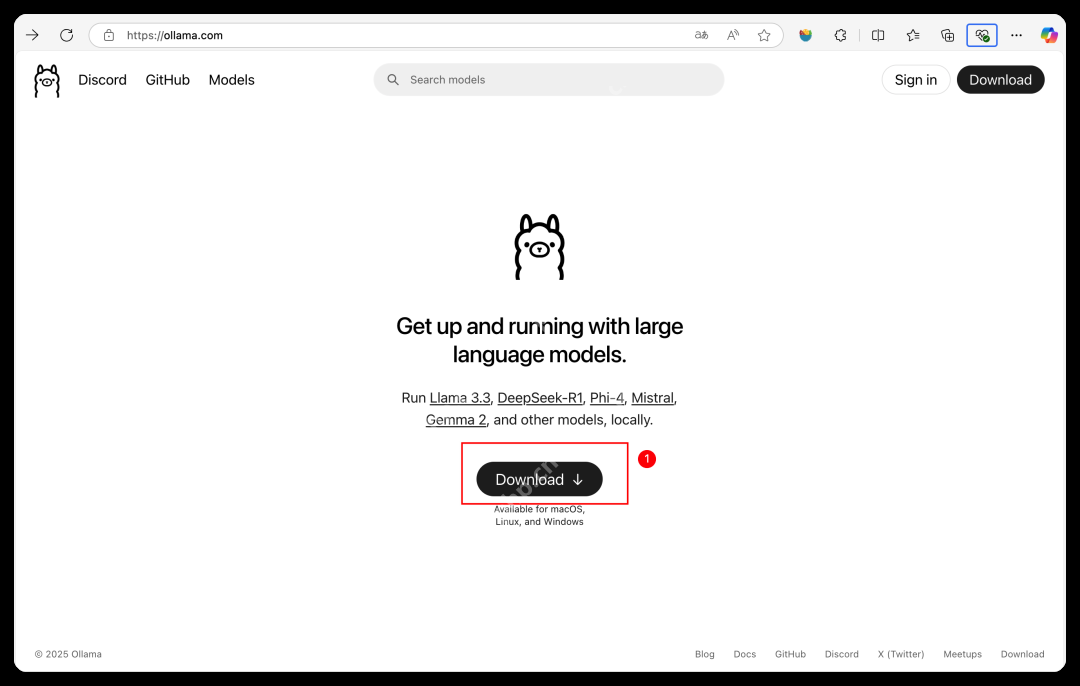

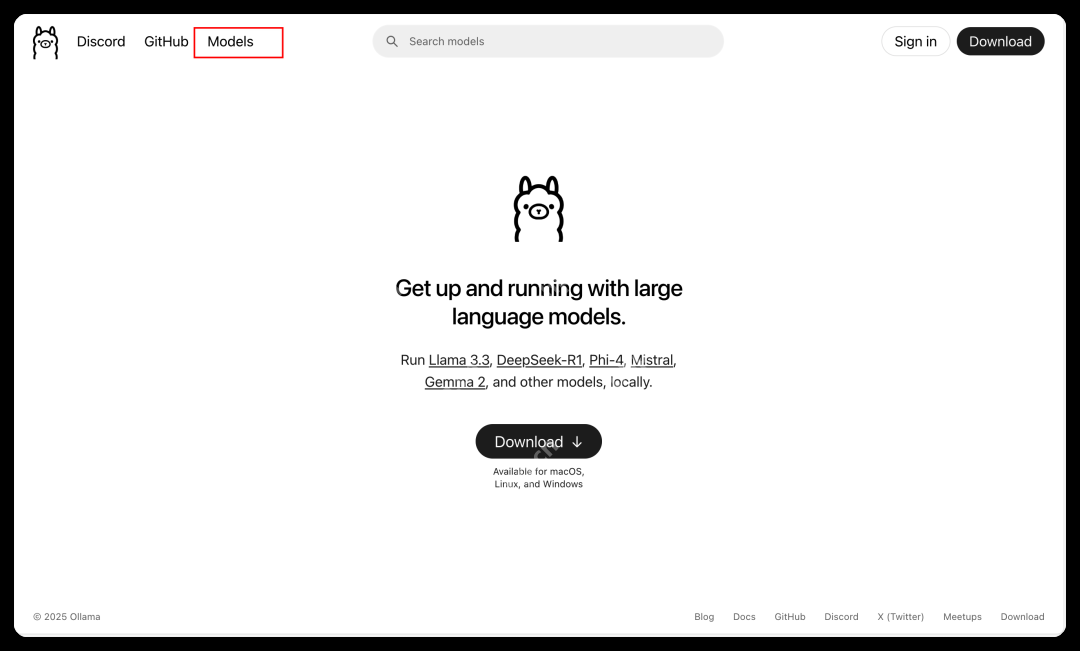

首先,打开Ollama的官方网站:https://ollama.com/,如图所示:

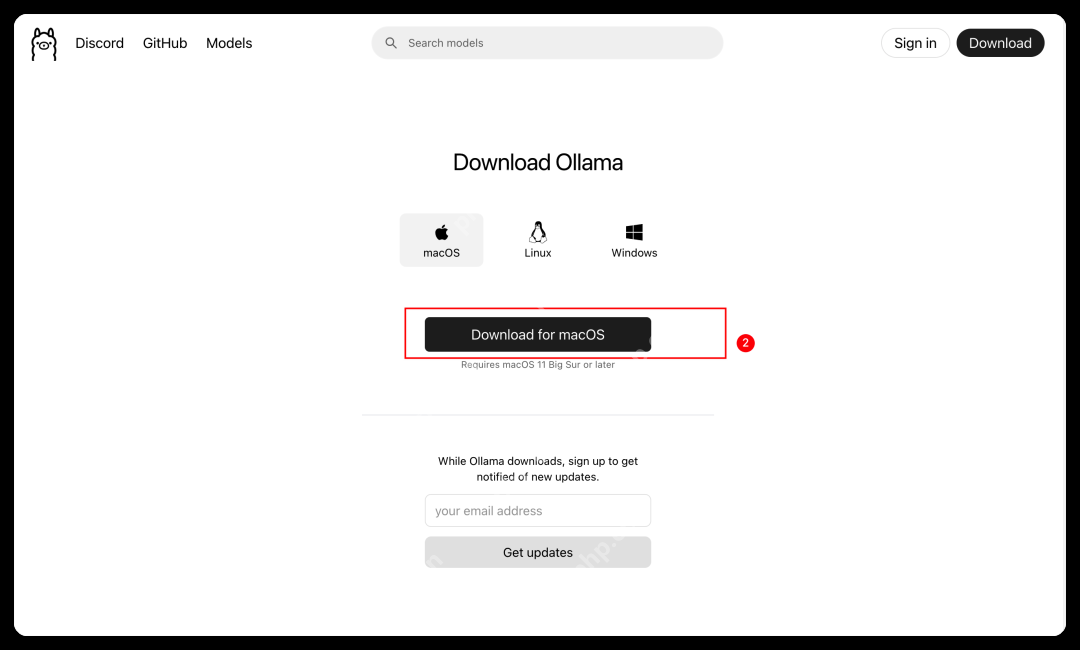

点击Download,会进入如下页面:

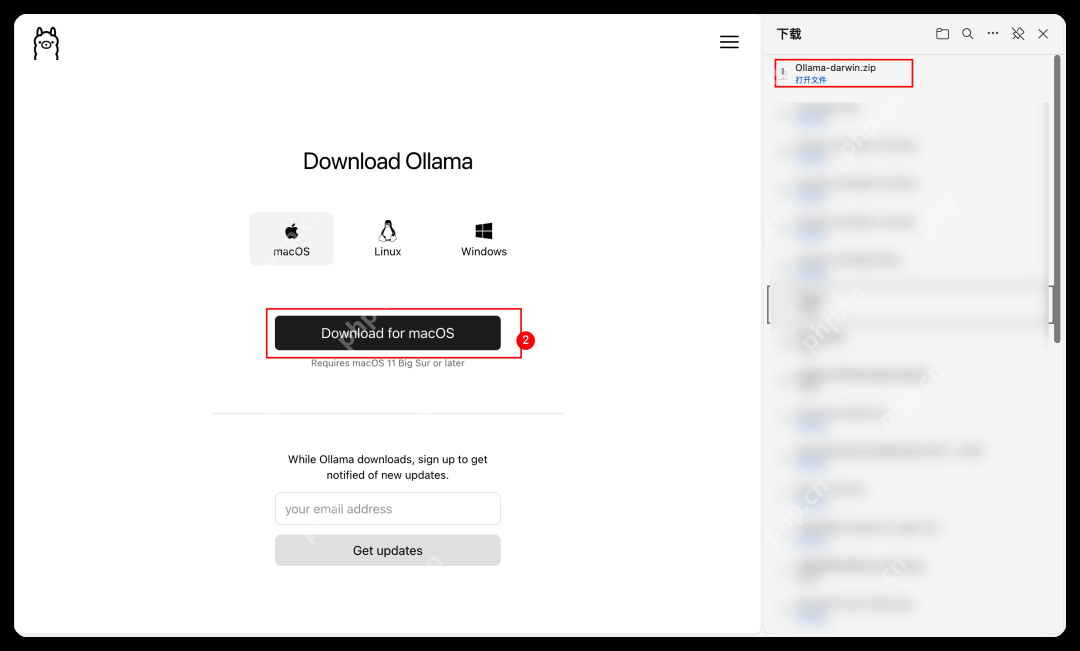

点击Download for macOS即可进行下载。

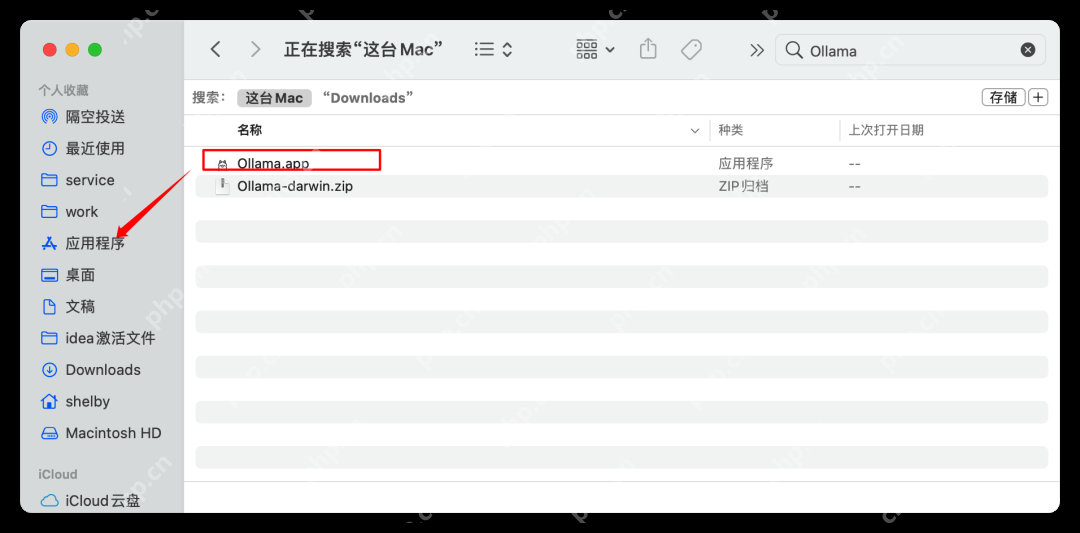

下载完成后解压安装。解压后会产生一个Ollama.app。我们只需要将这个app移动到应用程序中即可,如图所示:

然后找到应用程序中的Ollama,点击进行安装。

会出现如图所示的页面,只需点击Next即可。

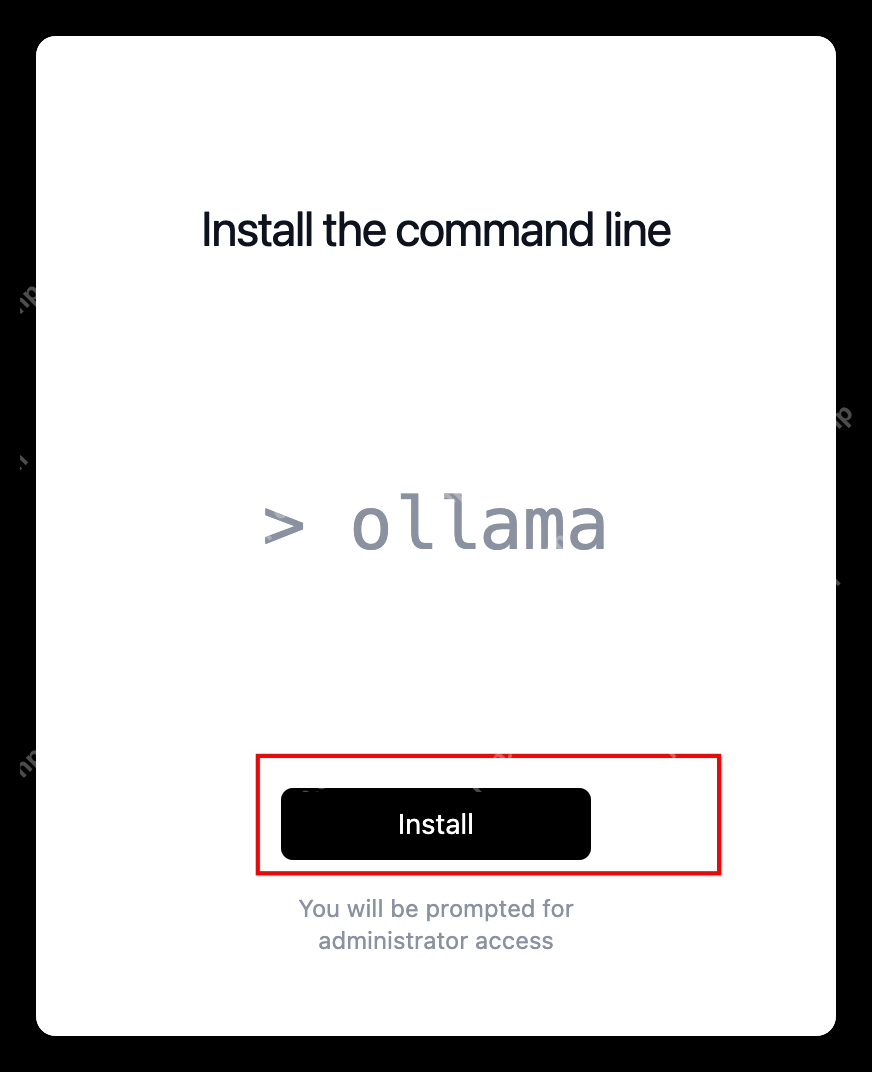

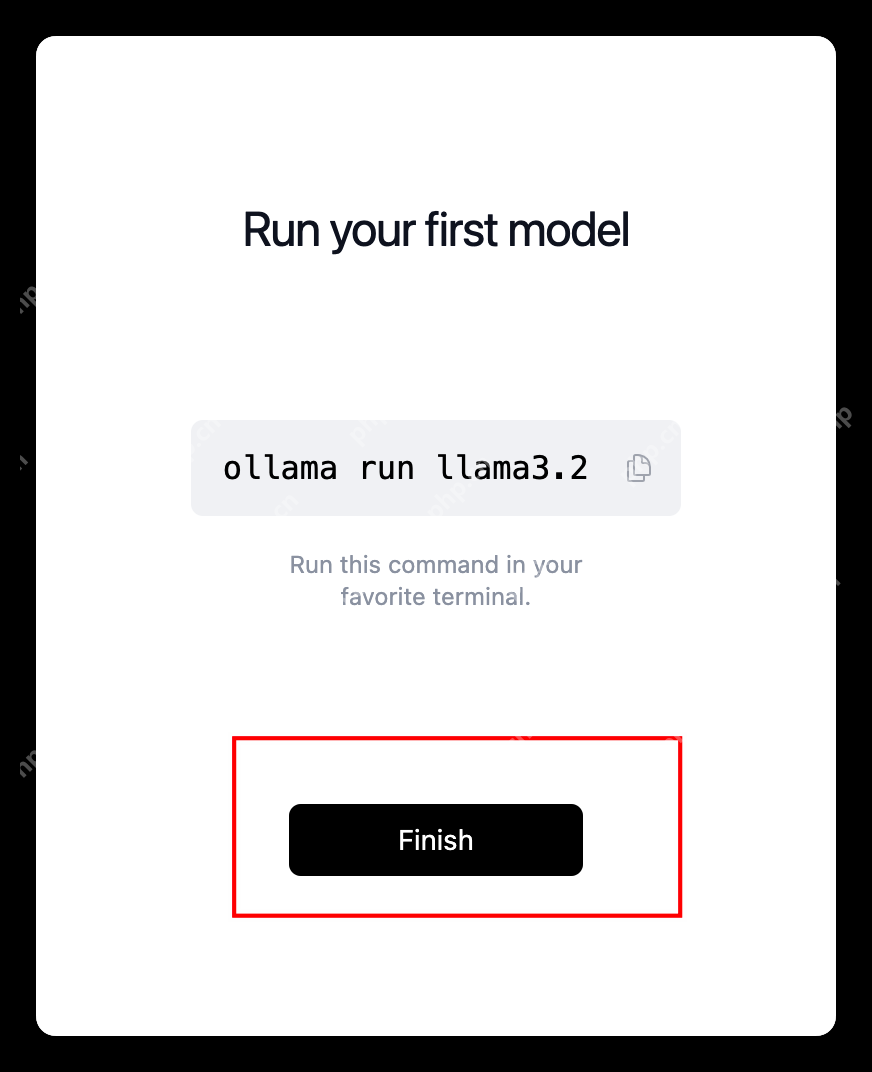

当点击完Next后会出现下图所示的页面,我们继续点击Install即可。

最后会出现Finnish页面,

安装好Ollama后,Mac的通知栏会有一个类似下图的图标,说明安装完毕。

至此,Ollama安装告一段落。

当安装完Ollama后,我们需要回到Ollama的官网找到Models去下载我们的模型,如图所示:点击Download。

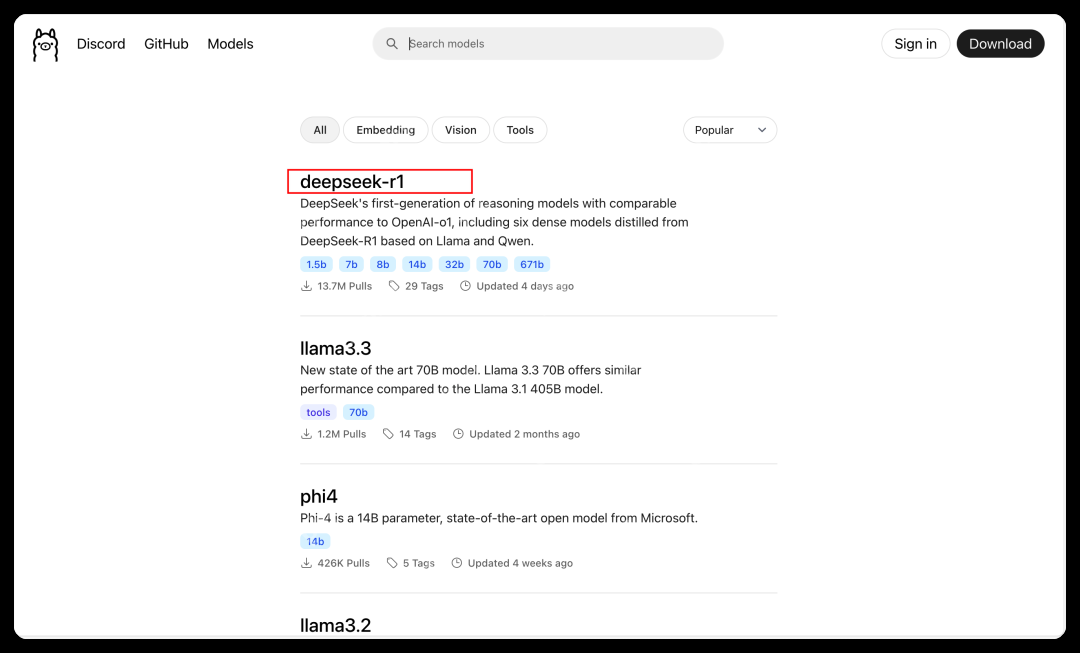

点击完Download后会出现下图所示的页面,也就是我们所需要的东西:

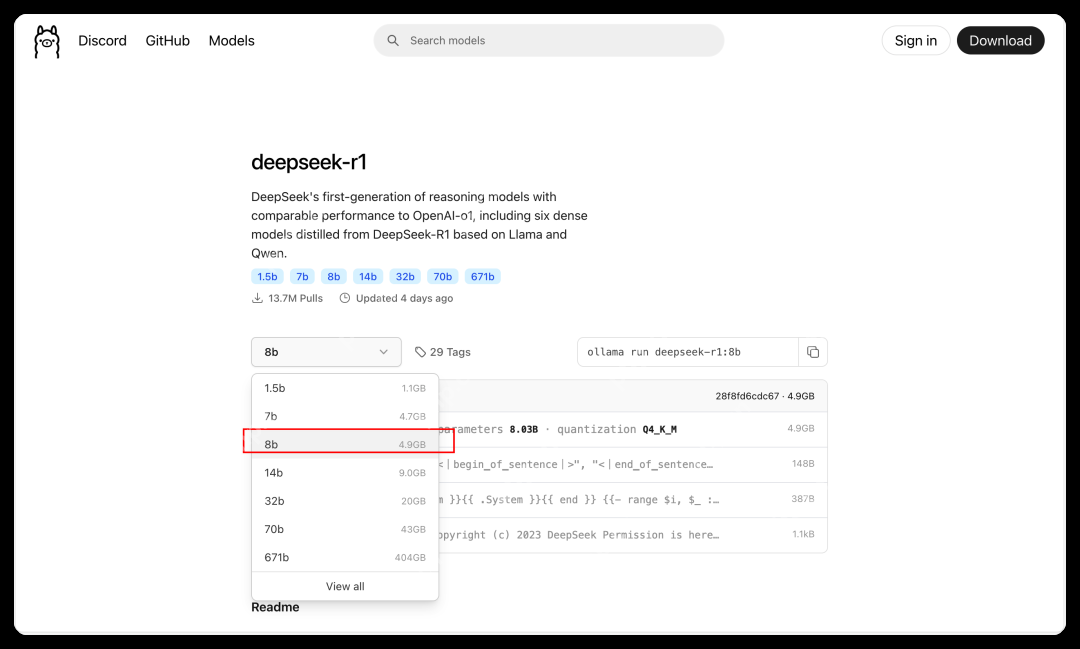

我们点击deepseek-r1。此时会出现如下页面。

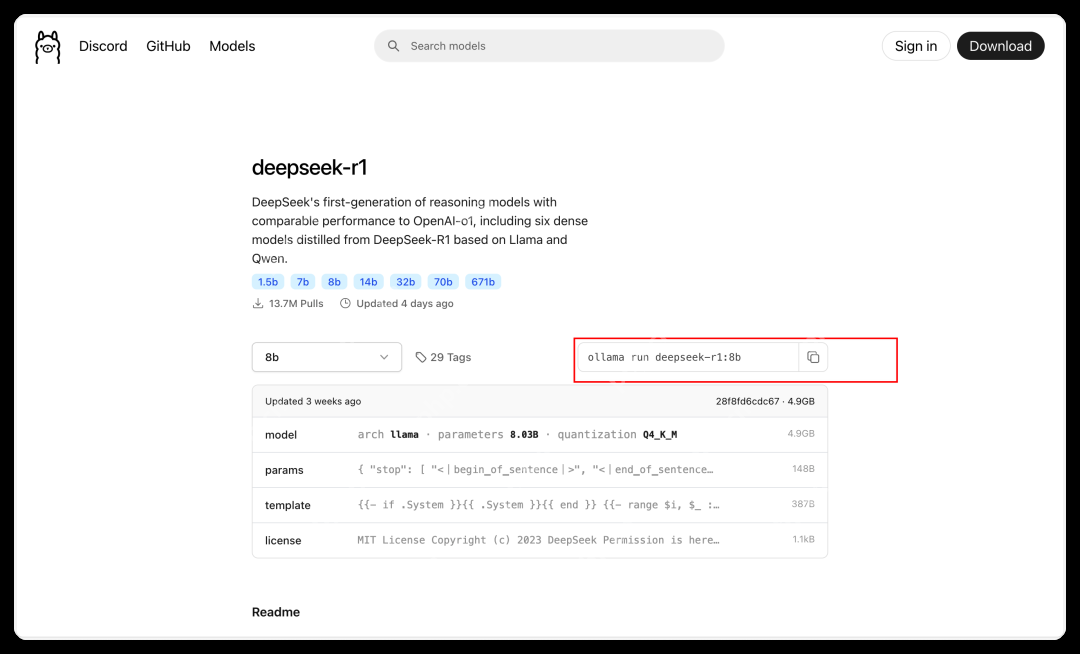

因为测试电脑的硬盘原因,我们选择的是8B版的。可因个人需要进行调整。选择好8B版本后,复制图中的命令进行留存,后面会用到。

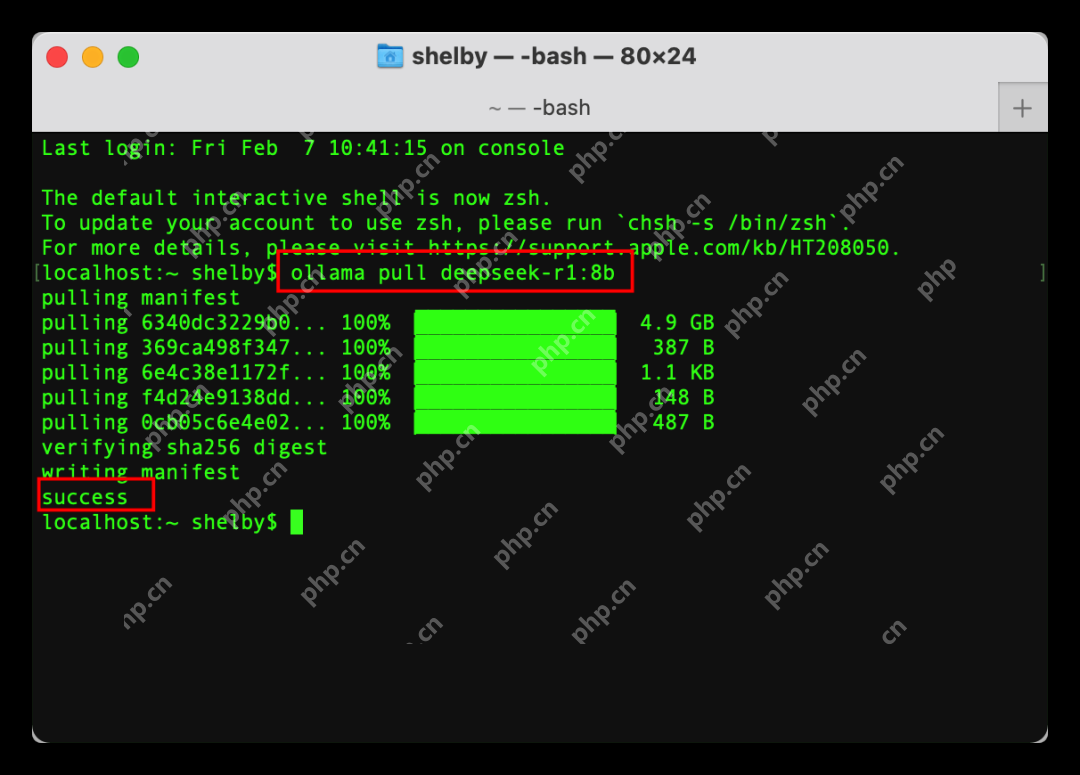

打开我们Mac的终端。输入上面我们记住的命令。记住要将命令中的run替换成pull,然后执行下载。结果如图所示,出现success说明安装成功。

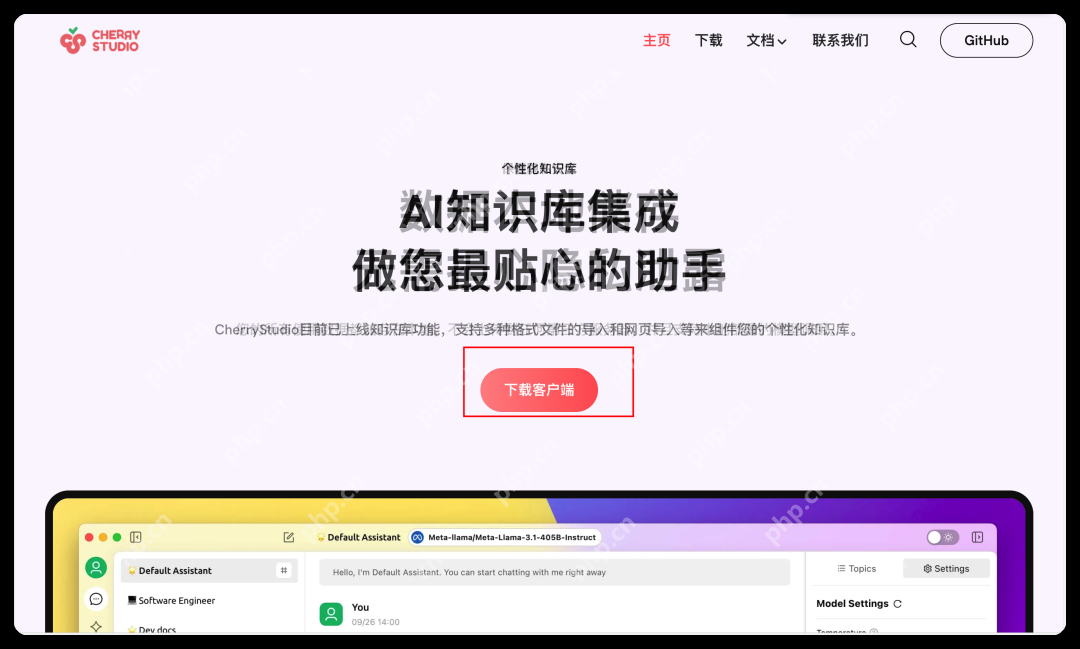

接下来,安装配置Cherry Studio。首先打开Cherry Studio官网:https://cherry-ai.com,点击下载客户端,如图所示:

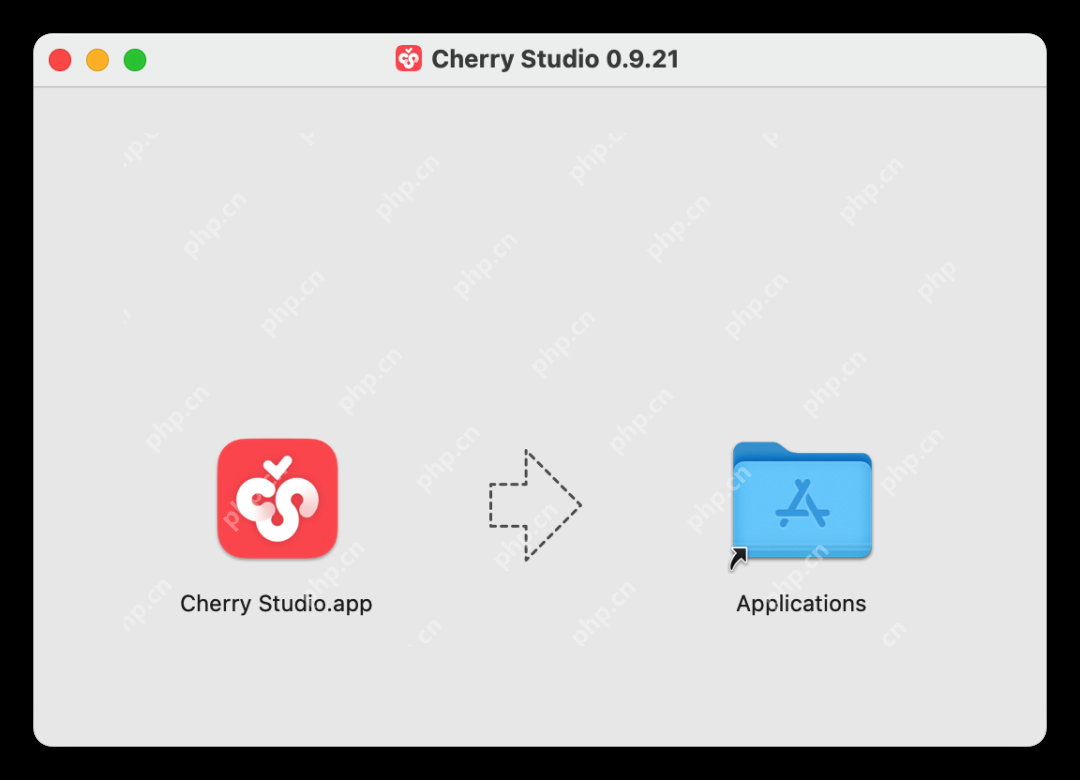

下载完成后会有一个cherry studio的dmg文件,双击安装即可。

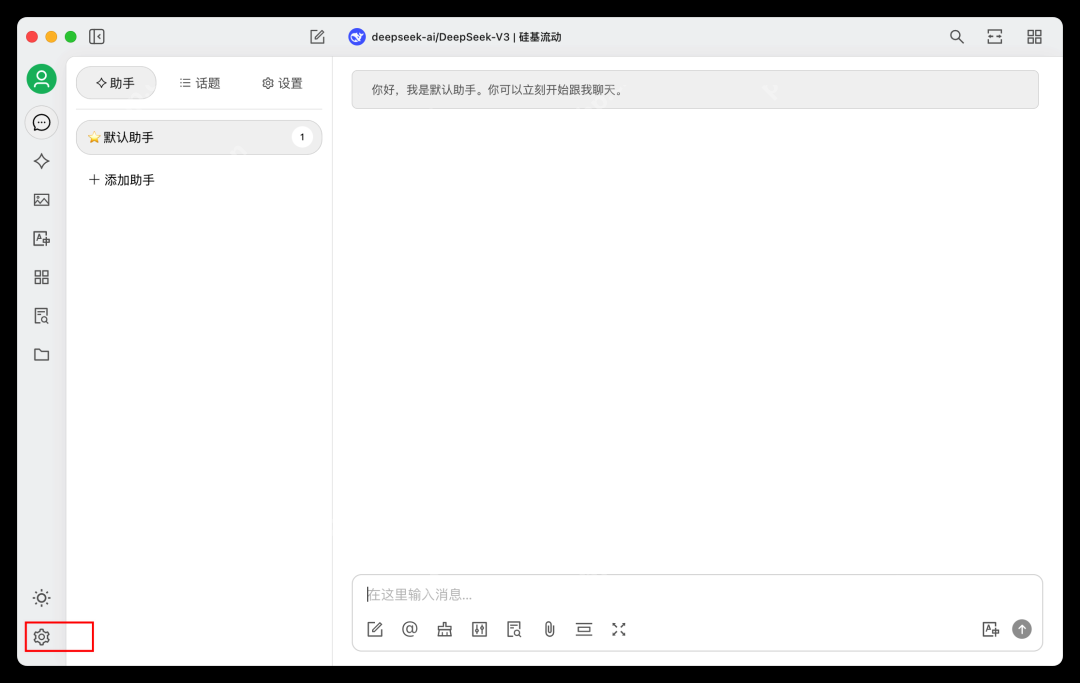

安装完成Cherry Studio后,我们在应用程序中找到并打开它,如图所示:

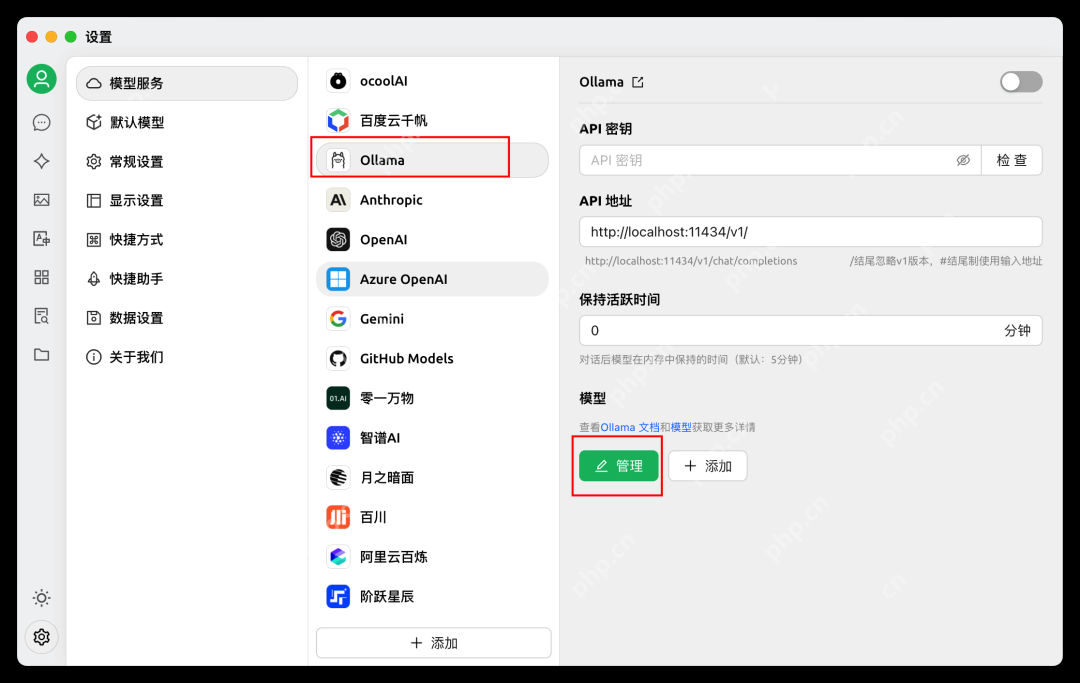

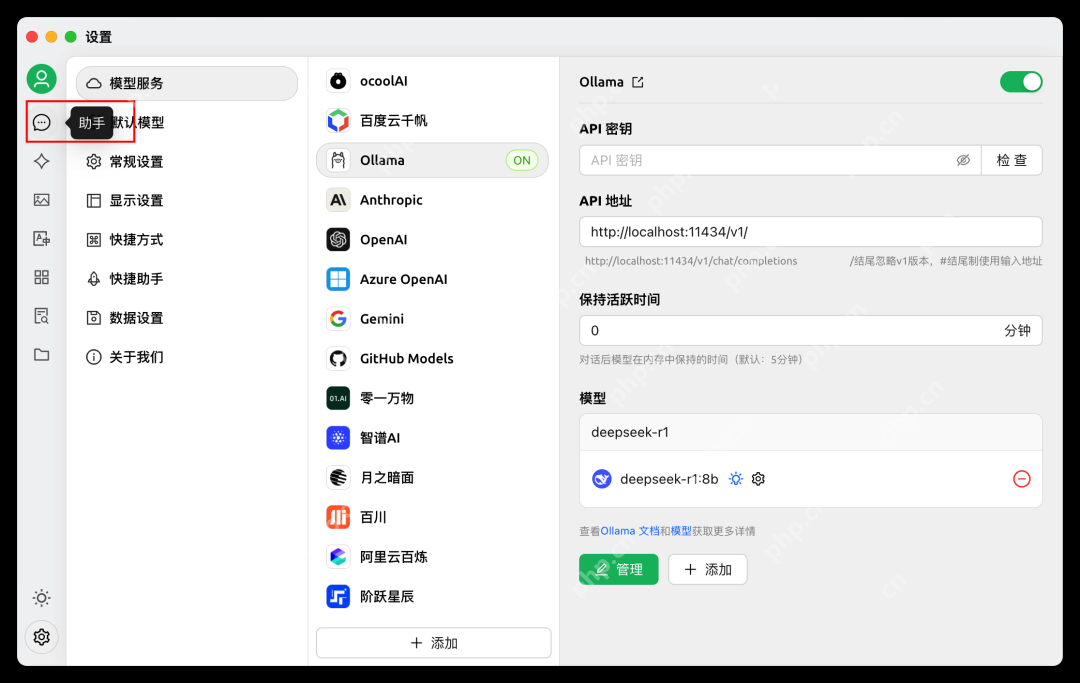

我们点击上图中:设置的小图标,进行配置模型。选择Ollama。然后点击管理。

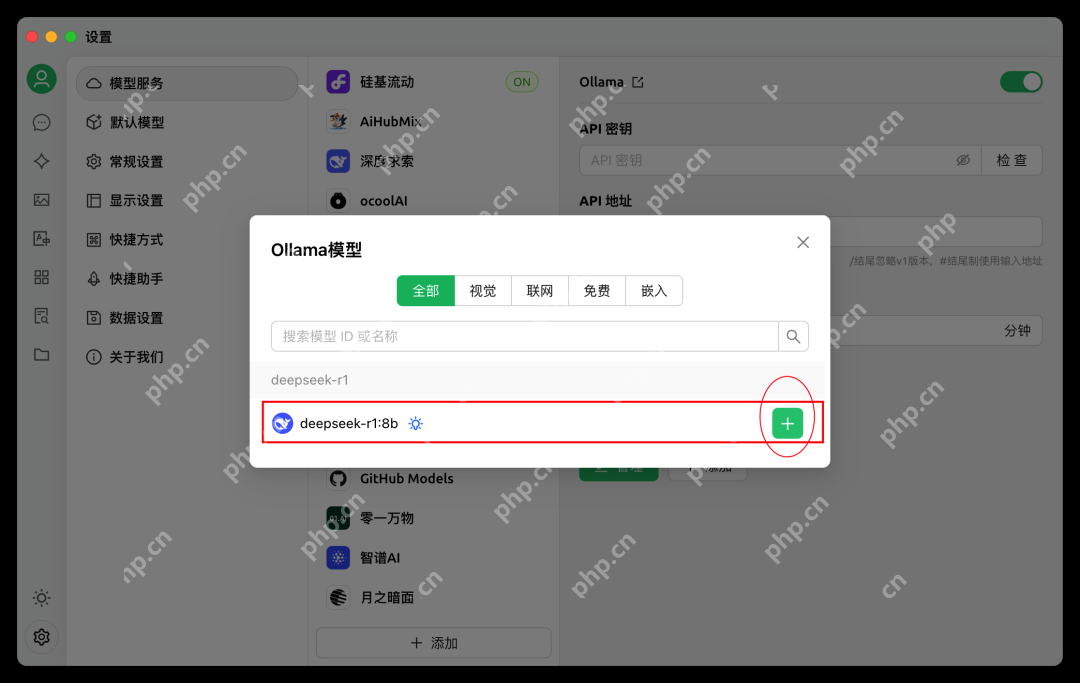

接着选择我们下载的8B版本,或者是你下载的版本。

配置完成后,我们回到聊天助手那里。

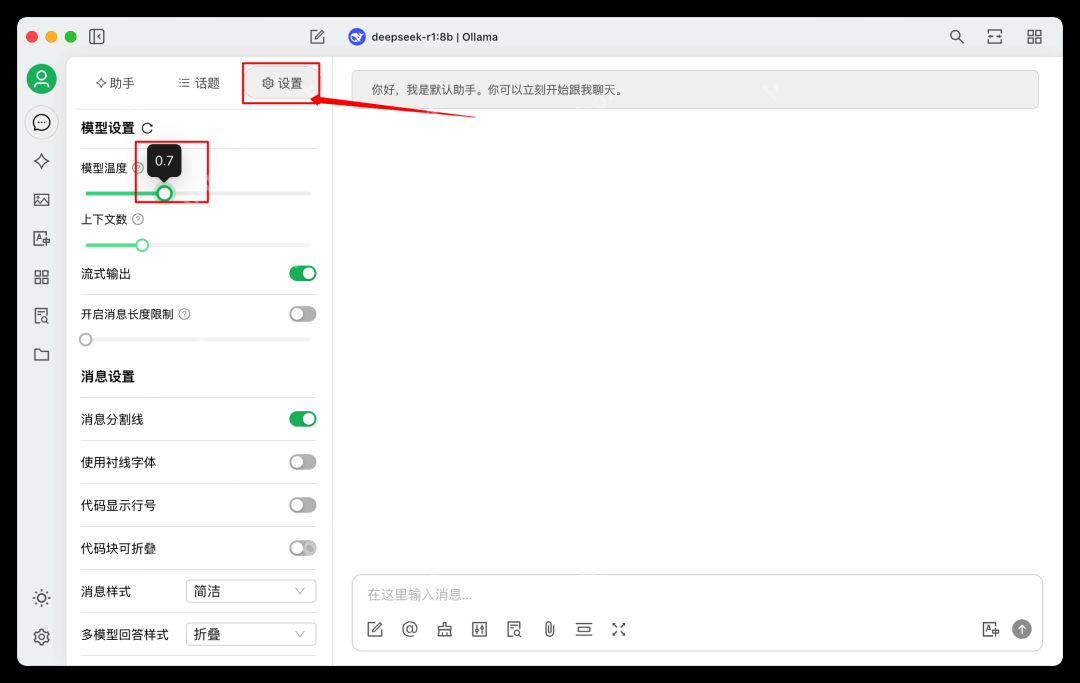

接着按图操作:

最后一步是在设置中配置模型参数:

至此,Cherry Studio设置完毕。

我们就可以进行测试啦:

通过本地部署DeepSeek,我们可以打造属于自己的AI语言模型推理环境,无需依赖云端API,同时能够获得更高的安全性和可控性。

✨ 你是否已经成功部署DeepSeek?欢迎在评论区分享你的经验和遇到的问题!记得关注我,获取更多AI部署教程!?

以上就是本地部署 DeepSeek:打造你的专属 AI 推理环境,简单明了适合新手的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号