这个星期真是热闹非凡,deepseek的开源周(2025年2月24日至28日)连续五天发布了5个核心技术项目,涵盖了ai模型训练、推理优化和文件系统等多个领域。而在今天,deepseek还公布了自己的利润率,真是把用户当成了自家人,哈哈!

接下来,让我们详细了解一下开源周都带来了哪些内容,并探讨这些内容对AI行业的影响。

开源内容详解

第一天:FlashMLA(2月24日)

功能:专为英伟达Hopper GPU优化的高效MLA(多头潜在注意力)解码内核,能够动态分配算力资源以处理不同长度的序列(如长/短文本),避免算力浪费。

亮点:在H800 GPU上可达580 TFLOPS峰值性能,内存带宽达3000GB/s,显著提升翻译、生成等任务的效率。

第二天:DeepEP(2月25日)

功能:首个面向MoE(混合专家模型)训练和推理的开源EP(专家并行)通信库,优化专家模型间的数据传输,支持FP8低精度计算。

亮点:减少通信延迟和资源消耗,提升MoE模型整体运行效率,支持NVLink和RDMA网络。

第三天:DeepGEMM(2月26日)

功能:FP8精度的通用矩阵乘法加速库,针对大模型核心计算环节优化,代码仅300行,支持普通和MoE分组的矩阵运算。

亮点:在Hopper GPU上实现1350+ FP8 TFLOPS性能,安装无需编译,直接通过CUDA运行。

第四天:并行优化策略(DualPipe & EPLB,2月27日)

DualPipe:双向管道并行算法,减少计算与通信阶段的等待时间,硬件利用率提升超30%。

EPLB:专家并行负载均衡器,通过冗余专家策略优化GPU负载分配,减少闲置。

第五天:3FS文件系统 & Smallpond(2月28日)

3FS:基于SSD和RDMA的并行文件系统,数据读取吞吐量达6.6TB/s,加速海量数据训练和推理。

Smallpond:轻量化数据处理框架,简化PB级数据管理。

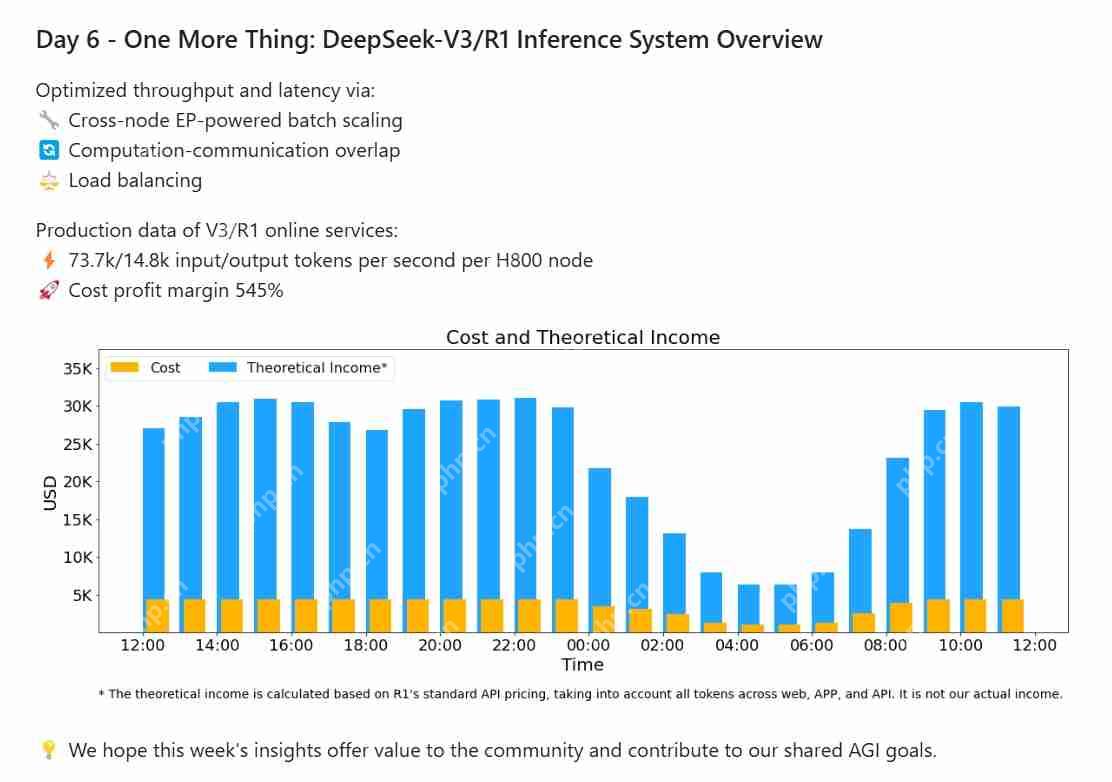

第六天:One More Thing: DeepSeek-V3/R1 推理系统概述(3月1日)

在DeepSeek-V3/R1 推理系统概述里,主要介绍了其高性能推理系统的设计与优化策略。该系统通过以下技术提升效率:

跨节点专家并行(EP)驱动的批量扩展,动态调整计算规模;计算与通信重叠,减少延迟;负载均衡算法,优化GPU资源分配,避免节点过载或闲置。实际运行中,每个英伟达H800节点每秒可处理73.7k输入token和14.8k输出token,理论成本利润率高达545%(受低价策略和夜间折扣影响,实际收入较低)。该系统支撑了DeepSeek-V3/R1模型的高效推理,进一步推动了大模型在低成本、高吞吐场景的落地。

总结

DeepSeek能够将底层技术开源,甚至连自己的利润率都展示给用户看,充分展示了自己的技术实力和自信心(是不是又更高级的模型了?)。这不仅仅是DeepSeek的胜利,更是国内AI行业的胜利。站在DeepSeek的肩膀上,也必然会有越来越多高性能、低费用的大模型被训练出来,为我们的AI普及做出贡献。