deepseek终于推出了他们的首个开源项目,flashmla,这是一个针对nvidia hopper架构gpu优化的高效多头线性注意力(mla)解码内核,专门为处理可变长度序列设计。

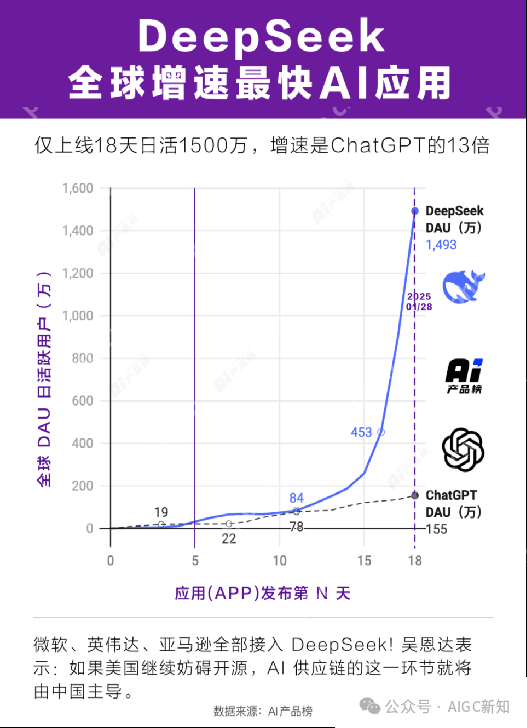

中国版的OpenAI——DeepSeek,在全球引发热议后,发布了他们的首个开源项目。

中国版的OpenAI——DeepSeek,在全球引发热议后,发布了他们的首个开源项目。

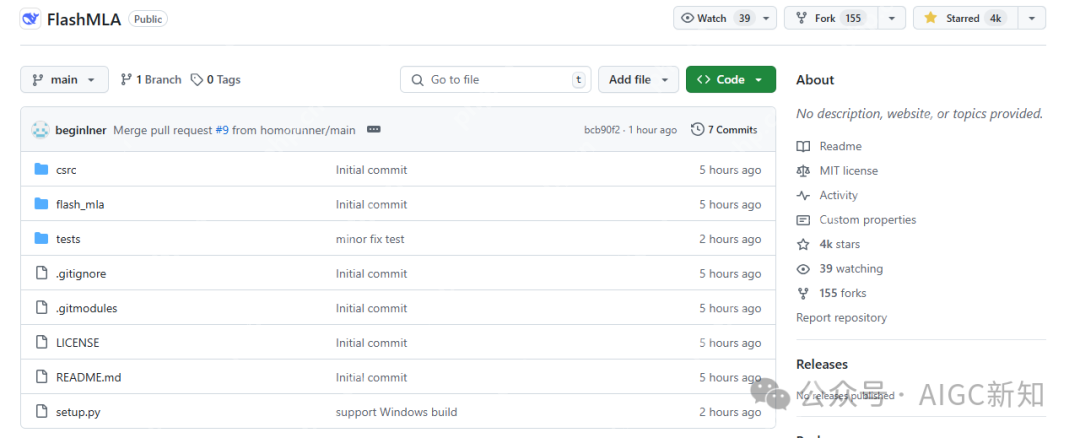

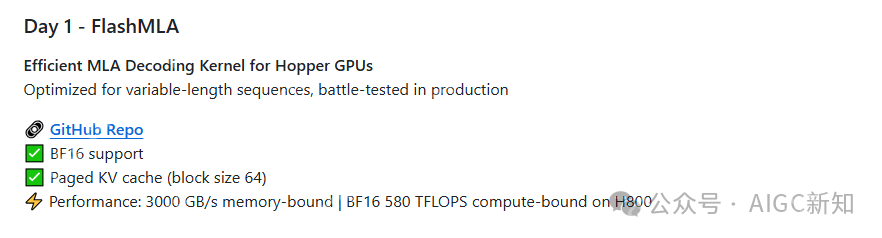

FlashMLA是DeepSeek针对NVIDIA Hopper架构GPU优化的高效MLA解码内核,专为处理可变长度序列而设计。

FlashMLA是DeepSeek针对NVIDIA Hopper架构GPU优化的高效MLA解码内核,专为处理可变长度序列而设计。

通过优化KV缓存机制和使用BF16数据格式,FlashMLA提升了内存和计算效率。在H800 SXM5 GPU上,其内存带宽可达3000 GB/s,计算性能可达580 TFLOPS。

通过优化KV缓存机制和使用BF16数据格式,FlashMLA提升了内存和计算效率。在H800 SXM5 GPU上,其内存带宽可达3000 GB/s,计算性能可达580 TFLOPS。

FlashMLA项目正是幻方AI应用工程师之前提到的萤火AI平台优化英伟达算力集群的技术,现在已经开源!

FlashMLA的设计灵感来源于FlashAttention 2&3和Cutlass项目,支持分页缓存和低秩压缩等技术,进一步优化了内存管理和计算性能。

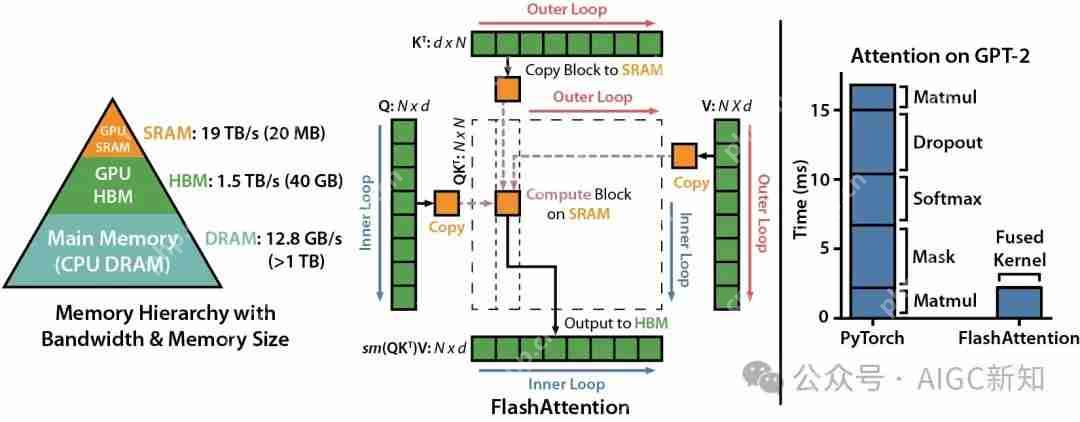

它结合了FlashAttention的高效内存管理和并行化策略,以及CUTLASS的底层优化和架构支持,从而在Hopper架构上实现了高效的多头注意力解码。这种结合使得FlashMLA在变长序列场景下表现出色,同时充分利用了现代GPU的硬件特性。

FlashAttention是具有IO感知功能的快速且节省内存的Exact Attention。

FlashAttention是具有IO感知功能的快速且节省内存的Exact Attention。

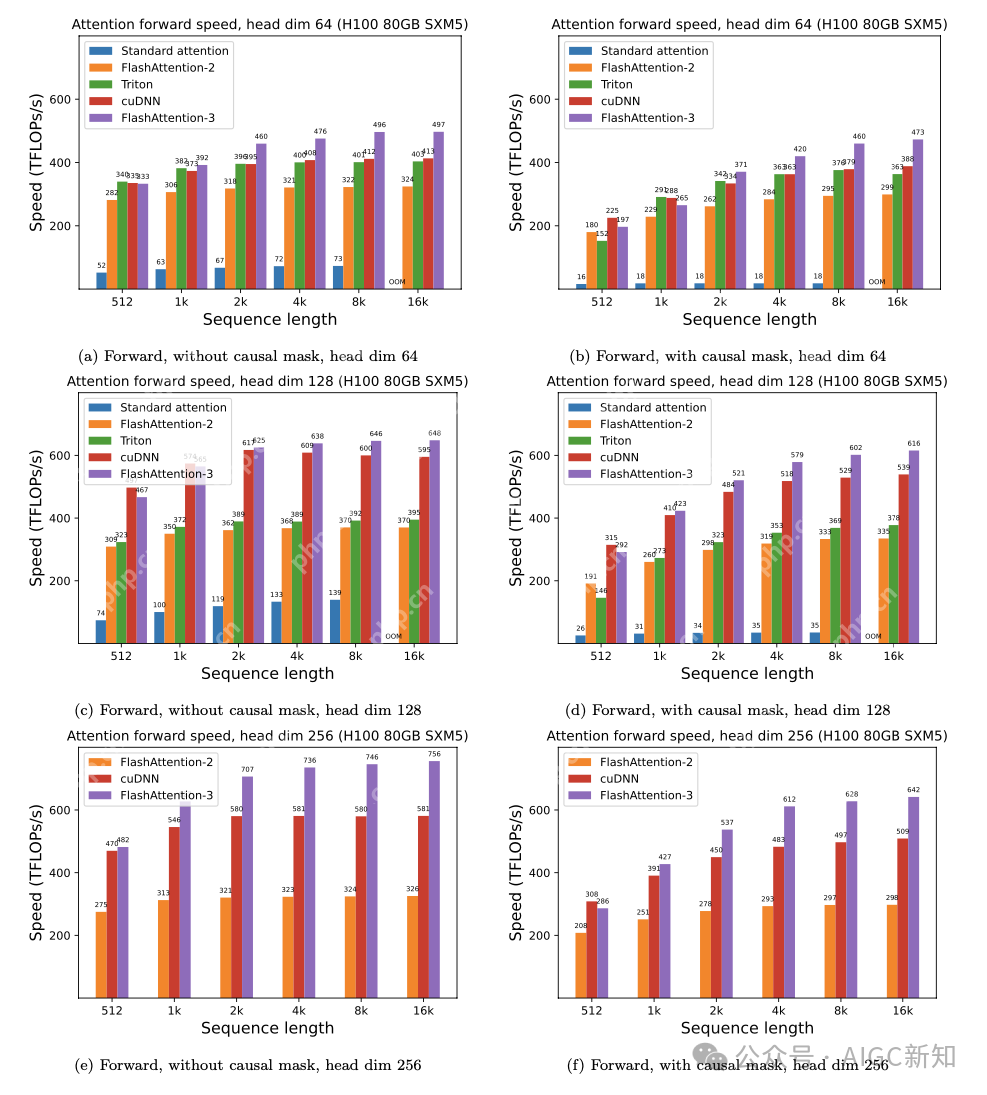

FlashAttention-3针对Hopper GPU(例如H100)进行了优化,并进行了相关测试。

FlashAttention-3针对Hopper GPU(例如H100)进行了优化,并进行了相关测试。

FlashAttention-3在H100 80GB SXM5上使用FP16时速度提升。FlashMLA借鉴了FlashAttention的分页缓存机制,优化了缓存的管理和访问效率,特别是在变长序列场景下。

FlashAttention-3在H100 80GB SXM5上使用FP16时速度提升。FlashMLA借鉴了FlashAttention的分页缓存机制,优化了缓存的管理和访问效率,特别是在变长序列场景下。

FlashAttention-2和FlashAttention-3的并行化和工作分配策略为FlashMLA提供了优化思路,使其能够在Hopper架构上实现高效的计算。

FlashAttention对BF16和FP16的支持也为FlashMLA提供了参考,使其能够充分利用现代GPU的硬件特性。

CUTLASS是由NVIDIA开发的高性能CUDA模板库,用于实现矩阵乘法(GEMM)和相关计算。

提供了高度可定制的模板抽象,支持多种数据类型(如FP64、FP32、FP16、BF16等)和混合精度计算。

FlashMLA的部分优化灵感来源于CUTLASS的特性:

FlashMLA的部分优化灵感来源于CUTLASS的特性:

底层优化:CUTLASS提供了高效的矩阵乘法内核和底层优化策略,FlashMLA借鉴了这些优化思路,以实现高效的多头注意力计算。架构支持:CUTLASS对多种NVIDIA GPU架构的支持为FlashMLA提供了硬件适配的基础,使其能够针对Hopper架构进行优化。

模板化设计:CUTLASS的模板化设计思想为FlashMLA提供了代码结构和模块化的参考,使其能够灵活地实现不同的优化策略。适用于大语言模型(LLM)的推理任务,在需要高效解码的自然语言处理(NLP)场景中表现出色。开发者可以通过简单的安装命令快速部署,运行基准测试脚本验证性能。

模板化设计:CUTLASS的模板化设计思想为FlashMLA提供了代码结构和模块化的参考,使其能够灵活地实现不同的优化策略。适用于大语言模型(LLM)的推理任务,在需要高效解码的自然语言处理(NLP)场景中表现出色。开发者可以通过简单的安装命令快速部署,运行基准测试脚本验证性能。

FlashMLA需要以下硬件和软件环境:

FlashMLA需要以下硬件和软件环境:

硬件:NVIDIA Hopper架构GPU(例如H800 SXM5)。软件:CUDA 12.3及以上版本;PyTorch 2.0及以上版本。安装FlashMLA:通过以下命令安装FlashMLA:

python setup.py install

运行基准测试脚本:

python tests/test_flash_mla.py

使用CUDA 12.6,在H800 SXM5上实现高达3000 GB/s的内存绑定配置和580 TFLOPS的计算绑定配置。

看看DeepSeek开源的项目,这才是真正的OpenAI!

DeepSeek正在以实际的行动践行"开源、AI先锋"的使命,这是国运级别的创新,也是本土诞生的幸事。

"若前方无路,我便踏出一条路,若天理不容,我便逆转这乾坤",

从DeepSeek爆火的背后,看到的是哪吒的不屈精神,誓要打破这层技术壁垒,为后来者镗出一条路来。

以上就是DeepSeek开源FlashMLA,从GPU架构进行优化开始......的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号