通过使用open webui,我们可以更方便地访问和操作vllm版本的模型,就像使用官方deepseek一样,直接在网页上进行对话。以下是对open webui的详细介绍和使用指南:

Open WebUI 是一个功能强大且用户友好的自托管 Web 用户界面,用于管理和操作各种本地和云端的人工智能模型。它支持多种大型语言模型(LLM)运行程序,包括 Ollama 和兼容 OpenAI 的 API,旨在完全离线操作。以下是关于 OpenWeb UI 的详细介绍:

主要特点:

安装和使用:

创建conda虚拟环境

conda create --name openwebui python=3.12.9

安装Open WebUI

pip install open-webui -i https://mirrors.aliyun.com/pypi/simple/

启动Open WebUI

# 禁用OLLAMA API export ENABLE_OLLAMA_API=False # 设置OpenAI API的基础URL为本地服务器 export OPENAI_API_BASE_URL=http://127.0.0.1:8000/v1 # 设置默认模型路径 export DEFAULT_MODELS="/root/deepseekr1_1.5b/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B" # 启动Open WebUI open-webui serve

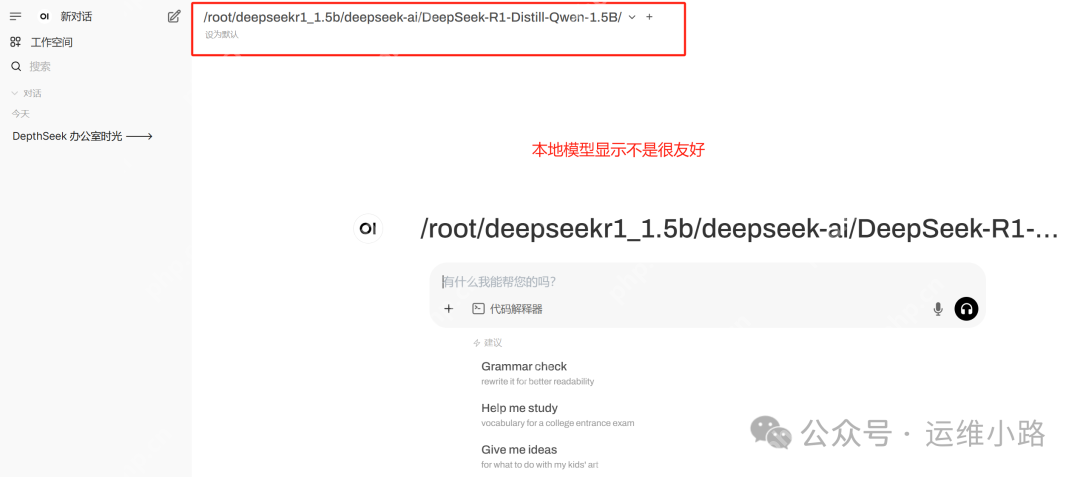

配置Open WebUI

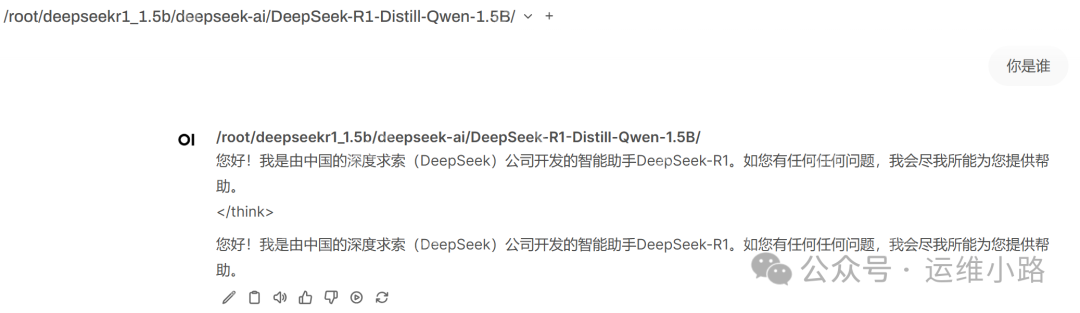

开始提问

通过上述步骤,您可以轻松地使用Open WebUI来管理和操作vLLM版本的模型,实现便捷的网页对话体验。

以上就是DeepSeek-Open WebUI部署的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号