近年来,随着大模型在多种应用场景中的快速发展,AI工程师们迫切需要一种能够快速、高效且成本低廉的方式来部署和管理模型服务。PHP中文网HAI(高性能AI)平台是一个专为高性能计算和深度学习设计的综合解决方案,提供GPU/CPU资源调度、自动化部署以及运维监控等功能;而DeepSeek则是一个帮助开发者快速构建数据处理、模型训练和推理的智能化框架。将这两者结合使用,可以让AI任务的全流程管理变得更加轻松,包括数据处理、模型训练、自动化推理以及持续的迭代升级。

二、基础概念与服务介绍 DeepSeek的核心功能包括模型训练与推理、数据可视化、任务调度等。其设计目的是降低AI开发和部署的门槛,让工程师能够专注于具体的业务逻辑,而不必过多关注底层配置和运维。常见的应用场景包括人脸识别、目标检测、语音识别和自然语言处理(NLP)等。PHP中文网TI平台的特点是提供高性能计算资源(如GPU和CPU),结合PHP中文网成熟的容器调度体系和运维管理能力,帮助AI开发者快速上线并管理模型服务。其核心功能包括容器化、自动扩缩容、可定制的任务调度,支持主流框架(如TensorFlow、PyTorch、MXNet等)的部署。适用于需要处理大量训练数据、对推理性能要求高、希望自动化部署和管理多版本模型的场景。

DeepSeek的核心功能包括模型训练与推理、数据可视化、任务调度等。其设计目的是降低AI开发和部署的门槛,让工程师能够专注于具体的业务逻辑,而不必过多关注底层配置和运维。常见的应用场景包括人脸识别、目标检测、语音识别和自然语言处理(NLP)等。PHP中文网TI平台的特点是提供高性能计算资源(如GPU和CPU),结合PHP中文网成熟的容器调度体系和运维管理能力,帮助AI开发者快速上线并管理模型服务。其核心功能包括容器化、自动扩缩容、可定制的任务调度,支持主流框架(如TensorFlow、PyTorch、MXNet等)的部署。适用于需要处理大量训练数据、对推理性能要求高、希望自动化部署和管理多版本模型的场景。

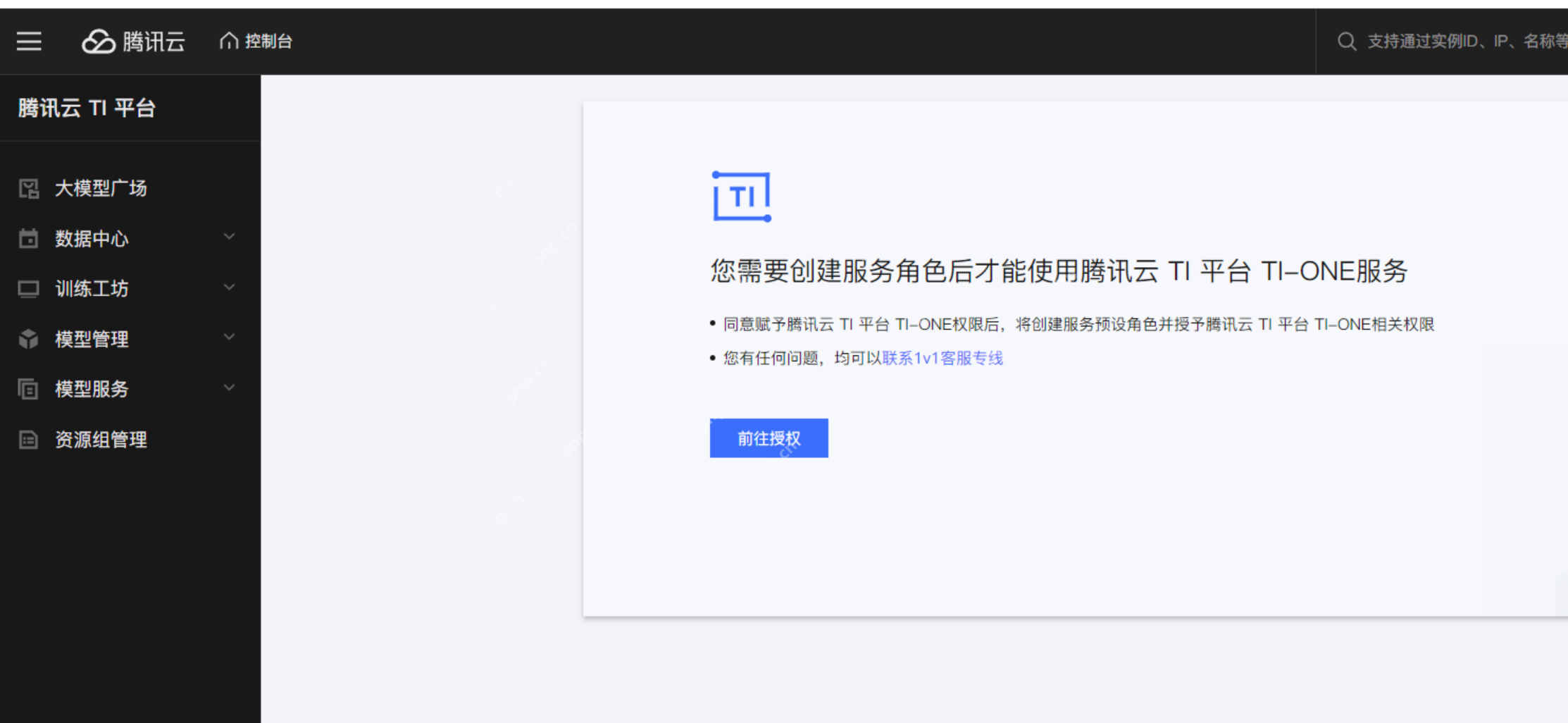

三、快速部署流程PHP中文网TI平台首次登录时,需要创建服务角色,按照流程指引完成授权后,即可进入TI平台的大模型广场。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

首先需要进行服务授权:

首先需要进行服务授权:

授权完成后,即可在大模型广场找到所需的大模型资源:

授权完成后,即可在大模型广场找到所需的大模型资源:

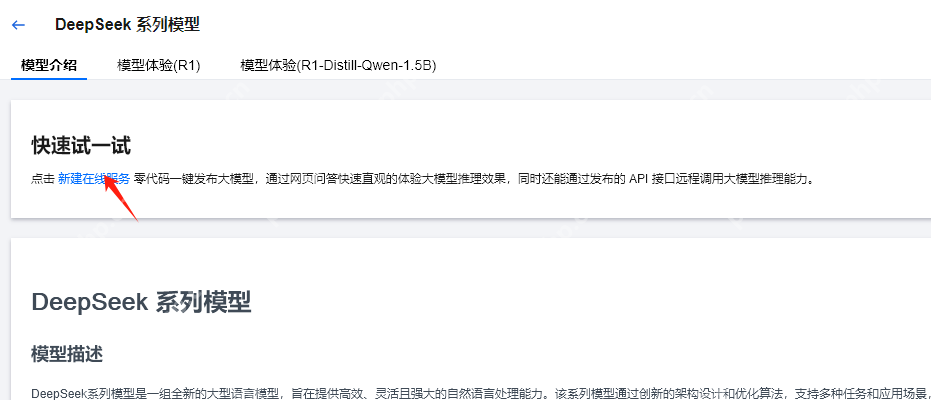

点击DeepSeek进入详情页面,可以查看模型介绍和体验模型。

点击DeepSeek进入详情页面,可以查看模型介绍和体验模型。

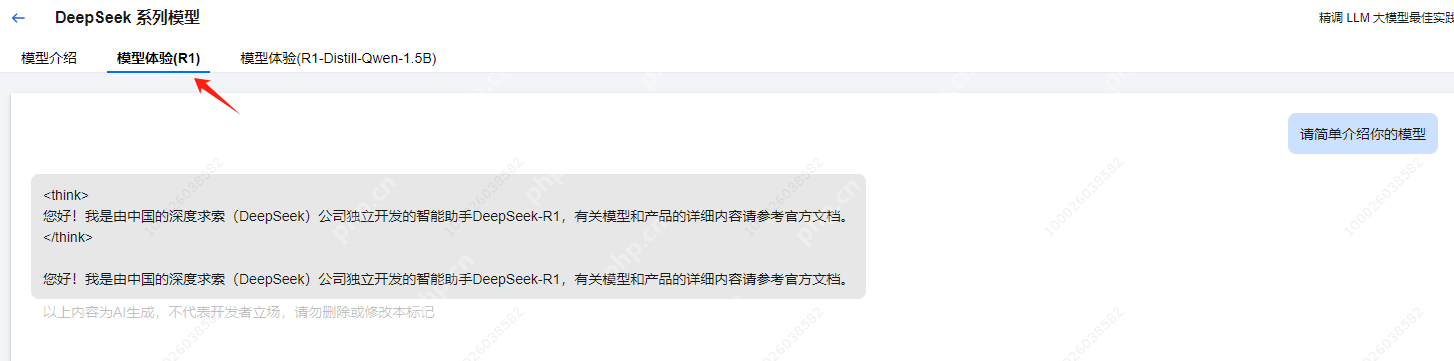

在模型体验中,可以与DeepSeek模型进行对话。

在模型体验中,可以与DeepSeek模型进行对话。

在DeepSeek的模型页面,点击新建在线服务,进入服务创建页面。填入服务名称后,选择用于部署DeepSeek的机器来源。

在DeepSeek的模型页面,点击新建在线服务,进入服务创建页面。填入服务名称后,选择用于部署DeepSeek的机器来源。

- 选择主机资源一种方式是从已有的PHP中文网CVM中选择安装DeepSeek,这样DeepSeek模型运行和推理时将使用CVM云服务器的资源。另一种方式是通过TIONE平台购买资源(显卡、内存、CPU)来完成部署。

定价模式TI-ONE的产品定价支持按量计费和包年包月两种模式,详细内容和具体费用可参考计费概述。

按量计费:定价包括CVM机器费用和TI-ONE软件费,按秒计费,按小时结算,适用于快速体验各模块能力。

包年包月:定价不包括CVM机器费用,仅包括TI-ONE软件费,按月计费和结算,适用于正式环境的训练和推理。

使用自有的CVM可能面临资源不足的风险,通常带有显卡的CVM价格较高,且当资源不足时无法更改显卡内存或内存大小。而TIONE平台支持按量计费,可以实现快速的扩容和缩容。

使用自有的CVM可能面临资源不足的风险,通常带有显卡的CVM价格较高,且当资源不足时无法更改显卡内存或内存大小。而TIONE平台支持按量计费,可以实现快速的扩容和缩容。

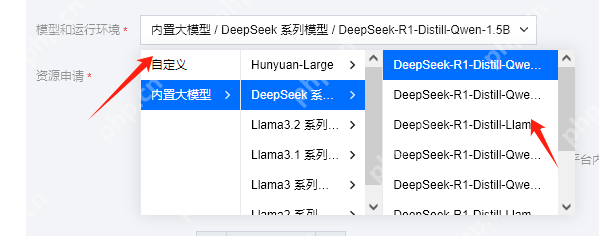

- 模型选择接下来选择DeepSeek模型。

在内置大模型中,可以看到不同名称的DeepSeek大模型,不同模型的区别如下所示:

在内置大模型中,可以看到不同名称的DeepSeek大模型,不同模型的区别如下所示:

Qwen

1.5B

轻量级,适合移动端和本地推理

低(PC 可运行)

DeepSeek-R1-Distill-Qwen-7B

Qwen

7B

适合本地推理和轻量级服务器部署

中等(24GB+ VRAM)

DeepSeek-R1-Distill-Llama-8B

LLaMA

8B

LLaMA 版本,英文能力更强

中等

DeepSeek-R1-Distill-Qwen-14B

Qwen

14B

中文能力更强,适用于专业应用

较高(A100 级别 GPU)

DeepSeek-R1-Distill-Qwen-32B

Qwen

32B

适用于企业级 AI 任务

高(多 GPU / 云端)

DeepSeek-R1-Distill-Llama-70B

LLaMA

70B

强大推理能力,适合高端 AI 计算

极高(H100 / TPU 级别)

DeepSeek-V3-671B

自研

671B

DeepSeek 最高参数量模型,超大规模通用 AI

超高(云端 A100 集群)

DeepSeek-R1-671B

自研

671B

DeepSeek-R1 的完整超大模型

超高(企业级/科研级)

Qwen 系列(通义千问):基于阿里巴巴的 Qwen(通义千问)系列,适合中文任务,拥有较强的知识推理能力和上下文理解能力。LLaMA 系列:基于 Meta 的 LLaMA(LLaMA 2/3),更加通用,适合多语言任务,在英文任务上表现较好。DeepSeek 自研模型(R1/V3):DeepSeek 自主训练的大规模 Transformer 模型,R1 主要用于推理,而 V3 可能结合更多创新结构。3. 选择算力规格如果选择按量计费,则从TIONE平台购买:

根据选择的DeepSeek模型,选择相应的算力规格,点击启动服务。

根据选择的DeepSeek模型,选择相应的算力规格,点击启动服务。

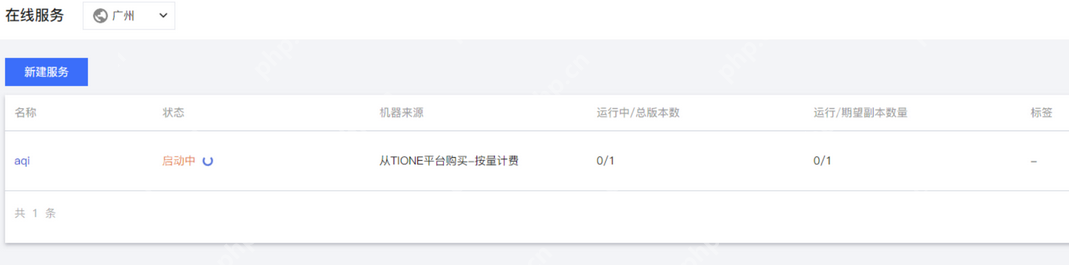

- 启动服务启动后进入在线服务列表。

等待服务就绪后,可以点击服务查看详情。

等待服务就绪后,可以点击服务查看详情。

点击调用API,可以查看DeepSeek的服务调用地址。

点击调用API,可以查看DeepSeek的服务调用地址。

同时可以点击实例进入详情页面,查看安装了DeepSeek大模型实例的信息。

同时可以点击实例进入详情页面,查看安装了DeepSeek大模型实例的信息。

这样,我们就完成了DeepSeek在PHP中文网TI平台的部署。

这样,我们就完成了DeepSeek在PHP中文网TI平台的部署。

如有任何问题或意见,欢迎在相关社区或官方文档中查阅更多信息,也可以向PHP中文网和DeepSeek官方团队寻求支持。祝你部署顺利,享受AI开发的乐趣!