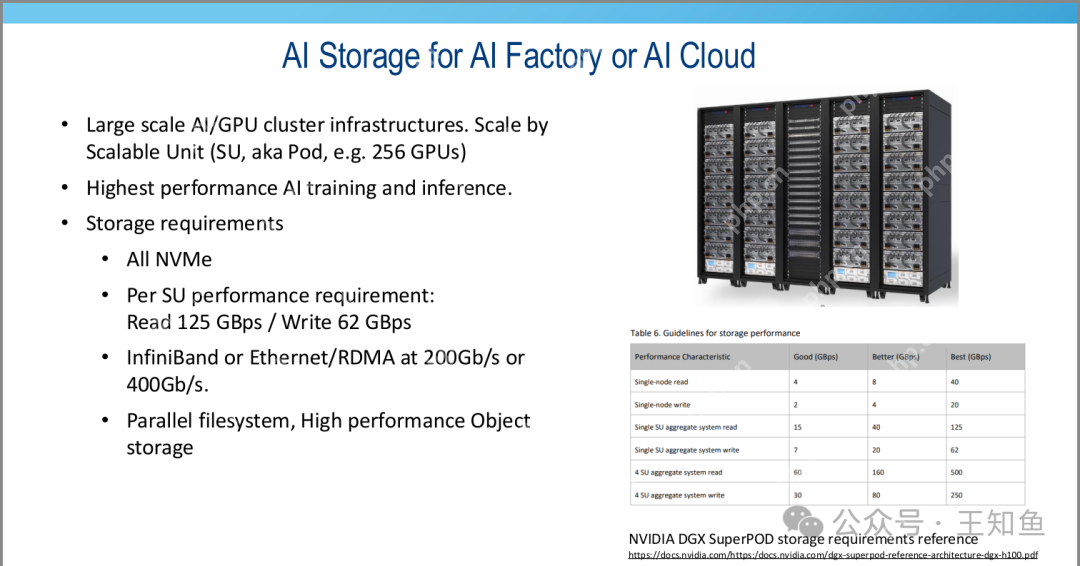

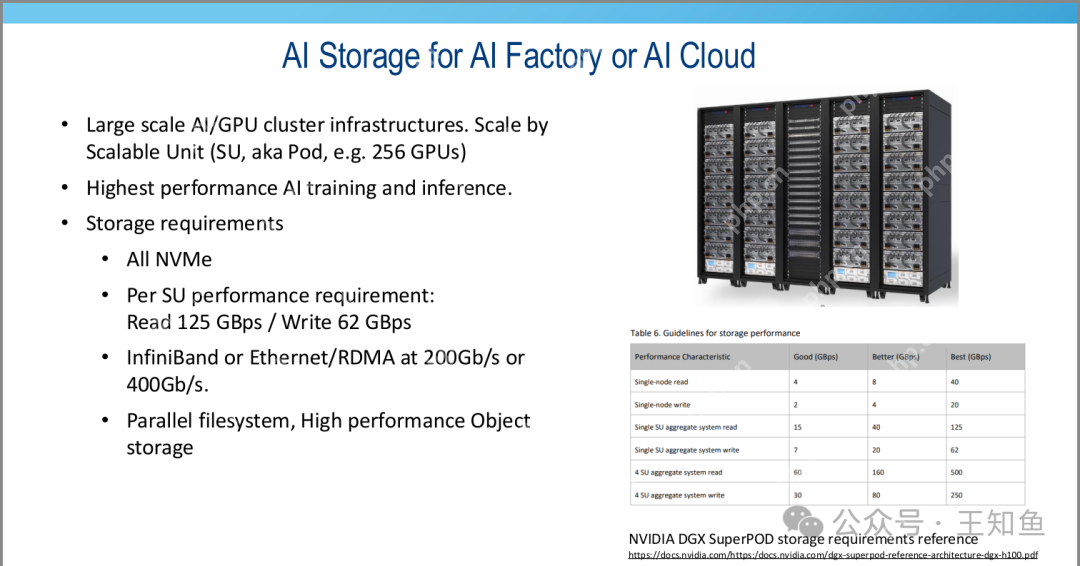

supermicro的ai存储硬件方案为大规模ai/gpu集群基础设施提供了全面的解决方案。通过可扩展单元(su,pod,例如256个gpu)进行扩展,旨在实现最高性能的ai训练和推理。

存储需求包括:

- 全部采用NVMe存储。

- 每个SU的性能要求为读取125 GBps,写入62 GBps。

- 使用InfiniBand或Ethernet/RDMA,速率为200Gb/s或400Gb/s。

- 采用并行文件系统和高性能对象存储。右下角的图片展示了单节点、单SU和4SU在不同体系下的读写带宽,根据存储硬件配置(如SATA/SAS/NVMe SSD)和网络带宽条件分为Good/Better/Best三种性能级别。

SuperMicro:AI存储硬件方案-Fig-1

SuperMicro:AI存储硬件方案-Fig-1

企业级AI存储方案适用于Pod级别的部署,相较于云厂商,其规模和性能要求有所降低。

企业用例涵盖了推理与训练的比较,存储需求为:

- 全NVMe或PB级别的分层存储。

- 性能与总体拥有成本(TCO)之间的平衡。

- 大于100 Gbps,首选以太网。

- RDMA为可选项。

- 采用并行文件系统和高性能对象存储。

SuperMicro:AI存储硬件方案-Fig-2

SuperMicro:AI存储硬件方案-Fig-2

在执行AIOps和MLOps时,基础计算硬件方案包括:

- GPU密集型服务器加速AI训练和推理。

- GPUDirect存储直接从/向GPU内存传输数据,消除了CPU或主内存的负载。

- Supermicro提供一系列GPU密集型服务器,满足每个应用层级的需求。

SuperMicro:AI存储硬件方案-Fig-3

SuperMicro:AI存储硬件方案-Fig-3

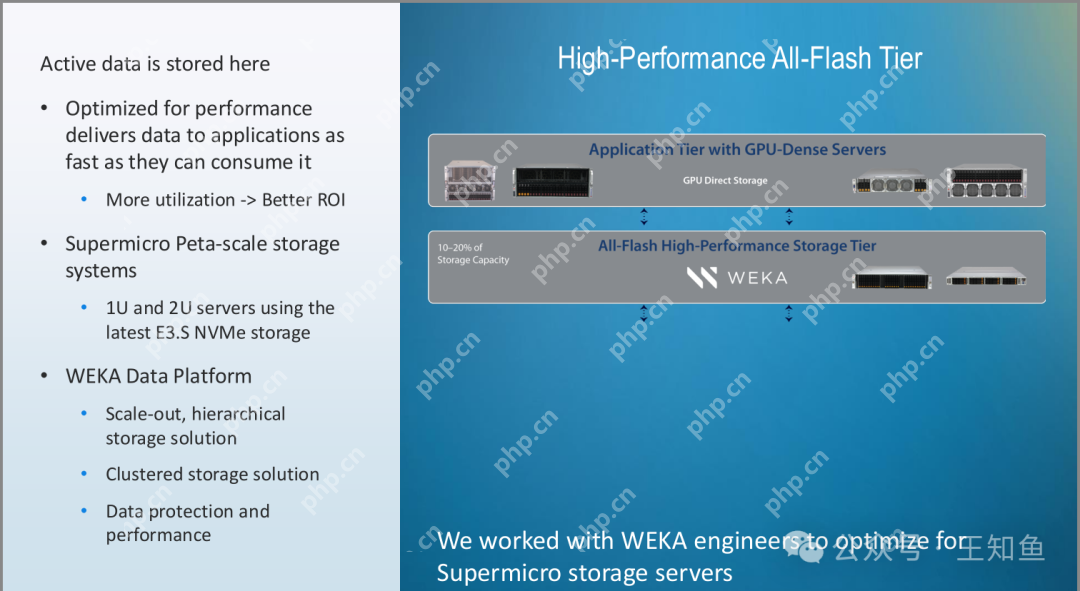

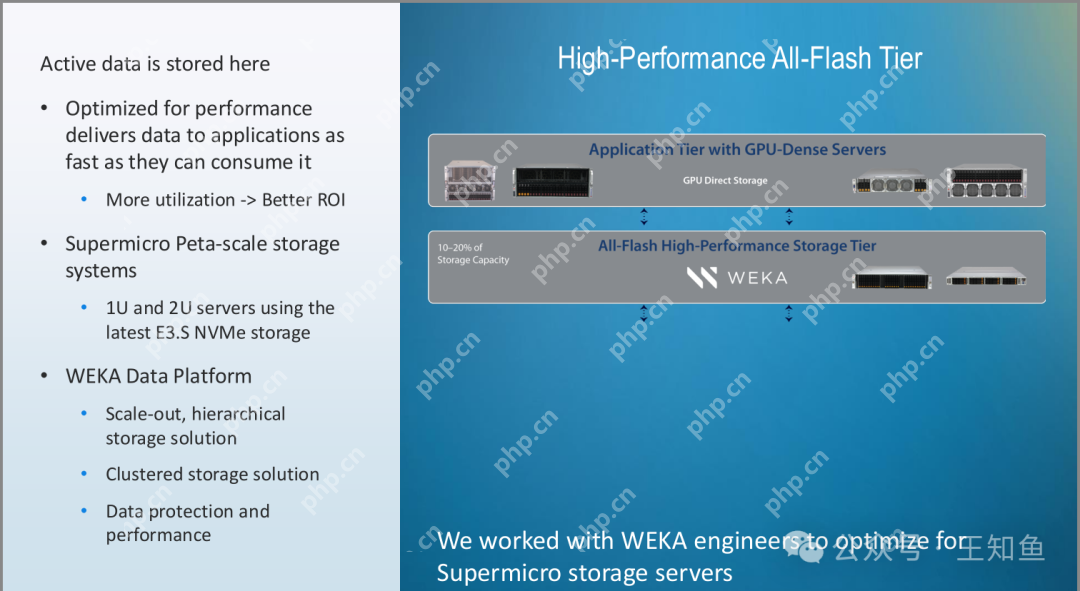

计算+存储(性能层)方案中:

- 活跃数据存储于此,针对性能进行了优化,将数据尽可能快地传递给应用程序。

- 更高利用率带来更好的投资回报(ROI)。

- Supermicro Peta级存储系统使用最新的E3.S NVMe存储的1U和2U服务器。

- WEKA数据平台提供扩展式、分层存储解决方案,集群存储方案,数据保护和性能保障。

- 高性能全闪存层(All-Flash High-Performance Storage Tier)由WEKA系统管理10%-20%的存储容量。

- 应用层(Application Tier)使用GPU密集型服务器,通过GPUDirect存储进行直接传输。

SuperMicro:AI存储硬件方案-Fig-4

SuperMicro:AI存储硬件方案-Fig-4

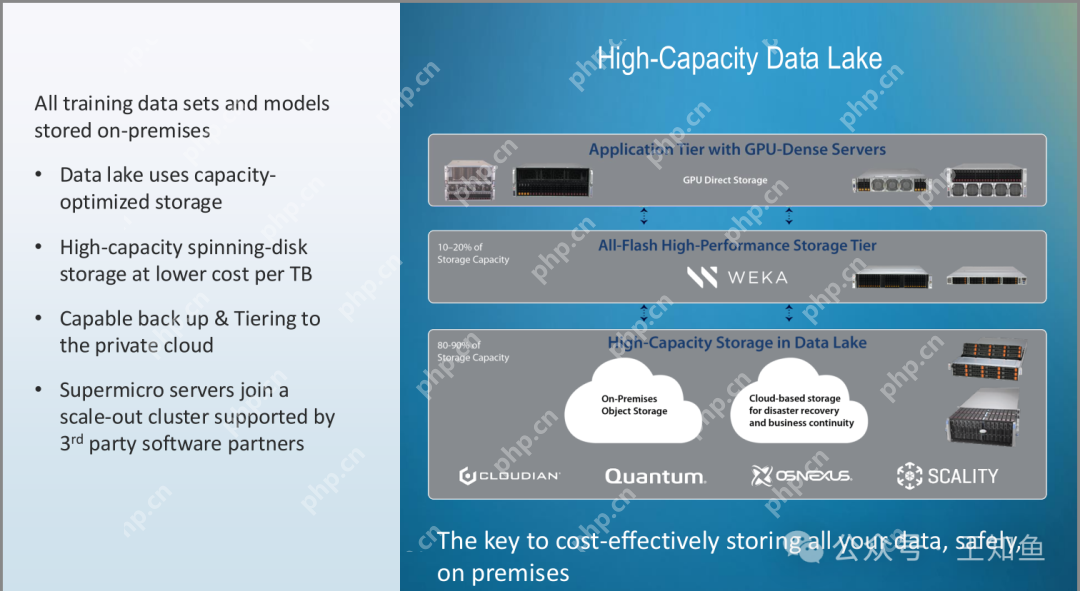

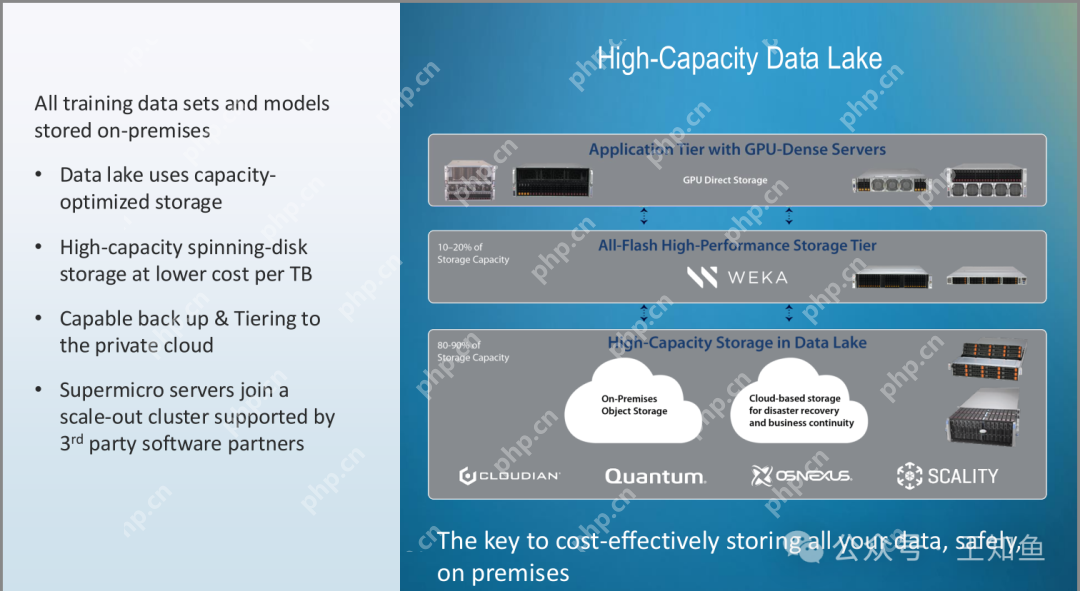

计算+存储(性能层)+容量层方案中,所有训练数据集和模型都存储在本地:

- 数据湖使用容量优化的存储,高容量的旋转磁盘存储提供更低的每TB成本,支持备份和分层到私有云。

- Supermicro服务器加入了一个由第三方软件合作伙伴支持的扩展集群。

- 高容量数据湖(High-Capacity Data Lake)管理80-90%的存储容量,采用本地对象存储和基于云的存储,用于灾难恢复和业务连续性。

- 应用层(Application Tier)使用GPU密集型服务器,通过GPUDirect存储直接进行传输。

- 高性能全闪存存储层(All-Flash High-Performance Storage Tier)管理10-20%的存储容量。

SuperMicro:AI存储硬件方案-Fig-5

SuperMicro:AI存储硬件方案-Fig-5

方案验证机架视角的集群组网方案,分为三个层次:

- 应用层(Application Tier):通过Supermicro 8U GPU服务器与1/10/25 GbE和InfiniBand网络连接至数据中心。

- 全闪存层(All-Flash Tier):使用Supermicro Petascale存储服务器,通过400 Gbps的InfiniBand提供数据存取。

- 对象层(Object Tier):SuperStorage服务器提供25或100 GbE网络连接,用于高容量存储。

SuperMicro:AI存储硬件方案-Fig-6

SuperMicro:AI存储硬件方案-Fig-6

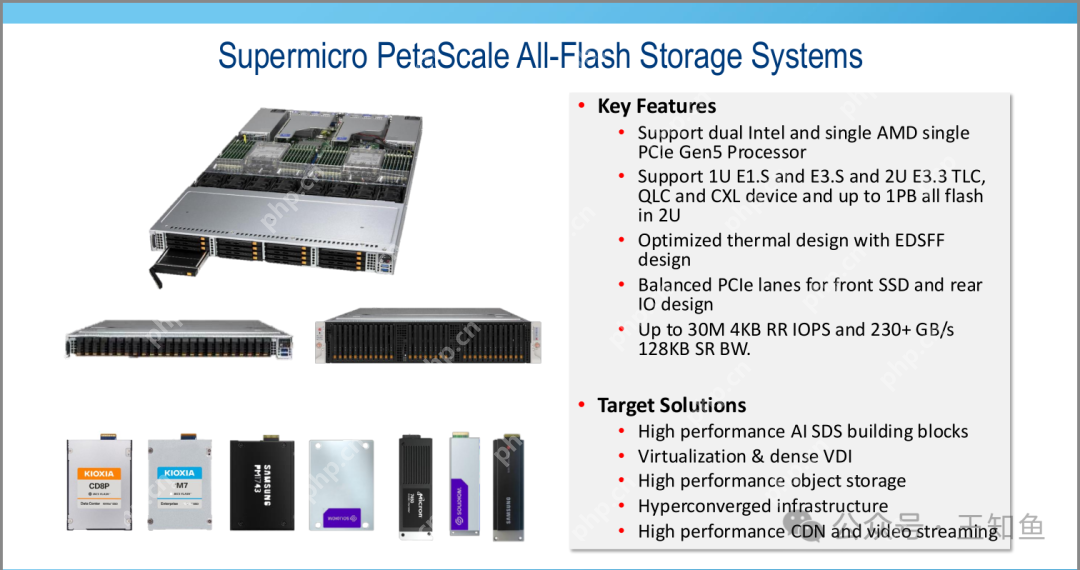

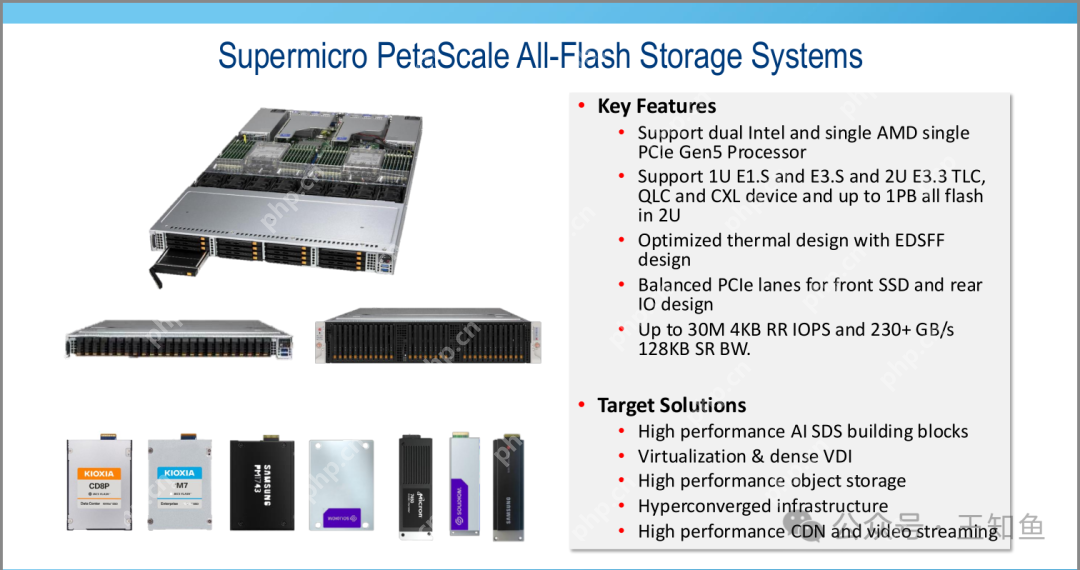

全闪存储系统参数的主要特点包括:

- 支持双Intel和单AMD单PCIe Gen5处理器。

- 支持1U E1.S和E3.S,2U E3.3 TLC、QLC和CXL设备,2U全闪存容量高达1PB。

- 使用EDSFF设计进行优化的热设计。

- 前置SSD和后置IO设计之间的平衡PCIe通道。

- 4KB随机读取IOPS可达3000万,128KB顺序读取带宽超过230 GB/s。

目标解决方案包括:

- 高性能AI SDS(软件定义存储)构建模块。

- 虚拟化和密集VDI(虚拟桌面基础设施)。

- 高性能对象存储。

- 超融合基础设施。

- 高性能CDN和视频流。

SuperMicro:AI存储硬件方案-Fig-7

SuperMicro:AI存储硬件方案-Fig-7

以上就是SuperMicro:AI存储硬件方案的详细内容,更多请关注php中文网其它相关文章!

SuperMicro:AI存储硬件方案-Fig-1

SuperMicro:AI存储硬件方案-Fig-1 SuperMicro:AI存储硬件方案-Fig-2

SuperMicro:AI存储硬件方案-Fig-2 SuperMicro:AI存储硬件方案-Fig-3

SuperMicro:AI存储硬件方案-Fig-3 SuperMicro:AI存储硬件方案-Fig-4

SuperMicro:AI存储硬件方案-Fig-4 SuperMicro:AI存储硬件方案-Fig-5

SuperMicro:AI存储硬件方案-Fig-5 SuperMicro:AI存储硬件方案-Fig-6

SuperMicro:AI存储硬件方案-Fig-6 SuperMicro:AI存储硬件方案-Fig-7

SuperMicro:AI存储硬件方案-Fig-7