关注公众号回复“激活码”,获取最新idea激活码。

自然语言处理(NLP)技术已成为数字化转型的核心推动力,近期备受瞩目的DeepSeek-R1作为新一代智能语言模型,在语义理解、推理能力和生成质量上取得了突破性进展。DeepSeek团队通过研究证明,较大模型的推理模式可以被精炼成较小的模型,并在性能上优于通过强化学习(RL)在小模型上发现的推理模式。结合最新的硬件发展趋势,本文为您提供精准的部署版本选择建议,希望能帮助您在不同场景下最大化发挥模型效能。

DeepSeek-R1模型概述该模型系列采用MoE(混合专家)架构,支持从移动端到超算集群的弹性部署:

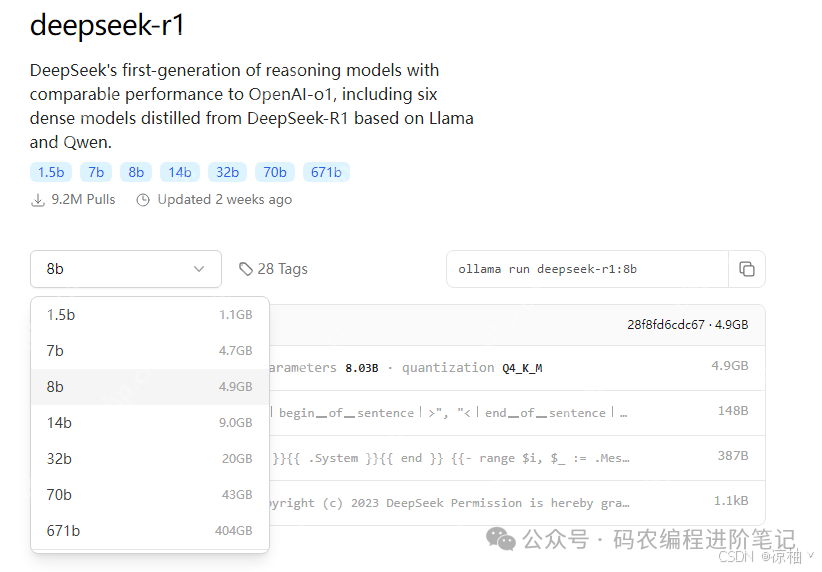

通过ollama下载DeepSeek-R1模型地址:deepseek-r1。

硬件要求根据计算密度需求提供两套配置方案:

| 模型版本 | 基础配置(CPU推理) | 加速配置(GPU推理) | 存储需求 | 内存要求 | 适用场景 |

|---|---|---|---|---|---|

| 1.5B | 至少4核x86/ARMv9 | (非必需)NVIDIA RTX 3050 6GB | 3.2GB | 8GB+ | 智能家电控制/工业传感器文本预处理 |

| 7B-8B | 8核Zen4/13代酷睿 | 至少RTX 3060 12GB 推荐:RTX 4070 Ti Super 16GB |

8-10GB | 16GB+ | 本地知识库问答/代码补全 |

| 14B-32B | 16核至强W7-2495X | 推荐:RTX 4090 24GB | 15-35GB | 48GB+ | 企业级文档分析/多轮对话系统 |

| 70B | 32核EPYC 9654 | 2x RTX 5090 32GB(NVLink互联) | 70GB+ | 128GB+ | 科研计算/金融建模 |

| 671B | 64核EPYC 9684X集群 | 8x H100 80GB(InfiniBand互联) | 300GB+ | 512GB+ | 国家级AI研究/通用人工智能探索 |

硬件选型建议:

适用场景:

轻量级部署:

企业级部署:

科研级部署:

性能优化建议:

注意事项:

在模型部署后,建议持续监控系统资源使用情况,以确保模型运行稳定。可以使用工具如htop或nvidia-smi来监控CPU、内存和显存的使用情况。

以上就是DeepSeek-R1模型本地部署如何选择版本(硬件要求与适用场景)的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号