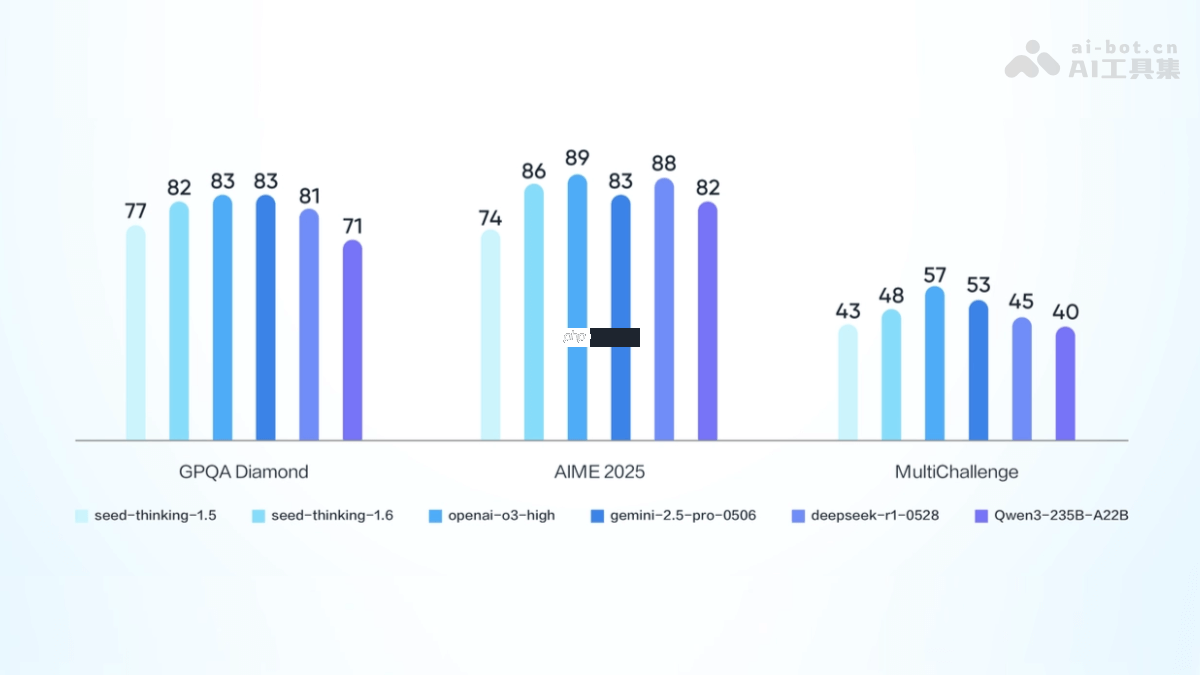

豆包大模型1.6(doubao-seed-1.6)是字节跳动推出的一款多模态深度思考型大模型。它支持auto、thinking和non-thinking三种模式,能够处理文本、图像、视频等多样输入形式,并输出高质量文字内容。该模型具备256k的长上下文窗口,最大输入长度可达224k tokens,输出长度最高支持16k tokens,推理能力强劲。在多个权威测评中表现优异,尤其在推理与数学能力方面显著提升。该模型广泛应用于内容创作、智能对话、代码生成等领域,为开发者和企业提供强大的ai工具。目前,豆包1.6已上线火山引擎平台,支持api调用。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

豆包大模型1.6的主要功能

豆包大模型1.6的主要功能

豆包大模型1.6的定价模式

豆包大模型1.6的定价模式豆包大模型1.6采用统一价格体系,无论是否启用深度思考模式,无论是文本还是视觉输入,均按相同标准计费。

<code>import requests

import json

<h1>API密钥和接口地址</h1><p>api_key = "your_api_key"

api_secret = "your_api_secret"

model_version = "doubao-seed-1.6" # 或doubao-seed-1.6-thinking、doubao-seed-1.6-flash

api_url = f"<a href="https://www.php.cn/link/dfd1e5f05a19b577a89a80f1cc545b7e">https://www.php.cn/link/dfd1e5f05a19b577a89a80f1cc545b7e</a>}"</p><h1>请求参数</h1><p>data = {

"input": "你的输入文本",

"parameters": {

"max_length": 256, # 输出的最大长度

"temperature": 0.7, # 随机性参数

"top_p": 0.9, # 核心采样参数

"top_k": 50, # 核心采样参数

"do_sample": True # 是否采样

}

}</p><h1>设置请求头</h1><p>headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}</p><h1>发起请求</h1><p>response = requests.post(api_url, headers=headers, data=json.dumps(data))</p>

<div class="aritcle_card">

<a class="aritcle_card_img" href="/ai/726">

<img src="https://img.php.cn/upload/ai_manual/000/000/000/175680204067325.png" alt="豆包大模型">

</a>

<div class="aritcle_card_info">

<a href="/ai/726">豆包大模型</a>

<p>字节跳动自主研发的一系列大型语言模型</p>

<div class="">

<img src="/static/images/card_xiazai.png" alt="豆包大模型">

<span>834</span>

</div>

</div>

<a href="/ai/726" class="aritcle_card_btn">

<span>查看详情</span>

<img src="/static/images/cardxiayige-3.png" alt="豆包大模型">

</a>

</div>

<h1>处理返回结果</h1><p>if response.status_code == 200:

result = response.json()

print("模型输出:", result["output"])

else:

print("请求失败,状态码:", response.status_code)

print("错误信息:", response.text)</code>以上就是豆包大模型1.6— 字节跳动推出的多模态深度思考模型的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号