最近,我们的一位读者问我们如何优化 robots.txt 文件以提高 seo。

robots.txt 文件告诉搜索引擎如何抓取您的网站,这使其成为一个非常强大的 SEO 工具。

在本文中,我们将向您展示一些有关如何为 SEO 创建完美 robots.txt 文件的提示。

Robots.txt 是网站所有者可以创建的文本文件,用于告诉搜索引擎机器人如何抓取其网站上的页面并为其建立索引。

它通常存储在网站的根目录(也称为主文件夹)中。robots.txt 文件的基本格式如下所示:

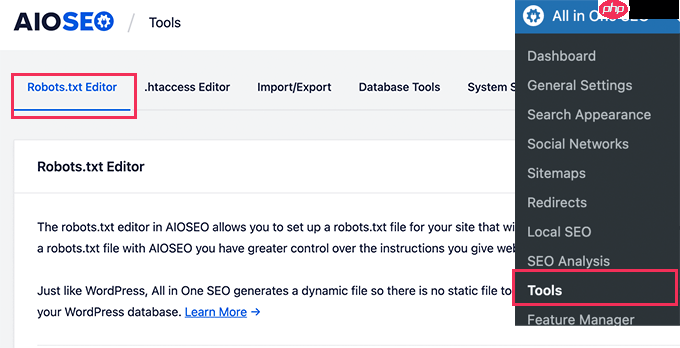

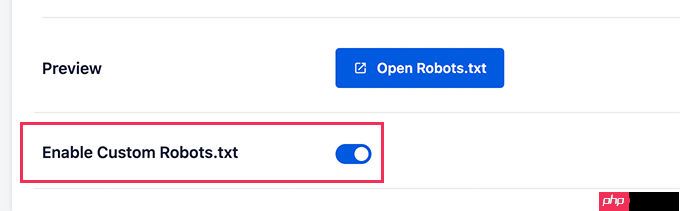

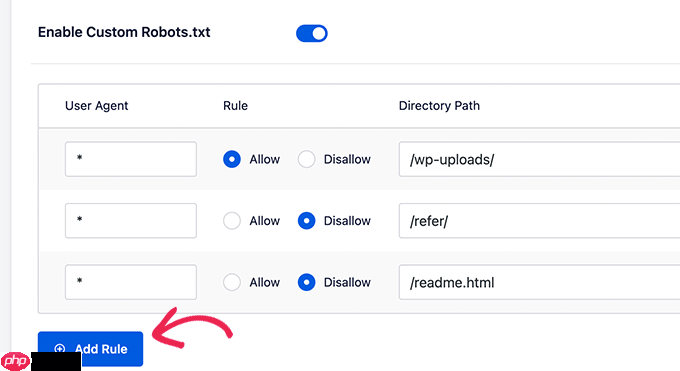

首先,您需要通过单击“启用自定义 Robots.txt”切换为蓝色来打开编辑选项。

启用此开关后,您可以在 WordPress 中创建自定义 robots.txt 文件。

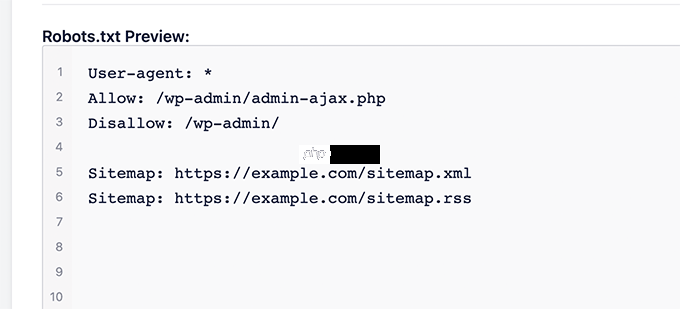

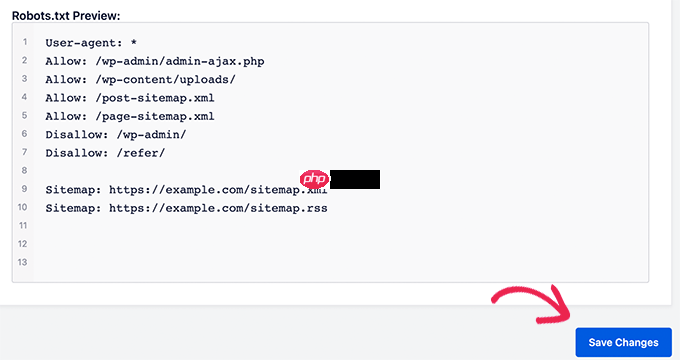

多合一 SEO 将在屏幕底部的“Robots.txt 预览”部分显示您现有的 robots.txt 文件。

此版本将显示 WordPress 添加的默认规则。

这些默认规则告诉搜索引擎不要抓取您的核心 WordPress 文件,允许机器人索引所有内容,并向它们提供指向您网站的 XML 站点地图的链接。

现在,您可以添加自己的自定义规则来改进 robots.txt 以进行 SEO。

要添加规则,请在“用户代理”字段中输入用户代理。使用 * 会将规则应用于所有用户代理。

然后,选择是否要“允许”或“禁止”搜索引擎抓取。

接下来,在“目录路径”字段中输入文件名或目录路径。

该规则将自动应用于您的 robots.txt。要添加其他规则,只需单击“添加规则”按钮。

我们建议添加规则,直到您创建我们上面分享的理想 robots.txt 格式。

您的自定义规则将如下所示。

完成后,不要忘记单击“保存更改”按钮来存储您的更改。

方法 2. 使用 FTP 手动编辑 Robots.txt 文件

HMCSS是由河马工作室全新开发的通用的企业网站系统,是PHP+MYSQL的架构,采用DIV+CSS的方式进行网页布局,网站的功能包括有:企业简介,图片展示幻灯,产品图片滚动,企业荣誉,实力展示,产品分类及展示,网上招聘,在线留言,联系我们,在线地图等内容,另外还带有完整的管理后台,如网站SEO优化关键词等都可以自由设定。 HMCSS目前发布的是1.0版本,就是上述的这些内容。后面我们还要加上产品

0

0

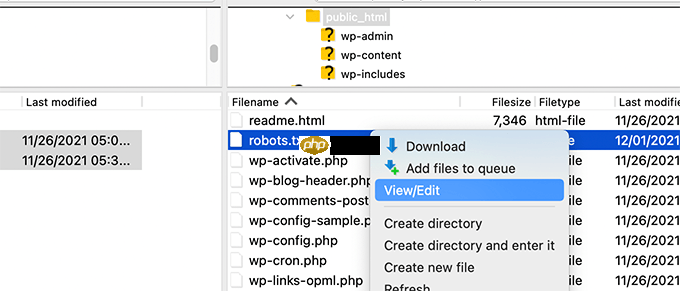

对于此方法,您需要使用 FTP 客户端来编辑 robots.txt 文件。

只需使用 FTP 客户端连接到您的WordPress 网站文件即可。

进入后,您将能够在网站的根文件夹中看到 robots.txt 文件。

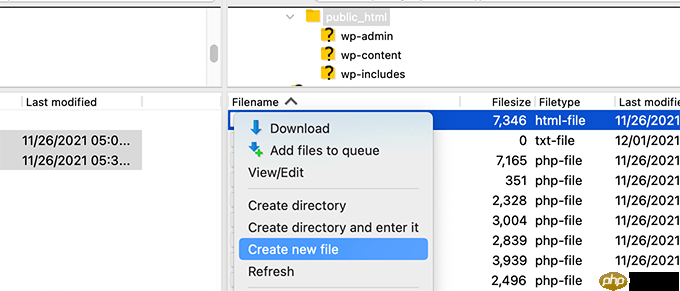

如果您没有看到,那么您可能没有 robots.txt 文件。

在这种情况下,您可以继续创建一个。

Robots.txt 是一个纯文本文件,这意味着您可以将其下载到计算机上并使用记事本或 TextEdit 等任何纯文本编辑器进行编辑。

保存更改后,您可以将 robots.txt 文件上传回网站的根文件夹。

创建 robots.txt 文件后,最好使用 robots.txt 测试工具对其进行测试。

有许多 robots.txt 测试工具,但我们建议使用Google Search Console中的工具。

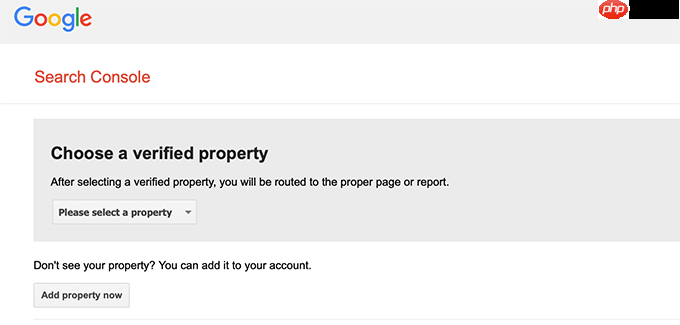

首先,您需要将您的网站与 Google Search Console 链接。如果您尚未执行此操作,请参阅我们有关如何将 WordPress 网站添加到 Google Search Console 的指南。

然后,您可以使用Google Search Console 机器人测试工具。

只需从下拉列表中选择您的房产即可。

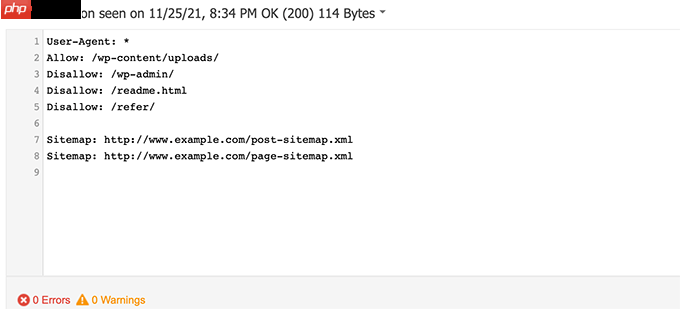

该工具将自动获取您网站的 robots.txt 文件,并突出显示错误和警告(如果发现)。

优化 robots.txt 文件的目的是防止搜索引擎抓取非公开的页面。例如,wp-plugins 文件夹中的页面或 WordPress 管理文件夹中的页面。

SEO 专家的一个常见误区是,阻止 WordPress 类别、标签和存档页面将提高抓取速度,并导致更快的索引和更高的排名。

这不是真的。这也违反了谷歌的网站管理员指南。

我们建议您按照上述 robots.txt 格式为您的网站创建 robots.txt 文件。

我们希望本文能帮助您了解如何优化 WordPress robots.txt 文件以实现 SEO。您可能还想查看我们的终极 WordPress SEO 指南以及我们的专家精选的最佳 WordPress SEO 工具来发展您的网站。

以上就是如何优化 WordPress Robots.txt 以进行 SEO的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号