前言

近期mcp的火爆是大家有目共睹的,关注人工智能前沿开发的开发者或多或少都有阅读过mcp相关文章或者视频,也不乏有像本人一样动手亲自来实践,开发本地mcp服务或者实现一系列相关llm+mcp应用(如本人曾实践过llm+mcp论文查找服务)。随着实操体验热度过去之后,结合本人人工智能应用开发与落地实践经验思考,不禁提出思考“大模型时代,mcp是必需品还是过渡方案?”这个问题。mcp 究竟是适配特定场景的刚需,还是因技术路径局限而需要迭代的过渡方案?故作下此篇文章,列出本人对于mcp看法和观点,一同探讨思考mcp开发与应用现状。

我是Fanstuck,致力于将复杂的技术知识以易懂的方式传递给读者,每一篇文章都凝聚着我对技术的深刻洞察。从人工智能的基础理论到前沿研究成果,从热门框架的深度解析到实战项目的详细拆解,内容丰富多样。无论是初学者想要入门,还是资深开发者追求进阶,都能在这里找到契合自身需求的知识养分。如果你对大模型的创新应用、AI技术发展以及实际落地实践感兴趣,那么请关注Fanstuck。

一、MCP 在 人工智能时代的困局与认知错位☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

我之所以会提出 “LLM 时代,MCP 是必需品还是过渡方案” 的反思,本质上源于技术落地过程中暴露的多重矛盾与行业实践的现实困境。

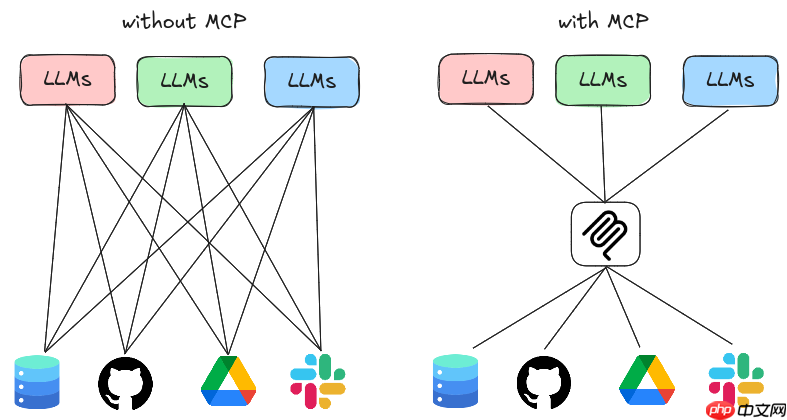

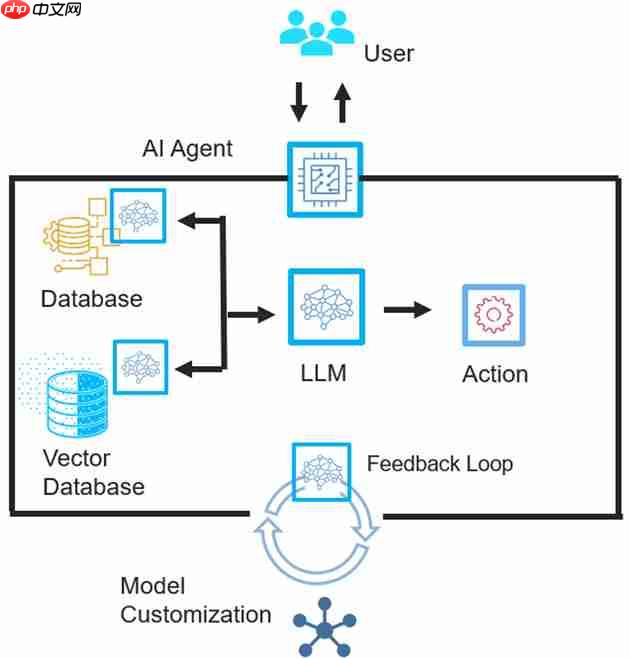

从技术基因来看,MCP 脱胎于 Anthropic 为本地客户端(如 Claude Desktop)设计的工具调用协议,这种 “客户端优先” 的出身使其在解决本地 AI 助手与外部工具的碎片化连接问题时展现出天然优势 —— 比如 Cursor 等应用通过 MCP 实现动态工具扩展,让桌面端 Agent 获得了 “无限工具箱” 的能力。但这种基因也埋下了隐患:当技术向服务端和云端场景延伸时,早期双连接模型(SSE 长链接 + HTTP 短链接)在高并发多服务器架构中暴露出跨机器寻址的复杂性,无状态云端服务中临时创建 SSE 链接的低效性,以及动态工具发现功能在预设工具集主导的云端场景中 “水土不服” 的尴尬。这种 “本地适用 - 云端受限” 的技术割裂,迫使行业思考:MCP 究竟是适配特定场景的刚需,还是因技术路径局限而需要迭代的过渡方案?

二、从实际场景看MCP的适用边界与技术瓶颈

在明确了MCP在人工智能生态中的困境与认知错位之后,我们进一步从具体业务场景和实际案例入手,客观地分析MCP究竟在哪些场景下真正体现出优势,又在哪些情况下表现出明显的不足。

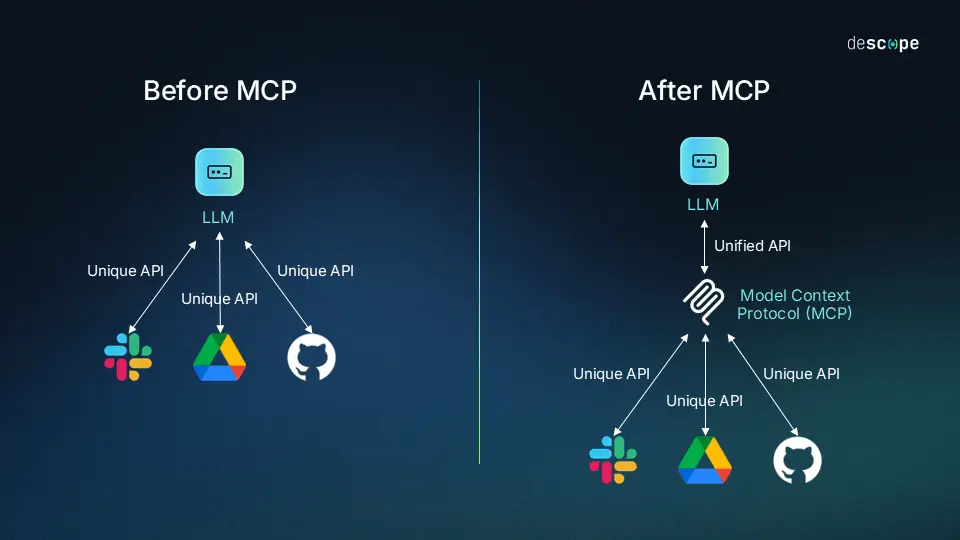

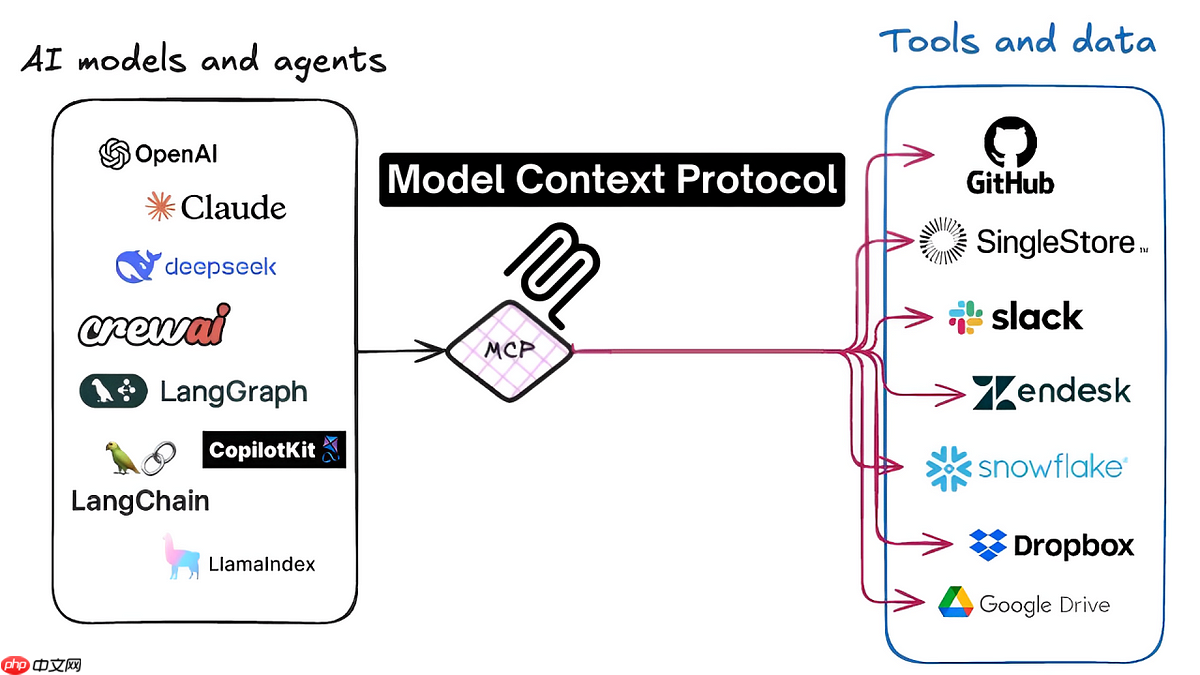

(1)MCP真正解决的问题在桌面端或本地Agent工具集动态加载的场景中,MCP展现出了显著的优势。比如Cursor,这款本地IDE智能助手,通过MCP实现了动态加载不同类型的工具插件,如代码搜索、文档查询以及代码生成等。用户在开发过程中无需手动安装和配置繁杂的插件,或不断切换不同的应用界面,只需要通过一个统一的MCP协议接口便能灵活且高效地实现各种工具的加载。这种标准化通信协议类似于通用的USB接口,不仅大大减少了开发者为每个新工具设计专门适配接口的工作量,而且利用MCP内置的SSE长链接机制,可以有效降低工具调用延迟,使得实时交互体验更加流畅。同时,MCP协议中的动态工具发现功能,使得本地Agent拥有了近乎无限的扩展性与自定义空间,这是其他现有方案难以比拟的。

短链路单服务器简单环境也是MCP表现突出的典型场景之一。例如,在我本人过去的开发实践中,曾基于MCP快速搭建了一个本地论文检索和摘要生成服务。在该服务的构建过程中,MCP极大地降低了单一数据源工具(如论文数据库)的接入难度,开发者仅需进行简单的配置,就能够实现高效且稳定的工具调用。得益于MCP标准化的配置,开发者能够快速地实现与论文数据库、搜索引擎等数据源的连接,同时还显著降低了接口维护的成本。由于在短链接单服务器模式下,MCP协议运行稳定,几乎没有明显的性能瓶颈。

(2)MCP表现明显不足的场景然而,在大规模、分布式、高并发的环境中,MCP协议却暴露出明显的不足。例如,在云端知识库问答服务的实际应用中,企业通常采用分布式部署和负载均衡方案,以应对大量的并发请求。然而,在这种场景下,MCP的设计所采用的双连接模型(长链接SSE + 短链接HTTP)却成为了明显的性能瓶颈。大量请求同时涌入时,MCP服务器不得不同时维护大量的SSE长链接,导致资源消耗激增,严重降低了整体服务的响应速度。此外,当工具调用跨越多个服务器节点时,MCP的工具寻址逻辑也变得异常复杂和低效,这进一步降低了服务的效率。

此外,在实时性要求极高的应用场景,如在线实时风控决策平台中,MCP也无法满足严格的性能要求。以金融领域的实时反欺诈系统为例,这类系统通常需要毫秒级的极低延迟,因为每个额外的延迟都可能带来显著的资金损失风险。MCP协议中的SSE长链接类似于交通繁忙时的单车道公路,一旦请求密集或消息频繁时,就容易形成排队等待现象,造成延迟增大;而HTTP短链接则像频繁开设和关闭的临时道路,每次连接的建立和关闭都会额外增加等待时间,进一步加剧了延迟问题。

三、MCP的替代方案与竞品技术路径分析

为了更全面地理解MCP在人工智能技术栈中的位置,我们需要引入一些同类或替代技术方案,从横向维度来分析MCP的适用性。

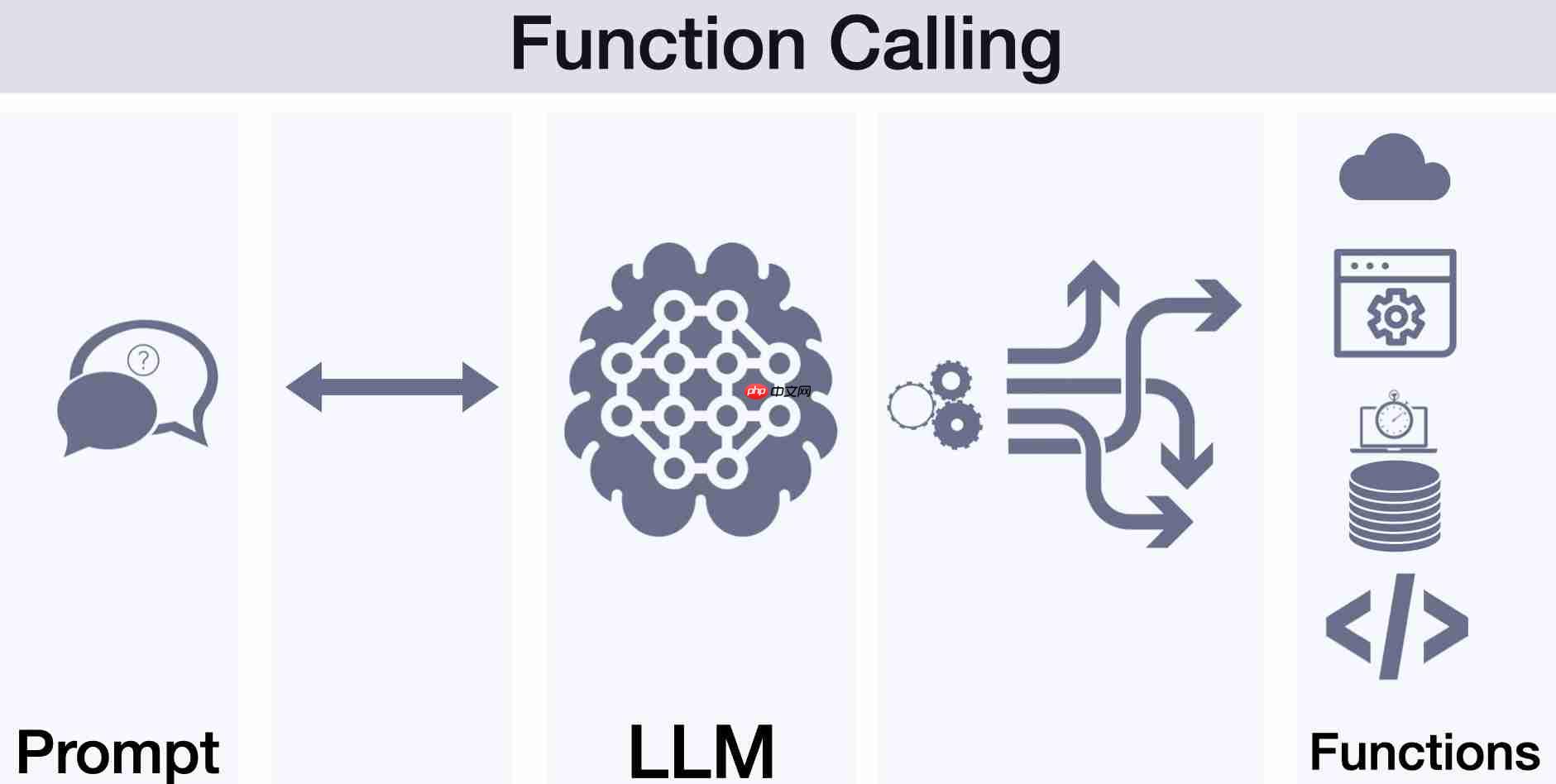

(1)函数调用 (Function Calling)

以OpenAI的Function Calling API为例,这种技术方案尤其适合简单API集成或标准化工具调用场景。它能高效地将明确的函数接口暴露给大模型,使模型能够快速精准地调用API或数据库查询服务。然而,相比MCP,函数调用的灵活性较弱,不支持动态工具加载,也不具备标准化的工具发现与连接能力。因此,在桌面端或动态插件加载场景下,函数调用无法完全替代MCP的功能。

(2)LangChain或Agentic编排框架

LangChain作为当前热门的Agentic编排框架,以高度的灵活性和强大的定制化能力著称。它能支持多样化的工具组合和自定义调用逻辑,非常适合复杂的业务逻辑处理场景。然而,这种灵活性也带来了较高的复杂性和开发成本。相较而言,MCP的标准化程度更高,开发者更容易快速上手,但在复杂定制场景中的适配性则明显不及LangChain。

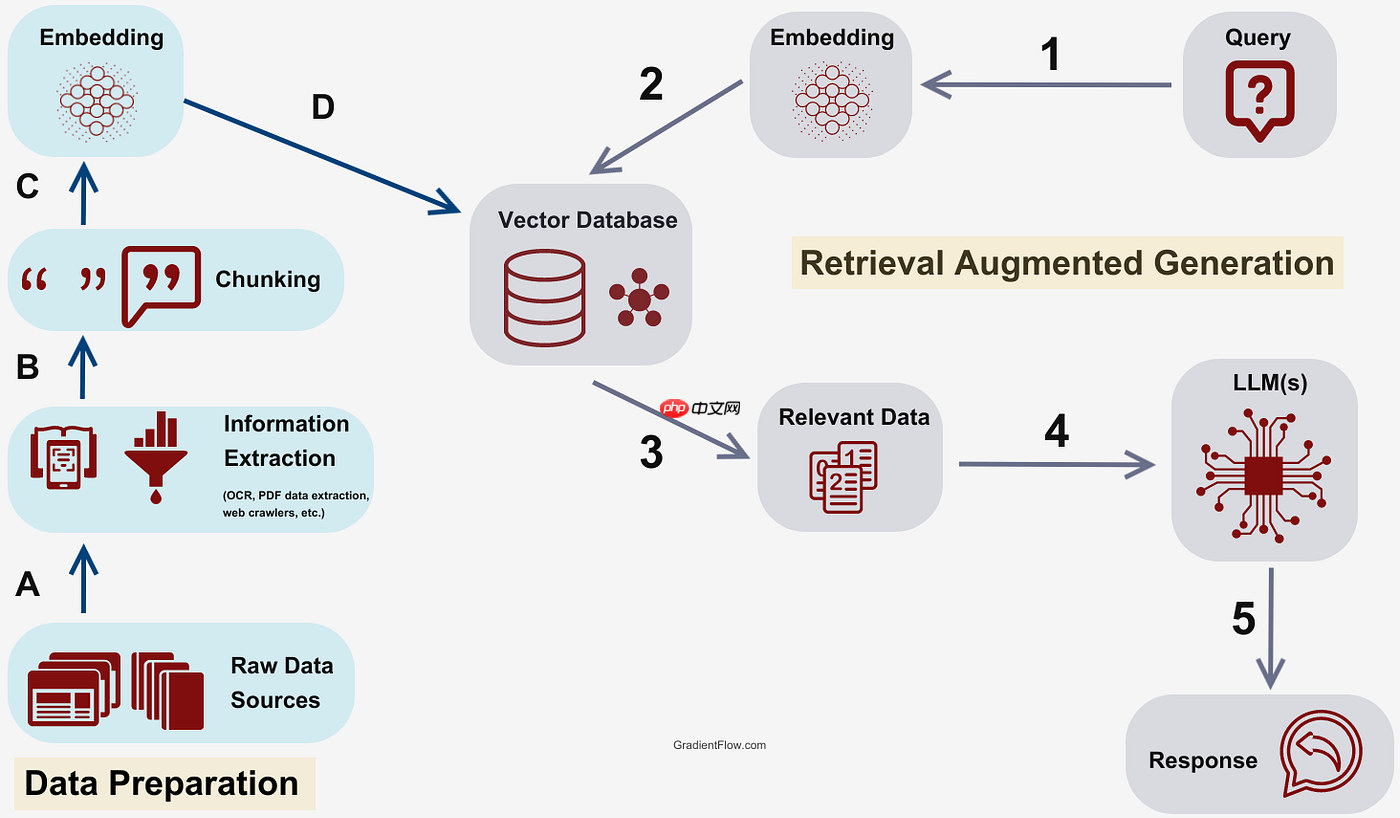

(3)RAG (检索增强生成)

RAG技术路线适用于知识库检索和信息增强生成场景,通过实时检索外部知识库增强生成内容的准确性。在企业知识库搜索优化场景中,RAG表现明显优于MCP,因为它专注于内容检索与增强生成。然而,在工具动态加载和实时交互的开发环境中,MCP仍然具有独特优势。因此,开发者应根据具体业务需求明确选择适用技术。

综合对比来看,MCP更适用于本地化、动态工具加载环境,而函数调用、LangChain和RAG各自在不同应用场景中具有明显的优势,应根据业务需求进行合理的选择和技术路线规划。

四、深入思考:MCP未来可能的进化路径面对当前MCP协议在性能和适用场景方面的瓶颈,我们有必要深入探讨其未来可能的进化方向。

MCP协议自身的优化可能首先是协议性能的优化,例如考虑采用更高效的传输协议如gRPC替代传统的SSE,从而大幅度提升通信性能并降低延迟。此外,MCP动态工具发现机制的进一步完善,如引入工具的评价排名系统和健康状态实时监测机制,能够极大提升工具选择的效率与可靠性。同时,协议层面上生态治理的引入,如建立统一的MCP工具市场和工具审查机制,可以有效解决当前工具生态混乱的问题,提升整体工具质量。

与其他技术路径的融合可能其次,MCP未来也可能与Function Calling、RAG等技术深度融合,形成新型的混合技术架构。这种融合方案不仅保留了MCP在动态加载和标准化工具接口的优势,还能够有效借鉴函数调用的高效性和RAG技术在内容检索增强方面的优势。

综上所述,我们预测MCP未来将在人工智能应用开发生态中扮演多重角色,既可能作为核心基础设施长期存在,也可能成为特定工具型场景下的过渡性解决方案。未来的发展将取决于协议自身优化的速度与与其他技术路线融合的程度。

五、结论:回归理性,如何看待和选择MCP?通过上述的详细分析与探讨,我们可以清晰地认识到MCP并非所有场景的“万能药”,但也绝不必然是一种短暂的“过渡技术”。技术本身并无绝对优劣之分,其价值和适用性关键在于具体的业务需求与场景特征。

开发者在进行技术选型时,应明确根据具体的业务场景来划定MCP的使用边界。在桌面端、本地开发工具集或单服务器简单应用环境中,MCP通常是最佳选择,它能提供快速的开发效率和优秀的扩展性;而在大规模云端服务、高并发实时场景下,则需谨慎评估性能和效率瓶颈,选择更为适合的高性能方案。

综上,我们建议开发者从实际需求出发,结合场景特点合理选择MCP的适用与否,以确保技术选型的精准性和落地的有效性,从而推动人工智能应用更高效、更务实地走向成功。

以上就是技术反思:LLM时代,MCP是必需品还是过渡方案?的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号