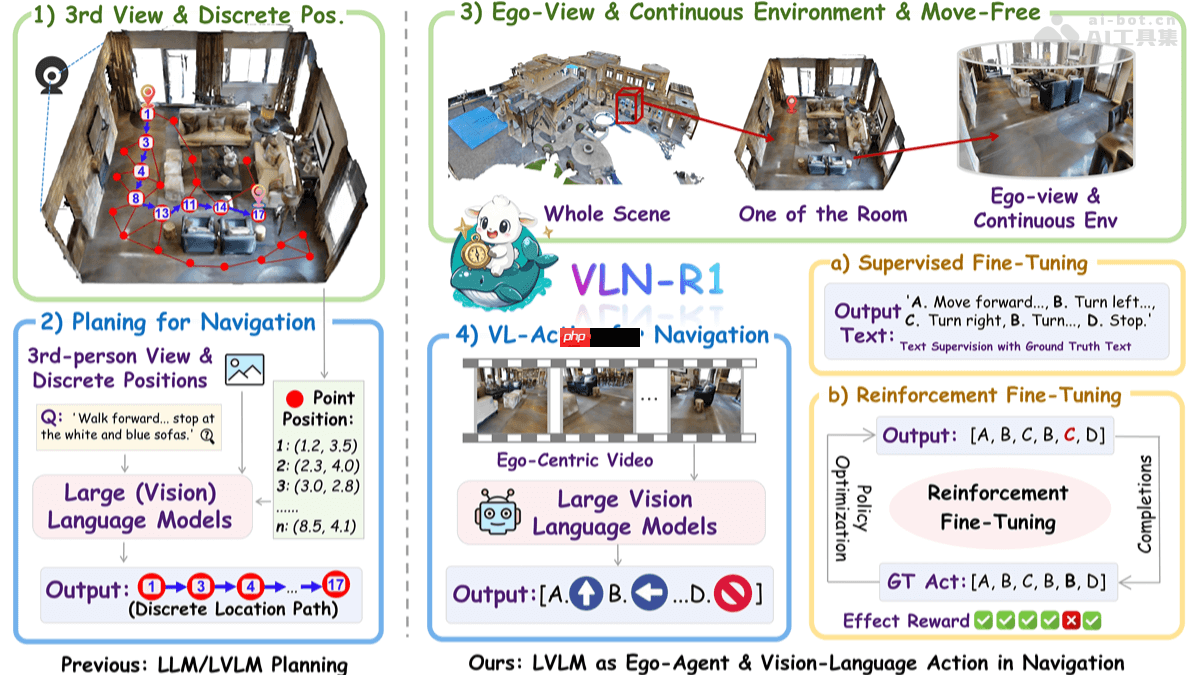

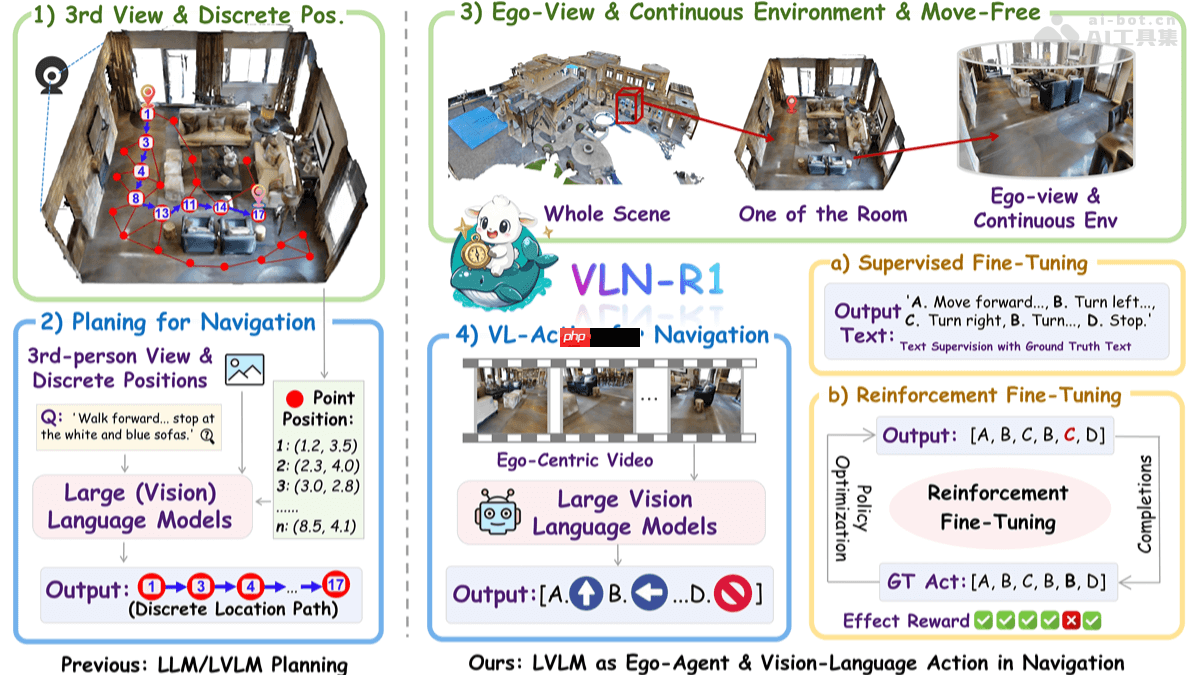

VLN-R1是什么

vln-r1是由香港大学与上海人工智能实验室共同研发的新型具身智能框架,利用大型视觉语言模型(lvlm),将第一人称视角的视频流直接转化为连续的导航动作。该框架依托habitat 3d模拟器构建了vln-ego数据集,并采用长短期记忆采样策略,平衡历史信息和当前观测内容。训练过程分为两个阶段:监督微调(sft)使模型的动作序列文本预测与专家示范保持一致;强化微调(rft)则基于时间衰减奖励(tdr)机制优化未来多步动作的表现。在vln-ce基准测试中,vln-r1展现出卓越性能,验证了lvlm在具身导航中的有效性,同时提升了任务特定推理能力并具备高数据效率。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

VLN-R1的主要功能

-

连续环境导航:可直接处理第一人称视角视频流,使智能体能够在连续的3D环境中自由移动,而不仅限于固定节点。

-

动作生成:能够输出四种基本指令(前进、左转、右转、停止),实现对导航行为的精准控制。

-

数据高效训练:通过监督微调(SFT)与强化微调(RFT)相结合的方式,在有限的数据量下完成高效的模型训练,显著提升导航表现。

-

跨领域适应:借助强化微调(RFT),模型可以在仅有少量新数据的情况下快速适应新的导航任务和环境。

-

任务特定推理:引入时间衰减奖励(TDR)机制,优化对未来多步动作的预测,从而增强长期导航的稳定性与准确性。

VLN-R1的技术原理

-

数据集构建:VLN-Ego数据集由Habitat 3D模拟器生成,包含第一人称视频流及其对应的未来动作预测,为模型提供丰富的训练素材。

-

长短期记忆采样:在处理视频输入时,采用长短期记忆采样策略,动态调节历史帧与实时输入的重要性,确保模型既关注短期变化,又保留长期上下文。

-

监督微调(SFT):通过最小化模型预测文本与专家示范之间的交叉熵损失,使模型的动作序列预测更加贴近真实操作,提高其对语言指令的理解能力。

-

强化微调(RFT):采用组相对策略优化(GRPO)方法,结合时间衰减奖励(TDR)机制评估和优化未来多步动作的预测效果,进一步提升模型在复杂任务中的表现。

-

大型视觉语言模型(LVLM):依托先进的LVLM(例如Qwen2-VL)处理视觉与语言输入,实现从第一视角视频到导航指令的端到端映射,提升整体系统的泛化能力与适应性。

VLN-R1的项目地址

VLN-R1的应用场景

-

家庭服务机器人:支持家庭机器人根据用户自然语言指令自主导航,执行清洁、取物等任务,提升居家便利程度。

-

工业自动化:协助工厂车间机器人依据人工指令灵活移动,完成物料运输和设备维护,提升生产效率。

-

智能仓储:让仓储机器人根据指令在货架间精准定位并完成货物存取,提高仓储管理效率。

-

医疗保健:应用于医院或养老院场景,使机器人能按医护人员或患者指令进行导航,完成送药、送餐等工作,减轻人力负担。

-

智能交通:帮助自动驾驶车辆在复杂城市道路中依据信号和指令进行导航,提升行驶安全性和灵活性。

以上就是VLN-R1— 港大联合上海AI lab推出的具身智能框架的详细内容,更多请关注php中文网其它相关文章!

VLN-R1的主要功能

VLN-R1的主要功能