机器之心编辑部

熟悉开源社区的朋友对 vLLM 应该不会陌生。它是由加州大学伯克利分校团队打造的高性能、开源 LLM 推理和服务引擎,主要目标是提升大语言模型(LLM)的推理速度(吞吐量)和资源利用率(尤其是内存),并且兼容 Hugging Face 等主流模型库。

简而言之,vLLM 可以让 GPT、Mistral、LLaMA 等主流模型系列运行得更快且占用更少资源,而实现这一效果的核心技术就是其创新性的注意力机制方案——PagedAttention。

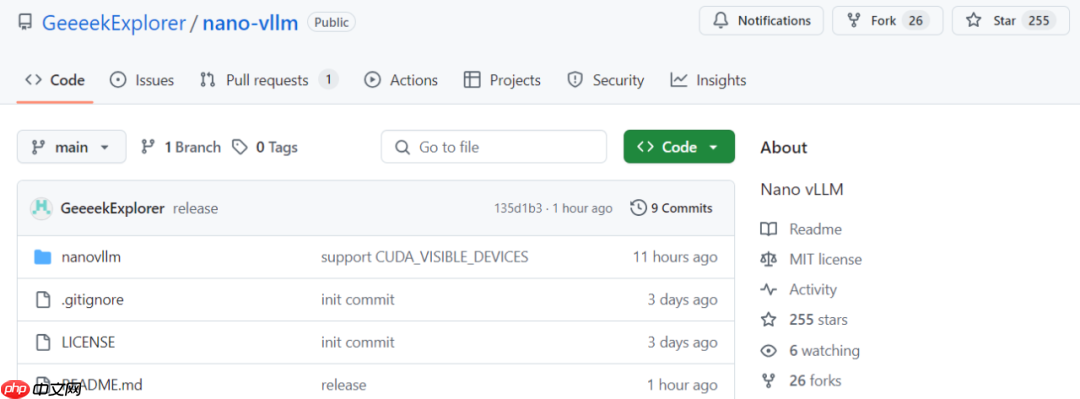

近日,来自 DeepSeek 的 AI 研究员、深度学习系统工程师俞星凯从零开始构建了一个极简版本的 vLLM 实现——Nano-vLLM,将整个项目代码压缩到了仅 1200 行以内。

目前该项目已在 GitHub 上获得超过 200 颗 Star。

图片GitHub 地址:https://www.php.cn/link/b3f2a6b3e119aaa5a1326802e7b49403

图片GitHub 地址:https://www.php.cn/link/b3f2a6b3e119aaa5a1326802e7b49403

具体来看,Nano-vLLM 具备以下三大核心特点:

第一,具备高效的离线推理能力,推理速度与原版 vLLM 相当。

第二,代码结构简洁易读,Python 总行数控制在了 1200 行以内。

第三,集成了多项优化工具,如 Prefix 缓存、Torch 编译以及 CUDA 计算图等特性。

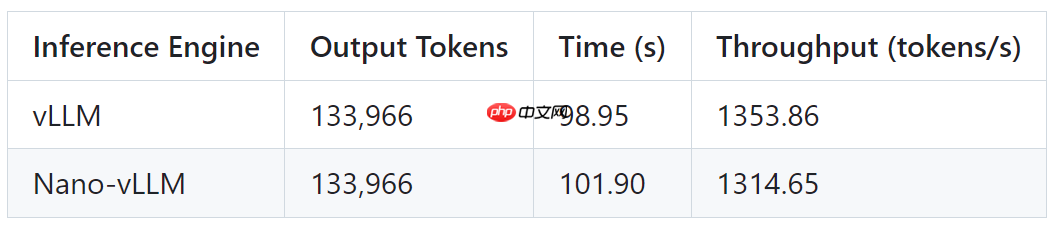

俞星凯在进行基准测试时使用了如下配置:

硬件:RTX 4070模型:Qwen3-0.6B总请求数:256 个序列输入长度:100–1024 tokens 范围内随机输出长度:100–1024 tokens 范围内随机测试结果如下表所示,Nano-vLLM 与 vLLM 输出 token 完全一致,响应时间略高,推理速度(吞吐量)稍有差距,但整体表现非常接近。

图片开发者简介

图片开发者简介

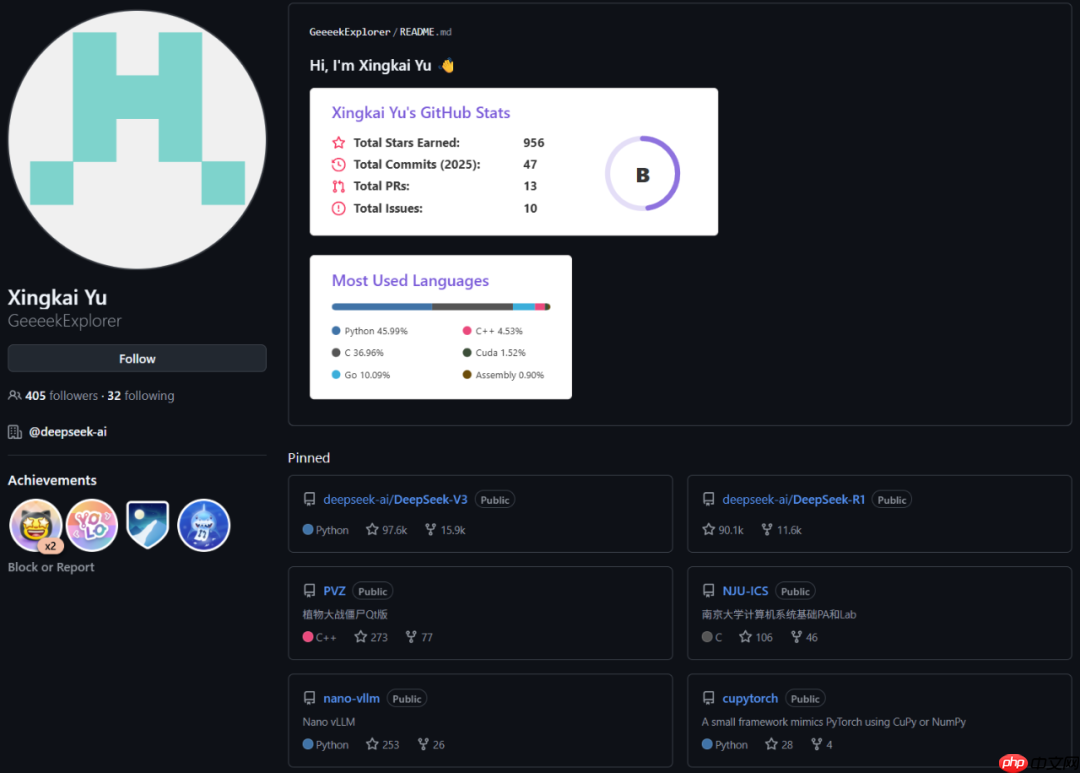

Nano-vLLM 的作者俞星凯目前任职于 DeepSeek,曾参与 DeepSeek-V3 和 DeepSeek-R1 的研发工作。

图片值得一提的是,根据其 GitHub 主页显示,他还开发过一个植物大战僵尸 Qt 版本,该项目也已获得 270 多颗 Star。此外,由于本科就读于南京大学,他还参与了不少南大的计算机相关项目,包括南京大学计算机图形学绘图系统、南京大学分布式系统 Raft 算法最简实现、南京大学操作系统 OSLab 等。

图片值得一提的是,根据其 GitHub 主页显示,他还开发过一个植物大战僵尸 Qt 版本,该项目也已获得 270 多颗 Star。此外,由于本科就读于南京大学,他还参与了不少南大的计算机相关项目,包括南京大学计算机图形学绘图系统、南京大学分布式系统 Raft 算法最简实现、南京大学操作系统 OSLab 等。

根据其 LinkedIn 页面信息显示,他曾先后在腾讯、幻方(DeepSeek 母公司)和字节跳动实习,并于 2023 年正式加入 DeepSeek 成为一名深度学习系统工程师。

图片你是 vLLM 用户吗?你会考虑尝试 Nano-vLLM 吗?

图片你是 vLLM 用户吗?你会考虑尝试 Nano-vLLM 吗?

© THE END

转载请联系本公众号获取授权