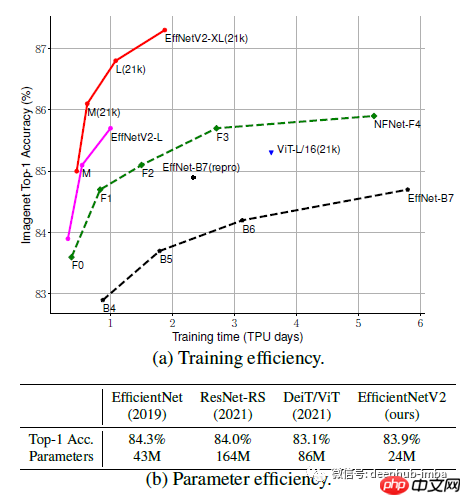

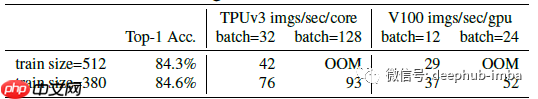

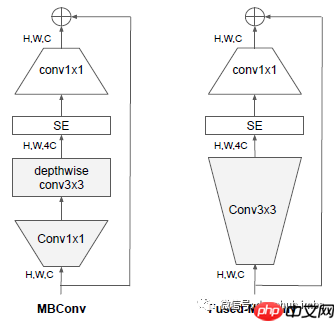

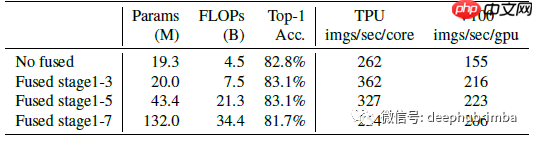

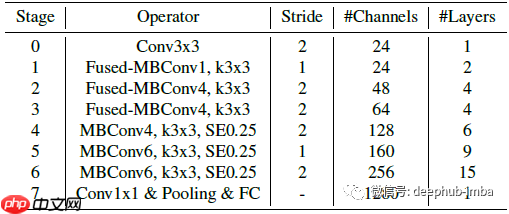

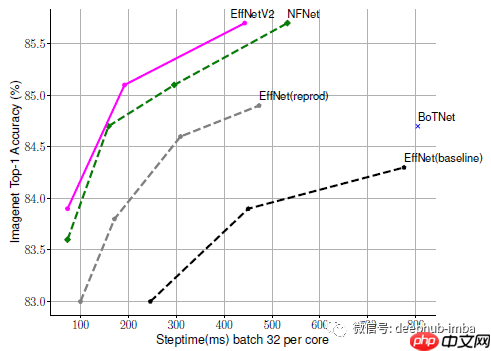

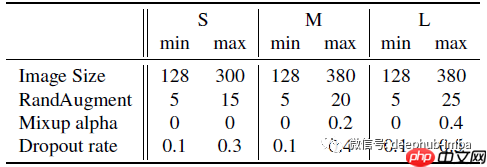

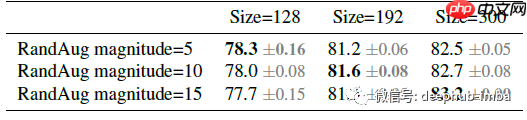

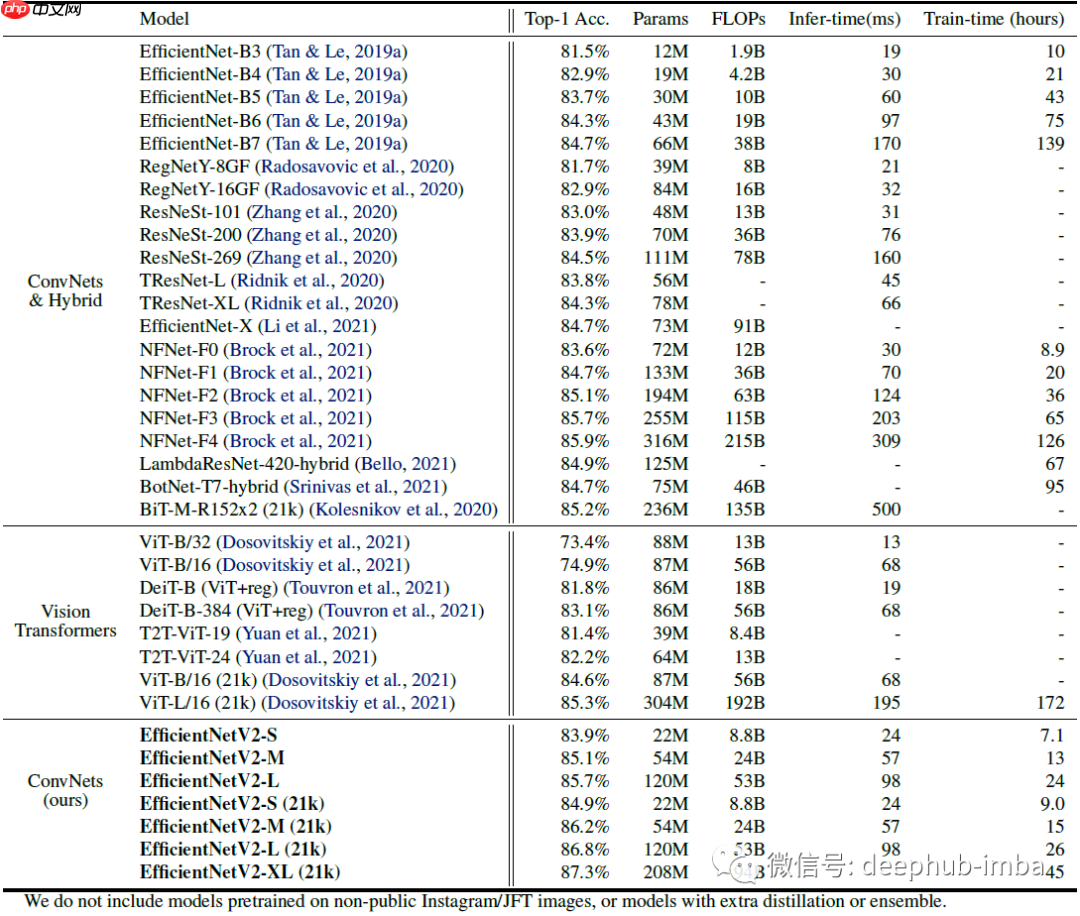

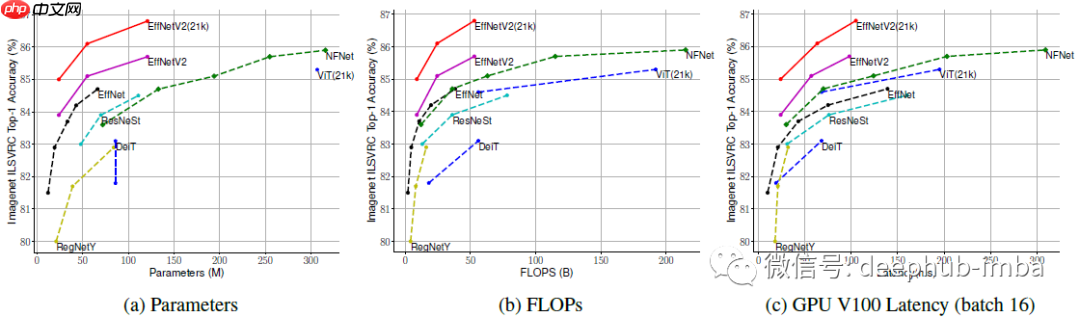

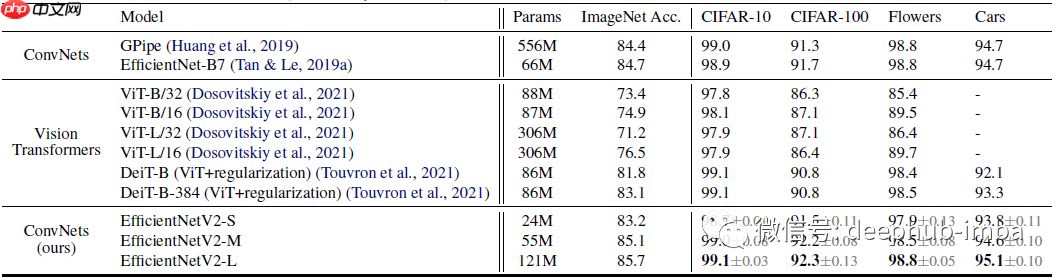

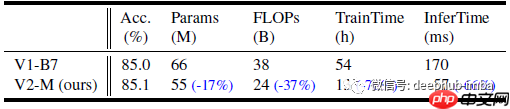

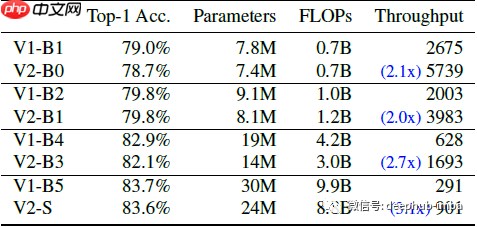

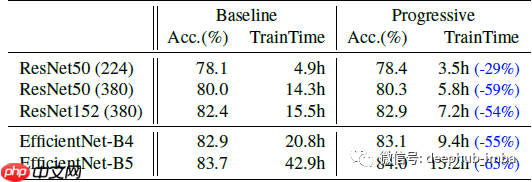

efficientnetv2 是由 google research 的 brain team 在 2021 年 icml 会议上发布的一篇论文。该论文通过神经架构搜索(nas)和缩放技术,优化了训练速度和参数效率。模型中引入的新操作,如 fused-mbconv,进一步提升了搜索空间的效率。efficientnetv2 模型的训练速度比 efficientnetv1 快得多,同时模型大小缩小了 6.8 倍。

论文大纲如下:

引用[2021 ICML] [EfficientNetV2]EfficientNetV2: Smaller Models and Faster Training

https://www.php.cn/link/9dc69f4a9d78d28dc1ba5697a159c546

以上就是论文推荐:EfficientNetV2 - 通过NAS、Scaling和Fused-MBConv获得更小的模型和更快的训练的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号