☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

在中国,一个AI大模型要完成从训练到推理的全过程,几乎如同经历一场算力的“九九八十一难”。

首先,它必须面对英伟达高端算力芯片被禁售、被降级的现实困境,导致算力获取成本高昂且渠道受限;紧接着,模型参数日益庞大,单张计算卡已无法承载,必须依赖大规模集群算力;而大规模AI集群又常面临故障频发、恢复缓慢的问题,严重拖慢训练进度;到了推理阶段,还需突破分布式推理的技术瓶颈,才能在应用层面建立竞争优势。

这些大模型宛如棋盘上的棋子,算法走得飞快,脚下的算力棋盘却始终依赖他人。即便如此,中国依然诞生了众多令人瞩目的大模型创新成果。但人们不禁思考:如果拥有一个自主可控、稳定强劲的AI算力底座,中国的AI技术又能走得多远?

在HDC 2025大会上,答案浮现。华为常务董事、华为云计算CEO张平安宣布:基于CloudMatrix384超节点的新一代昇腾AI云服务正式全面上线,为大模型提供澎湃动力。

这项服务的本质,是对传统AI算力形态的一次重构。它打破了以单卡为核心的算力供给模式,直面中国AI算力自主化的迫切需求,并通过云服务这一最适配大模型推训的方式,实现了算力的高效交付。

384个AI计算单元紧密互联,宛如一片“龙鳞”。从这片鳞甲的光泽中,我们看到的是中国AI算力以技术重塑规则的决心与能力。

让我们沿着“发现问题—技术破局—云服务闭环—行业落地”的逻辑脉络,看看AI算力的重重难关,是如何被一一化解的。

自深度学习兴起以来,AI算力作为专项资源被广泛认知,学界与产业界早已预见到中国将在AI算力供需之间面临巨大矛盾。这一矛盾在大模型时代达到了前所未有的高峰。

一方面,中国在算法与应用场景上的创新层出不穷,AI正深度融入社会经济;另一方面,本土AI算力基础设施长期缺失,严重依赖外部供应。这种依赖逐渐演变为发展的结构性短板——就像把自己的棋子放在别人的棋盘上,一旦对方撤盘,我们便无从落子;当棋子越来越多,原有的棋盘也早已不堪承载。

从历史、当下与未来三个维度审视,中国AI算力必须走出一条自主发展的新路径。

自1996年《瓦森纳协定》签署以来,美国长期主导对华高科技出口管制。进入AI时代,AI算力成为科技博弈的核心战场。近年来,美国不断加码对中国AI芯片的限制,曾占据中国市场95%以上份额的英伟达GPU,频繁遭遇禁售或被迫推出性能缩水的“特供版”。算力变得既昂贵又稀缺,成为制约中国AI发展的关键瓶颈。

聚焦国内市场,算力供需矛盾愈发尖锐。以DeepSeek为代表的国产大模型崛起,以及AI Agent等新型应用的爆发,都对训练与推理能力提出了更高要求。

例如,AI Agent的核心逻辑是“大模型决策+调用工具执行”,这对响应时延极为敏感。要实现大规模商用,必须具备强大的CPU与NPU间高速通信能力。这些底层算力的实现,直接决定了AI应用的成败。

更深远的是,大模型仍在快速进化。未来可能出现参数量达百万亿级别的模型,算力需求或将呈百万倍增长。同时,自动驾驶、元宇宙等新兴领域推动多元融合计算成为主流。我们必须提前构建强大的算力底座,才能支撑起未来无限的AI想象。

要破解这些困局,关键在于:不能再依赖外部供应的单卡算力。唯有将算力资源系统化、集群化整合,用整体优势弥补个体短板,才是中国AI算力的破局之道。

尽管技术难度极高,但我们也早已做好准备。华为在网络领域的深厚积累,可突破大规模集群通信瓶颈;昇腾芯片的持续迭代,为自主算力提供支撑;华为云在大规模算力服务与下一代云基础设施上的经验,为超节点的构建奠定了坚实基础。

这些能力的融合,使华为得以打破传统冯诺依曼架构,打造出“一切可池化”“一切皆对等”“一切可组合”的CloudMatrix384超节点,并通过云服务将其推向千行百业。

AI算力的多重困境,由此迎来了底层规则的重构可能。

要突破单卡算力的局限,就必须走向多卡集群化发展。

集约化计算提升资源利用率,构建更适应大规模训练的超节点,这一思路早有共识。但CloudMatrix384的独特之处在于,它通过计算、存储、网络等多维度协同创新,彻底颠覆传统架构,打造出真正的“最强AI服务器”。

CloudMatrix384将384颗昇腾NPU与192颗鲲鹏CPU通过高速互联总线连接,构成一台384卡的超级AI计算机。中国文化崇尚“合”的智慧,这种理念在CloudMatrix384中得以充分体现。通过集约化设计,它突破了硬件与工艺的限制,结合软硬协同、资源池化与动态调度,显著提升有效算力。数据显示,其算力规模可达300PFlops,相较英伟达NVL72提升67%。它的出现,从底层解决了多个紧迫的算力难题:

DeepSeek爆火后,MoE(混合专家)模型成为主流。这类模型对分布式推理能力要求极高。CloudMatrix384通过超节点分布式推理引擎,大幅提升单卡计算与通信效率,单卡吞吐量可达2300Tokens/s,较非超节点提升近4倍,支持“一卡一任务”,算力利用率(MFU)提升50%以上。更可实现“一卡一专家”,单个超节点支持384个专家并行推理,极大提升效率。

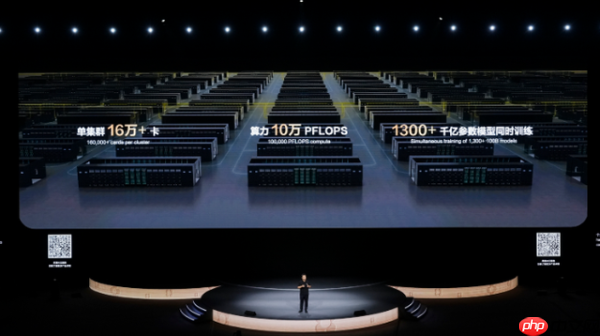

随着模型规模扩大,业界正从万卡集群向五万、十万卡演进。满足算力规模需求,是超节点的首要任务。

为此,CloudMatrix384采用MatrixLink全对等互联技术,构建高速智能网络,配合集群智能调度,确保性能无损,万卡集群线性度超95%。最高可级联432个超节点,形成16万卡规模的AI集群,提供10万PFlops算力,足以支撑万亿参数模型训练,彻底打破大规模计算的边界。

对开发者和企业用户而言,算力不仅稀缺,还常伴随浪费、低效与运维复杂等问题。为最大化每比特算力价值,CloudMatrix384支持按逻辑超节点灵活划分资源,像搭积木一样分配算力,实现“一切可组合”,让资源投入发挥最大效益。

此外,超节点支持40天长稳训练、10分钟快速恢复,彻底扫清大模型训练中的卡点与堵点。

正如张平安所言:“CloudMatrix384标志着算力竞争从单点突破迈向系统架构创新。通过技术与资源的深度融合,匹配全面智能时代的企业需求,引领中国AI生态的整体跃迁。”

技术突破之后,关键在于将能力释放到产业中。而云服务,正是最佳载体。

CloudMatrix384的技术本质,是打破单点算力限制,实现弹性、可扩展的大规模算力供给,这与云计算的特性高度契合。企业上云,正是为了灵活

以上就是从新一代昇腾AI云服务,俯瞰AI算力的云上变局的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号