DreamVVT是什么

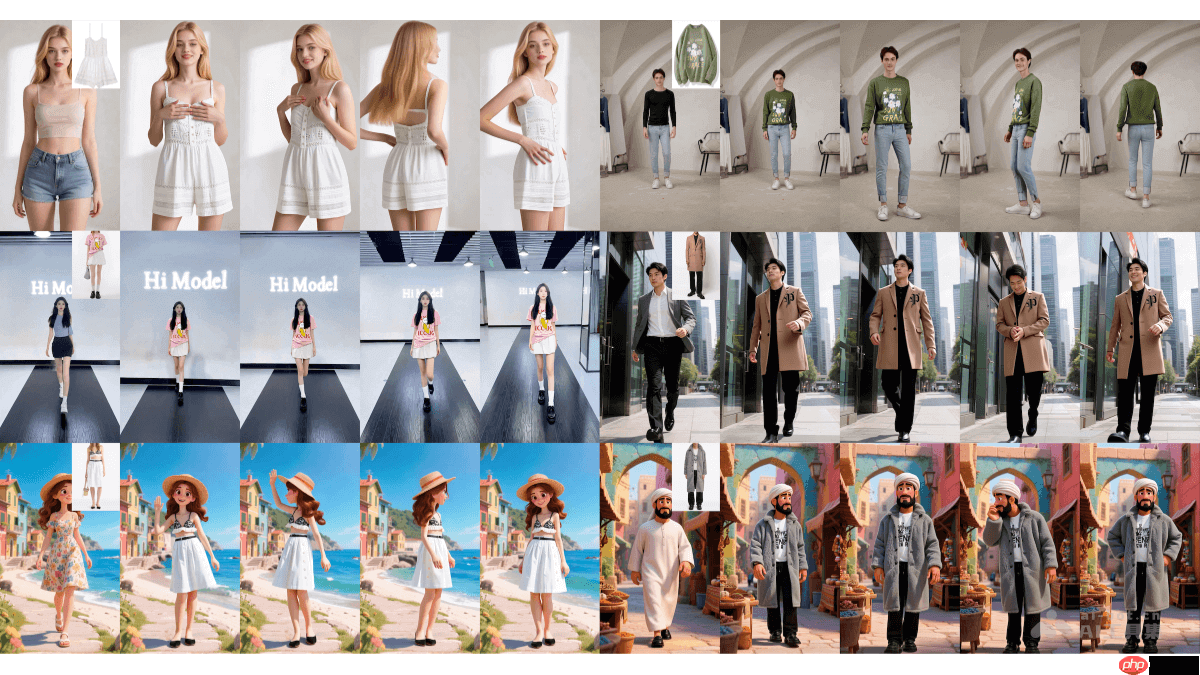

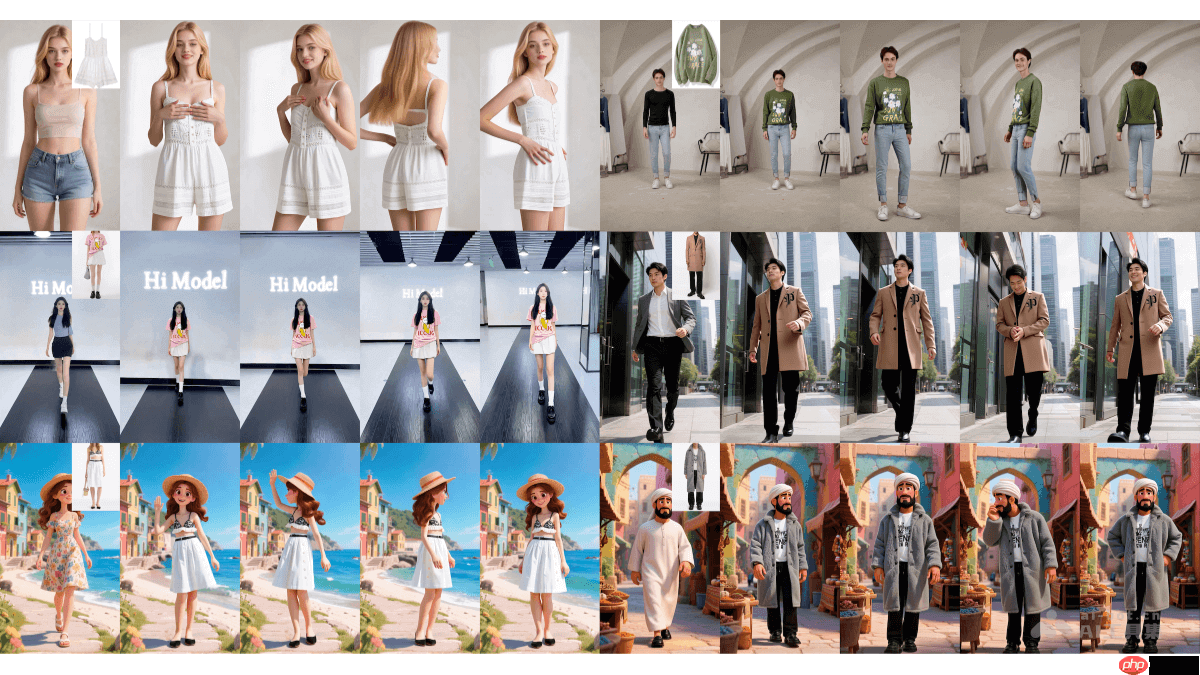

dreamvvt 是由字节跳动与清华大学(深圳)联合研发的一项视频虚拟试穿技术(video virtual try-on, vvt),基于扩散 transformer(dits)架构,采用创新的两阶段策略,实现高质量、时间连续的虚拟试穿效果。第一阶段从原始视频中提取关键帧,并结合视觉语言模型(vlm)生成语义准确、细节丰富的试穿图像;第二阶段则利用人体骨骼信息和运动轨迹,借助预训练的视频生成模型,确保输出视频在动态过程中的自然流畅。该技术能够在复杂动作和多样化场景下精准还原服装纹理与形态,甚至可为卡通角色“穿上”现实世界的服饰。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

DreamVVT的主要功能

-

高保真度呈现:在视频序列中实现精细的服装试穿效果,完整保留布料纹理、图案及细节,即使在剧烈运动或复杂姿态下仍保持视觉质量。

-

时间一致性保障:通过分阶段处理机制确保帧间连贯性,避免画面跳跃或闪烁,生成自然流畅的动态试穿视频。

-

广泛场景兼容:支持多种环境条件下的试穿,包括动态背景、复杂光照以及人物与其他物体的交互动作,适应性强。

-

非配对数据训练能力:可在无成对标注数据(即无人物穿某件衣服的真实图像)的情况下进行训练,显著降低数据需求,提升模型泛化性能。

-

整套穿搭模拟:不仅支持单件衣物替换,还能完成整套服装的协调搭配试穿,提供更贴近真实购物体验的解决方案。

-

跨域风格迁移:可将真实服装风格迁移到卡通或动画角色身上,拓展虚拟试穿在动漫、游戏等领域的应用边界。

-

动态物理表现:能够模拟服装随动作产生的自然摆动、褶皱变化等动态效果,增强试穿结果的真实感与沉浸感。

DreamVVT的技术原理

-

双阶段生成架构:采用“先静态后动态”的两步策略,第一阶段生成高质量的关键帧试穿图像,第二阶段基于这些图像合成完整视频。

-

扩散Transformer(DiTs)核心:以DiTs为生成骨干,融合视觉语言模型(VLM)引导生成过程,保证语义一致性和图像质量。

-

关键帧智能采样与生成:从输入视频中选取代表性帧,使用多视角试穿模型生成细节清晰、风格统一的试穿结果,作为视频生成的基础锚点。

-

人体运动建模:提取输入视频中的人体骨骼关键点和光流信息,作为动态约束条件,指导视频生成过程中的姿态演变。

-

LoRA微调视频模型:利用LoRA适配器对预训练视频扩散模型进行轻量级微调,结合关键帧输出与运动信号,高效生成时间连贯的试穿视频。

DreamVVT的项目地址

DreamVVT的应用场景

-

电商虚拟试衣:集成至在线购物平台,用户上传自身视频即可实时试穿不同款式服装,提升购买决策效率,降低退货率。

-

数字时装秀:助力品牌打造沉浸式虚拟时装发布,突破物理场地限制,实现全天候、全球化的时尚展示。

-

影视与特效制作:在电影、剧集制作中快速预览角色着装效果,减少实体服装成本与拍摄周期,同时可用于动画角色的写实服饰合成。

-

游戏角色定制:应用于游戏和VR场景,允许玩家为虚拟形象自由更换真实风格服饰,提升个性化体验与沉浸感。

-

社交内容创作:赋能社交媒体用户和内容创作者,轻松制作虚拟穿搭短视频,丰富时尚类UGC内容生态。

以上就是DreamVVT— 字节联合清华推出的视频虚拟试穿技术的详细内容,更多请关注php中文网其它相关文章!

DreamVVT的主要功能

DreamVVT的主要功能