答案:JavaScript通过TensorFlow.js等库调用预训练模型实现图像识别,利用WebAssembly和WebGL加速,在浏览器端完成推理任务。这种方式保护用户隐私、降低服务器成本、支持离线使用,但受限于设备性能和模型大小,适合轻量级、实时性要求高的场景。

JavaScript(JS)实现图像识别,通常不是指从零开始构建一个复杂的神经网络,而更多是利用现有的、强大的机器学习框架和预训练模型,在浏览器端或Node.js环境中进行推理(Inference)。核心思想是把复杂的计算密集型任务,通过WebAssembly或WebGL加速,搬到前端来执行,从而实现实时、保护隐私的图像处理能力。

解决方案

要在JS环境中实现图像识别,目前最主流且强大的方案就是利用 TensorFlow.js。它是一个由Google开发的库,能让JavaScript开发者直接在浏览器或Node.js中训练和部署机器学习模型。我觉得,这就像是给前端开发者打开了一扇通往AI世界的大门,以前那些看起来高深莫测的机器学习应用,现在我们也能亲手捣鼓了。

具体来说,TensorFlow.js提供了几种实现图像识别的途径:

-

加载预训练模型进行推理: 这是最常用、也最快速的方式。TensorFlow.js生态系统里有很多已经训练好的模型,比如用于图像分类的MobileNet、用于目标检测的COCO-SSD等。你只需要几行代码就能加载这些模型,然后把你的图片数据输入进去,模型就能给出识别结果。这极大地降低了门槛,因为你不需要自己拥有大量数据或强大的计算资源去训练模型。

import * as tf from '@tensorflow/tfjs'; import * as mobilenet from '@tensorflow-models/mobilenet'; async function classifyImage(imgElement) { // 确保使用WebGPU或WebGL后端以获得最佳性能 await tf.setBackend('webgl'); // 或者 'webgpu' 如果支持 console.log('加载MobileNet模型...'); const model = await mobilenet.load(); console.log('模型加载完成。'); const predictions = await model.classify(imgElement); console.log('识别结果:', predictions); // predictions 包含 [{ className: '类别名', probability: 概率 }] return predictions; } // 示例用法(假设页面上有一个id为'myImage'的图片元素) const img = document.getElementById('myImage'); if (img) { img.onload = () => classifyImage(img); // 或者直接调用,如果图片已经加载 // classifyImage(img); }这段代码展示了如何加载MobileNet模型并对一个HTML

@@##@@

元素进行图像分类。它非常直观,而且性能在现代浏览器中也相当不错。 在浏览器中进行迁移学习或训练小型模型: 虽然直接从头训练一个大型深度学习模型在浏览器端不现实,但你可以利用预训练模型的特征提取能力,在其基础上进行迁移学习。这意味着你可以在一个相对较小的数据集上,用较少的计算资源和时间,训练出一个针对特定任务的定制模型。比如,你可以用MobileNet作为基础模型来提取图像特征,然后只训练最后几层来识别你自己的特定物品。这对于一些个性化、私密性要求高的应用场景非常有用。

结合其他库: 除了TensorFlow.js,还有一些基于它构建的、更易用的库,比如 ml5.js,它封装了TensorFlow.js的复杂性,提供了更简洁的API,非常适合初学者和快速原型开发。另外,像 face-api.js 这样的库则专注于特定领域,如人脸检测、识别和表情分析,它们内部也大量使用了WebAssembly和Web Workers来优化性能。

总的来说,JS实现图像识别,就是站在巨人的肩膀上,利用现有的AI模型和前端技术栈,将AI能力带入浏览器,让用户体验更流畅、数据更安全。

为什么浏览器端的图像识别成为可能,它的优势和局限性有哪些?

浏览器端的图像识别,在几年前听起来可能还像是科幻小说里的情节,但现在已经相当成熟了。这得益于几个关键技术的发展。

首先,WebAssembly (Wasm) 是一个巨大的推动力。它允许开发者将C、C++或Rust等语言编写的代码编译成一种可以在浏览器中运行的二进制格式。这意味着像TensorFlow这样的复杂计算库,其核心算法部分可以被编译成Wasm模块,以接近原生的速度运行。这解决了JavaScript在处理大量数值计算时性能不足的问题。

其次,WebGL和WebGPU(WebGPU是WebGL的下一代标准,还在发展中)为浏览器提供了直接访问GPU的能力。深度学习模型在推理时,尤其是在处理图像数据这种高维张量时,GPU的并行计算能力是至关重要的。有了WebGL/WebGPU,TensorFlow.js等框架就能将模型计算卸载到用户的显卡上,从而大幅提升运行速度,实现实时图像处理。

再者,JavaScript引擎本身的优化 也功不可没。V8(Chrome和Node.js的JavaScript引擎)等现代JS引擎通过JIT编译、垃圾回收优化等手段,让JS的执行效率越来越高。

优势:

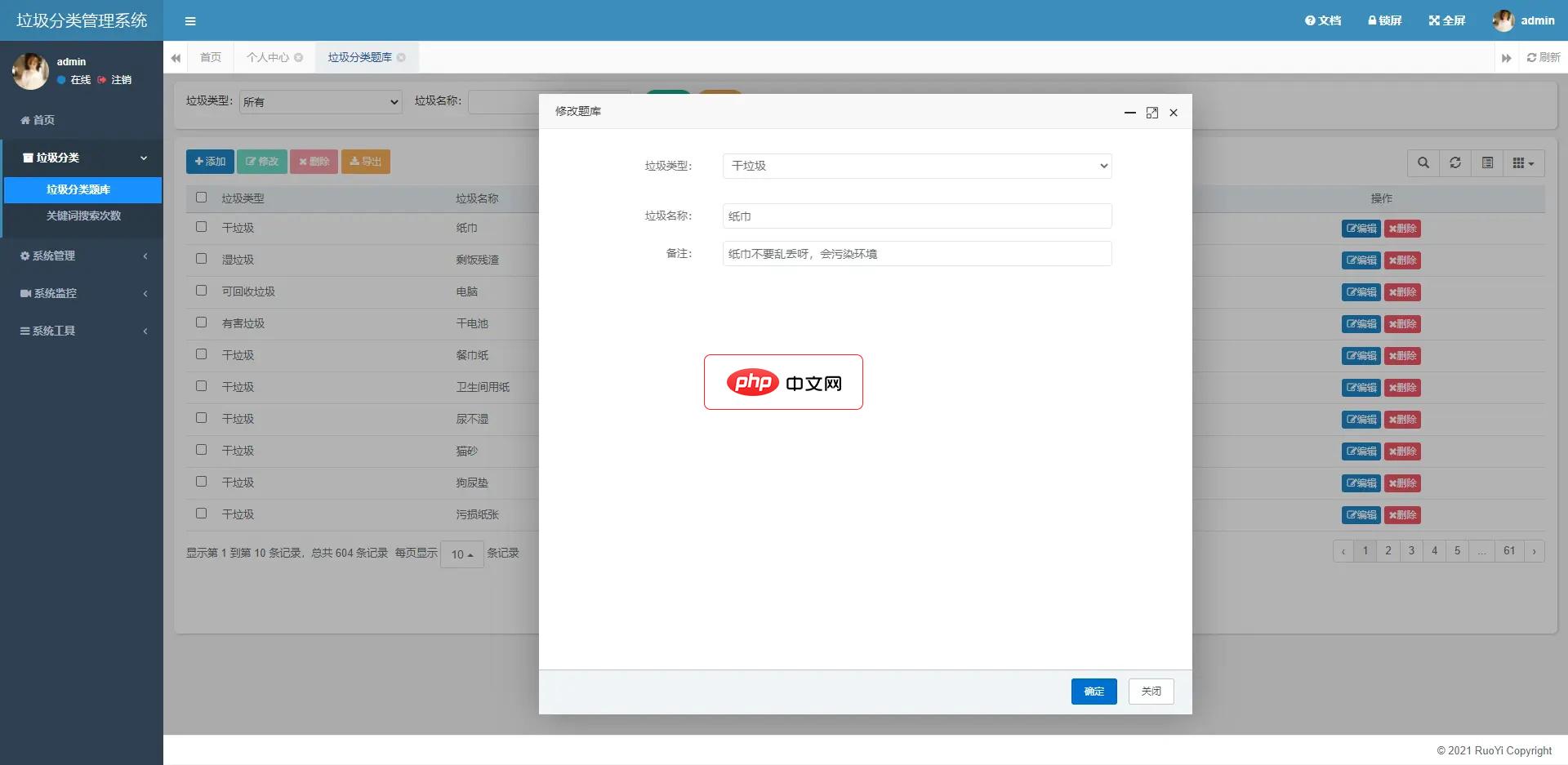

GarbageSort垃圾识别工具箱是一个基于uni-app开发的微信小程序,使用SpringBoot2搭建后端服务,使用Swagger2构建Restful接口文档,实现了文字查询、语音识别、图像识别其垃圾分类的功能。前端:微信小程序 采用 uni-app 开发框架,uni-app 是一个使用 Vue.js 开发所有前端应用的框架,开发者编写一套代码,可发布到iOS、Android、H5、以及各

- 用户隐私保护: 图像数据在用户设备本地处理,无需上传到服务器,大大增强了用户数据的隐私安全性。这对于涉及个人敏感信息的应用(如人脸识别)尤为重要。

- 实时性与低延迟: 由于计算发生在本地,省去了网络传输的时间,识别结果几乎是即时反馈的。这对于需要实时交互的应用(如AR滤镜、实时物体追踪)至关重要。

- 降低服务器成本: 图像识别的计算负载从服务器转移到了客户端,减轻了服务器的压力和带宽消耗,从而降低了运营成本。

- 离线可用性: 一旦模型文件下载到本地,即使没有网络连接,应用也能继续进行图像识别。这对于一些特定场景(如野外作业、网络不稳定的地区)非常有用。

- 部署简便: 作为一个Web应用,无需用户安装任何客户端软件,只需通过浏览器访问即可使用,极大地简化了分发和更新流程。

局限性:

- 性能瓶颈: 尽管有WebAssembly和WebGL/WebGPU的加持,但浏览器端的计算能力仍然无法与专业的服务器级GPU相媲美。对于非常大型、复杂的模型(如某些高精度的语义分割模型),在浏览器中运行可能会非常缓慢,甚至卡顿。

- 模型大小限制: 模型文件需要从网络下载到客户端。大型模型意味着更长的下载时间,这会影响用户体验。因此,通常需要使用轻量级或经过优化的模型。

- 内存消耗: 运行大型模型会占用较多的浏览器内存,这在低端设备上可能会导致性能问题甚至崩溃。

- 浏览器兼容性: 虽然主流浏览器都支持WebGL,但WebGPU仍在推广中,且不同浏览器、不同设备的GPU硬件差异可能导致性能表现不一。

- 训练复杂性: 虽然TensorFlow.js支持在浏览器中训练模型,但对于大型数据集和复杂模型来说,效率远低于服务器端的Python环境。浏览器端更适合进行推理或小规模的迁移学习。

在实际项目中,如何选择合适的JS图像识别库和模型?

在实际项目中,选择合适的JS图像识别库和模型,就像是为一场旅行挑选交通工具和地图。没有一劳永逸的最佳方案,一切都取决于你的“旅行目的地”——也就是项目的具体需求。

首先,你需要明确你的 任务类型。你是要做图像分类(这张图里是什么?)、目标检测(图里有哪些物体,它们在哪里?)、人脸识别(这是谁?)、姿态估计(人的骨架在哪里?)还是图像分割(哪些像素属于哪个物体?)?不同的任务类型,对应的模型和库会有所侧重。比如,如果只是简单的图像分类,MobileNet这样的轻量级模型配合TensorFlow.js就足够了;如果是人脸相关的,face-api.js可能会更省心。

其次,要考虑 性能要求和用户设备。你的应用需要实时反馈吗?用户大多使用PC还是移动设备?如果追求极致的实时性,并且用户设备性能有限,那么你必须选择非常轻量级的模型,并考虑使用Web Workers将推理过程放到后台线程,避免阻塞主UI线程。模型的大小也是一个重要考量,用户可不会乐意为了一个功能下载几十上百兆的模型文件。通常,我们会优先选择经过量化(quantized)或剪枝(pruned)的轻量级模型,它们在保持一定精度的前提下,体积更小,运行更快。

再者,是 开发成本和社区支持。如果你希望快速原型开发,或者团队成员对深度学习不太熟悉,那么像ml5.js这样封装度高、API简洁的库会是很好的选择。它提供了很多预设的示例和功能,上手很快。如果你的项目需要高度定制化的模型,或者对性能有极致要求,需要深入到底层控制,那么直接使用TensorFlow.js会提供更大的灵活性。同时,关注库的社区活跃度、文档完善程度和是否有足够的示例,这些都能在开发过程中提供巨大帮助。

最后,别忘了 数据隐私和模型部署 的考量。如果你的应用处理的是敏感数据,或者需要离线工作,那么客户端本地推理是唯一的选择。这意味着你需要确保模型能在浏览器端高效运行。如果模型太大,或者计算量实在太大,以至于浏览器无法胜任,那么你可能需要退而求其次,考虑将部分计算放在服务器端,或者只在客户端进行简单的预处理和特征提取,将复杂推理交给后端。

总而言之,选择合适的库和模型,是一个权衡的过程。你得在模型精度、运行速度、模型大小、开发便捷性和用户体验之间找到一个平衡点。通常我会先从最简单的预训练模型开始尝试,如果达不到要求,再逐步考虑更复杂、更定制化的方案。

遇到性能瓶颈或识别准确率不高时,有哪些优化策略?

在JS图像识别的实践中,遇到性能不佳或准确率不理想的情况是家常便饭。这就像你在调优一辆赛车,总有地方可以打磨。

针对性能瓶颈:

-

模型选择与优化: 这是最直接有效的方式。

- 选择更小的模型: 比如,优先考虑MobileNetV2而不是InceptionV3,或者YOLOv3-tiny而不是YOLOv4。这些模型在设计时就考虑了在资源受限环境下的运行效率。

- 模型量化: 将模型的浮点参数转换为8位整数(或更低位)表示。TensorFlow.js支持加载量化模型,这能显著减少模型体积和推理时间,虽然可能会牺牲一点点精度,但很多时候这点牺牲是值得的。

- 模型剪枝: 在模型训练后,移除其中不重要的连接和神经元,从而减小模型大小和计算量。

- 利用Web Workers: 将模型的推理计算放在一个独立的Web Worker线程中运行。这样,即使模型计算量大,也不会阻塞主线程,导致UI卡顿。用户界面依然可以保持流畅响应。

-

确保使用GPU加速: 明确设置TensorFlow.js使用WebGL或WebGPU后端。

await tf.setBackend('webgl'); // 或者 'webgpu'并确保浏览器环境支持且启用了GPU加速。如果用户设备没有GPU或驱动有问题,它会回退到CPU,性能会大打折扣。

-

优化输入数据预处理:

- 图像尺寸: 尽量将输入图像缩放到模型要求的最小尺寸,过大的图像会增加计算量。

- 数据格式转换: 确保图像数据到Tensor的转换过程高效,避免不必要的内存拷贝。

- 批处理(Batching): 如果你需要处理多张图片,尝试将它们合并成一个批次(batch)输入给模型进行推理,这比一张一张地处理效率更高。

- 浏览器环境优化: 确保浏览器是最新版本,因为新的浏览器版本通常会对JS引擎和Web API进行性能优化。

针对识别准确率不高:

-

数据是王道: 机器学习模型的性能上限很大程度上取决于训练数据的质量和数量。

- 扩充数据集: 如果条件允许,收集更多、更丰富、更符合实际应用场景的数据进行训练。

- 数据增强(Data Augmentation): 对现有数据进行翻转、旋转、裁剪、调整亮度等操作,人工扩充数据集的多样性,提高模型的泛化能力。

- 数据标注质量: 确保你的训练数据标注是准确无误的。错误的标注会直接误导模型学习。

- 迁移学习与微调(Fine-tuning): 对于大多数图像识别任务,从头开始训练一个深度学习模型是不切实际的,因为它需要海量数据和计算资源。最有效的方法是利用一个在大型通用数据集(如ImageNet)上预训练好的模型(比如MobileNet、ResNet等),然后用你自己的小数据集对它的最后几层进行微调。这能让模型快速适应你的特定任务,并利用到预训练模型已经学到的通用图像特征。

-

模型选择与架构调整:

- 尝试更复杂的模型: 如果轻量级模型无法满足精度要求,可能需要考虑使用更大、更深的模型(当然,这会带来性能挑战)。

- 调整模型超参数: 如果你在进行迁移学习或训练自定义模型,尝试调整学习率、批次大小、优化器等超参数。

-

后处理优化:

- 对于目标检测任务,非极大值抑制(NMS)的参数调整对最终的检测效果有很大影响。

- 对于分类任务,可以考虑对模型的输出概率进行一些额外的逻辑判断或阈值设定。

-

调试与分析:

- 使用TensorFlow.js的调试工具(如

tf.enableDebugMode()

)来查看模型的输入输出,检查是否存在数据格式或形状不匹配的问题。 - 分析模型在哪些类型的图片上容易出错,这可能提示你的数据集存在偏差或模型对某些特征学习不足。

- 使用TensorFlow.js的调试工具(如

记住,优化是一个迭代的过程。你不可能一次性解决所有问题。通常是先让功能跑起来,然后根据实际表现,有针对性地进行性能和准确率的优化。