金磊 从 凹非寺 量子位 报道 | 公众号 qbitai

在处理大规模图像识别任务时,DeepMind推出了一种新方法,引起了广泛关注。

不仅达到了最先进的水平(SOTA),而且训练速度提升了惊人的8.7倍!

方法的关键在于去除“批处理归一化”。对于大多数图像识别模型而言,批处理归一化(batch normalization)是一个关键组成部分。

方法的关键在于去除“批处理归一化”。对于大多数图像识别模型而言,批处理归一化(batch normalization)是一个关键组成部分。

然而,这种方法也存在一些局限性,即包含了许多不必要的特征。

尽管近期的研究表明,在没有归一化的情况下,可以成功训练深度ResNet,但这些模型的测试精度与最佳批处理归一化网络相比仍有差距。

DeepMind的这次研究旨在解决这个问题,提出了自适应梯度剪裁(AGC)技术。

具体来说,这是一种称为Normalizer-Free ResNet(NFNet)的新网络架构。

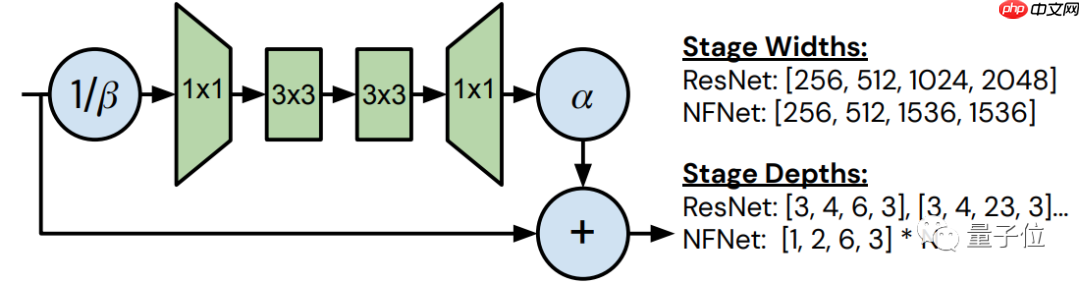

从整体结构来看,NFNet如上图所示。

从整体结构来看,NFNet如上图所示。

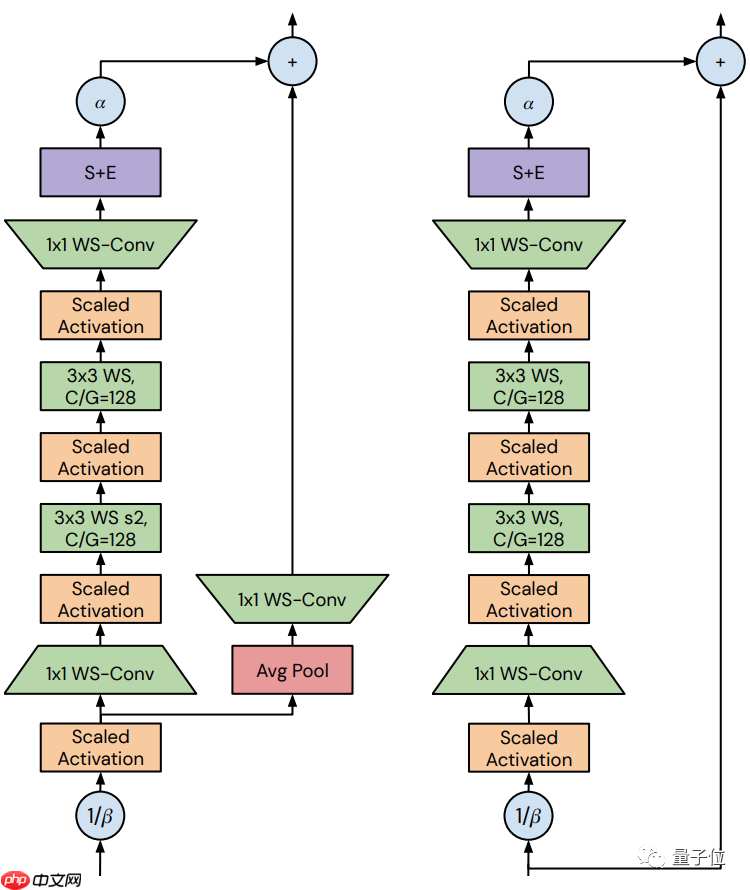

根据是否包含“transition块”,可以将其细分为两种类型。

它们的bottleneck ratio均设置为0.5,且在3 x 3的卷积中,无论信道的数量如何,组宽都固定为128。

它们的bottleneck ratio均设置为0.5,且在3 x 3的卷积中,无论信道的数量如何,组宽都固定为128。

两者的区别在于skip path接收信号的方式,左侧是在使用β进行variance downscaling和缩放非线性之后;而右侧则是在使用β进行variance downscaling之前完成。

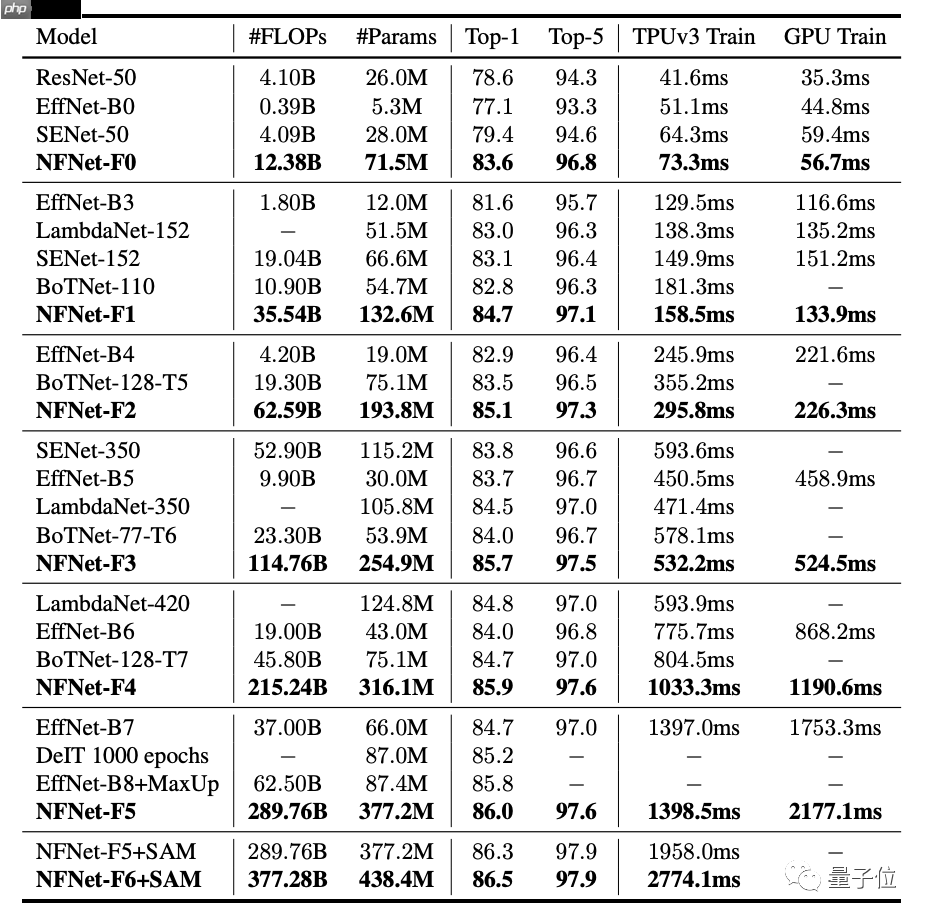

实验结果在实验部分,DeepMind的研究人员使用了与NFNet相关的7个模型进行对比实验,分别为NFNet-F0至NFNet-F6。

显然,在各个模型的对比中,NFNet在Top-1精度方面均取得了最佳结果。

值得注意的是,与EfficientNet-B7相比,训练速度提升了8.7倍。

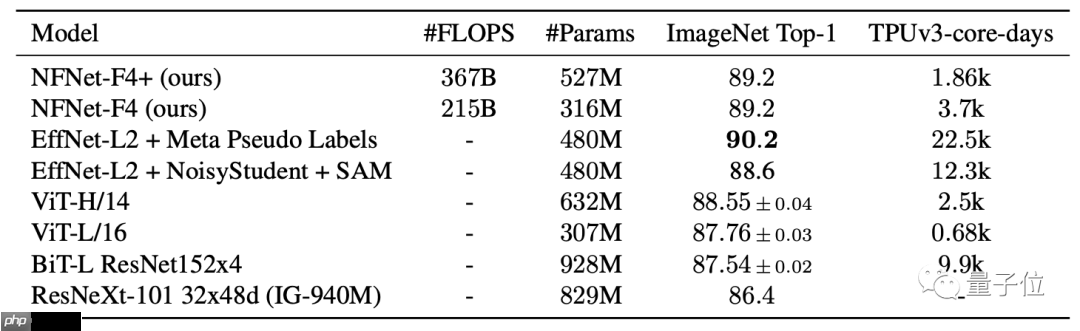

此外,在对3亿张标记图像进行大规模预训练后,在ImageNet上取得了89.2%的Top-1精度。

此外,在对3亿张标记图像进行大规模预训练后,在ImageNet上取得了89.2%的Top-1精度。

最后,这项研究的代码已在GitHub上开源。

最后,这项研究的代码已在GitHub上开源。

论文链接:https://www.php.cn/link/c4caf9e04a0d4f83565449f2cce9d5d5

代码链接:https://www.php.cn/link/e607b9b80358410a2bcdcbc7e9978ce1

— 完 —

本文为网易新闻•网易号特色内容激励计划签约账号【量子位】的原创内容,未经授权,请勿随意转载。

以上就是DeepMind丢掉了归一化,让图像识别训练速度提升了8.7倍 | 已开源的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号