谷歌 AI 最近推出了一款名为 Stax 的实验性评估工具,专为帮助开发者更高效地测试和分析大语言模型(LLMs)而设计。

与传统软件不同,大语言模型属于概率性系统,对同一提示可能生成不同的输出,这给评估过程的一致性和可重复性带来了挑战。为此,Stax 提供了一套结构化框架,支持开发者根据自身业务场景中的具体标准来评估和对比不同模型的表现。

在当前的模型评估实践中,排行榜和通用基准测试被广泛使用,虽然有助于追踪整体技术进展,但难以满足特定行业或应用场景的实际需求。例如,一个在开放域推理任务中表现优异的模型,未必擅长生成合规文档摘要、解析法律条文或回答企业内部知识库中的专业问题。Stax 通过允许用户自定义评估流程,有效弥补了这一差距。

该工具的一个关键特性是“快速比较”功能。它支持开发者将多个模型和提示并列运行,直观地观察提示工程调整或模型更换对输出结果的影响,从而显著减少反复试验的时间成本。

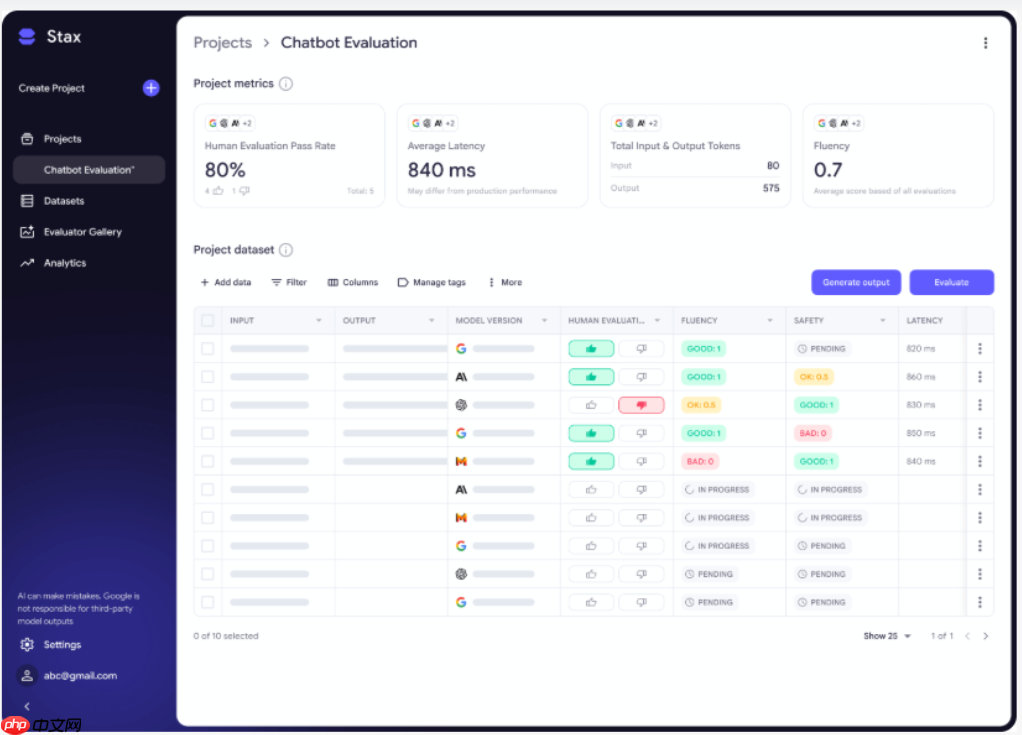

同时,Stax 还引入了“项目与数据集”模块,适用于需要大规模、系统化测试的场景。开发者可以创建结构化的测试数据集,并在整个测试集中统一应用评估规则,提升测试的可复现性,并让模型在更贴近真实应用的环境下接受检验。

Stax 的核心机制之一是“自动评估器”。开发者既可以构建针对特定用例的定制化评估器,也可以选用平台提供的预设评估器。系统内置的评估类别包括语言流畅性(语法准确性和表达清晰度)、事实基础性(输出与参考内容的一致性)以及安全性(避免生成有害或不适当内容)等常见维度。这种模块化设计使得评估指标能够精准匹配实际业务需求,而非依赖单一通用评分。

此外,Stax 配备了可视化分析仪表板,帮助开发者更直观地解读评估结果。用户可以在仪表板中查看模型性能的变化趋势,对比不同评估器的判断结果,并深入分析多个模型在同一数据集上的表现差异。

总体而言,Stax 推动了从随意性测试向系统化、可重复评估的转变,使开发团队能够在部署前更全面地理解模型在特定条件下的行为,确保其输出持续符合实际应用场景的质量与合规要求。

以上就是谷歌 AI 推出 Stax:帮助开发者根据自定义标准评估大语言模型的详细内容,更多请关注php中文网其它相关文章!

谷歌浏览器Google Chrome是一款可让您更快速、轻松且安全地使用网络的浏览器。Google Chrome的设计超级简洁,使用起来得心应手。这里提供了谷歌浏览器纯净安装包,有需要的小伙伴快来保存下载体验吧!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号