谷歌发布了最新的 2025 年 dora 报告,重点聚焦 ai 在软件开发中的广泛应用及其带来的深远影响。

DORA(DevOps Research and Assessment) 是由谷歌长期主导的开发效能研究项目,每年通过全球范围的大规模调研,为软件工程团队提供基于数据的洞察与实践指导。今年报告的核心主题围绕 AI 的快速普及、开发者对其的信任困境,以及它对团队运作和组织效能的实际作用展开。

以下是本年度报告的主要发现与深入解读:

-

AI 使用率实现飞跃式增长

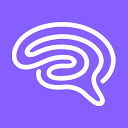

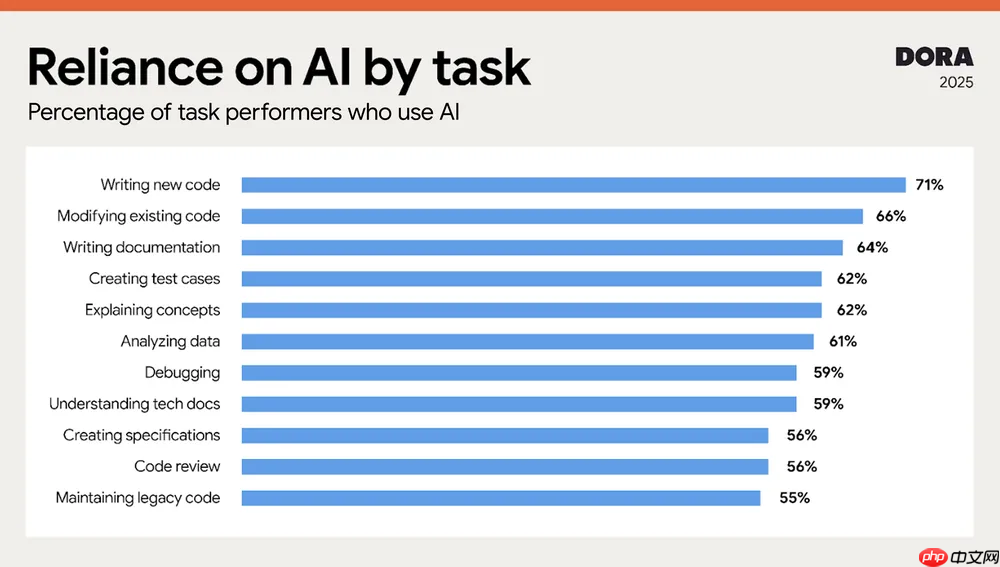

- 高达 90% 的开发者已在日常核心开发任务中使用 AI 工具,较去年上升 14 个百分点。

- 开发者平均每天投入约 2 小时与 AI 协同工作。

- 解读:AI 不再是边缘尝试或实验性工具,而是深度嵌入主流开发流程的关键助手。

-

AI 显著提升效率与代码质量

- 80% 的开发者反馈 AI 提升了他们的工作效率。

- 超过半数(59%)认为 AI 对提升代码质量有积极影响。

- 解读:AI 主要在自动化重复任务、减少语法错误和加速编码方面发挥作用,但尚无法替代人类在架构设计与创新上的判断力。

-

存在显著的“信任悖论”

- 仅有 24% 的开发者表示高度信任 AI 输出结果。

- 约三成(30%)受访者表示“几乎不信任”或“完全不信任”AI 建议。

- 解读:尽管广泛使用,开发者仍对 AI 可能产生的“幻觉”、安全漏洞和逻辑偏差保持警惕。

-

AI 具备“倍增效应”

- 报告指出:AI 并非独立解决方案,而是一种“放大器”。

- 在高效协作、流程清晰的团队中,AI 加速交付并增强产出质量。

- 而在流程混乱、沟通不畅的团队中,AI 可能加剧技术债务与决策失误。

- 解读:AI 的价值取决于组织的基础能力,技术和文化需同步演进。

-

提出七类团队原型(7 Archetypes)

- DORA 将团队划分为七种典型模式,从“和谐高绩效团队(Harmonious high-achievers)”到“传统瓶颈团队(Legacy bottleneck)”。

- 每一类原型体现了团队在 AI 采用程度、交付效能水平、成员幸福感 三个维度上的综合状态。

- 解读:该分类体系帮助团队识别自身位置,并制定针对性改进策略。

-

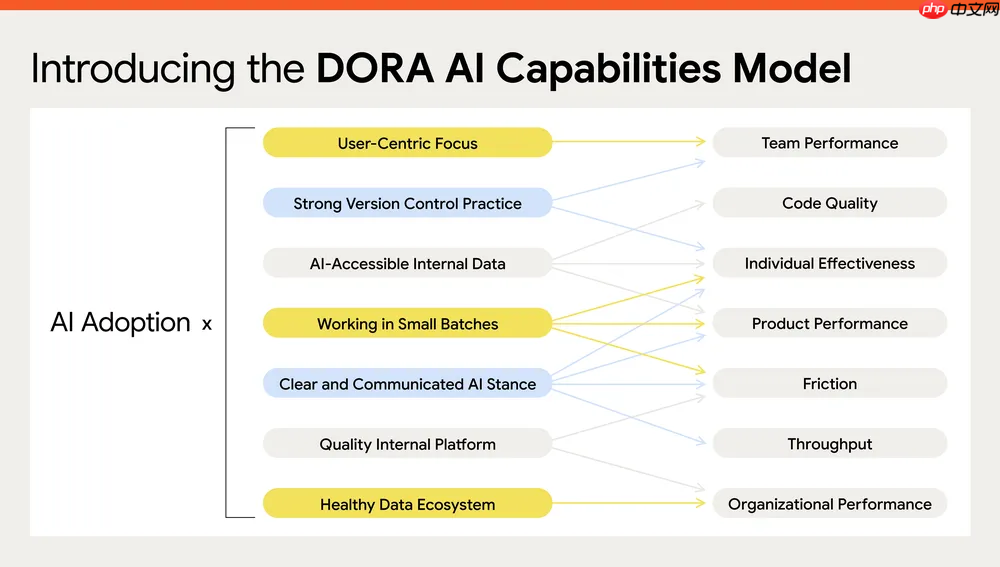

推出 DORA AI 能力模型(7 项核心能力)

- 报告首次提出一个系统的 AI 能力成熟度框架,涵盖七项关键能力,用于评估组织 AI 应用水平。

- 虽未完全公开细节,但已知包括:工具链集成、治理与合规机制、信任建立与验证流程、跨职能协同、持续学习体系 等要素。

- 解读:这一模型可视作 DevOps 成熟度模型的 AI 延伸,未来有望成为行业标准参考。