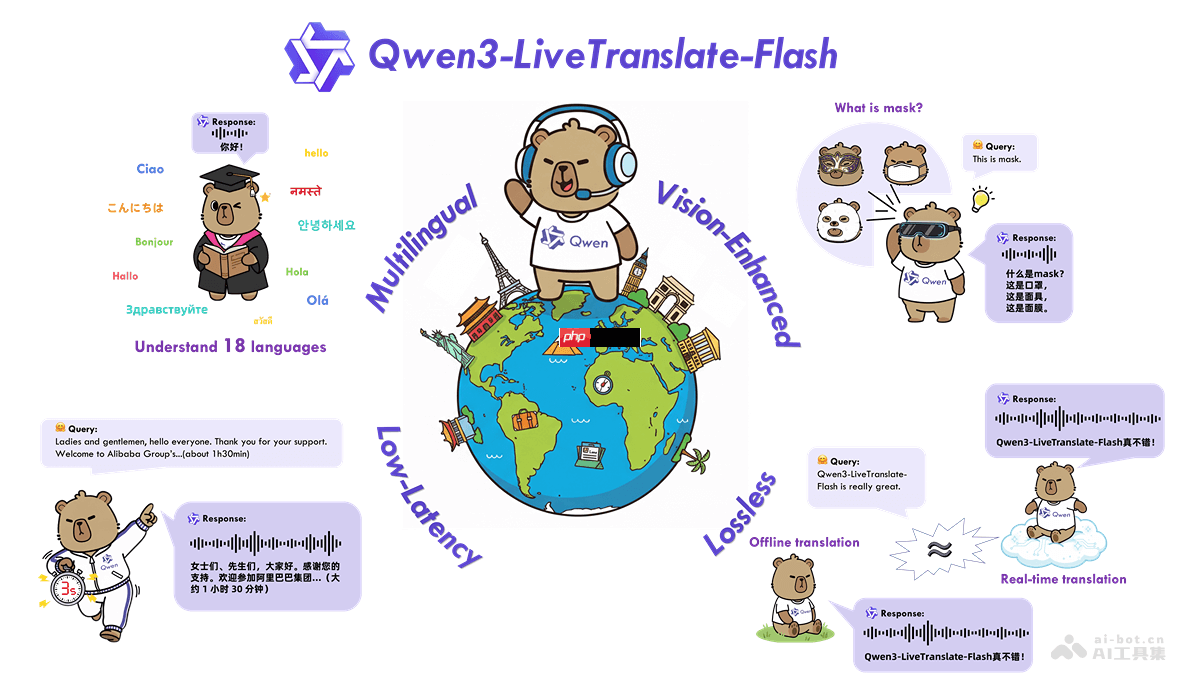

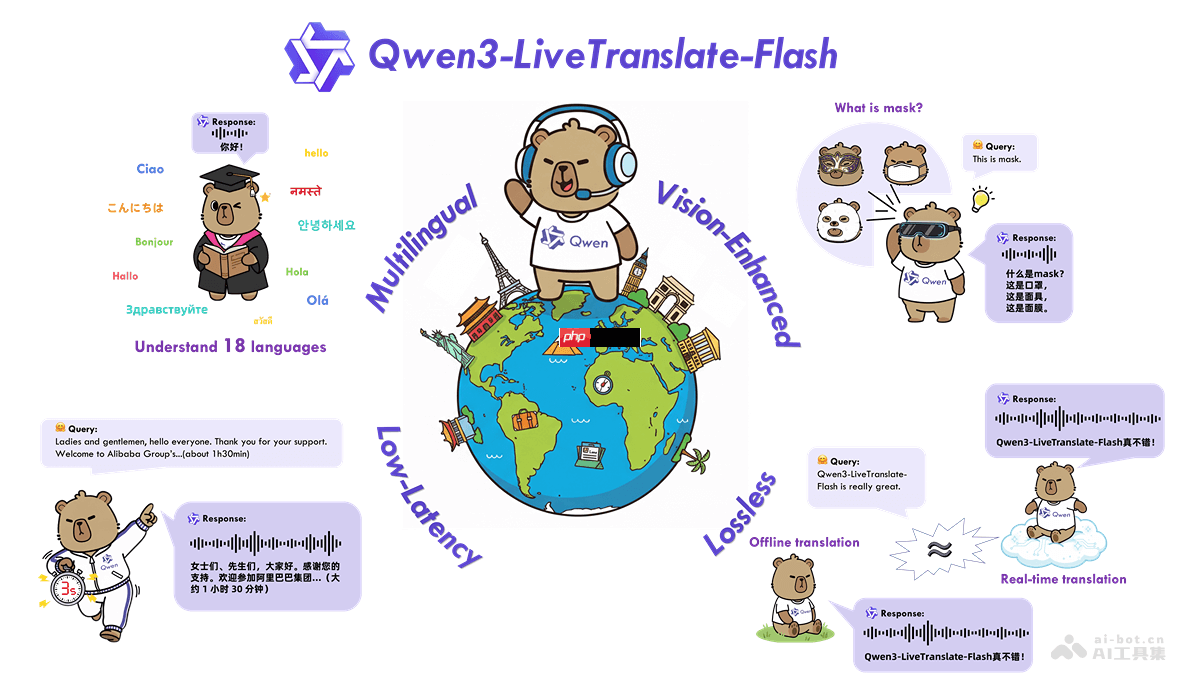

Qwen3-LiveTranslate是什么

qwen3-livetranslate 是由阿里通义实验室推出的一款基于大语言模型的多语言实时音视频同声传译系统。该模型支持18种主流语言及多种方言之间的互译,融合视觉增强技术,能够利用说话人的口型、肢体动作等多模态信息提升翻译精准度。凭借最低仅3秒的超低延迟和无损质量还原能力,其翻译效果接近离线高精度翻译水平,并配备自然流畅的语音合成音色。在复杂噪音环境下依然表现稳定,有效打破语言壁垒,实现更自然、顺畅的跨语言交流。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

Qwen3-LiveTranslate的主要功能

-

多语言实时翻译:覆盖中、英、法、德、日、韩等18种语言,支持普通话、粤语、四川话等多种方言,适用于离线与在线音视频场景下的即时翻译。

-

视觉增强翻译:融合口型变化、面部表情、手势动作及画面文字等视觉线索,显著提升在嘈杂环境或一词多义语境下的翻译准确率。

-

低延迟同传体验:采用轻量级混合专家架构(MoE)与动态采样机制,实现端到端最低3秒延迟,满足高实时性需求。

-

高质量无损翻译:通过语义单元预测技术优化跨语言语序调整,保障输出语句通顺自然,翻译质量逼近专业离线翻译水准。

-

拟人化语音输出:根据原始语音的情感、节奏自动调节语调与语气,生成富有表现力、接近真人发音的自然音色。

Qwen3-LiveTranslate的技术原理

-

多模态数据融合机制:同步处理音频信号与视频内容,整合语音流与视觉特征,增强对上下文语义的理解能力。

-

语义单元建模:对输入语言进行细粒度语义切分与结构分析,提前预测目标语言中的合理语序排列,减少错译漏译。

-

轻量混合专家架构:基于稀疏化的MoE模型设计,结合动态计算资源调度策略,在保证性能的同时大幅降低推理延迟。

-

大规模音视频训练数据:依托海量真实场景下的多语言音视频语料进行训练,提升模型对不同口音、语速和方言的泛化能力。

-

视觉辅助解码技术:运用计算机视觉算法提取唇动轨迹、表情变化等非语音信息,作为语音识别与翻译的补充依据,提高鲁棒性与准确性。

Qwen3-LiveTranslate的项目地址

Qwen3-LiveTranslate的应用场景

-

国际会议同传:为跨国会议、论坛提供实时多语种同声传译服务,帮助来自不同国家的参与者无障碍获取信息,提升沟通效率。

-

远程教学与在线学习:将教师授课内容实时翻译成学生母语,助力全球化教育普及,让语言不再成为知识传播的障碍。

-

跨国商务协作:应用于跨国电话会议、商务洽谈等场景,实现低延迟精准互译,避免因语言误解影响合作进程。

-

出境旅游交流:游客可通过设备实现实时口语互译,轻松应对问路、点餐、购物等日常对话,畅享无忧旅程。

-

全球媒体直播:广泛用于国际新闻播报、体育赛事、大型活动直播中,实时生成多语言字幕或配音,扩大传播范围与观众覆盖面。

以上就是Qwen3-LiveTranslate— 阿里通义推出的全模态同传大模型的详细内容,更多请关注php中文网其它相关文章!

Qwen3-LiveTranslate的主要功能

Qwen3-LiveTranslate的主要功能