本文旨在帮助读者理解 PyTorch 中 conv2d 函数的具体实现位置,并深入了解卷积操作的底层原理。通过本文,你将找到 conv2d 相关的 C++ 代码,从而更好地理解 PyTorch 如何执行卷积运算。

PyTorch 的 conv2d 函数是深度学习中常用的卷积操作,它在神经网络中扮演着至关重要的角色。虽然我们通常通过 torch.nn.functional.conv2d 或 torch.nn.Conv2d 在 Python 中调用它,但其底层实现却是由 C++ 代码完成的。理解这些 C++ 代码的位置,有助于我们更深入地了解 PyTorch 的内部机制,并可能在需要时进行自定义扩展。

conv2d 的 C++ 实现位置

PyTorch 的 conv2d 函数的实现位于 PyTorch GitHub 仓库的 aten/src/ATen/native/Convolution.cpp 文件中。具体来说,conv2d 及其变体以及卷积操作本身定义在该文件的 第940行 附近。

代码结构分析

在 Convolution.cpp 文件中,你会找到多个与卷积相关的函数,这些函数涵盖了 conv2d 的不同变体,例如不同的 padding 方式、stride 大小以及 dilation 速率等。这些函数最终会调用底层的卷积算法实现,例如基于 CUDA 的 cuDNN 或基于 CPU 的优化算法。

示例代码(Python 调用)

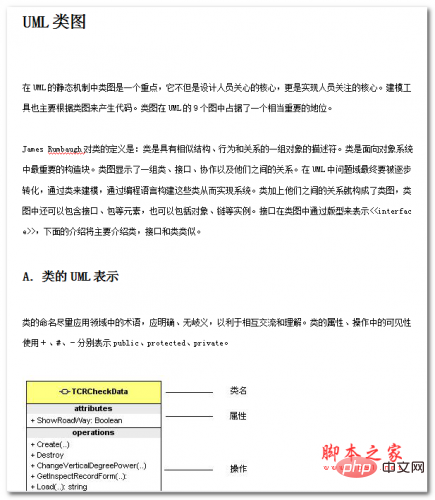

本文档主要讲述的是UML 类图详解;在UML的静态机制中类图是一个重点,它不但是设计人员关心的核心,更是实现人员关注的核心。建模工具也主要根据类图来产生代码。类图在UML的9个图中占据了一个相当重要的地位。希望本文档会给有需要的朋友带来帮助;感兴趣的朋友可以过来看看

虽然我们关注的是 C++ 实现,但理解如何在 Python 中调用 conv2d 函数也是很重要的。以下是一个简单的示例:

import torch import torch.nn.functional as F # 创建一个输入张量 input_tensor = torch.randn(1, 3, 32, 32) # NCHW 格式:Batch size, Channels, Height, Width # 创建一个卷积核 kernel = torch.randn(16, 3, 3, 3) # 输出通道数, 输入通道数, Kernel Height, Kernel Width # 执行卷积操作 output_tensor = F.conv2d(input_tensor, kernel) print(output_tensor.shape) # 输出张量的形状

在这个例子中,F.conv2d 函数接收输入张量和卷积核作为参数,并返回卷积后的输出张量。

注意事项

- Convolution.cpp 文件是 PyTorch 底层实现的核心部分,理解其中的代码需要一定的 C++ 基础和对卷积算法的深入了解。

- PyTorch 的代码库非常庞大,查找特定功能的实现可能需要一些技巧。使用 GitHub 的代码搜索功能,结合关键词(如 "conv2d", "convolution")可以帮助你快速定位到相关的代码。

- PyTorch 可能会在不同版本中对代码进行重构和优化,因此具体的文件路径和代码行数可能会有所变化。请以最新版本的 PyTorch 代码为准。

总结

通过本文,你应该能够找到 PyTorch 中 conv2d 函数的 C++ 实现位置,并对卷积操作的底层原理有更深入的了解。深入研究 Convolution.cpp 文件中的代码,可以帮助你更好地理解 PyTorch 的内部机制,并为自定义扩展提供基础。记住,持续学习和实践是掌握深度学习框架的关键。