在人工智能技术迅猛发展的今天,ai 正以前所未有的速度渗透进我们的日常生活中。从语音助手到图像识别系统,智能模型的应用边界不断拓展。对开发者而言,如何将训练完成的模型顺利部署至小程序,实现模型转换与应用落地的无缝衔接,已成为开启智能化服务新篇章的核心环节。

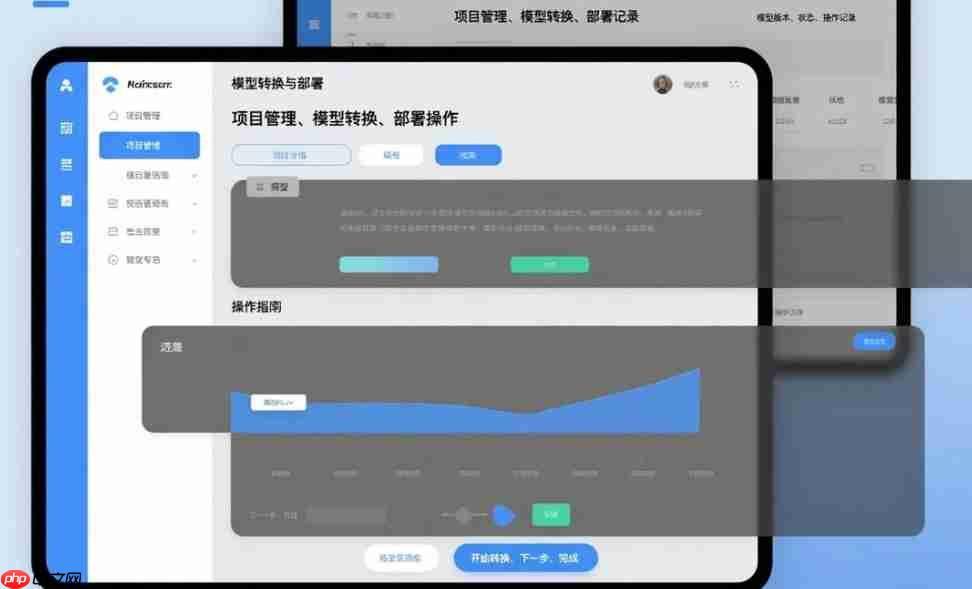

模型转换:连接训练成果与小程序生态的关键纽带

模型转换是整个流程的第一步,相当于为模型“量身定制”适合小程序运行环境的格式。不同框架生成的模型各具特色,如 TensorFlow 的 .pb 文件、PyTorch 的 .pt 或 .pth 模型,而小程序平台通常只支持特定类型的轻量化格式。

以 TensorFlow Lite 为例,它是专为移动设备和边缘计算设计的精简版框架。开发者可以利用 TensorFlow 提供的转换工具(如 TFLite Converter),将标准 TensorFlow 模型转化为适用于移动端的小型化 .tflite 文件。这一过程不仅压缩了模型体积,还优化了推理效率,使其更适应小程序这类资源受限的运行环境。只需按照官方文档配置参数并执行转换脚本,即可完成格式迁移。

对于使用 PyTorch 训练的模型,则可通过 ONNX(开放神经网络交换) 作为桥梁进行中转。首先将 PyTorch 模型导出为 ONNX 格式,再借助第三方工具链将其进一步转换为小程序可加载的格式。ONNX 扮演着“通用翻译器”的角色,打破了框架之间的壁垒,提升了模型跨平台部署的灵活性。

值得注意的是,模型转换不仅仅是格式变更,还需兼顾精度与性能的平衡。例如,在采用量化技术压缩模型时,可能会带来轻微的准确率下降。因此,开发者需根据实际应用场景合理选择是否启用量化、剪枝等优化手段,在保证推理效果的前提下最大限度提升运行速度。

部署小程序:让 AI 能力触手可及

完成模型转换后,下一步是将模型集成到小程序中,真正实现智能功能的落地。

开发者需要熟悉目标小程序平台的开发架构,比如微信小程序基于 JavaScript/WXML 的运行机制。在项目目录中创建专门用于存放模型文件的文件夹,并将转换后的模型导入其中。随后通过平台提供的 API 接口加载模型,并调用其进行推理运算。

举个例子,在一个图像分类类小程序中,用户上传图片后,前端会先对图像进行归一化、缩放等预处理操作,使其满足模型输入维度要求;接着触发模型推理流程,获取输出结果;最后将识别标签或置信度展示给用户。在此过程中,应特别注意模型加载策略——避免因模型过大导致页面卡顿或启动延迟。

为了提升用户体验,可采取多种优化措施:

挑战与应对:在实践中不断突破瓶颈

本程序源码为asp与acc编写,并没有花哨的界面与繁琐的功能,维护简单方便,只要你有一些点点asp的基础,二次开发易如反掌。 1.功能包括产品,新闻,留言簿,招聘,下载,...是大部分中小型的企业建站的首选。本程序是免费开源,只为大家学习之用。如果用于商业,版权问题概不负责。1.采用asp+access更加适合中小企业的网站模式。 2.网站页面div+css兼容目前所有主流浏览器,ie6+,Ch

1

1

尽管模型部署路径日益成熟,但在实际操作中仍面临诸多挑战。

首先是平台兼容性问题。不同小程序平台(如微信、支付宝、百度、字节跳动等)对模型大小、算子支持程度、运行时权限等方面存在差异,部分平台甚至限制了 JS 引擎的计算能力。这就要求开发者在选型初期充分调研各平台的技术文档,评估模型复杂度是否符合规范。

其次是模型更新维护难题。随着业务迭代和数据演进,模型需要定期重新训练和升级。如何在不影响用户正常使用的情况下实现模型热更新?一种可行方案是在服务器端托管最新模型版本,小程序启动时检测版本号,若发现更新则静默下载并在下次启动时生效,从而实现平滑过渡。

此外,安全性也不容忽视。模型文件可能包含敏感逻辑或权重信息,直接暴露在客户端存在被逆向分析的风险。可通过加密模型文件、动态解密加载等方式增强防护,或结合云端协同推理来保护核心算法。

智能小程序的广阔前景

模型转换与小程序部署技术的成熟,正在加速 AI 能力向大众应用的普及。未来,越来越多的智能模型将融入轻量化的应用场景之中,带来前所未有的便捷体验。

想象一下:在医疗健康领域,用户只需通过小程序上传皮肤照片,就能获得皮肤病风险初步判断;在教育场景中,学生答题后系统即时分析错题类型,推送个性化学习路径;在零售行业,消费者拍摄商品图片即可获取推荐搭配与价格对比……

这些不再是遥不可及的设想,而是正在发生的现实。

结语

模型转换与部署至小程序,标志着人工智能从实验室走向大众生活的关键一步。它不仅拓宽了开发者的创新边界,也让普通用户得以随时随地享受智能服务。随着工具链不断完善、硬件性能持续提升,未来的智能小程序将在更多垂直领域绽放光彩,引领我们迈入一个真正“人人可用 AI”的全新时代。

以上就是模型转换与部署小程序的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号