豆包大模型1.6迎来重磅升级,首次在国内推出原生支持“分档调节思考长度”的功能,新增 minimal、low、medium、high 四种思考模式,实现性能与效率的灵活平衡。

以低思考长度模式为例,相较于此前版本单一的思考方式,升级后的豆包1.6在保持模型效果不变的前提下,总输出 Tokens 减少77.5%,思考时间缩短84.6%,显著提升响应速度和资源利用率。

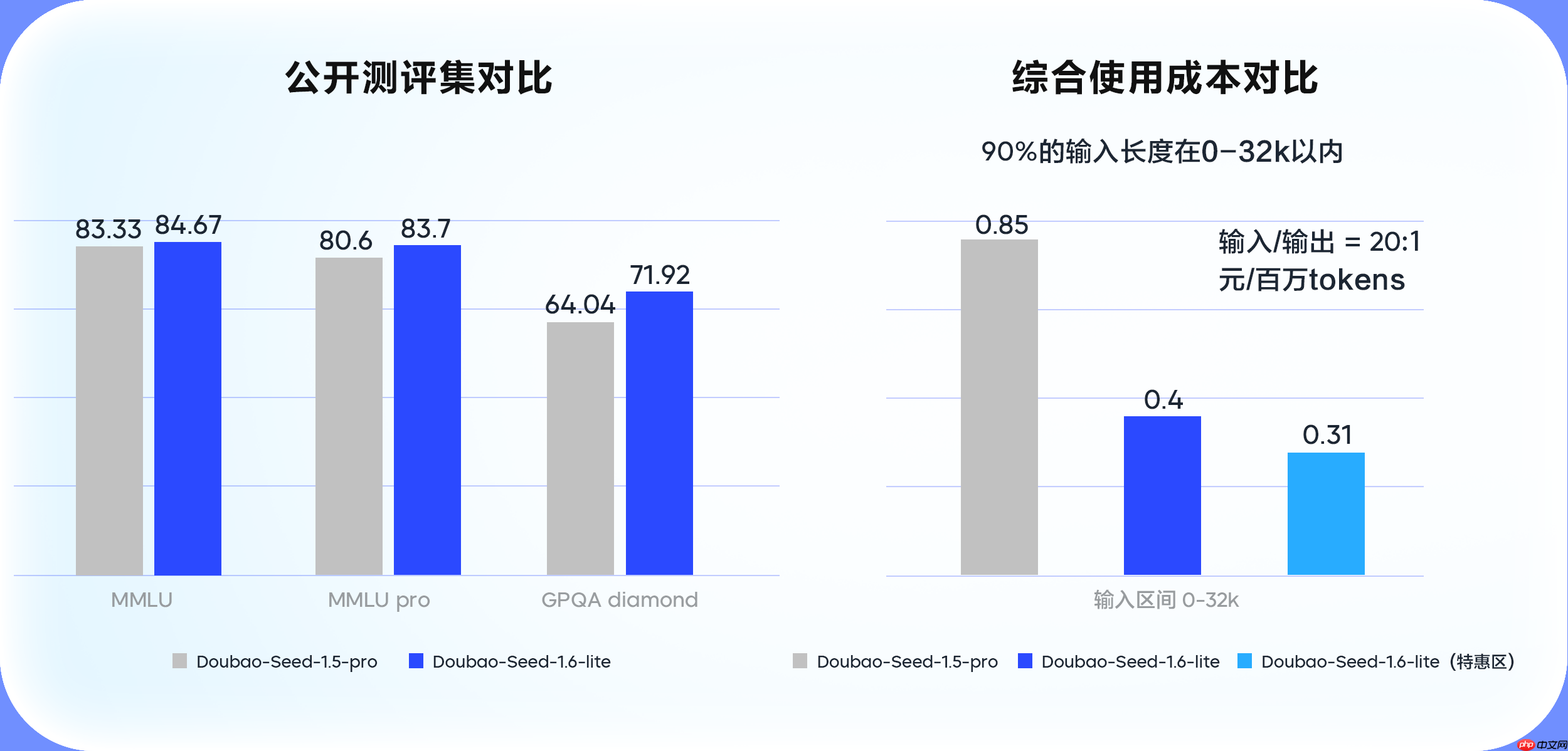

为更好地服务企业用户的多元化场景需求,火山引擎同步发布豆包大模型1.6 lite(Doubao-Seed-1.6-lite)。该轻量级版本在推理速度上表现更优,具备更高的性价比,适用于对响应时效和成本敏感的应用场景。

实测结果显示,豆包1.6 lite 在企业级任务测评中表现优于前代豆包1.5 pro(Doubao-Seed-1.5-pro),整体能力提升14%;在使用最频繁的0-32k输入区间内,综合成本较豆包1.5 pro 下降53.3%,大幅降低企业调用负担。

立即进入“豆包AI人工智官网入口”;

立即学习“豆包AI人工智能在线问答入口”;

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号