特斯拉前自动驾驶负责人、OpenAI联合创始人Andrej Karpathy近日在社交媒体上对开源项目DeepSeek-OCR的论文发表评论,提出了一项引人深思的观点:未来大语言模型(LLM)可能应更多依赖图像而非传统文本token作为输入方式。这一见解迅速在AI研究圈引发热议,推动人们重新思考模型输入范式的演进路径。

Karpathy指出,当前主流的文本分词机制存在效率瓶颈,而以图像形式输入信息或能带来显著提升。他从多个角度分析了图像输入相较于标准token序列的潜在优势。

首先是更高的信息密度。当文字被渲染为图像后,单个视觉patch可承载多个字符内容,相比之下,传统tokenization方案中每个子词或字符往往需独立编码。这意味着,在处理超长上下文时,图像表示有望大幅减少所需的token数量,从而降低计算开销并提升整体效率。

其次是表达能力的增强。图像天然具备对字体样式、颜色、排版结构等视觉特征的承载能力,这些在纯文本系统中通常需要借助额外标记语言(如HTML或Markdown)来描述,而这本身又会增加token负担。若直接输入图像,模型便能更直观地感知文档的格式意图和重点信息。

第三点涉及注意力机制的设计优化。图像输入支持双向注意力结构,允许模型在整个上下文中自由聚焦任意位置,而不像自回归文本生成那样受限于因果顺序。这种非因果性有助于提升语义理解的完整性和准确性。

Karpathy还特别批评了tokenizer本身的复杂与冗余。他认为分词器是一个历史遗留组件,并非端到端设计的理想选择。例如,视觉上完全相同的字符因Unicode来源不同可能被切分为不同token,导致模型误判输入差异。若跳过分词步骤,直接将文本作为图像进行处理,则整个流程将更加简洁一致。

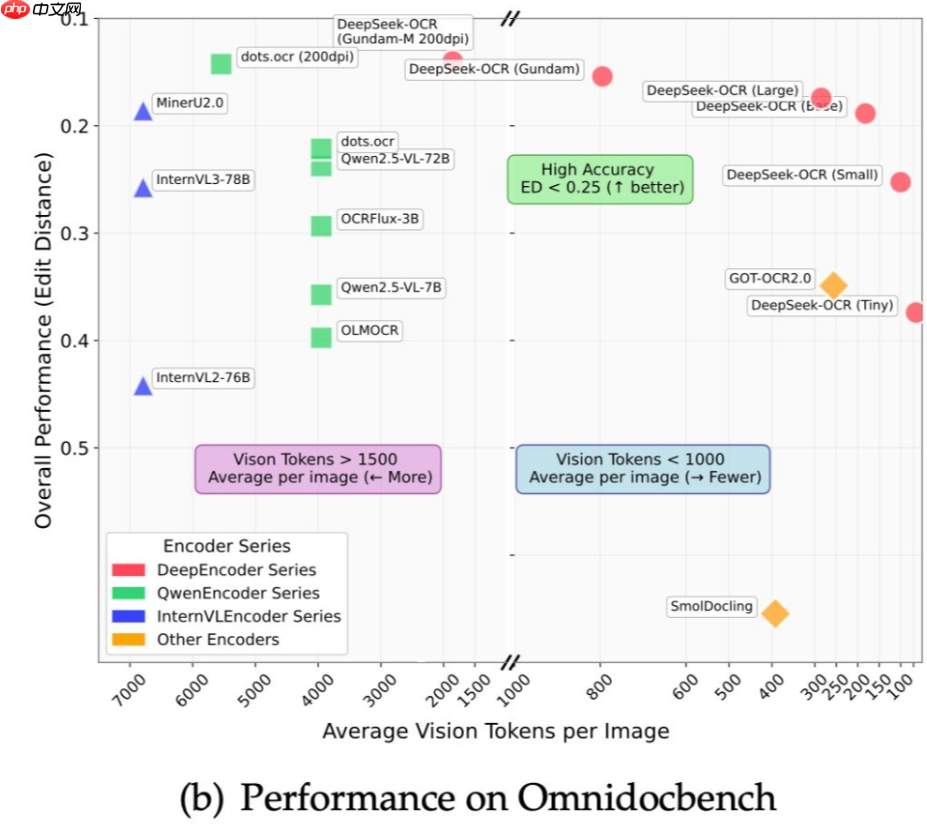

从技术基础来看,这一设想并非空中楼阁。近年来Vision Transformer等视觉架构已展现出强大的图像理解能力,而DeepSeek-OCR等系统的高精度也证明,从图像中还原并理解文本内容已成为现实。这为将“所有文本处理视为视觉任务”提供了可行性支撑。

但他也坦承一个关键限制:尽管输入可用图像,输出仍需回归文本。由于高质量图像生成难度大、成本高,用户交互界面依然依赖可读、可复制的文本结果。因此,即便采用图像输入,系统仍须保留强大的文本生成能力,无法彻底脱离传统语言建模模块。

该观点激起了广泛讨论。从效率维度看,若图像输入确能压缩上下文长度,在处理法律文书、技术手册等长篇材料时将极具价值;从架构统一性出发,图像输入或将打通OCR、文档解析、多模态问答等多个任务边界,实现更一致的模型设计。

然而挑战同样明显。其一,图像编码本身计算量较大,可能抵消部分节省下来的token红利;其二,图像化的“文本”难以编辑、搜索或程序化操作,丧失了纯文本的灵活性;其三,现有NLP生态高度依赖token级处理工具链——包括训练数据、评估指标、推理引擎等——全面转向图像输入意味着重建整套基础设施。

从长远视角观察,Karpathy的看法揭示了一个深层趋势:随着视觉模型日益强大,“语言模型”或许正逐步演化为“通用信息处理器”,其中文本只是信息呈现的一种形态。在这种范式下,语言与视觉的界限将进一步模糊,催生更具包容性的智能系统。

DeepSeek-OCR之所以成为此次讨论的导火索,正是因为它标志着OCR已超越简单字符识别,迈向深层次文档语义理解的新阶段。如果模型能够精准解析复杂排版中的语义结构,那么将一切文本理解任务都归结为“视觉理解”在逻辑上是成立的。

Karpathy最后半开玩笑地表示:“得忍住别马上去做一个只接受图像输入的聊天机器人。”这句话既流露出他对该方向的热情,也折射出实际落地过程中的重重障碍。这种根本性架构变革需要大量实证验证,还需克服工程、性能与兼容性等多重难题。

在应用层面,即使图像输入最终被证实更具优势,过渡过程也将是渐进式的。更现实的发展路径或是混合模式:在重视格式保真的场景(如合同分析、网页理解)使用图像输入;而在强调可编程性和组合性的场合(如代码生成、指令编辑),继续沿用文本token。

总而言之,Karpathy的观点虽具颠覆性,却为AI输入表示的研究打开了新的思路。它质疑了“文本必须转为token”的默认设定,促使学界重新审视模型前端设计的根本原则。无论这一构想是否最终普及,它都可能成为推动下一代高效、统一AI架构的重要催化剂。

以上就是Andrej Karpathy 评 DeepSeek-OCR 论文:图像输入可能成为大语言模型新方向的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号