7 月 30 日,ACL(国际计算语言学年会)揭晓了 2025 年度获奖论文名单。令人瞩目的是,中国作者在这些论文中的占比突破 51%,远超美国的 14%,彰显出中国在自然语言处理领域的强劲势头。

其中,由 DeepSeek 创始人梁文锋担任通讯作者、联合北京大学等机构完成的一篇论文不仅斩获 Best Paper 大奖,其技术成果也迅速引发广泛关注。

在会议现场分享环节,论文第一作者袁境阳透露,该研究成功将模型上下文长度扩展至惊人的 100 万 tokens,并计划集成到 DeepSeek 即将推出的下一代前沿模型中。值得一提的是,袁境阳在撰写这篇论文时仍为 DeepSeek 的实习生身份。

当前,长上下文建模被视为推动大模型进化的关键路径,但传统注意力机制因计算复杂度随序列增长呈平方级上升,导致推理延迟严重。理论分析显示,在处理 64k 长度上下文时,softmax 注意力运算可占据整体延迟的 70% 至 80%,凸显出对高效替代方案的迫切需求。

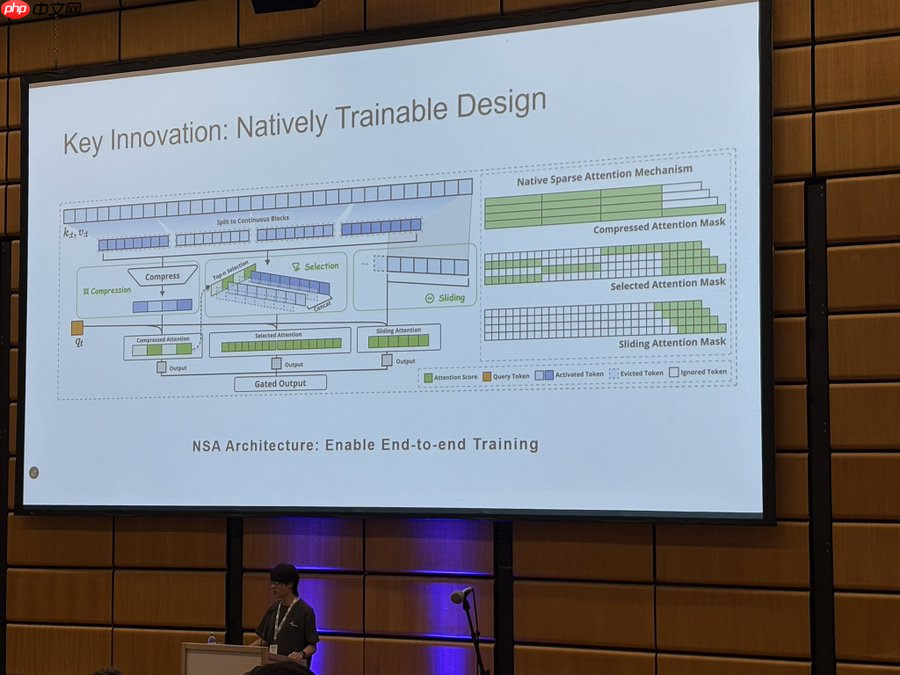

为此,团队提出 NSA(Natively trainable Sparse Attention),一种原生可训练的稀疏注意力架构。该机制融合算法创新与硬件协同设计,旨在实现高性能且高效的长序列建模。

NSA 采用动态分层稀疏策略,结合粗粒度 token 压缩与细粒度 token 选择,在保障全局语义感知的同时保留局部细节精度,有效应对长文本中的信息密度不均问题。

NSA 的核心突破体现在两大方面:

一是通过算术强度均衡的算法设计显著提升运行效率,并针对现代 GPU 架构进行底层优化。其改进的块式稀疏注意力结构提高了张量核心利用率和内存访问效率,确保计算负载均衡;同时配备高效的反向传播算子,支持稳定端到端训练,大幅降低预训练所需算力。

二是实现了真正意义上的硬件友好型稀疏化。无论是预填充阶段还是自回归解码过程,NSA 都能充分利用硬件并行能力,缓解内存带宽压力和调度开销,从而将理论上的计算节省转化为实际的速度增益。

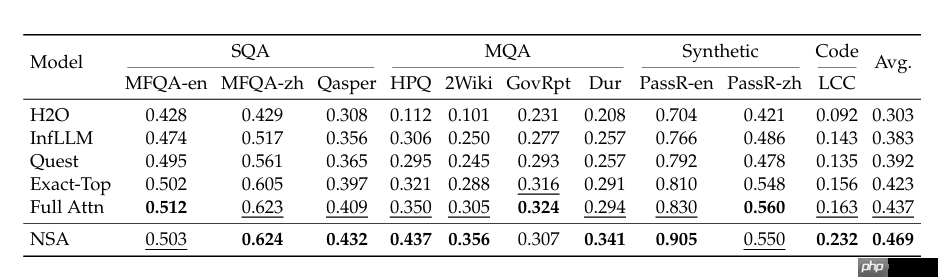

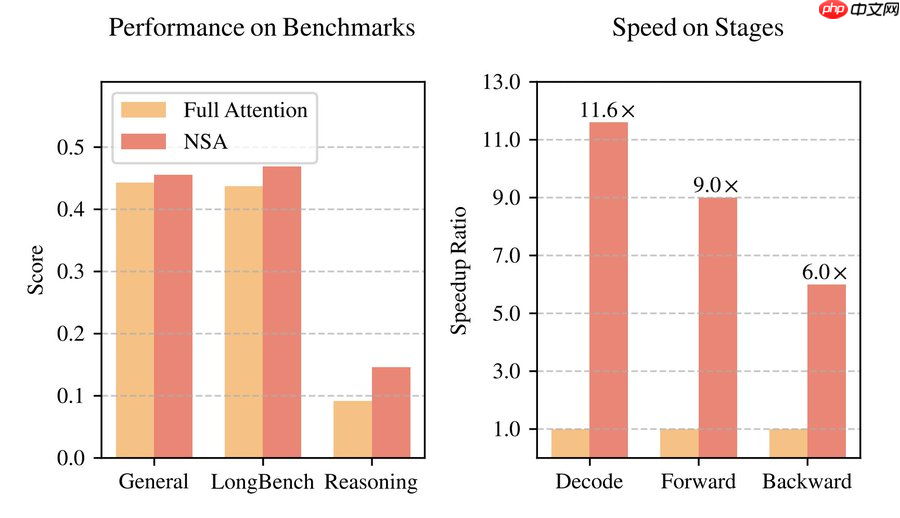

研究团队在一个参数总量达 270 亿(激活参数约 30 亿)的 Transformer 主干网络上,使用 2600 亿 token 数据完成预训练,并从通用语言理解、长文本任务及思维链推理三个维度全面评估 NSA 性能。

实验结果显示,NSA 在多数指标上优于全注意力基线模型。在九项评测任务中,有七项取得领先成绩。尤其在涉及复杂推理的场景下,优势更为明显:多跳问答 HPQ 和 2Wiki 分别提升 0.087 和 0.051;代码理解 LCC 超出基线 0.069;段落检索 PassR-en 提升 0.075。

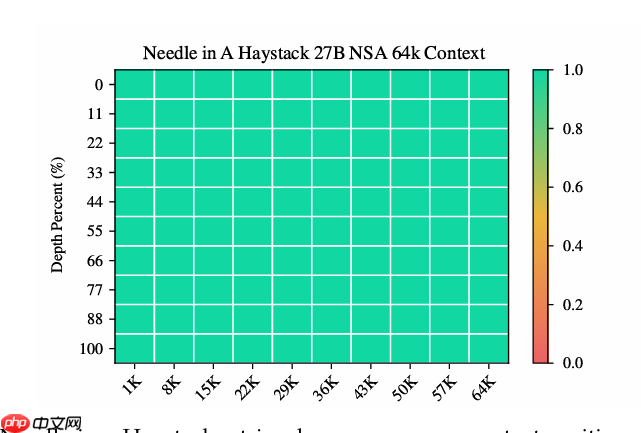

更引人注目的是,在 64k 上下文下的“大海捞针”测试中,NSA 实现了100% 的精准定位能力,展现出卓越的信息保持与检索性能。

此外,NSA 在速度方面实现跨越式进步。与基于 Triton 实现的 FlashAttention-2 相比,在 A100 多卡系统中:

且随着序列增长,加速效果愈发显著,体现出强大的可扩展性。

为进一步验证其下游任务适配能力,团队还开展了强化版数学推理训练实验。通过知识蒸馏方式,利用 DeepSeek-R1 的 32k 长度推理轨迹对 NSA 模型进行监督微调,构建出 NSA-R 模型,并与全注意力版本对比。

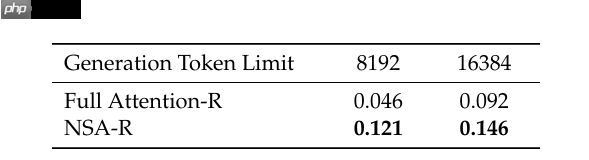

在极具挑战性的 AIME 24 数学竞赛基准测试中,NSA-R 在 8k 与 16k 上下文长度下均超越全注意力模型,证明其不仅能维持深度推理所需的上下文连贯性,还能避免因稀疏化导致的知识遗忘。

这表明,NSA 的原生稀疏训练机制有助于模型自动学习最优注意力路径,在复杂逻辑推导任务中具备更强潜力。

尽管该论文早在今年 2 月便已公开(arXiv:2502.11089),但截至目前,NSA 技术尚未出现在任何已发布的 DeepSeek 模型中。不过据袁境阳透露,这项技术将被应用于 DeepSeek 下一代主力模型,极大激发外界对 DeepSeek V4 的期待。

与此同时,关于 DeepSeek R2 是否会推迟发布的消息也在业内持续发酵。此前曾有传闻称该模型已在 Hugging Face 泄露,引发热议。虽官方未予回应,但有消息称,由于创始人梁文锋对当前性能尚不满意,研发团队仍在持续打磨。

也有观点认为,R2 或将等待 V4 发布后再正式推出——毕竟 V3 可能已触及现有架构的极限,而 NSA 所代表的新一代核心技术,或将彻底重塑 DeepSeek 的产品路线图。

参考链接:

https://www.php.cn/link/42751fb669b1fe8b899c5a70deb061d8

声明:本文为 AI 前线整理,不代表平台观点,未经许可禁止转载。

以上就是DeepSeek V4 借实习生获奖论文“起飞”?梁文峰剑指上下文:处理速度提 10 倍、要“完美”准确率的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号