答案是利用Goroutine和Channel实现并发爬虫。通过为每个URL创建Goroutine执行fetch函数,并使用Channel传递结果,实现高效并发抓取,提升爬虫性能。

在Golang中实现并发爬虫,核心在于利用Goroutine和Channel高效发起网络请求并处理响应。Go语言天生适合并发编程,通过轻量级的Goroutine和通信机制Channel,可以轻松构建高性能的爬虫系统。

使用Goroutine发起并发请求

每个网页抓取任务可以封装为一个函数,用Goroutine并发执行。这样能同时处理多个URL,显著提升抓取速度。

示例:启动多个Goroutine抓取不同页面

func fetch(url string, ch chan string) {

resp, err := http.Get(url)

if err != nil {

ch <- fmt.Sprintf("Error: %s", url)

return

}

defer resp.Body.Close()

ch <- fmt.Sprintf("Success: %s (status: %d)", url, resp.StatusCode)

}

// 主函数中并发调用

urls := []string{"https://www.php.cn/link/b05edd78c294dcf6d960190bf5bde635", "https://www.php.cn/link/4d2fe2e8601f7a8018594d98f28706f2", ...}

ch := make(chan string, len(urls))

for _, url := range urls {

go fetch(url, ch)

}

for range urls {

fmt.Println(<-ch)

}

用Channel控制并发数量

无限制地开启Goroutine可能导致目标服务器压力过大或本地资源耗尽。使用带缓冲的Channel作为信号量,可有效控制最大并发数。

立即学习“go语言免费学习笔记(深入)”;

方法是创建一个容量固定的Channel,在每个任务开始前获取令牌,完成后释放。

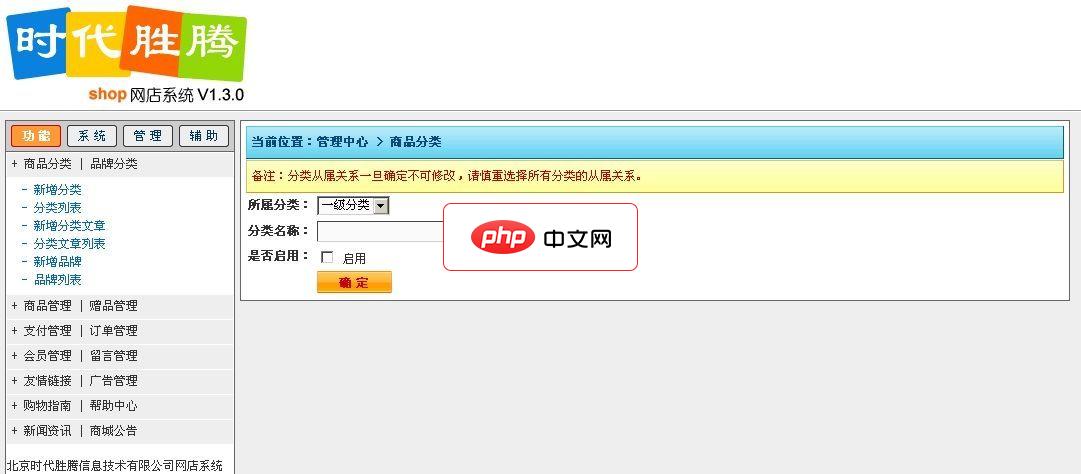

dmSOBC SHOP网店系统由北京时代胜腾信息技术有限公司(http://www.webzhan.com)历时6个月开发完成,本着简单实用的理念,商城在功能上摒弃了外在装饰的一些辅助功能,尽可能的精简各项模块开发,做到有用的才开发,网店V1.0.0版本开发完成后得到了很多用户的使用并获得了好评,公司立即对网店进行升级,其中包括修正客户提出的一些意见和建议,现对广大用户提供免费试用版本,如您在使用

semaphore := make(chan struct{}, 10) // 最多10个并发

ch := make(chan string, len(urls))

for _, url := range urls {

go func(u string) {

semaphore <- struct{}{} // 获取令牌

resp, err := http.Get(u)

result := ""

if err != nil {

result = "Failed"

} else {

result = fmt.Sprintf("Status: %d", resp.StatusCode)

resp.Body.Close()

}

ch <- result

<-semaphore // 释放令牌

}(url)

}

结合Context管理超时与取消

网络请求应设置超时机制,避免长时间阻塞。使用context.WithTimeout可为请求设定最长等待时间。

将Context传入http.Get,能在超时后自动中断请求。

client := &http.Client{

Timeout: 10 * time.Second,

}

ctx, cancel := context.WithTimeout(context.Background(), 5*time.Second)

defer cancel()

req, _ := http.NewRequestWithContext(ctx, "GET", url, nil)

resp, err := client.Do(req)

解析HTML与数据提取

抓取到页面内容后,常用goquery或直接使用net/html进行解析。goquery语法类似jQuery,更易上手。

示例:提取页面标题

doc, err := goquery.NewDocumentFromReader(resp.Body)

if err != nil {

log.Fatal(err)

}

title := doc.Find("title").Text()

fmt.Println("Title:", title)

基本上就这些。合理使用Goroutine、Channel和Context,就能写出稳定高效的并发爬虫。注意遵守robots.txt,控制请求频率,避免对目标网站造成负担。并发爬虫虽强,也需文明使用。