首先配置LocoySpider新建“百科知识采集”任务并输入目标URL,接着通过智能模式分析页面结构,提取标题、信息框、正文段落及参考资料;针对动态加载内容启用浏览器模拟或JS脚本触发,对分页内容添加多URL模板;随后清洗数据去除HTML标签与冗余信息,结构化映射至数据库字段,最终设置JSON或Excel导出格式,并通过随机User-Agent、代理IP池和低频请求规避反爬机制,确保完整获取百科条目数据。

如果您需要从百科类网站(如百度百科、维基百科)采集结构化的知识条目,但发现数据抓取不完整或规则失效,则可能是由于网页结构复杂或动态加载所致。以下是针对LocoySpider进行百科知识采集的详细步骤和结构解析方法:

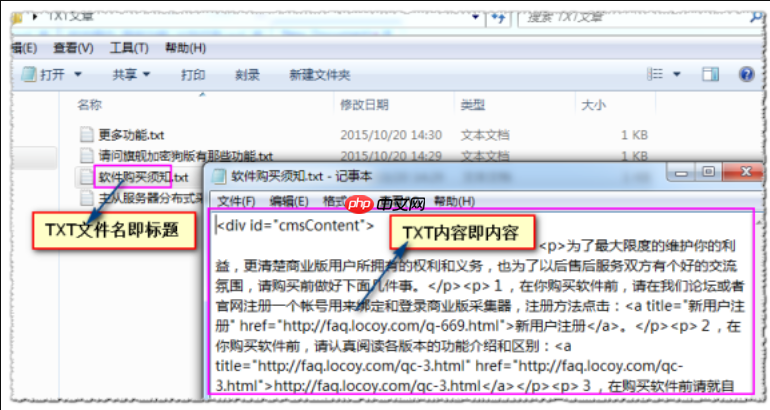

此步骤用于创建并初始化一个针对百科页面的采集任务,确保软件能正确访问目标网址并识别基本页面结构。

1、打开LocoySpider软件,点击“新建任务”,在任务名称栏输入“百科知识采集”。

2、在“起始地址”中输入目标百科网站的词条URL,例如:https://baike.baidu.com/item/人工智能。

3、选择“智能模式”或“向导模式”,让软件自动分析页面结构,并识别标题、正文、信息框等主要区域。

4、点击“保存”完成基础任务配置,进入下一步规则设置。

百科页面通常包含固定的HTML结构,如标题区、信息框(infobox)、目录、段落正文和参考资料等。准确识别这些区块是成功采集的关键。

1、在任务编辑界面,切换到“列表页”或“内容页”规则设置,使用鼠标框选词条标题区域,软件将自动生成XPath或CSS选择器规则。

2、单独提取信息框内容:找到百科右侧或顶部的信息表格,框选其整体区域,命名为“info_box”,设置为“表格型”字段以便结构化存储。

3、对于正文段落,选择第一个段落后,启用“循环提取”功能,确保所有连续段落都能被捕获。

4、添加“参考资料”和“相关词条”区域的提取规则,分别命名为“references”和“related_terms”,以完整保留知识关联性。

部分百科内容通过AJAX加载或多标签页展示(如“发展历程”、“应用领域”等子页面),需模拟点击或构造请求以获取全部数据。

1、若发现某些内容未被抓取,进入“高级采集”设置,启用“浏览器模拟”功能,选择内置的IE或Chromium内核渲染页面。

2、对于多标签页内容,手动添加额外的URL模板,例如:https://baike.baidu.com/item/人工智能?view=timeline,并为每个子页面设置独立的内容提取规则。

3、使用“自定义JS脚本”功能,在页面加载完成后执行点击操作,触发JavaScript加载隐藏内容。

采集后的原始数据可能包含HTML标签、冗余空格或编码乱码,需进行清洗才能形成可用的知识条目。

1、在“数据处理”环节,添加“过滤HTML标签”规则,清除所有、 2、使用“正则替换”功能统一日期格式、去除广告文本或无关链接。 3、将提取的字段映射到数据库表结构中,例如创建名为“encyclopedia_entries”的MySQL表,包含title、content、info_box_json、references等字段。 4、设置导出格式为JSON或Excel,便于后续导入知识图谱系统或CMS平台。 大型百科网站常设有IP频率限制、验证码或User-Agent检测等防护措施,需配置相应策略绕过封锁。 1、在“请求设置”中启用“随机User-Agent”,从预设列表中轮换不同浏览器标识。 2、配置代理IP池,导入可用的HTTP或SOCKS5代理,设置每N次请求更换一次IP。 3、调整采集线程数至1-2个,降低请求频率,避免被服务器判定为异常流量。 4、若遇到验证码,集成第三方OCR服务接口,在采集流程中自动识别并填写验证码。五、应对反爬虫机制

以上就是LocoySpider如何采集百科知识条目_LocoySpider百科采集的结构解析的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号