FG-CLIP 2是什么

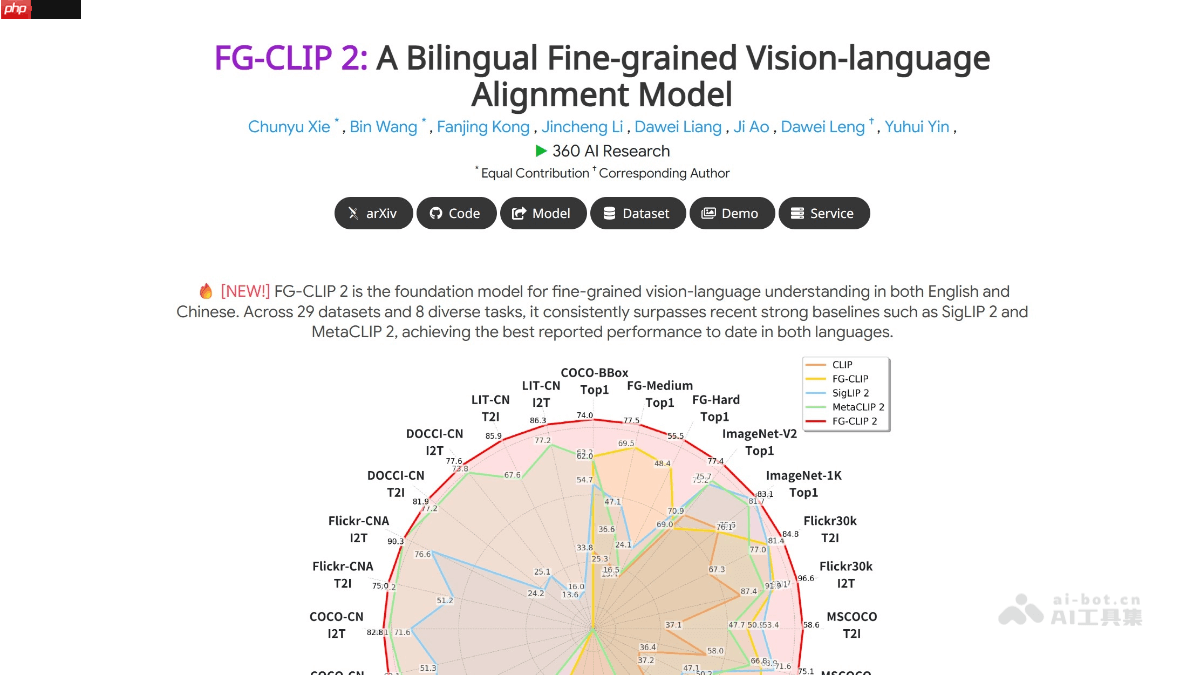

fg-clip 2是由360推出的开源双语细粒度视觉语言对齐模型,专为实现图像与文本之间的高精度语义匹配而设计。该模型在视觉语言理解方面实现了重要突破,尤其在中英文双语环境下表现卓越。其采用层次化对齐架构,结合全局语义理解和局部细节建模,逐步增强模型对图像内容的深层解析能力。通过引入动态注意力机制,模型能够智能识别并聚焦图像中的关键区域,有效应对复杂多样的视觉语言任务。在多项国际权威评测中,fg-clip 2性能超越google的siglip 2和meta的metaclip 2,成为当前全球领先的视觉语言模型之一。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

FG-CLIP 2的主要功能

-

细粒度视觉语言理解:可精确捕捉图像中物体的属性、姿态及空间关系,显著提升细粒度识别能力。

-

双语原生支持:在中文和英文任务上均具备强大表现力,真正实现双语均衡处理。

-

层次化对齐结构:融合宏观场景理解与微观元素分析,全面增强图像语义解析深度。

-

动态注意力机制:自动定位图像中的重要区域,提升复杂语义匹配的准确性。

-

优化双语协同训练策略:缓解中英文理解偏差问题,提高跨语言任务的整体性能。

-

卓越的基准测试成绩:在29项公开评测任务中全面领先于SigLIP 2和MetaCLIP 2等主流模型。

-

毫秒级响应能力:延续显式双塔架构设计,支持图像与文本特征预计算与缓存,满足高并发实时需求。

-

自适应输入分辨率:具备动态分辨率处理能力,灵活适配不同尺寸图像输入。

-

全面开源支持:开放源代码、模型权重及详细训练数据集,便于学术研究与工程应用。

FG-CLIP 2的技术原理

-

层次化语义对齐:通过全局语义对齐与局部细粒度学习相结合,逐层深化视觉语言关联。

-

动态注意力网络:利用注意力机制动态聚焦图像关键部位,强化细节感知能力。

-

双语协同优化策略:设计平衡的训练方法,提升中英文语义空间的一致性。

-

大规模多模态训练数据:基于海量中英文图文对进行训练,增强模型的语言泛化能力。

-

细粒度监督信号引入:采用区域-文本匹配、长文本描述建模等方式加强精细化学习。

-

文本内模态对比损失:通过对比学习区分语义相近的文本描述,提升判别精度。

-

难负样本增强训练:使用大模型生成的“难负样本”进行训练,进一步拉大正负样本差距。

-

动态分辨率处理机制:支持变尺寸输入,提升模型在实际场景中的适应性。

FG-CLIP 2的项目地址

FG-CLIP 2的应用场景

-

家庭服务机器人:精准解析复杂指令,如“请取走沙发上屏幕破裂的黑色手机”,提升人机交互智能化水平。

-

智能安防监控:快速检索特定目标,例如“查找穿红色外套、背双肩包的人员”,提高监控系统的响应效率。

-

电子商务平台:优化以文搜图、跨语言商品检索功能,降低人工标注成本,提升用户体验。

-

自动驾驶系统:准确识别道路环境细节,如“检测前方是否有掉落的障碍物”,增强行车安全性。

-

医学影像辅助诊断:帮助医生定位病灶区域,如“识别肺部CT中的结节区域”,提升诊疗效率。

-

智慧教育工具:应用于教学辅助系统,如“识别教材插图中的动植物并提供说明”,丰富教学形式与内容。

以上就是FG-CLIP 2— 360开源的双语细粒度视觉语言对齐模型的详细内容,更多请关注php中文网其它相关文章!

FG-CLIP 2的主要功能

FG-CLIP 2的主要功能