☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

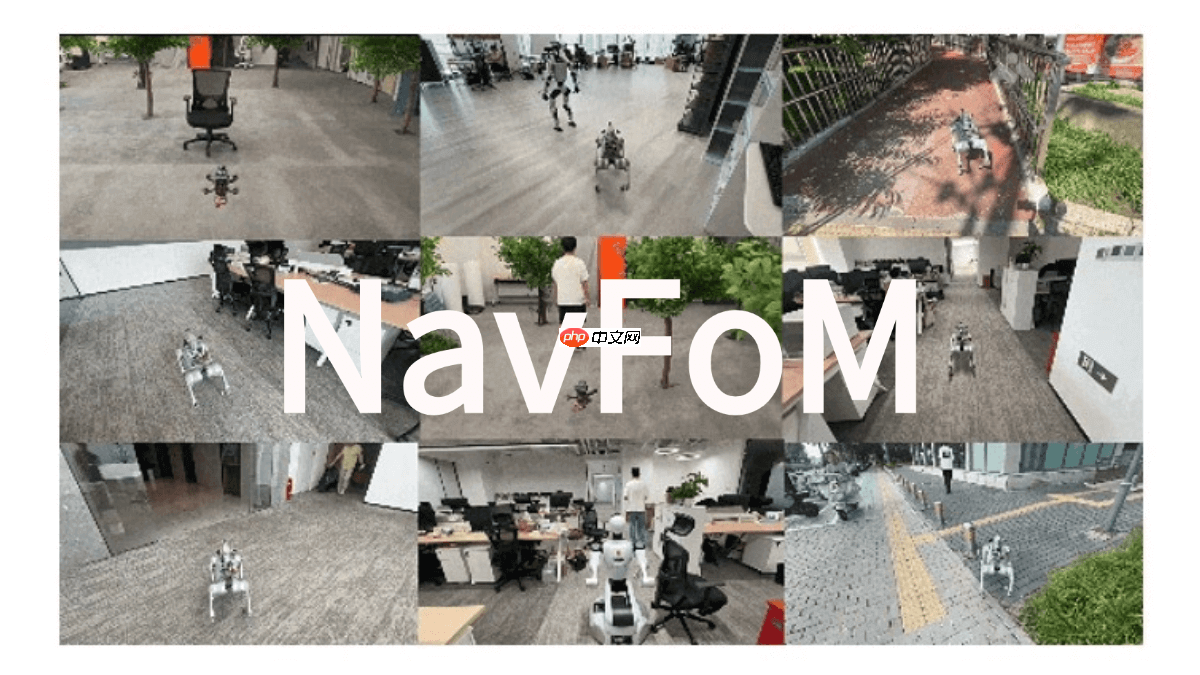

NavFoM(Navigation Foundation Model)是由银河通用携手北京大学、阿德莱德大学、浙江大学等科研团队共同推出的全球首个跨本体全域环视导航基座大模型。该模型具备强大的泛化能力,可在室内外多种环境中实现零样本部署,无需预先建图或额外数据采集即可运行。NavFoM支持自然语言指令驱动的目标跟随与自主导航任务,能够快速适配机器狗、轮式人形机器人、无人机、智能汽车等多种实体形态。其核心技术采用TVI Tokens与BATS策略,构建了全新的端到端通用范式:“视频流 + 文本指令 → 动作轨迹”,实现了从感知理解到行动决策的无缝衔接。

NavFoM的核心特性

- 全场景通用性:适用于室内家居、办公空间以及室外街道、园区等多样化环境,能够在未训练过的场景中直接运行,展现出卓越的环境适应能力。

- 多任务融合能力:支持基于自然语言指令的目标追踪、路径规划和自主避障等多种导航子任务,灵活响应不同语义指令。

- 跨本体兼容设计:可高效迁移至机器狗、轮式人形、腿式机器人、无人机及自动驾驶车辆等不同结构和尺寸的移动平台,降低定制化开发成本。

-

关键技术突破:

- TVI Tokens(时序-视角索引标记):通过引入时间与视角维度的结构化标记,增强模型对动态环境变化和空间方位的理解能力。

- BATS策略(算力感知标记采样):在计算资源受限条件下,智能选择关键信息标记进行处理,保障推理效率与决策质量的平衡。

- 统一架构范式:摒弃传统模块化导航系统的拼接模式,提出“视觉输入+语言指令→动作输出”的一体化框架,实现真正的端到端导航闭环。

- 大规模数据支撑:构建了包含约八百万条跨任务、跨设备导航数据与四百万条开放域问答样本的综合性训练集,显著提升模型的泛化性和语义理解能力。

技术实现机制

- TVI Tokens机制:将连续视频流中的每一帧按时间顺序与观测视角进行编码标记,使模型能有效捕捉运动趋势与空间关系,提升对动态场景的推理能力。

- BATS采样策略:根据硬件算力预算动态调整Token处理数量,在保证导航性能的同时优化计算开销,适合边缘设备部署。

- 端到端映射架构:以原始视频流和文本指令为输入,直接输出控制动作序列,省去中间环节如SLAM、路径规划器等模块依赖,简化系统复杂度。

- 跨任务预训练数据集:整合来自多种机器人平台、不同导航任务的真实与仿真数据,涵盖城市道路、室内走廊、复杂地形等丰富场景,强化模型鲁棒性。

应用前景与落地场景

- 服务机器人:在商场、机场、医院等公共场所,机器人可通过语音指令完成带路、巡检、目标跟随等任务,提升智能化服务水平。

- 自动驾驶系统:赋能智能汽车理解自然语言导航指令,结合实时视觉感知实现更人性化、高安全性的驾驶决策。

- 无人飞行器:助力无人机在森林、山区、灾区等复杂环境中自主飞行执行搜救、测绘、配送等任务。

- 人形机器人控制:支持双足、轮式等人形机器人在多变地形中稳定行走并完成交互式导航任务。

- 开发者生态拓展:作为通用导航基座模型,开发者可基于NavFoM进行微调或后训练,快速构建面向特定行业应用的专用导航系统。

项目开源信息

目前官方尚未公开navfom的代码仓库及模型下载地址。