东北大学“小牛翻译”团队近期推出了以中文和英文为双核心的多语言翻译模型 lmt(large-scale multilingual translation)。该模型支持60种语言、234个翻译方向,涵盖英↔59种语言及中↔58种语言的互译,覆盖全球主要语系与广泛使用的语言。

支持的语言分类如下:

| **语言资源** | **语言列表** |

| 高资源13种 | 阿拉伯语(ar)、英语(en)、西班牙语(es)、德语(de)、法语(fr)、意大利语(it)、日语(ja)、荷兰语(nl)、波兰语(pl)、葡萄牙语(pt)、俄语(ru)、土耳其语(tr)、中文(zh) |

| 中资源18种 | 保加利亚语(bg)、孟加拉语(bn)、捷克语(cs)、丹麦语(da)、现代希腊语(el)、波斯语(fa)、芬兰语(fi)、印地语(hi)、匈牙利语(hu)、印度尼西亚语(id)、韩语(ko)、挪威语(no)、罗马尼亚语(ro)、斯洛伐克语(sk)、瑞典语(sv)、泰语(th)、乌克兰语(uk)、越南语(vi) |

| 低资源29种 | 阿姆哈拉语(am)、阿塞拜疆语(az)、藏语(bo)、希伯来语(he)、克罗地亚语(hr)、亚美尼亚语(hy)、冰岛语(is)、爪哇语(jv)、格鲁吉亚语(ka)、哈萨克语(kk)、高棉语(km)、柯尔克孜语(ky)、老挝语(lo)、中国蒙古语(mn\_cn)、马拉地语(mr)、马来语(ms)、缅甸语(my)、尼泊尔语(ne)、普什图语(ps)、僧伽罗语(si)、斯瓦希里语(sw)、泰米尔语(ta)、泰卢固语(te)、塔吉克语(tg)、他加禄语(tl)、维吾尔语(ug)、乌尔都语(ur)、乌兹别克语(uz)、粤语(yue) |

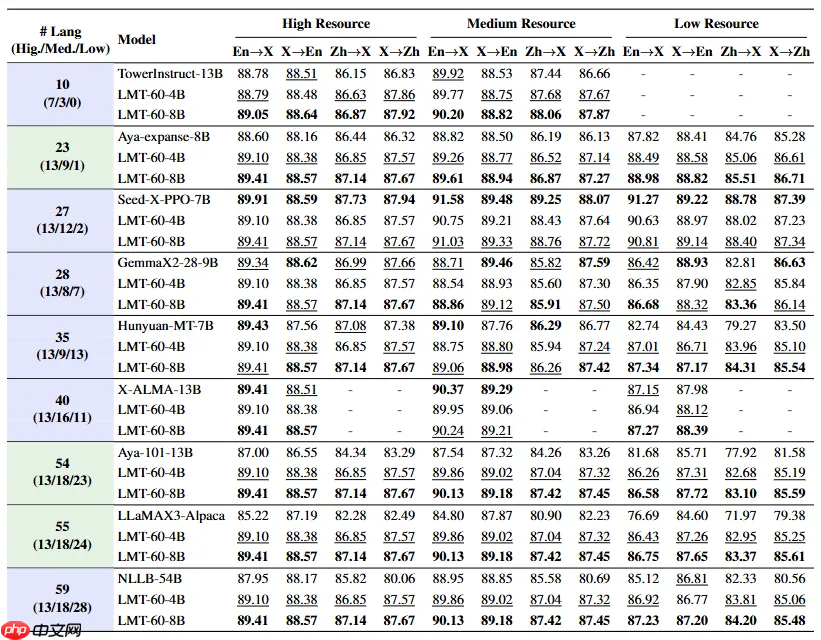

在 FLORES-200 基准测试中,LMT 在同等规模的多语言模型中达到了最先进的性能水平(SOTA),展现出广泛的语种覆盖能力和全面的翻译表现力。

LMT基于Qwen3系列架构构建,采用主流的两阶段训练策略:

持续预训练(Continued Pre-training, CPT):在大规模混合单语与双语语料上进行继续训练,全面提升模型的多语言理解与翻译能力。CPT阶段使用约 90B tokens 的数据,各语言方向按1:1:1比例混合单语、中文为中心的双语和英文为中心的双语数据。

监督式微调(Supervised Fine-tuning, SFT):利用高质量人工标注的平行语料进行指令化微调,进一步优化翻译质量。SFT所用数据集包括FLORES-200 Dev、NTREX-128、SMol、WMT14-23、IWSLT17-24等公开权威测试集,总计约 567K 条样本,覆盖 117 个翻译方向,每个方向包含约 3K–20K 条数据。

目前,LMT已全面开源,提供四种参数规模版本:0.6B / 1.7B / 4B / 8B,满足不同场景下的部署需求。

GitHub 项目地址: https://www.php.cn/link/f9a7f25376f10e98cf7c33c582d2c3b8

Hugging Face 模型仓库:

- https://www.php.cn/link/58c0c5010ab781e7e188e88c7270702b

- https://www.php.cn/link/9d635acac17e5e2d78b10ac123bb2a97

- https://www.php.cn/link/812030f5df0d7e38686fee76cb224528

- https://www.php.cn/link/12412472ffad7100e8d82937353d77a0287

源码下载链接:点击获取