1、通过设置max_tokens、temperature和top_p参数可控制生成文本长度与多样性;2、需配置response_format为JSON模式并明确提示以实现结构化输出;3、VL模型应启用vl_high_resolution_images并正确传入图像数据;4、使用LoRA微调时设置r秩和AdamW优化器以高效训练。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

如果您在使用通义大模型时,发现输出结果不符合预期或需要针对特定任务进行优化,则可能是由于模型参数未正确配置。以下是设置通义大模型参数的详细方法:

本文运行环境:MacBook Pro,macOS Sonoma

一、设置基础生成参数

调整基础生成参数可以控制模型输出的长度、随机性和多样性,适用于大多数文本生成场景。

1、设置max_tokens参数以限制生成文本的最大长度,避免输出过长或截断。例如,将其设置为512可保证生成内容在合理范围内。

2、通过调整temperature参数来控制输出的随机性。较低的值(如0.1)会使输出更确定和一致,较高的值(如1.0)则增加创造性与多样性。

3、启用top_p(核采样)参数进行动态词汇选择,通常设置为0.9,使模型在累积概率最高的词汇中进行采样,平衡流畅性与新颖性。

二、配置响应格式化参数

当需要结构化输出(如JSON格式)时,必须明确指定响应格式,以便下游系统直接解析。

1、在API请求体中添加response_format参数,并将其设置为{"type": "json_object"}以启用JSON模式输出。

2、确保输入提示(prompt)中明确要求返回JSON格式的内容,例如:“请以JSON格式返回以下信息……”

3、验证API返回结果是否符合JSON标准格式,避免因缺少引号或括号导致解析失败。

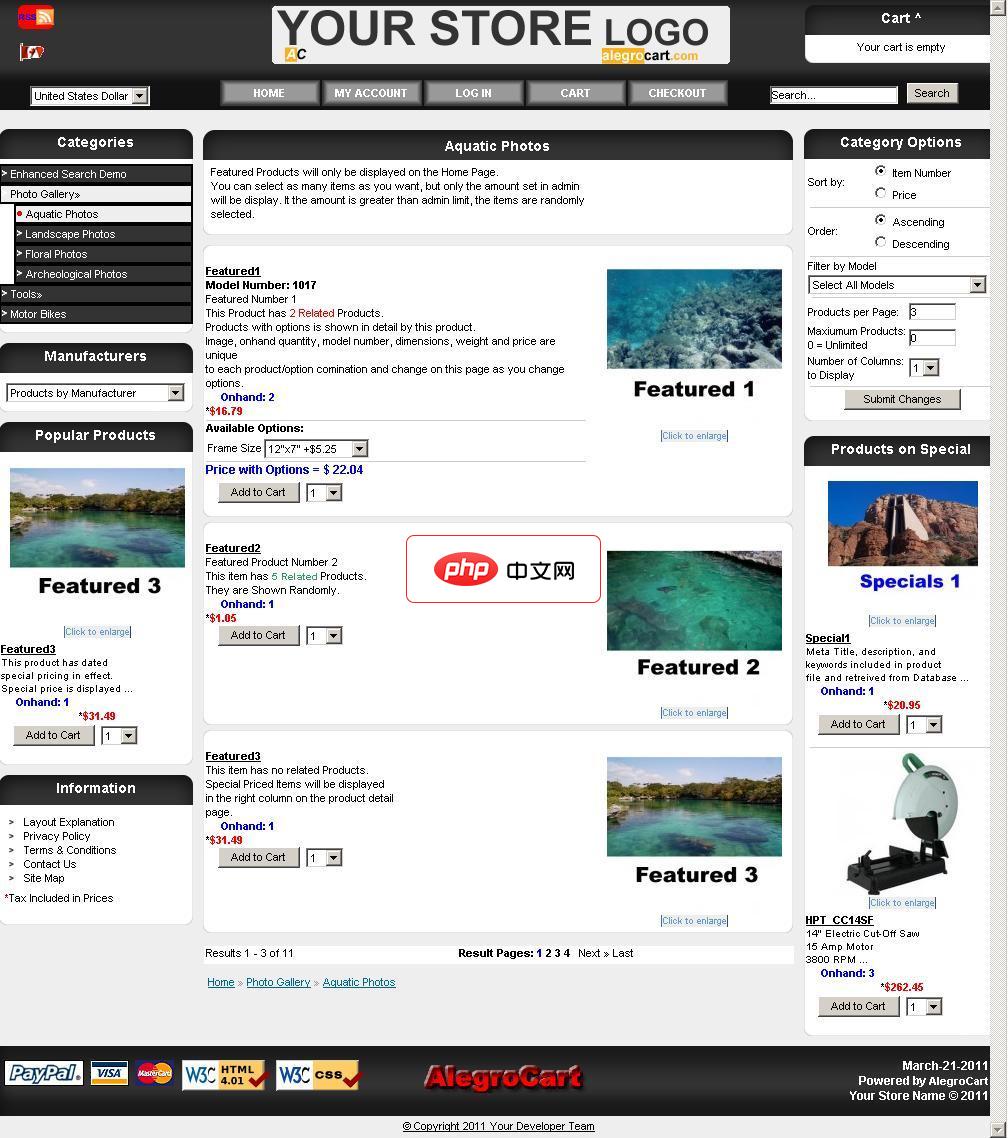

AlegroCart新功能:维类:包括在这两种线性长宽高或面积或体积长波产品尺寸允许与期权产品:让产品/期权组合独特的数量,尺寸,图像和型号。选择店铺标识管理 图片放大镜:显示一个图片放大上空盘旋时,产品形象弹出框。自定义错误报告:设置在管理员启用。 开发者只可以显示详细的信息。错误信息都写入到错误日志文件每天可以通过电子邮件发送给管理员。仓库皮卡航运模块:允许客户指定产品在商店的位置回升。增加了

三、调整视觉相关参数(适用于VL模型)

对于支持图像输入的通义千问-VL系列模型,需配置专用参数以处理高分辨率图像并提升理解精度。

1、将vl_high_resolution_images参数设置为True,以启用对高分辨率图像的解析能力,确保细节信息不丢失。

2、在输入数据中正确传递图像URL列表至"images"字段,并配合文本提示共同输入。

3、根据实际需求设置"n"参数决定生成结果数量,例如设置为1表示每次请求仅生成一条响应。

四、应用低秩适应(LoRA)微调参数

使用LoRA技术可在不修改原始模型权重的情况下进行高效微调,大幅降低计算资源消耗。

1、冻结预训练模型的主干参数,插入低秩矩阵A和B用于替代原有权重更新过程。

2、定义r参数(秩),控制低秩矩阵的维度大小,一般从8或16开始尝试。

3、配置优化器参数,推荐使用AdamW,设置初始学习率在1e-4至5e-4之间,并结合梯度裁剪(阈值设为1.0)防止训练不稳定。