countvectorizer官方文档。

将一个文档集合向量化为为一个计数矩阵。

如果不提供一个先验字典,不使用分析器做某种特征选择,那么特征的数量将等于通过分析数据发现的词汇量。

两种方法:1.可以不分词直接投入模型;2.可以先将中文文本进行分词。

两种方法产生的词汇会非常不同。在后面会具体给出示范。

立即学习“Python免费学习笔记(深入)”;

import jieba

import re

from sklearn.feature_extraction.text import CountVectorizer

#原始数据

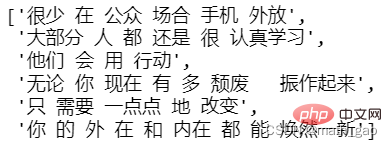

text = ['很少在公众场合手机外放',

'大部分人都还是很认真去学习的',

'他们会用行动来',

'无论你现在有多颓废,振作起来',

'只需要一点点地改变',

'你的外在和内在都能焕然一新']

#提取中文

text = [' '.join(re.findall('[\u4e00-\u9fa5]+',tt,re.S)) for tt in text]

#分词

text = [' '.join(jieba.lcut(tt)) for tt in text]

text

#构建模型 vectorizer = CountVectorizer() #训练模型 X = vectorizer.fit_transform(text)

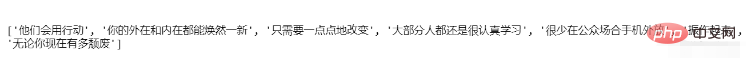

#所有文档汇集后生成的词汇 feature_names = vectorizer.get_feature_names() print(feature_names)

不分词生成的词汇

如果您是新用户,请直接将本程序的所有文件上传在任一文件夹下,Rewrite 目录下放置了伪静态规则和筛选器,可将规则添加进IIS,即可正常使用,不用进行任何设置;(可修改图片等)默认的管理员用户名、密码和验证码都是:yeesen系统默认关闭,请上传后登陆后台点击“核心管理”里操作如下:进入“配置管理”中的&ld

0

0

分词后生成的词汇

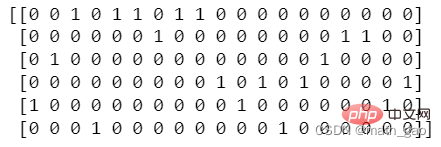

#每个文档相对词汇量出现次数形成的矩阵 matrix = X.toarray() print(matrix)

#计数矩阵转化为DataFrame df = pd.DataFrame(matrix, columns=feature_names) df

print(vectorizer.vocabulary_)

以上就是如何使用Python的sklearn中的CountVectorizer?的详细内容,更多请关注php中文网其它相关文章!

python怎么学习?python怎么入门?python在哪学?python怎么学才快?不用担心,这里为大家提供了python速学教程(入门到精通),有需要的小伙伴保存下载就能学习啦!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号