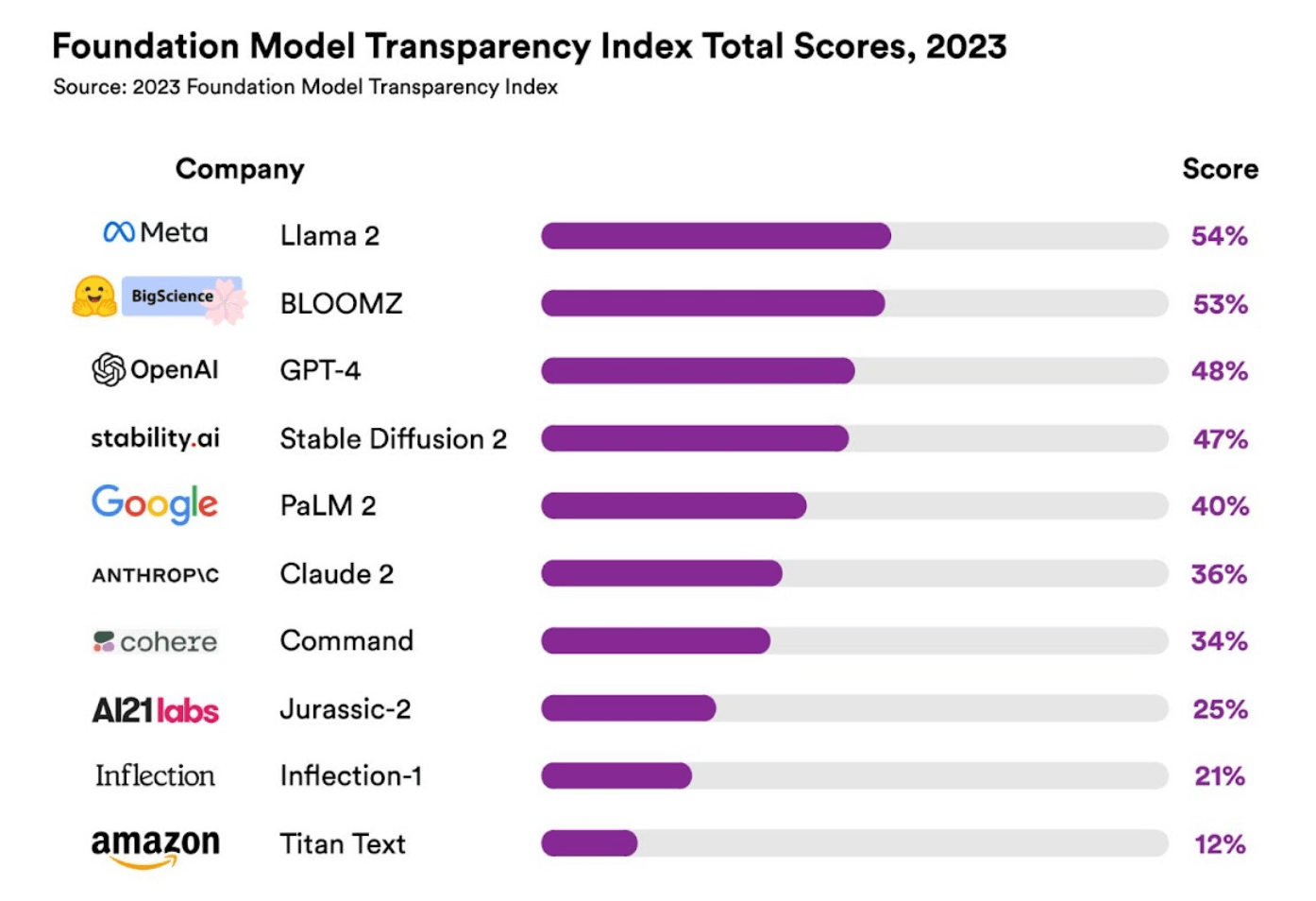

it之家 10 月 20 日消息,斯坦福大学日前发布了 ai 基础模型“透明度指标”,其中显示指标最高的是 meta 的 lama 2,但相关“透明度”也只有 54%,因此研究人员认为,市面上几乎所有 ai 模型,都“缺乏透明度”。

据悉,这一研究是由 HAI 基础模型研究中心(CRFM)的负责人 Rishi Bommasani 所主导,调查了海外最流行的 10 款基础模型:

Meta 的 Llama 2、 BigScience 的 BloomZ、 OpenAI 的 GPT-4、 Stability AI 的 Stable Diffusion、 Anthropic PBC 的 Claude、 谷歌的 PaLM 2、 Cohere 的 Command、 AI21 Labs 的 Jurassic-2、 Inflection AI 的 Inflection、 亚马逊的 Titan。

Rishi Bommasani 认为,“缺乏透明度”一直是 AI 行业所面临的问题,在具体模型“透明度指标”方面,IT之家发现,相关评估内容主要围绕“模型训练数据集版权”、“训练模型所用的运算资源”、“模型生成内容的可信度”、“模型自身能力”、“模型被诱导生成有害内容的风险”、“使用模型的用户隐私性”等展开,共计 100 项。

最终调查情况显示,Meta 的 Lama 2 以 54% 的透明度居冠,而 OpenAI 的 GPT-4 透明度只有 48%,谷歌的 PaLM 2 则以 40% 排名第五。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

▲ 图源 斯坦福大学

在具体指标中,十大模型得分表现均“最好”的是“模型基本信息”(Model Basics),这一评估内容主要包含“模型训练上是否准确介绍了模型的模式、规模、架构”,平均透明度为 63%。表现最差的则是影响(Impact),主要评估基础模型是否会“调取用户信息进行评估”,平均透明度只有 11%。

CRFM 主任 Percy Liang 表示,商业基础模型的“透明度”对于推动 AI 立法,及相关产业、学术界而言,非常重要。

Rishi Bommasani 则表示,较低的模型透明度让企业更难知道它们能否安全地依赖相关模型,也难以令研究人员依靠这些模型来做研究。

Rishi Bommasani 最终认为,上述十大基础模型在透明度方面都“不及格”,虽然 Meta 的 Llama 2 得分最高,但并不能满足外界需求,“模型透明度最少要达到 82%,才能被外界认可”。

以上就是斯坦福大学发布AI基础模型透明度指标,Llama 2居首但“不及格”的详细内容,更多请关注php中文网其它相关文章!

每个人都需要一台速度更快、更稳定的 PC。随着时间的推移,垃圾文件、旧注册表数据和不必要的后台进程会占用资源并降低性能。幸运的是,许多工具可以让 Windows 保持平稳运行。

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号