antoolsprov3.0的最新版本发布了重大更新,不仅完美支持deepseek官方api和硅基流动api,还引入了强大的本地ollama支持。面对deepseek官网经常出现的拥堵问题和token使用限制,本地部署方案的作用显得尤为重要。

一、本地部署方案:Ollama轻松搭建

令人振奋的是,部署的门槛并不高。只要有一台配备16G内存和i7处理器的普通电脑,就能轻松运行14B级别的模型,完全满足日常使用需求。

Ollama作为一款专业的LLM管理工具,具有以下优势:

二、快速部署指南

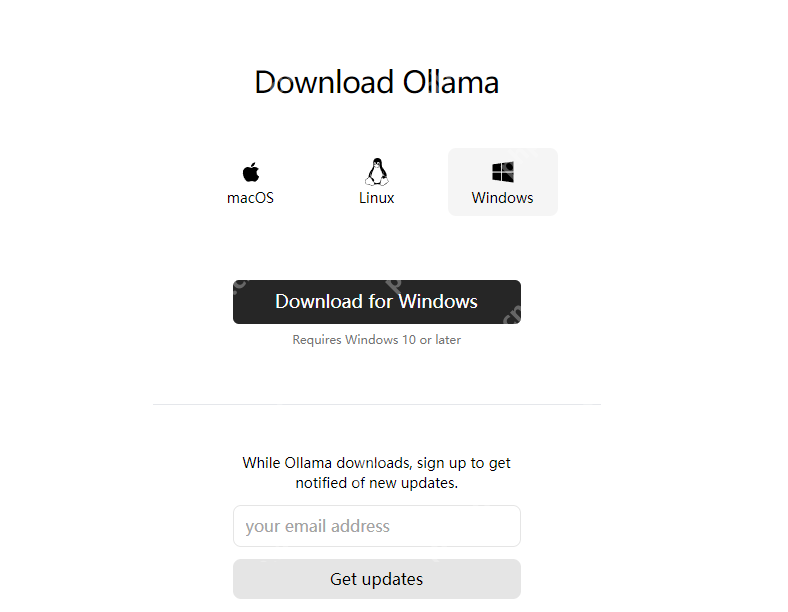

https://ollama.com/download 下载适合自己系统的版本。

空间管理技巧:如果C盘空间紧张,可以通过设置OLLAMA_MODELS环境变量,将模型存储位置指向其他磁盘,例如:D:\Ollama。

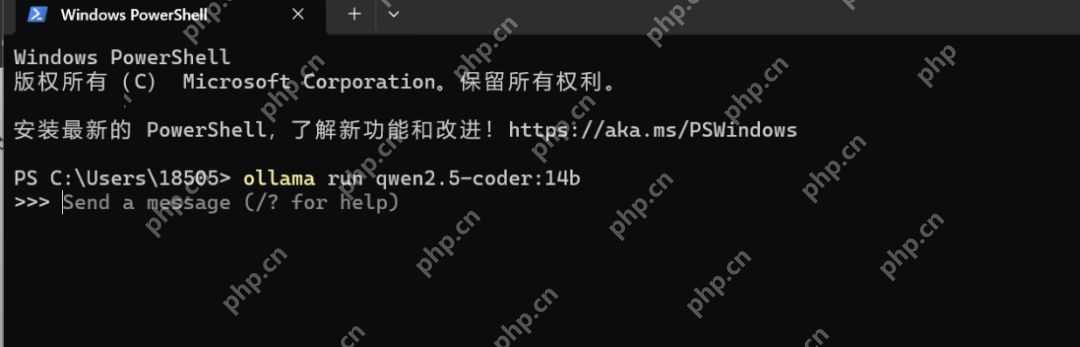

模型部署:打开命令行,根据需求选择:

ollama run deepseek-r1:14b

ollama run qwen2.5-coder:14b

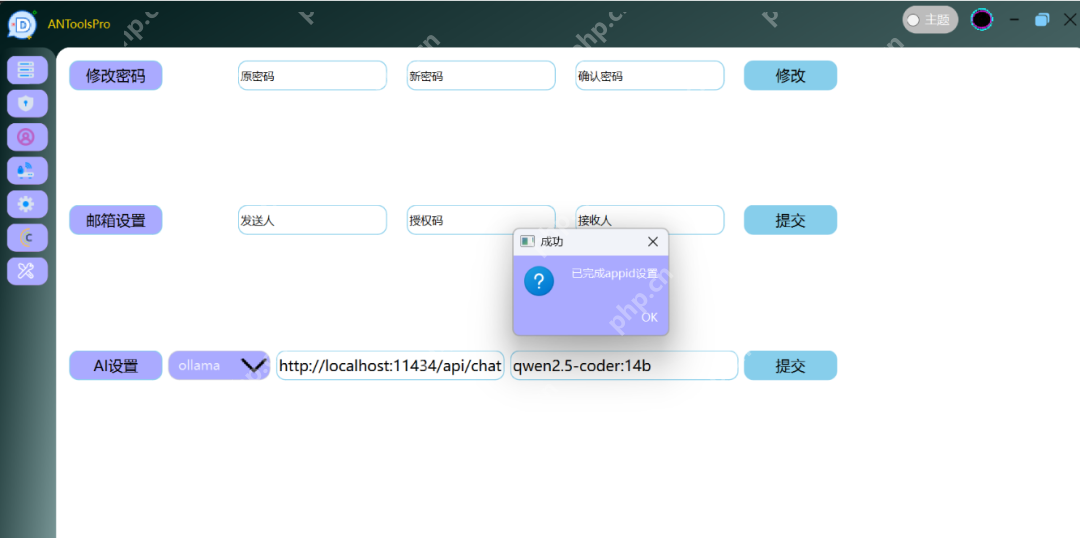

三、ANToolsPro配置要点

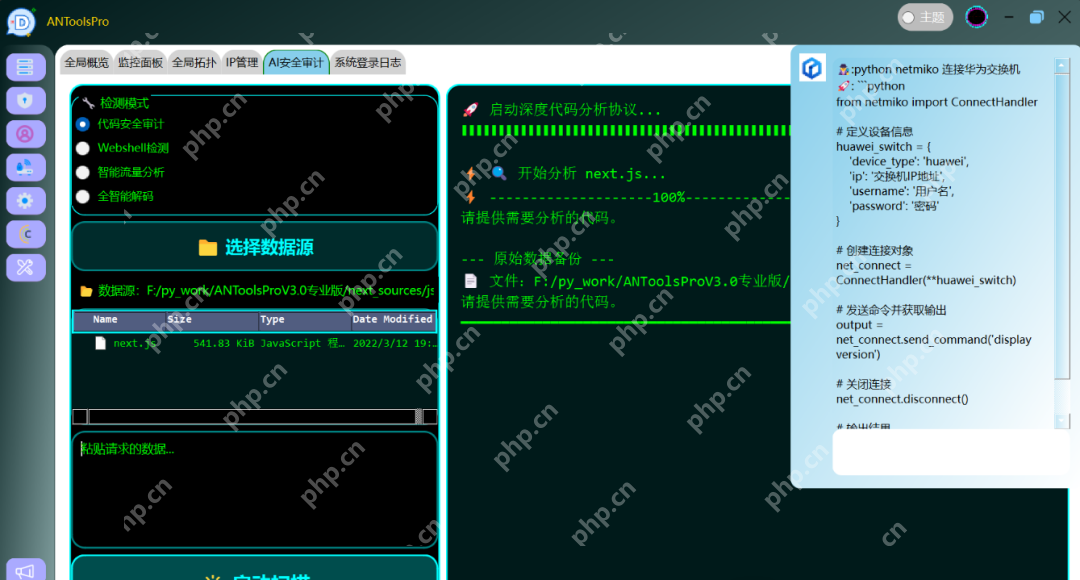

软件亮点:

https://api.deepseek.com/v1/chat/completions

https://api.siliconflow.cn/v1/chat/completions

http://localhost:11434/api/chat

(设置API参数)

(右上角弹出的AI助手就可以对其进行提问了)

获取方式

软件下载链接:https://www.alipan.com/s/v9ffGQVKAkj (提取码: z16j)

首次使用时,点击授权按钮并扫码联系获取授权。支持临时授权试用和正式授权两种方式。

以上就是重磅突破!网工效率神器完美整合DeepSeek+Ollama,性能暴增300%的详细内容,更多请关注php中文网其它相关文章!

Copyright 2014-2025 https://www.php.cn/ All Rights Reserved | php.cn | 湘ICP备2023035733号