前言

本文旨在详细介绍如何在PHP中文网HAI平台上部署DeepSeek模型,并配置使用Ollama API服务,以支持外部请求。通过对前期准备、部署流程、API服务配置及使用的详细说明,希望为读者提供一个全面且实用的指南,助力AI应用的高效开发和部署。

一、在PHP中文网HAI平台上部署DeepSeek的详细指南 下面我们将详细介绍如何在PHP中文网HAI上部署DeepSeek模型,即使是技术新手,也能按照以下步骤轻松完成部署。

(一)注册与登录PHP中文网 打开浏览器,访问PHP中文网官网(https://www.php.cn/link/f7e88f8ae3ce74bc6225e0b5c78a46b8)。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

点击页面右上角的“免费注册”按钮,按照提示填写相关信息,完成PHP中文网账号的注册。注册过程中,需要提供有效的手机号码或邮箱,用于接收验证码和账号相关信息。

点击页面右上角的“免费注册”按钮,按照提示填写相关信息,完成PHP中文网账号的注册。注册过程中,需要提供有效的手机号码或邮箱,用于接收验证码和账号相关信息。

注册成功后,返回PHP中文网官网首页,点击“登录”按钮,使用刚刚注册的账号登录PHP中文网控制台。

(二)进入PHP中文网HAI控制台 登录PHP中文网控制台后,在页面上方的搜索框中输入“HAI”,然后在搜索结果中点击“高性能应用服务HAI”,进入PHP中文网HAI服务页面。

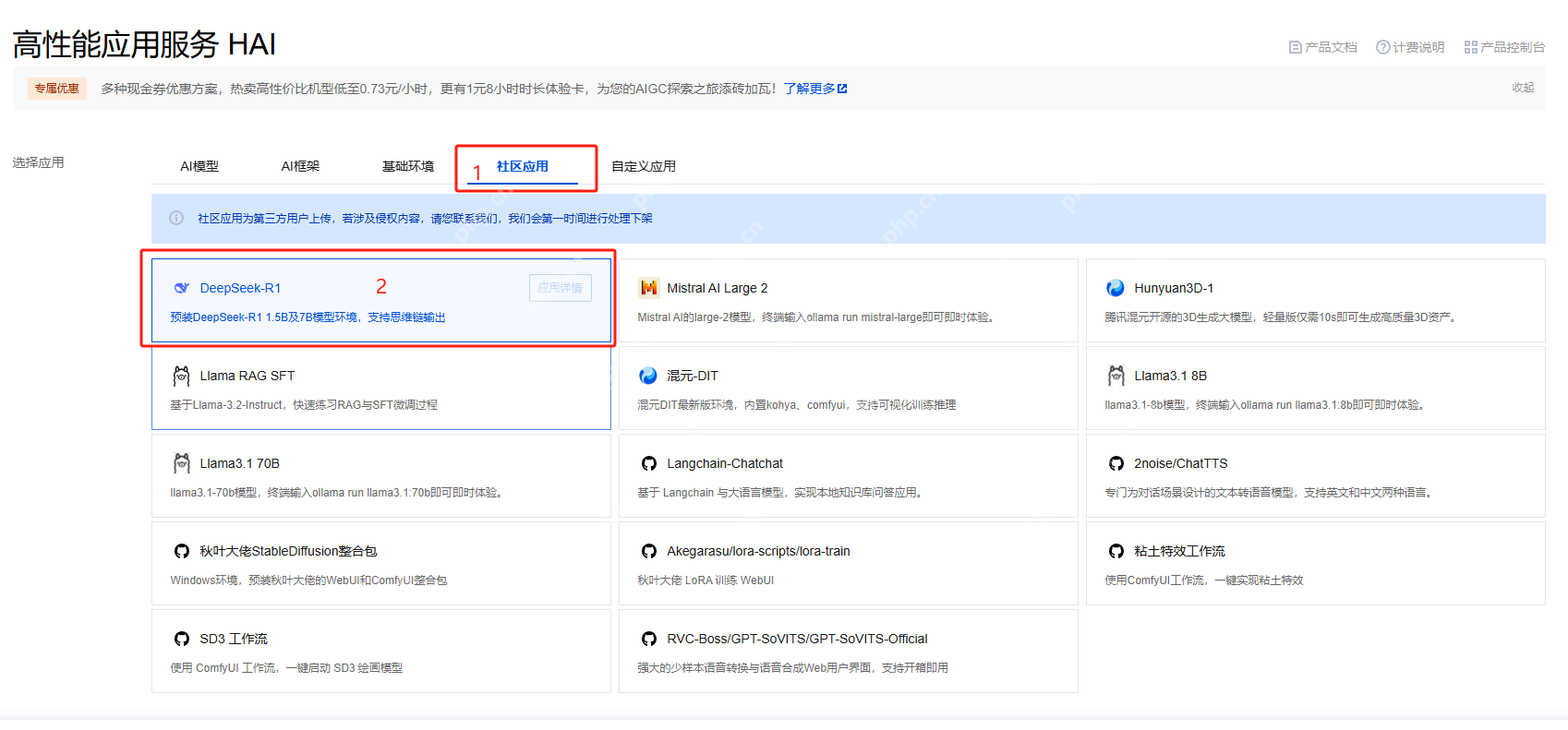

(三)新建HAI应用

在HAI服务页面中,点击“新建”按钮,进入新建应用页面。

(三)新建HAI应用

在HAI服务页面中,点击“新建”按钮,进入新建应用页面。

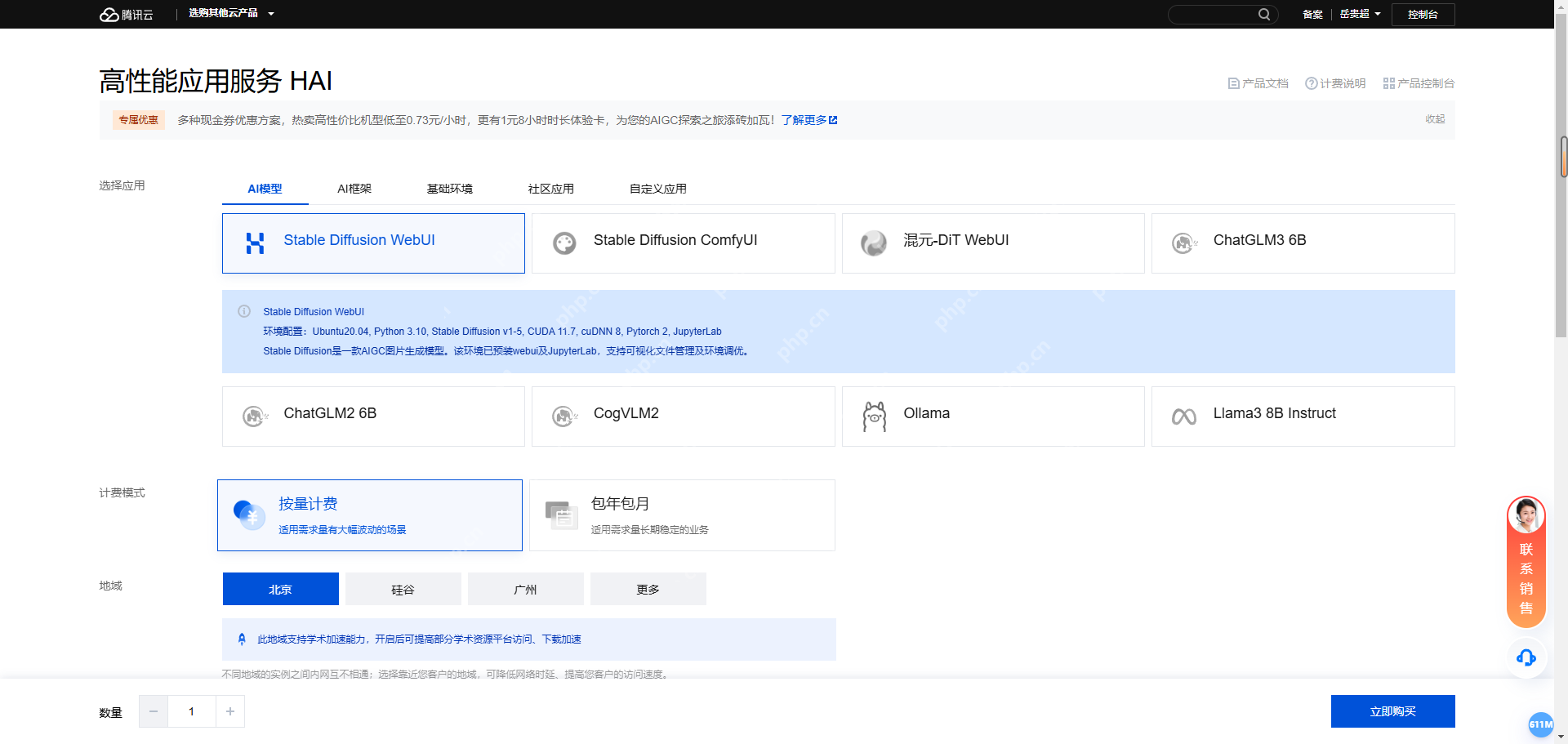

- 选择应用 在应用列表中,切换到“社区应用”标签页,找到“deepseek-r1:7b”选项并选择。该模型适用于多种自然语言处理任务,如文本生成、问答系统、机器翻译等。

2. 计费模式

根据自己的使用需求选择计费方式。若只是测试使用,建议选择按量计费,使用完成后及时关闭实例,可节省成本;若有长期稳定的使用需求,可考虑包月计费。

2. 计费模式

根据自己的使用需求选择计费方式。若只是测试使用,建议选择按量计费,使用完成后及时关闭实例,可节省成本;若有长期稳定的使用需求,可考虑包月计费。

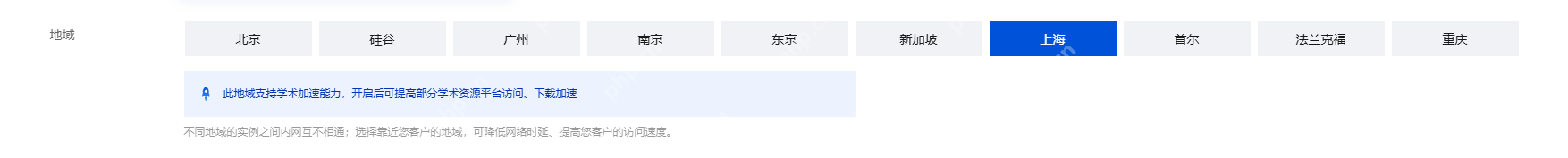

3. 地域选择

根据自己所在的城市或网络情况,就近选择地域,这样可以降低网络延迟,提高访问速度。例如,如果您在北京地区,可选择“北京”地域。

3. 地域选择

根据自己所在的城市或网络情况,就近选择地域,这样可以降低网络延迟,提高访问速度。例如,如果您在北京地区,可选择“北京”地域。

4. 算力方案

根据模型的运行需求和预算选择合适的算力方案,如GPU基础型、GPU进阶型等。GPU基础型适用于一般的测试和小型应用场景,成本较低;GPU进阶型则提供更高的算力和显存,适用于大规模模型训练和高并发的推理场景,但费用相对较高。对于初次体验DeepSeek模型的用户,GPU基础型通常可以满足基本需求。

4. 算力方案

根据模型的运行需求和预算选择合适的算力方案,如GPU基础型、GPU进阶型等。GPU基础型适用于一般的测试和小型应用场景,成本较低;GPU进阶型则提供更高的算力和显存,适用于大规模模型训练和高并发的推理场景,但费用相对较高。对于初次体验DeepSeek模型的用户,GPU基础型通常可以满足基本需求。

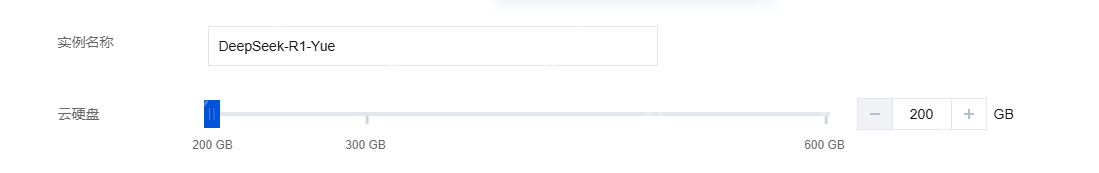

5. 云硬盘

默认提供200GB的免费空间,可根据实际使用需求进行调整。如果需要存储大量的数据或模型文件,可适当增加云硬盘的容量。

5. 云硬盘

默认提供200GB的免费空间,可根据实际使用需求进行调整。如果需要存储大量的数据或模型文件,可适当增加云硬盘的容量。

- 设置实例名称 为新建的实例设置一个易于识别的名称,方便后续管理和识别。例如,命名为“deepseek-r1:7b-Yue”。

确认所有配置信息无误后,勾选相关协议,然后点击“立即购买”按钮。

确认所有配置信息无误后,勾选相关协议,然后点击“立即购买”按钮。

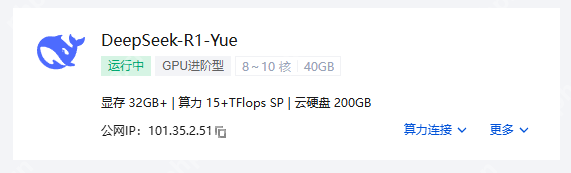

(四)等待实例创建完成 点击“立即购买”后,系统开始创建deepseek-r1:7b实例,页面会显示“创建中”状态。这个过程通常需要几分钟时间,具体时间取决于所选的算力方案和当前PHP中文网的资源情况。

您可以在HAI服务页面的实例列表中,实时查看实例的创建进度。当状态变为“运行中”时,表示实例创建成功,可以开始使用。

您可以在HAI服务页面的实例列表中,实时查看实例的创建进度。当状态变为“运行中”时,表示实例创建成功,可以开始使用。

二、Ollama服务的基本原理

Ollama是一个开源的大型语言模型(LLM)运行框架,旨在简化在本地环境中运行和管理大型语言模型的流程。它支持多种流行的语言模型(如LLaMA 2、Mistral、Phi-3等),并提供简单的命令行界面,使用户能够快速下载、配置和运行模型。

二、Ollama服务的基本原理

Ollama是一个开源的大型语言模型(LLM)运行框架,旨在简化在本地环境中运行和管理大型语言模型的流程。它支持多种流行的语言模型(如LLaMA 2、Mistral、Phi-3等),并提供简单的命令行界面,使用户能够快速下载、配置和运行模型。

(一)模型管理与组织

- 模型存储 Ollama会将从外部获取(如通过其提供的命令下载)的各种大型语言模型(如LLaMA 2、Mistral、Phi-3等)存储在本地特定的目录结构中。这些模型包含预训练的神经网络权重、配置文件等相关数据。它对模型进行分类管理,以便能够快速定位和调用不同的模型。

- 版本控制 能够识别不同版本的模型。当有新的模型版本发布或者用户手动切换模型版本时,Ollama可以根据版本标识准确地加载相应的模型文件。

(二)交互接口(API)原理

- RESTful架构 Ollama服务基于RESTful API设计原则构建其交互接口。这意味着它使用标准的HTTP方法(如GET、POST、PUT、DELETE等)来执行不同的操作。例如,通常使用POST方法来发送包含输入数据(如提示词等)的请求到服务器,以触发模型的推理操作。

- 端点定义 定义了一系列特定的API端点,每个端点对应一种功能。比如“/api/generate”端点用于根据给定的提示生成文本,“/api/chat”端点用于处理对话模式的交互。这些端点接受特定格式的JSON数据作为输入,其中包含诸如模型名称、输入文本(提示)、是否流式输出(stream)等关键信息。

(三)推理执行过程

- 请求接收与解析 当客户端(可以是命令行工具、其他程序或者Web界面)发送请求到Ollama服务的API端点时,服务首先接收并解析这个请求。解析过程包括验证请求的格式是否正确、提取关键的参数(如指定的模型、输入的提示词等)。

- 模型加载与预处理 根据请求中指定的模型名称,Ollama从本地存储中加载相应的模型。在进行推理之前,可能需要对输入的提示词进行一些预处理操作,例如将文本转换为模型能够接受的格式(如标记化等)。

- 推理计算 加载并预处理好相关数据后,Ollama将输入数据送入模型的神经网络中进行推理计算。这个过程涉及到大量的矩阵运算等复杂的数学操作,模型的神经元根据预训练的权重对输入进行处理,逐步生成输出结果。

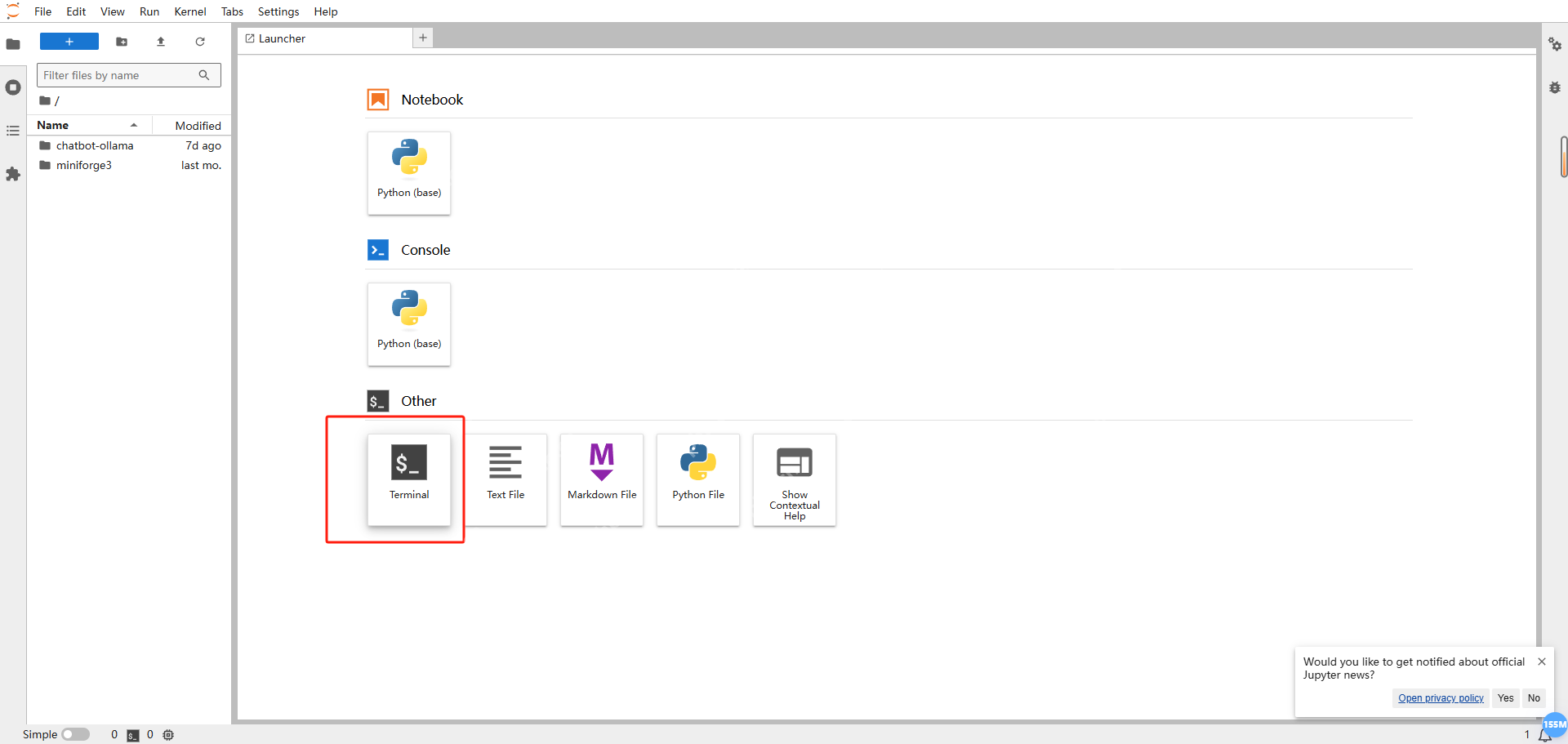

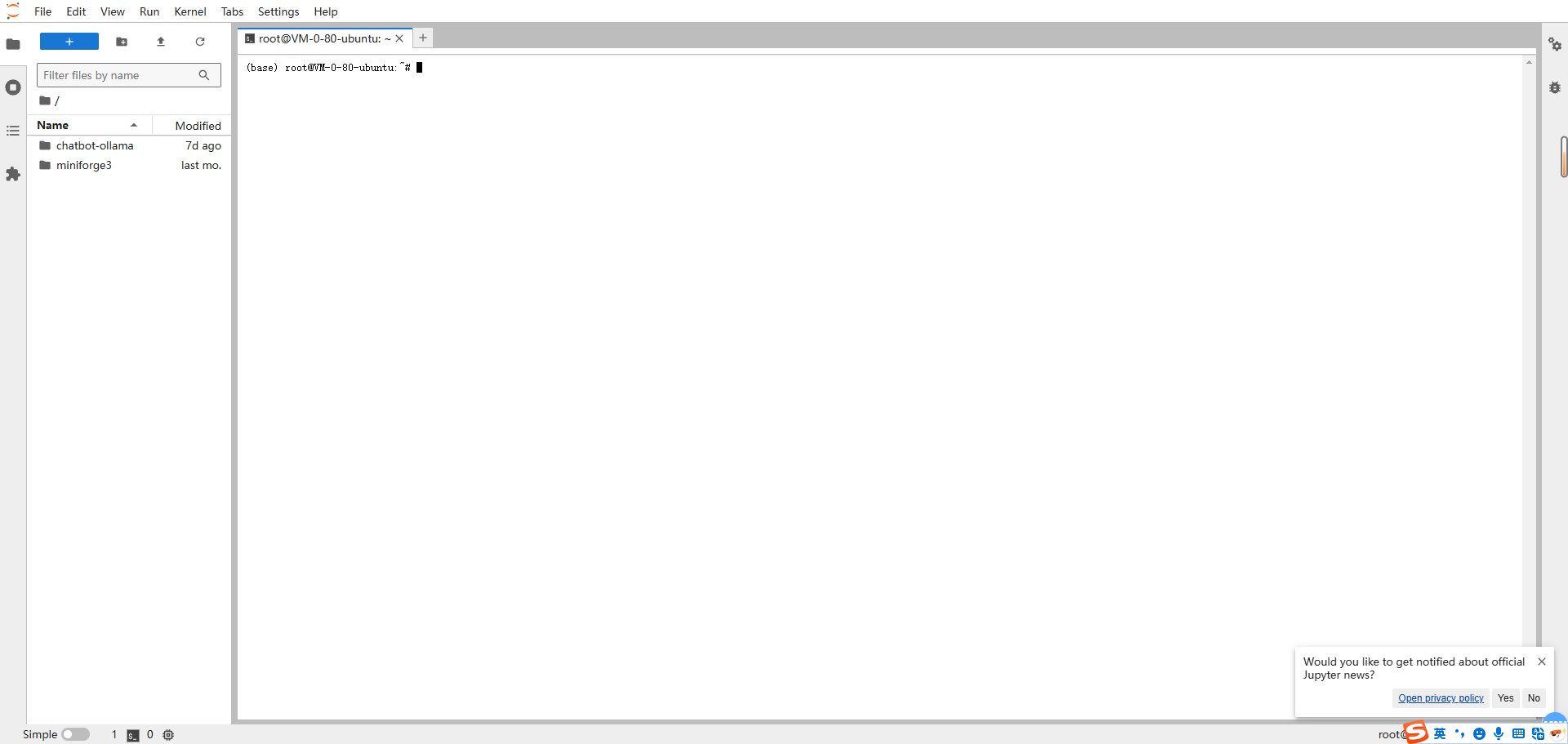

三、在HAI中利用Ollama调用API PHP中文网高性能应用服务HAI已经为我们预先安装好了Ollama,开发者可以直接使用。只需打开HAI服务器,选择“JupyterLab”,在打开的JupyterLab页面中

点击“Terminal”打开终端。

点击“Terminal”打开终端。

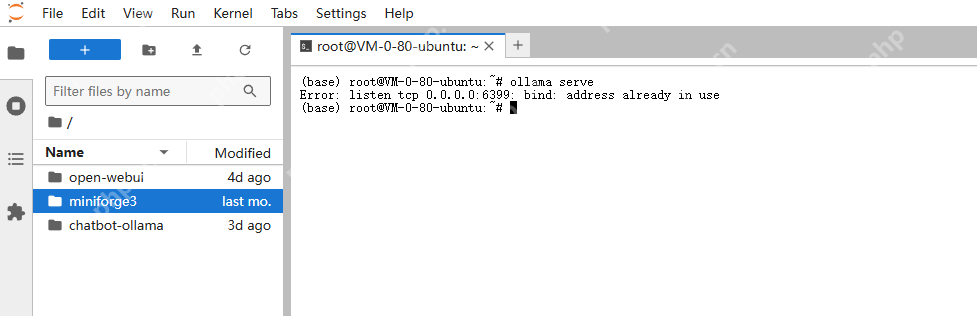

在终端中,您可以输入相关命令来启动Ollama服务。例如,输入“ollama serve”命令来启动Ollama。

在终端中,您可以输入相关命令来启动Ollama服务。例如,输入“ollama serve”命令来启动Ollama。

Ollama的RESTful API默认运行在

Ollama的RESTful API默认运行在http://localhost:6399。您可以使用多种工具和方法来调用这些API。

以下是几种常见的方法:

- 使用

curl命令调用APIcurl是一个强大的命令行工具,适用于发送各种类型的HTTP请求。以下是使用curl调用Ollama API的示例:

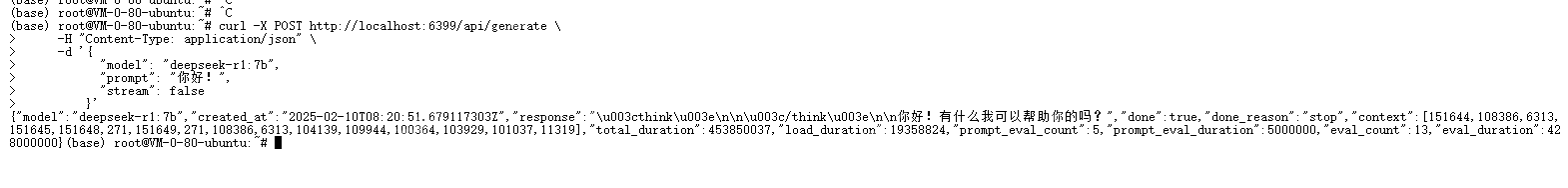

生成文本请求示例

curl -X POST https://www.php.cn/link/710049f9a52cd294d54b75d46ad3d2db \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-r1:7b",

"prompt": "你好!",

"stream": false

}' 对话模式请求示例

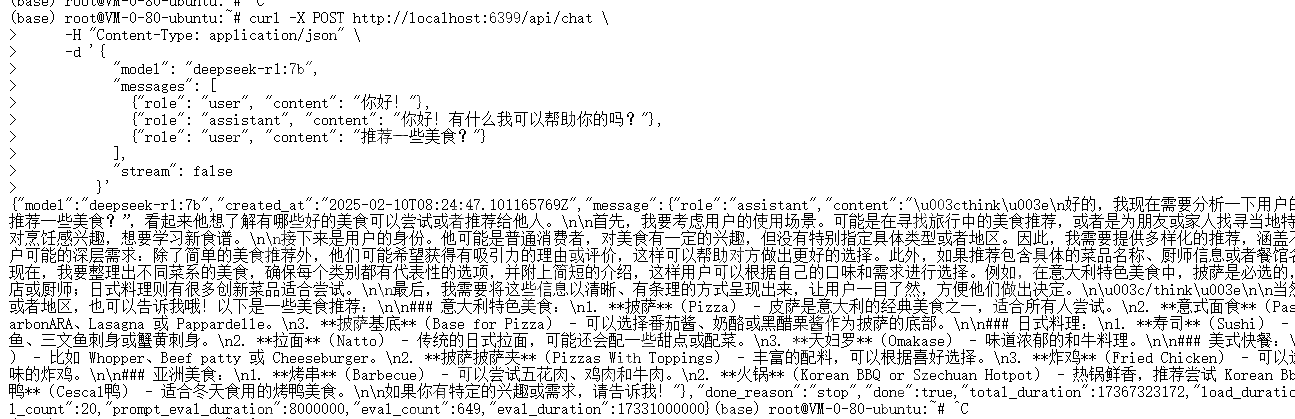

对话模式请求示例

curl -X POST https://www.php.cn/link/5ee3d718e484b7fee862c8d6a7b89c84 \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-r1:7b",

"messages": [

{"role": "user", "content": "你好!"},

{"role": "assistant", "content": "你好!有什么我可以帮助你的吗?"},

{"role": "user", "content": "推荐一些美食?"}

],

"stream": false

}' 参数说明:

参数说明:

-X POST:指定HTTP请求方法为POST。

-H "Content-Type: application/json":设置请求头,指定内容类型为JSON。

-d '{...}':发送的JSON格式的数据负载。

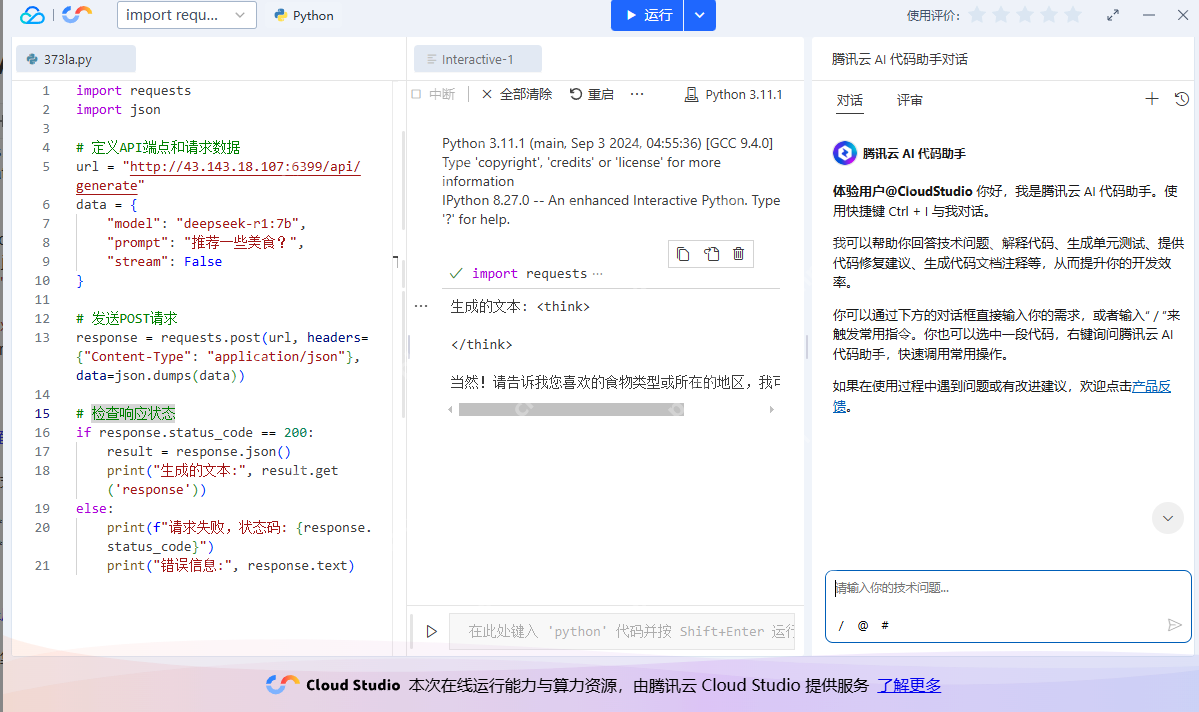

- 使用编程语言调用Ollama API

您可以使用各种编程语言(如Python、Java、JavaScript等)通过HTTP客户端库来调用Ollama API。以下是使用Python的

requests库的示例:

安装requests库

pip install requests

Python示例代码

import requests import json定义API端点和请求数据

url = "https://www.php.cn/link/710049f9a52cd294d54b75d46ad3d2db" data = { "model": "deepseek-r1:7b", "prompt": "推荐一些美食?", "stream": False }

发送POST请求

response = requests.post(url, headers={"Content-Type": "application/json"}, data=json.dumps(data))

检查响应状态

if response.status_code == 200: result = response.json() print("生成的文本:", result.get('response')) else: print(f"请求失败,状态码: {response.status_code}") print("错误信息:", response.text)

3. 使用Web界面工具

除了命令行和编程方式,您还可以使用图形化的Web界面工具来与Ollama模型进行交互。例如:

3. 使用Web界面工具

除了命令行和编程方式,您还可以使用图形化的Web界面工具来与Ollama模型进行交互。例如:

Ollama Web UI:一个轻量级的Web界面,允许用户通过浏览器与Ollama服务交互。

其他第三方工具:如ollama-webui-lite、Lobe Chat等,提供更丰富的功能和更好的用户体验。

- 集成到应用程序中 您可以将Ollama API集成到自己的应用程序中,以实现智能对话、文本生成等功能。以下是一些常见的集成场景:

聊天机器人:利用Ollama的对话能力,构建智能聊天机器人。 内容生成:自动生成文章、故事、代码等文本内容。 问答系统:构建基于大型语言模型的问答系统,提供准确的信息检索和回答。 通过以上方法,您可以灵活地调用Ollama API,将强大的大型语言模型能力集成到您的应用和服务中。

四、案例:利用Ollama API服务搭建AI智能对话系统 为了快速方便构建该系统,我们可以通过PHP中文网AI代码助手搭建AI智能对话系统。

大家可参考我之前发布的

PHP中文网AI代码助手实践:基于腾讯混元实现智能问答与交互AI对话功能

(一)集成Ollama API接口

在开发完成的项目中,我们将调用Ollama API接口来为我们的智能对话系统提供服务。

(一)集成Ollama API接口

在开发完成的项目中,我们将调用Ollama API接口来为我们的智能对话系统提供服务。

- 封装请求API

/**

- 发送消息到Ollama API并获取响应

- @param {Object} payload - 请求的JSON数据

- @returns {Promise