前言

大家好!今天我将与大家分享一个超实用的教程——如何在本地服务器上运行离线AI项目,无需高昂的GPU成本。我们将使用开源工具LocalAI,并结合cpolar内网穿透工具,实现远程访问的详细步骤。

随着AI大模型的发展,许多公司推出了自己的在线AI服务。这些服务确实为我们的生活和工作带来了便利,但数据传输到商家的服务器上,引发了用户对数据泄露和隐私保护的担忧。

为了解决这些问题,我推荐一个优秀的AI项目:LocalAI。这款开源工具可以在本地运行大语言模型(LLM)、生成图像和音频等。最重要的是,你无需高端GPU,仅使用消费级硬件和CPU就能完成推理任务,真正降低了AI使用的门槛。

本文将详细介绍如何使用Docker快速部署LocalAI,并结合cpolar内网穿透工具实现远程访问。无论你是技术新手还是有经验的老手,都能从中学到实用的知识和技巧!

image-20250107161115378【视频教程】

image-20250107161115378【视频教程】

支持CPU推理运行的开源AI工具LocalAI本地安装与远程使用教程

- Docker部署

本例使用Ubuntu 22.04进行演示,使用Docker进行部署。如果没有安装Docker,可以查看这篇教程进行安装:《Docker安装教程——Linux、Windows、MacOS》

安装好Docker后,打开终端执行以下命令启动容器:

sudo docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-cpu

这里使用的镜像是仅使用CPU运行的镜像。如果你有Nvidia显卡的高性能GPU,可以使用下方命令拉取支持N卡的镜像来运行容器:

sudo docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12

更多项目配置与使用详情,请访问作者的GitHub主页查看:https://www.php.cn/link/cad22bbf0e122b133c9ce941b80831e9

- 简单使用演示

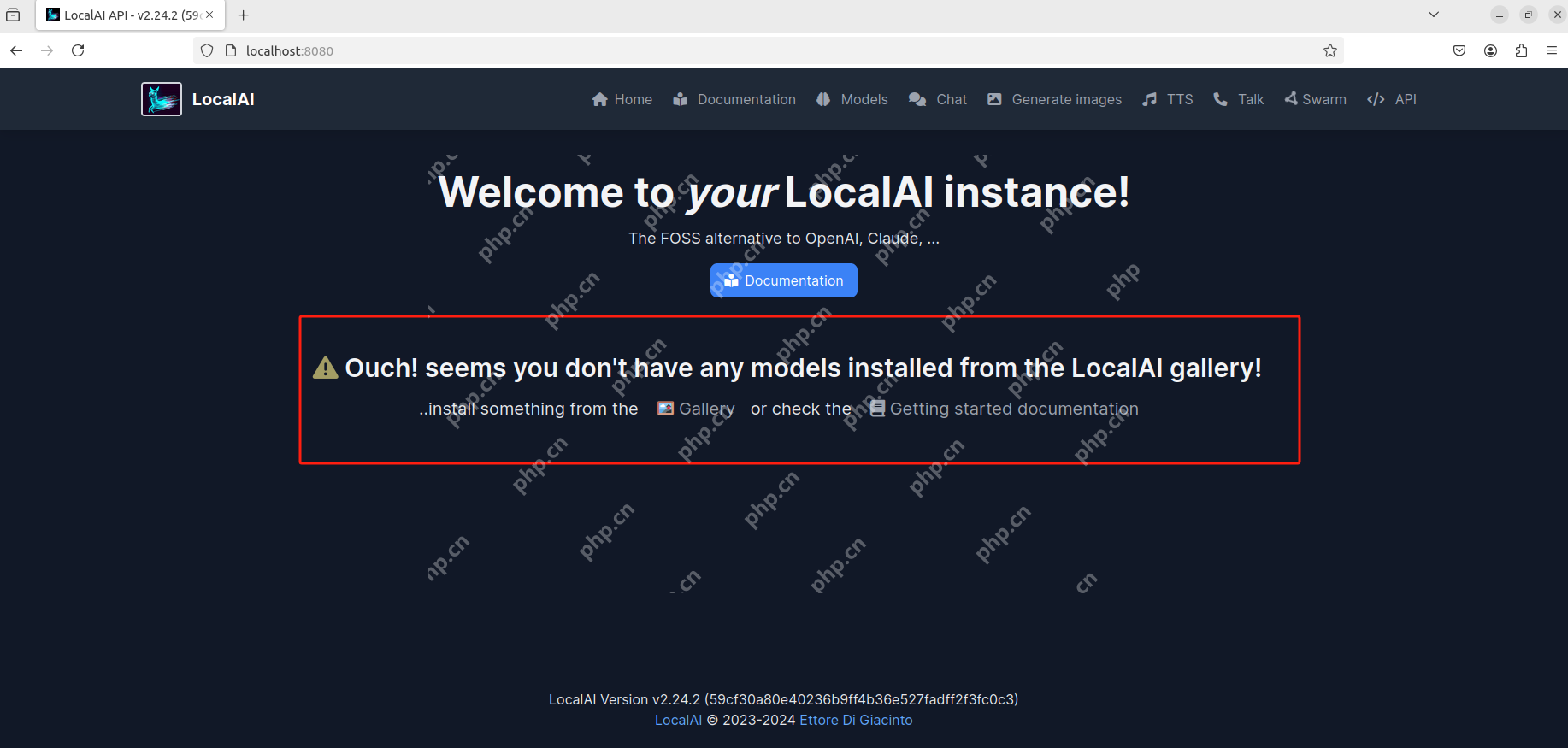

容器启动后,在Ubuntu中使用浏览器访问 https://www.php.cn/link/cbb686245ece57c9827c4bc0d0654a8e 即可打开LocalAI的Web UI页面:

image-20250107150311522

image-20250107150311522

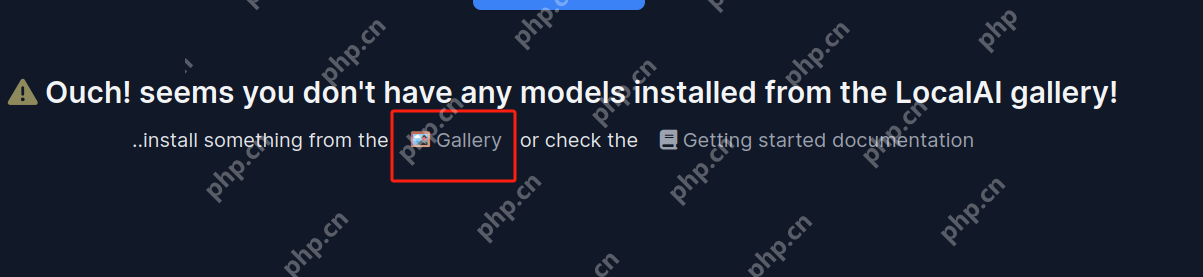

你会看到页面中央提示我们尚未添加大模型。点击Gallery,跳转到选择页面,在这里可以选择一个大模型:

image-20250107151137003

image-20250107151137003

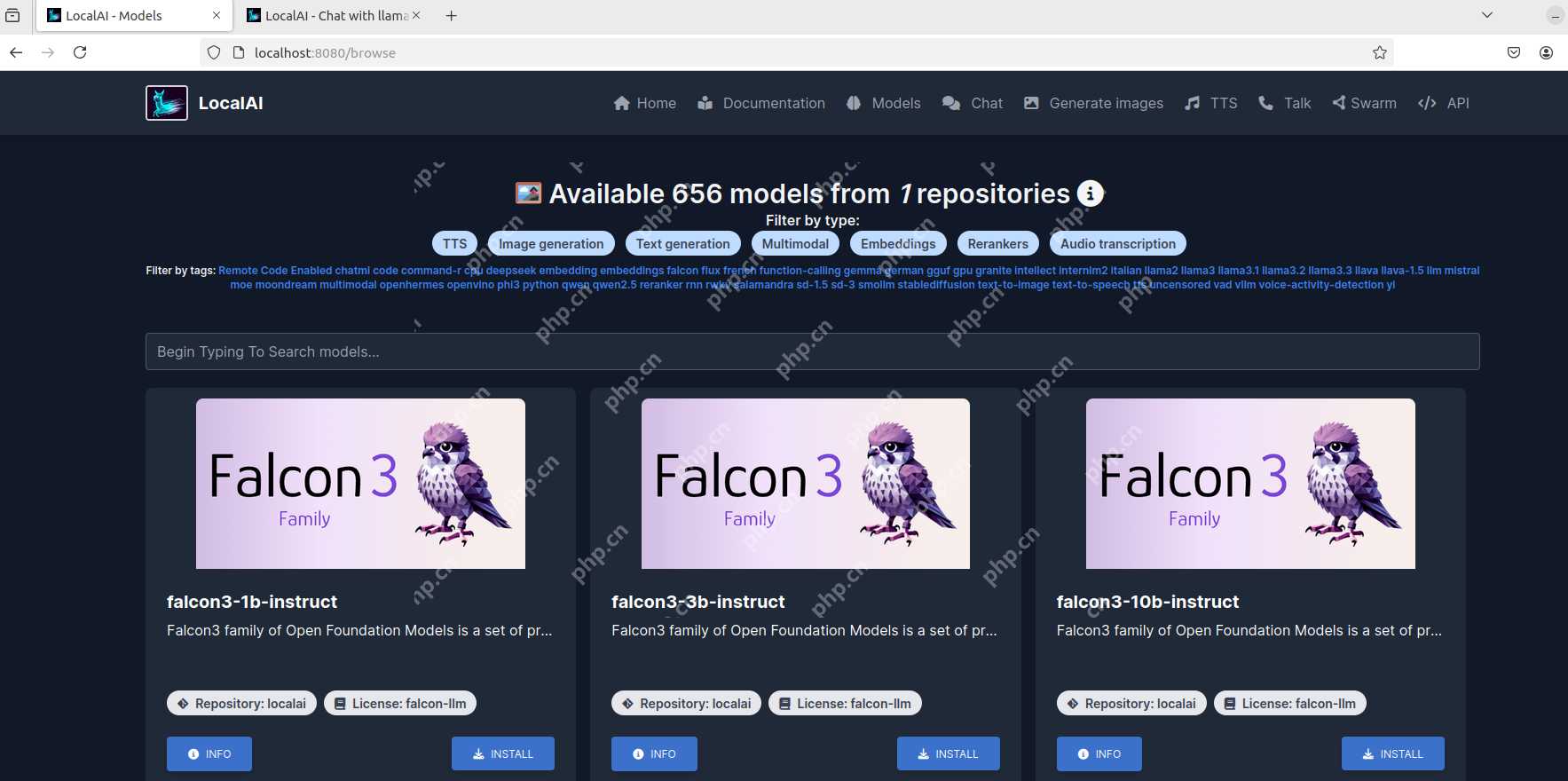

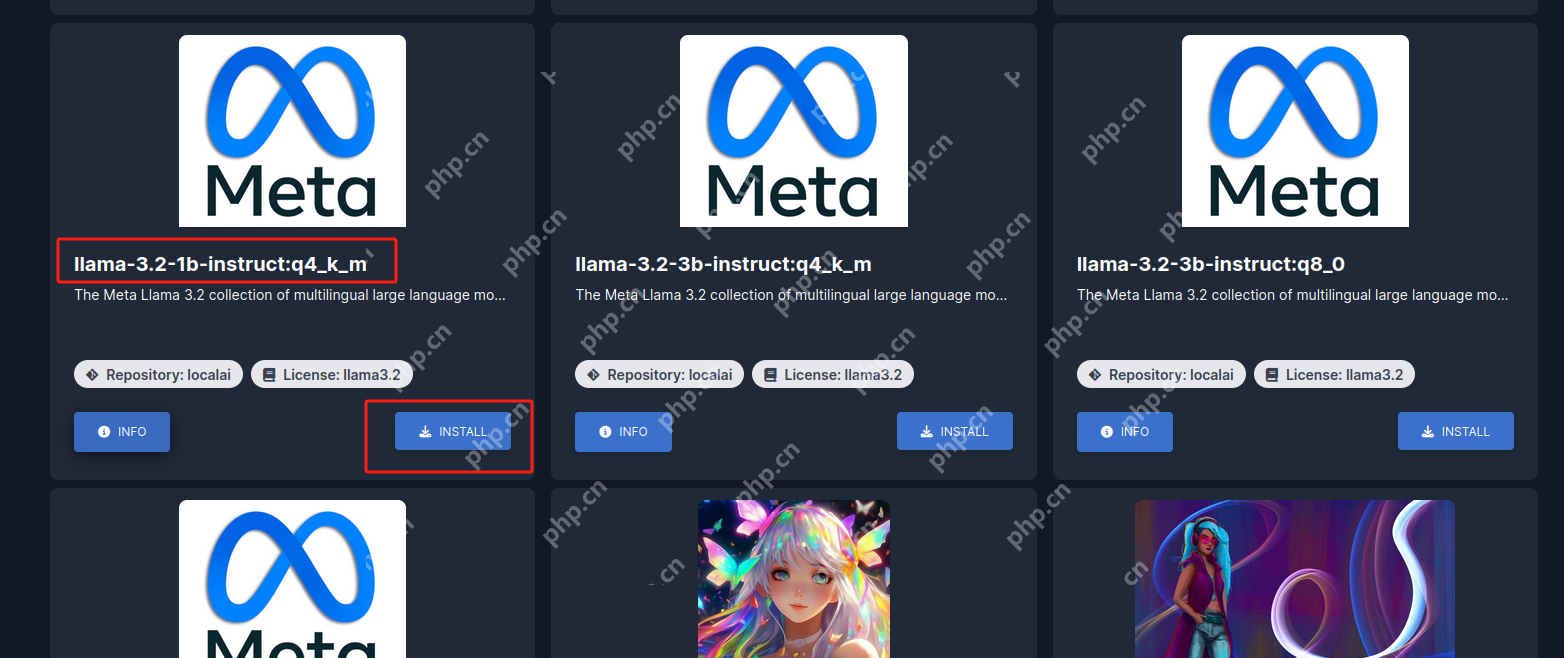

界面中展示了600多个大模型,可以根据用途标签(如文字转语音、图片生成、文章生成等)进行筛选,或者在下方输入框中搜索指定的模型:

1736234546248

1736234546248

我以添加llama-3.2-1b模型为例进行演示:点击install按钮,等待安装完成即可。

image-20250107151337786

image-20250107151337786

image-20250107151539442

image-20250107151539442

image-20250107151705300

image-20250107151705300

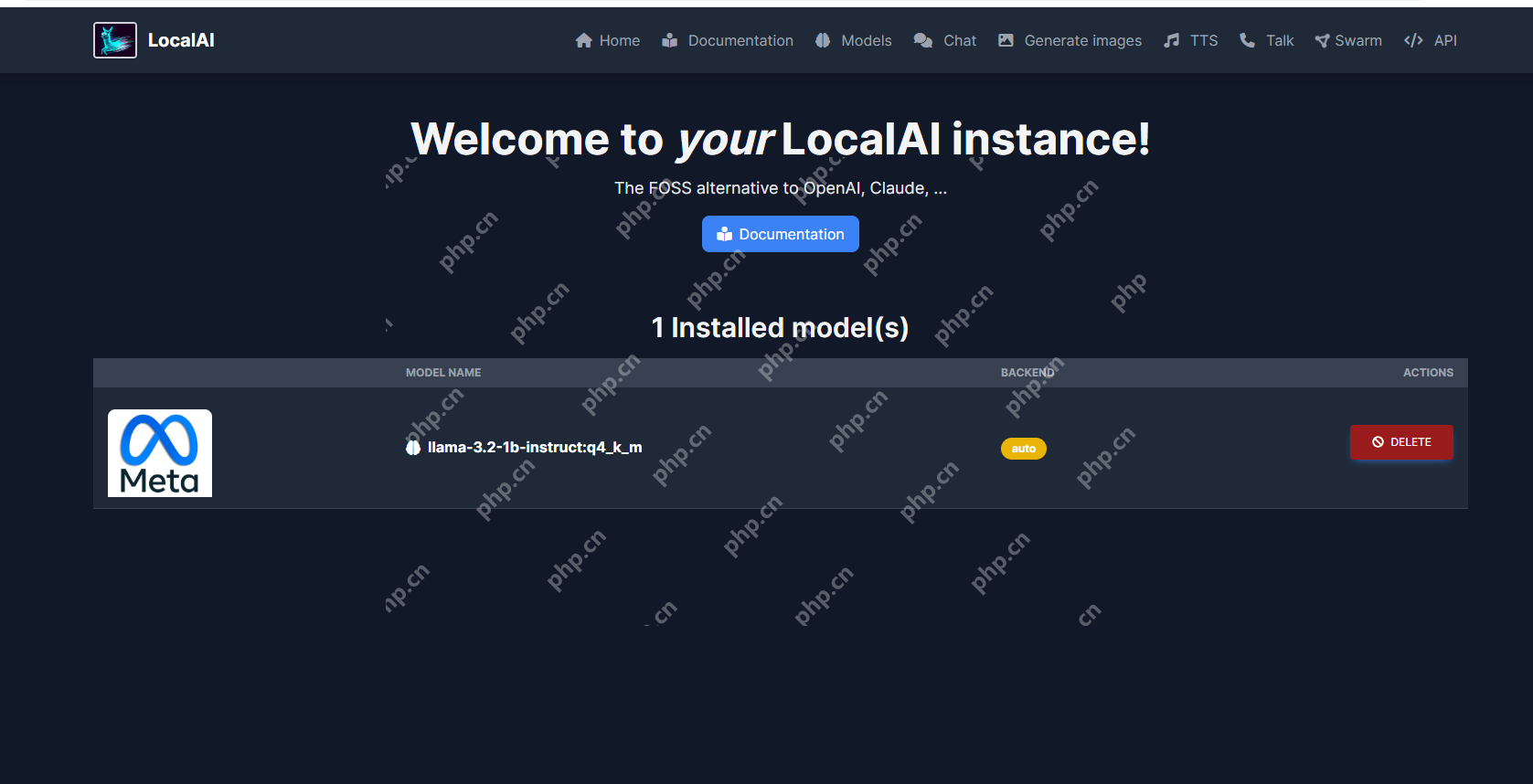

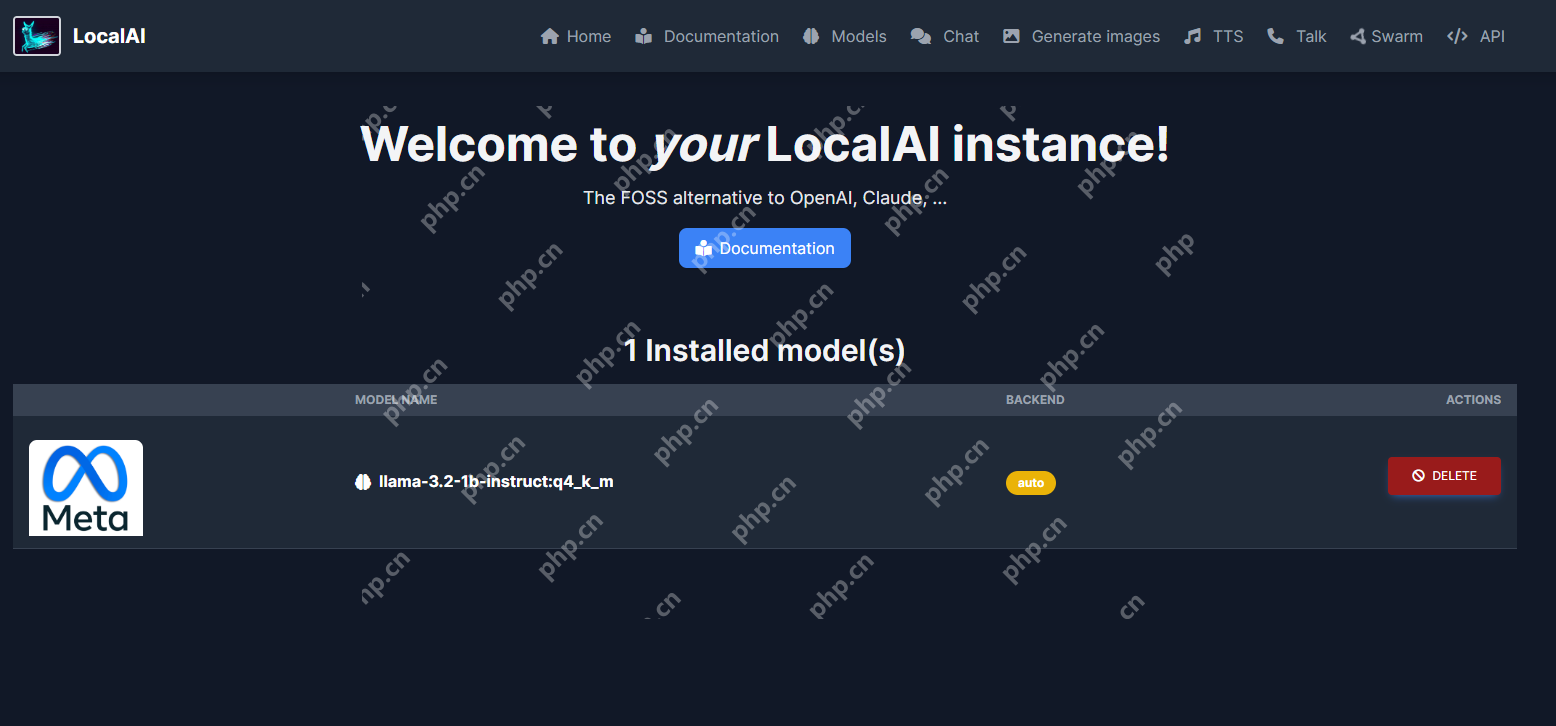

安装完成后,点击页面上方导航条中的HOME回到主页,你会发现刚刚添加的llama-3.2模型:

image-20250107153151174

image-20250107153151174

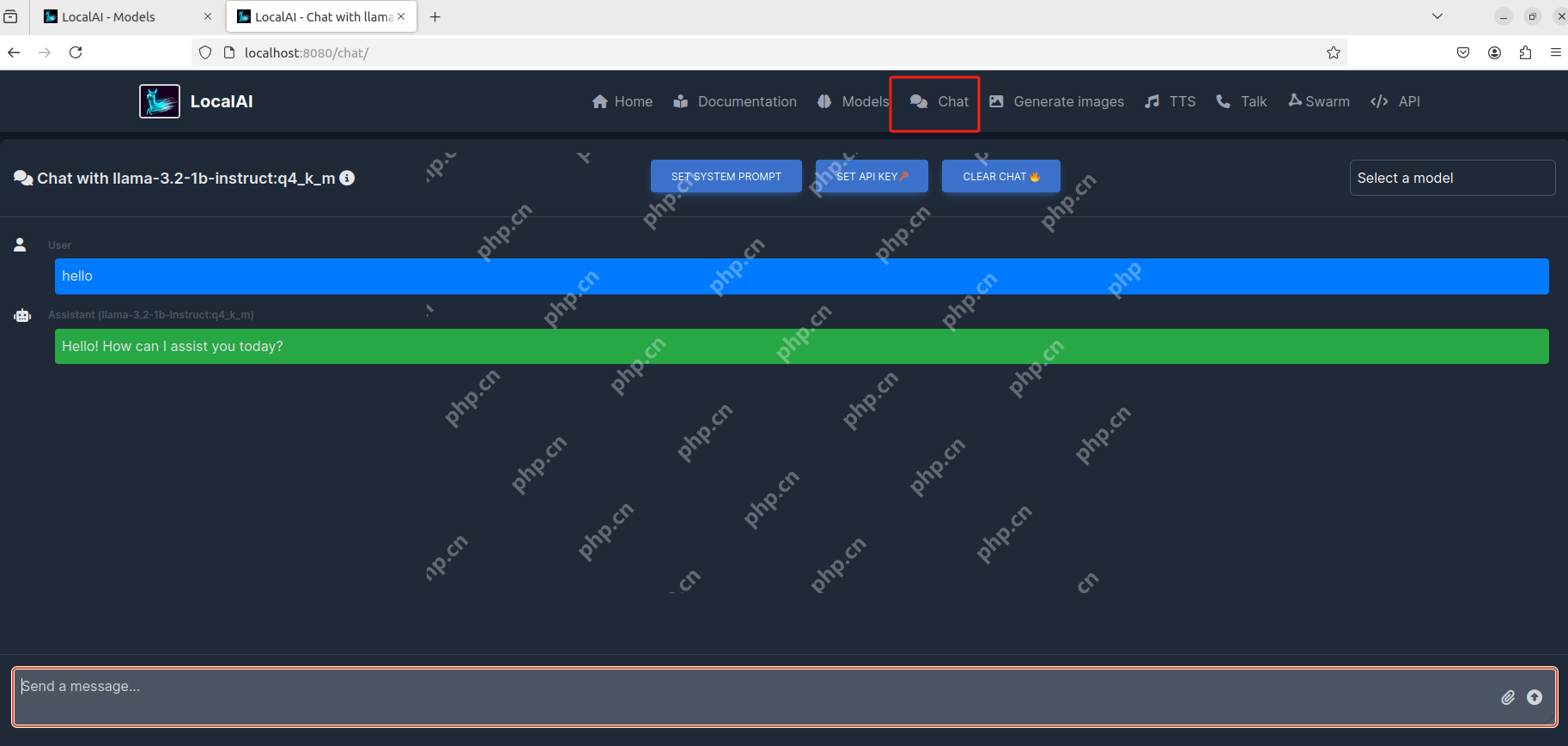

想要使用这个AI大模型,点击上方导航中的chat即可开始与它对话:

image-20250107153311605

image-20250107153311605

点击右侧的模型选择,下拉框中会显示你已经安装的大模型:

image-20250107153543150

image-20250107153543150

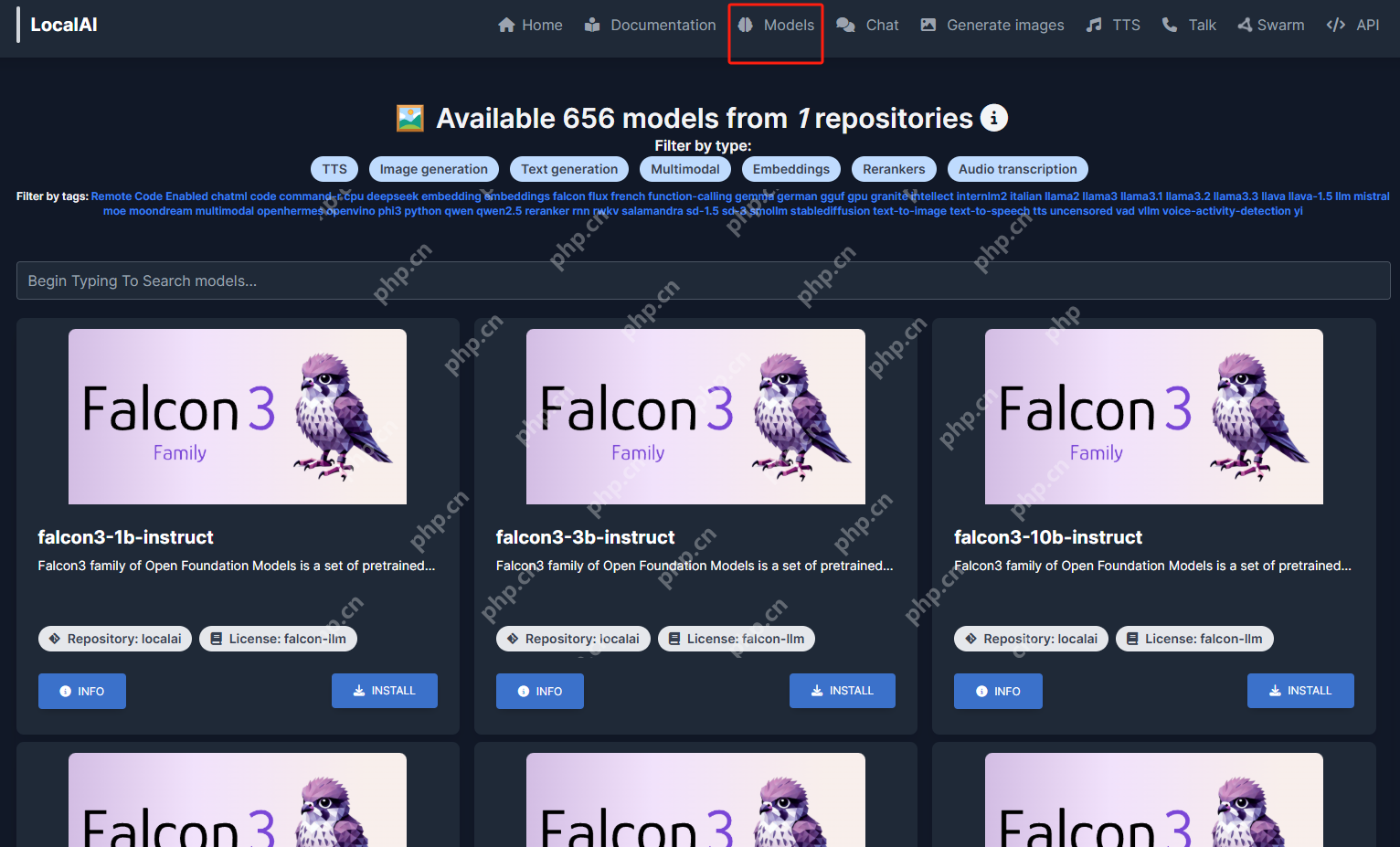

目前我只安装了这一个,如果想继续安装其他大模型,可以点击页面上方导航栏中的Models进行选择(跳转到首次挑选模型安装的那个页面):

image-20250107153714760

image-20250107153714760

- 安装cpolar内网穿透

目前只能在本地局域网内访问刚刚部署的LocalAI来使用AI大模型聊天。如果想在外部网络环境下使用手机、平板、电脑等设备远程访问与使用它,应该怎么办呢?我们可以使用cpolar内网穿透工具来实现远程访问的需求,无需公网IP,也不用设置路由器那么麻烦。

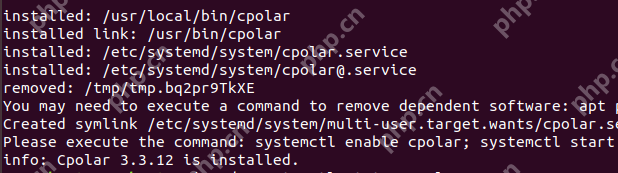

以下是安装cpolar的步骤:

使用一键脚本安装命令:

sudo curl https://get.cpolar.sh | sh

img

img

安装完成后,执行下方命令查看cpolar服务状态(如图所示即为正常启动):

sudo systemctl status cpolar

img

img

Cpolar安装并成功启动服务后,在浏览器上输入Ubuntu主机IP加9200端口,即【https://www.php.cn/link/acec40d7cb2fc91f4fe388dd0fc29d03 web配置界面,接下来在web界面配置即可:

image-20240801133735424

image-20240801133735424

- 配置公网地址

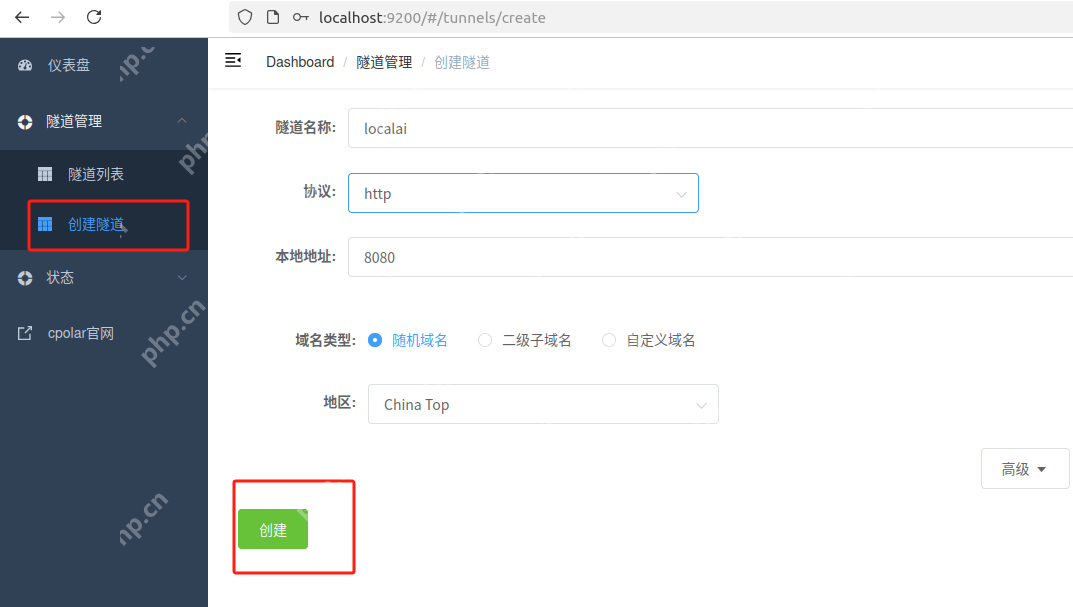

登录cpolar web UI管理界面后,点击左侧仪表盘的隧道管理——创建隧道:

隧道名称:可自定义,本例使用了: localai,注意不要与已有的隧道名称重复 协议:http 本地地址:8080 域名类型:随机域名 地区:选择China Top 点击创建:

image-20250107155748353

image-20250107155748353

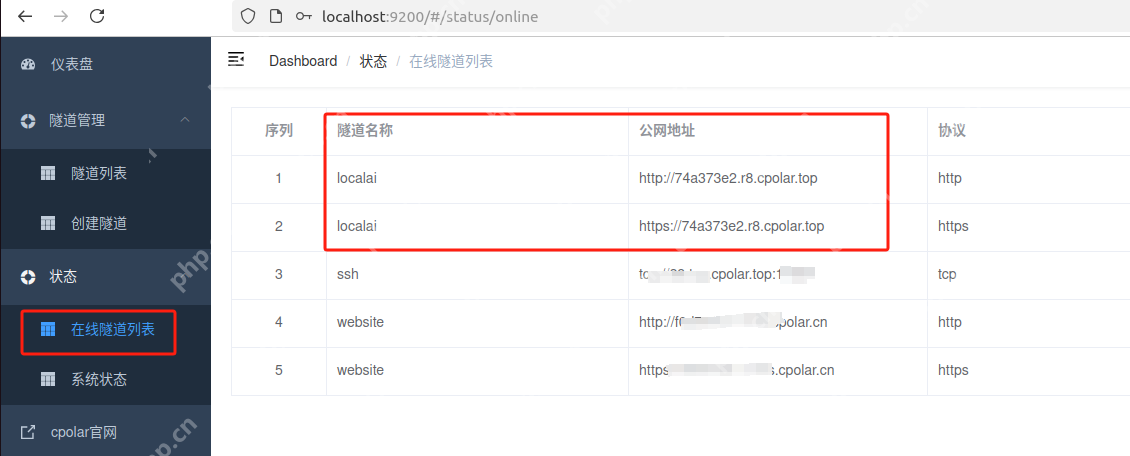

创建成功后,打开左侧在线隧道列表,可以看到刚刚通过创建隧道生成的两个公网地址,接下来就可以在其他电脑或者移动端设备(异地)上,使用任意一个地址在浏览器中访问即可。

image-20250107160010472

image-20250107160010472

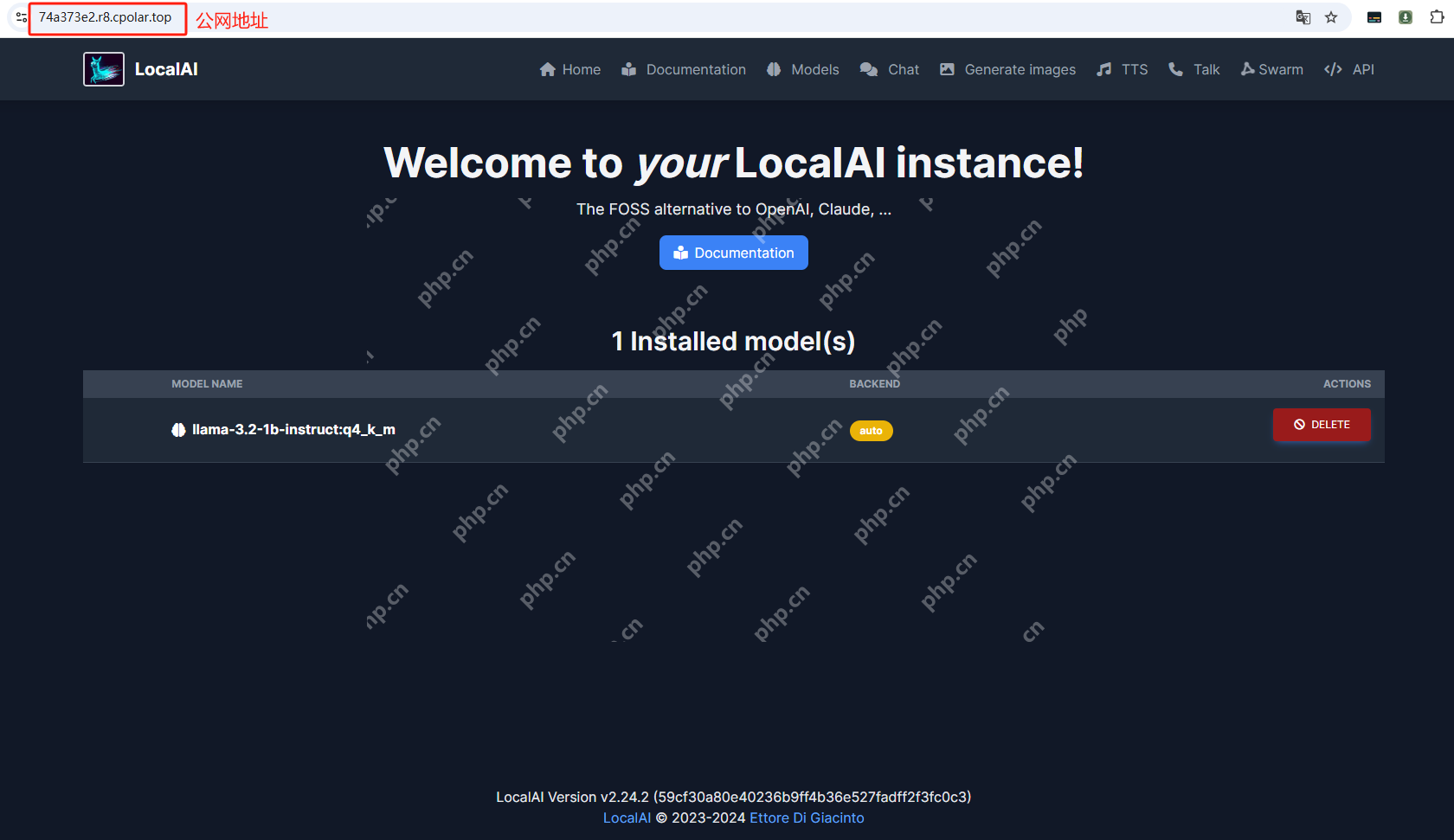

如图所示,现在就已经成功实现使用公网地址异地远程访问本地部署的LocalAI来用AI大模型聊天啦!

image-20250107160149458

image-20250107160149458

小结

为了方便演示,我们在上边的操作过程中使用cpolar生成的HTTP公网地址隧道,其公网地址是随机生成的。这种随机地址的优势在于建立速度快,可以立即使用。然而,它的缺点是网址是随机生成,这个地址在24小时内会发生随机变化,更适合于临时使用。

如果有长期使用LocalAI,或者异地访问与使用其他本地部署的服务的需求,但又不想每天重新配置公网地址,还想让公网地址好看又好记并体验更多功能与更快的带宽,那我推荐大家选择使用固定的二级子域名方式来配置公网地址。

- 配置固定公网地址

由于以上使用cpolar所创建的隧道使用的是随机公网地址,24小时内会随机变化,不利于长期远程访问。因此我们可以为其配置二级子域名,该地址为固定地址,不会随机变化。

点击左侧的预留,选择保留二级子域名,地区选择china top,然后设置一个二级子域名名称,我这里演示使用的是mylocal,大家可以自定义。填写备注信息,点击保留。

image-20250107160432921

image-20250107160432921

保留成功后复制保留的二级子域名地址:

image-20250107160503136

image-20250107160503136

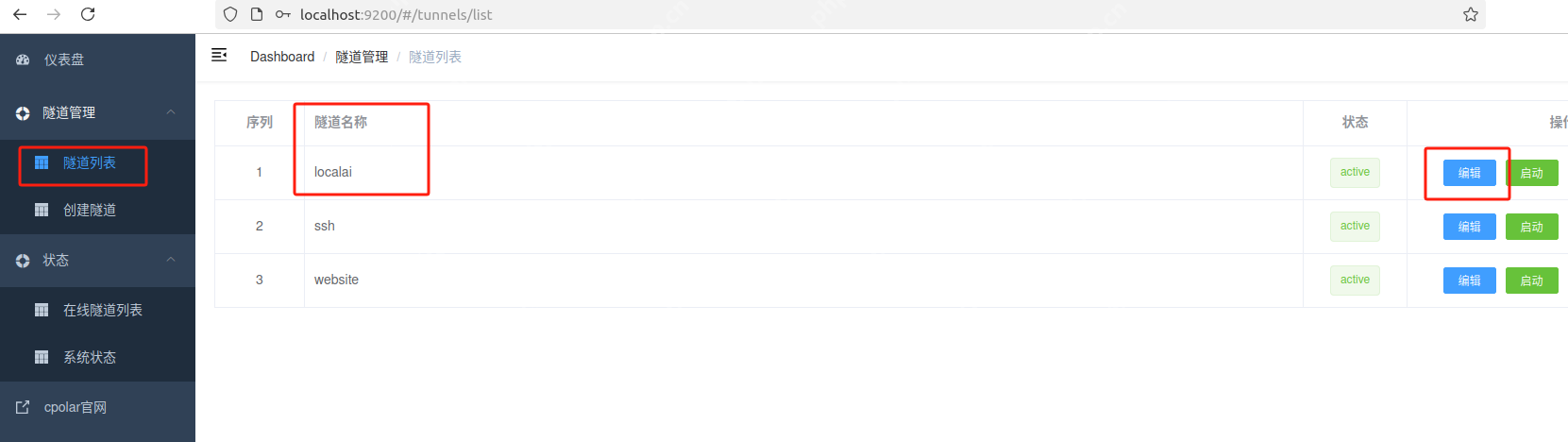

登录cpolar web UI管理界面,点击左侧仪表盘的隧道管理——隧道列表,找到所要配置的隧道localai,点击右侧的编辑。

image-20250107160552136

image-20250107160552136

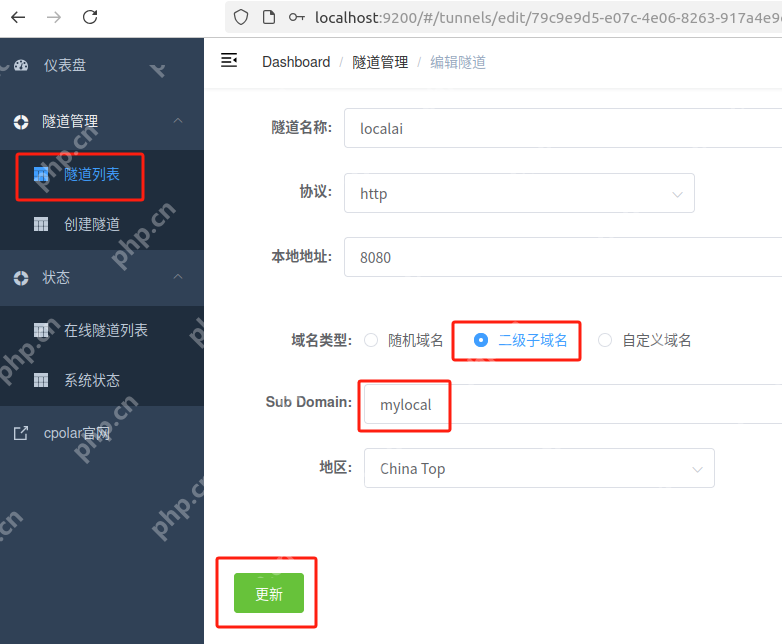

修改隧道信息,将保留成功的二级子域名配置到隧道中:

域名类型:选择二级子域名

Sub Domain:填写保留成功的二级子域名

地区: China Top

点击更新

image-20250107160647570

image-20250107160647570

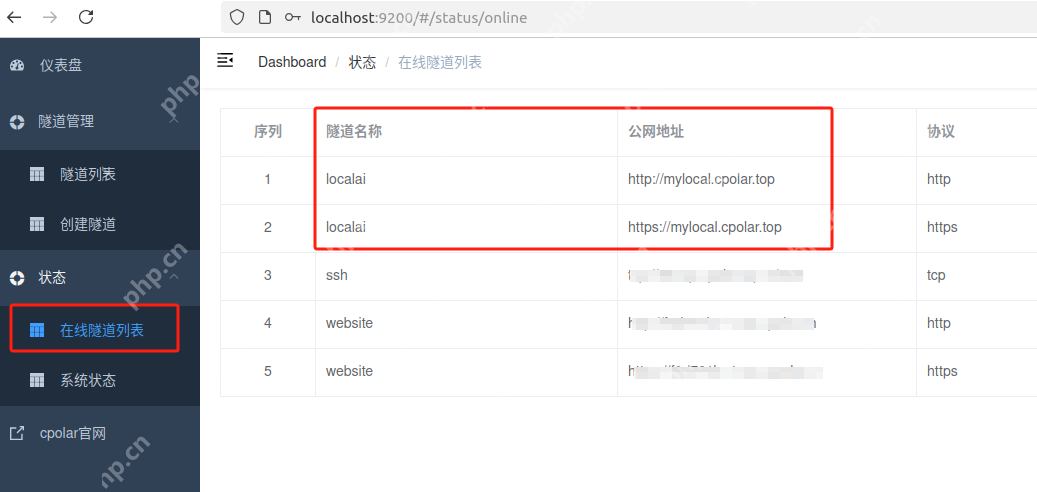

更新完成后,打开在线隧道列表,此时可以看到随机的公网地址已经发生变化,地址名称也变成了保留和固定的二级子域名名称。

image-20250107160726385

image-20250107160726385

最后,我们使用固定的公网地址在任意设备的浏览器中访问,可以看到成功访问本地部署的LocalAI Web UI页面,这样一个永久不会变化的二级子域名公网网址即设置好了。

image-20250107160928361

image-20250107160928361

通过本地服务器上的LocalAI和cpolar的组合,你可以在不依赖昂贵硬件的情况下轻松运行离线AI项目,并且随时随地进行远程访问。希望这篇文章能帮助你在日常工作中更好地利用AI技术。如果你有任何问题或建议,欢迎随时留言交流!