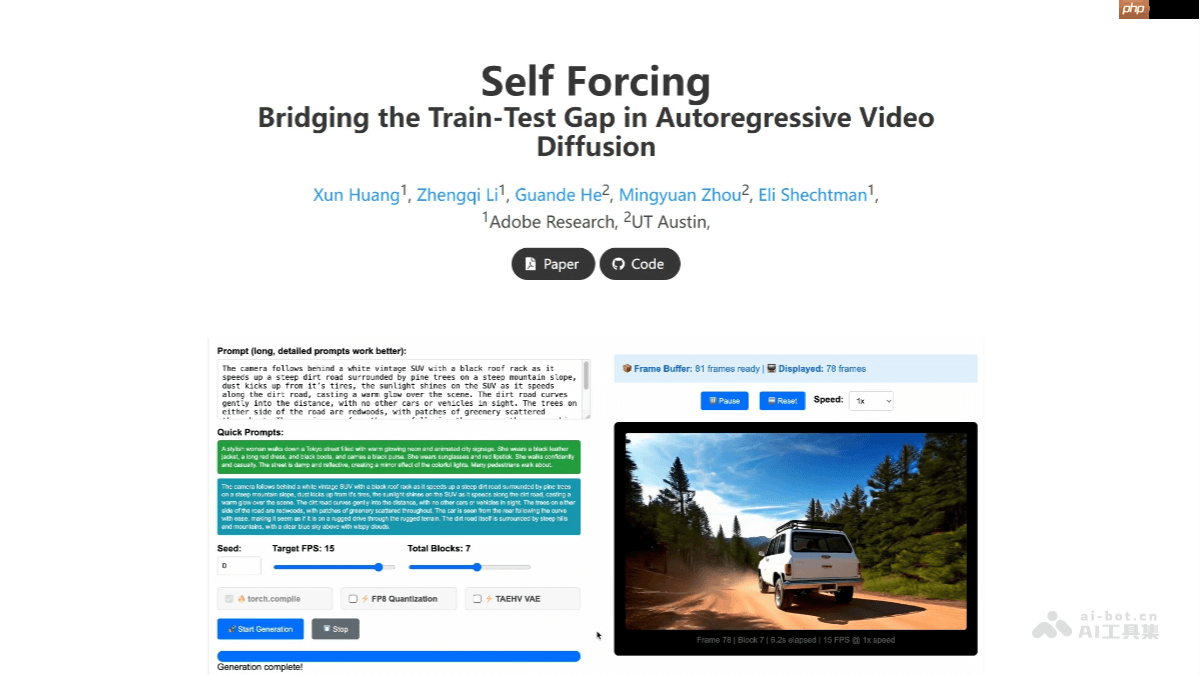

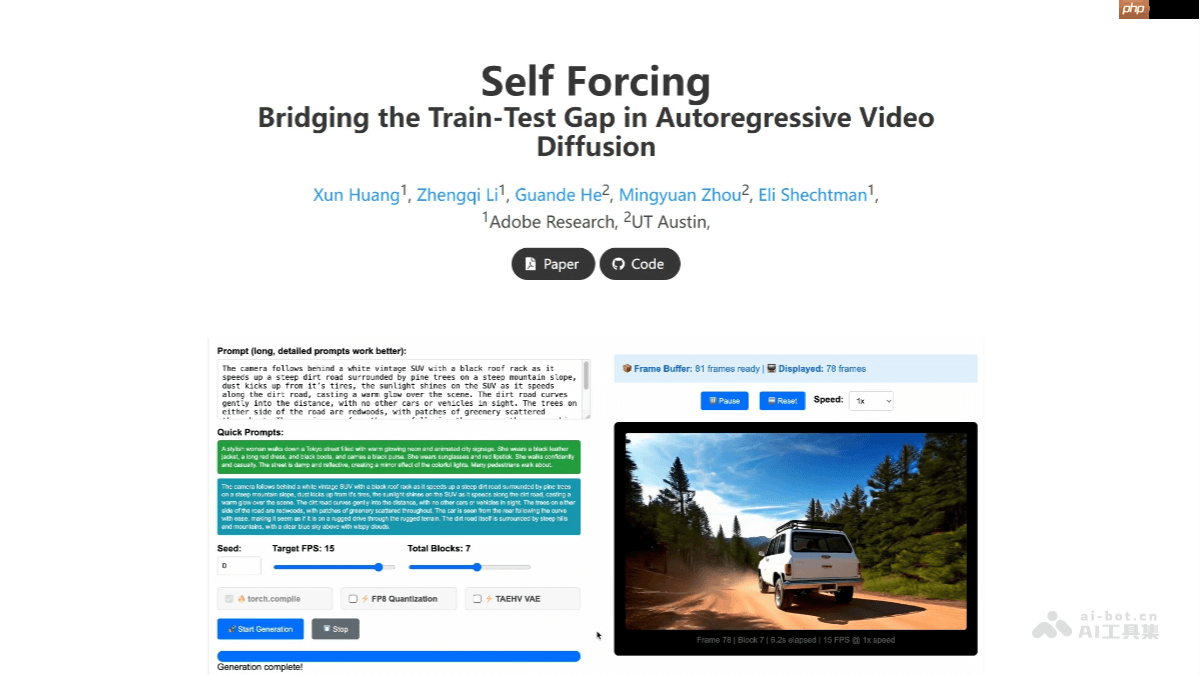

self forcing 是由 adobe research 联合德克萨斯大学奥斯汀分校推出的全新自回归视频生成算法,旨在解决传统生成模型在训练与测试阶段存在的暴露偏差问题。该方法通过在训练过程中模拟自生成机制,以先前生成的帧作为条件生成后续帧,而非依赖真实帧,从而有效缩小了训练与测试分布之间的差异。self forcing 引入了一种滚动 kv 缓存机制,支持理论上无限长度的视频生成,并能在单个 h100 gpu 上实现每秒 17 帧的实时生成速度,延迟控制在一秒以内。这项技术突破为直播、游戏及实时交互应用带来了新的可能性,例如可实时生成虚拟背景或特效内容。其高效性和低延迟特性使其成为未来多模态内容创作的重要工具。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

Self Forcing的核心功能

-

实时高效视频生成:Self Forcing 可在单个 GPU 上实现高效的实时视频输出,帧率可达 17 FPS,整体延迟低于一秒。

-

无限长度视频生成:借助滚动 KV 缓存机制,Self Forcing 支持理论上无限长的视频生成。能够持续产出视频内容而不会因长度限制中断,为动态视频创作提供强大支撑。

-

缩小训练与测试差距:在训练阶段,Self Forcing 模拟自生成流程,以模型自身生成的帧为条件继续生成后续帧,而不是使用真实帧。这种方式有效缓解了自回归生成中的暴露偏差问题,提升生成视频的质量和稳定性。

-

低资源消耗:Self Forcing 在计算资源利用方面进行了优化,可在单张 RTX 4090 显卡上实现流式视频生成,降低了对高性能硬件的依赖,便于在普通设备上部署。

-

支持多模态创作:Self Forcing 的高效率与实时性为多模态内容创作提供了便利,例如可在游戏直播中实时生成背景或特效,或在虚拟现实场景中动态构建视觉内容,拓展了创作者的应用边界。

Self Forcing的技术解析

-

自回归展开与全局损失监督:Self Forcing 在训练过程中模拟推理时的自回归生成方式,每一帧都基于模型之前生成的画面进行推导,而非真实画面。通过视频级别的整体分布匹配损失函数对整个序列进行监督,不仅限于逐帧评估。这使得模型能从自身的预测错误中学习,有效缓解暴露偏差。

-

滚动 KV 缓存机制:为实现长视频生成,Self Forcing 引入滚动键值(KV)缓存机制。该机制维护一个固定大小的缓存区,记录最近几帧的 KV 嵌入信息。当生成新帧时,缓存区会自动移除最旧条目并加入最新嵌入。

-

少量步数扩散模型与梯度截断策略:为了提高训练效率,Self Forcing 采用少步扩散模型,并结合随机梯度截断策略。具体而言,在训练过程中模型会随机选择去噪步骤数量,并仅对最终去噪步骤执行反向传播。

-

动态条件生成机制:在生成每一帧时,Self Forcing 动态融合两类条件输入:已生成的历史清晰帧与当前噪声帧。通过迭代去噪过程完成生成,确保生成结果连贯自然。

Self Forcing的项目链接

Self Forcing的实际应用场景

-

直播与实时视频流:Self Forcing 能在单个 GPU 上实现 17 FPS 的实时视频生成,延迟低于一秒。适用于直播场景,如实时生成虚拟背景、特效或动态场景,为观众带来全新的视觉体验。

-

游戏开发领域:在游戏开发中,Self Forcing 可用于实时生成游戏环境和特效,无需预先制作大量视频素材。可根据玩家操作动态生成环境变化或特效,增强沉浸感和互动性。

-

虚拟现实与增强现实应用:Self Forcing 的低延迟与高效生成能力可为 VR 和 AR 提供实时视觉内容。例如在 VR 场景中实时构建逼真虚拟世界,或在 AR 应用中叠加虚拟元素。

-

内容创作与视频编辑工具:Self Forcing 可集成至短视频创作平台,帮助创作者快速生成高质量视频内容。

-

世界模拟与训练用途:可用于构建世界模拟系统,例如生成逼真的自然景观或城市环境,服务于军事训练、城市规划或环境研究等领域。

以上就是Self Forcing— Adobe联合德克萨斯大学推出的视频生成模型的详细内容,更多请关注php中文网其它相关文章!

Self Forcing的核心功能

Self Forcing的核心功能