要使用python实现gpt-2文本生成,核心在于加载预训练模型并调用生成接口。1. 使用hugging face的transformers库安装依赖(transformers和torch);2. 通过pipeline快速生成或手动加载模型与分词器进行更精细控制;3. 设置生成参数如max_length、do_sample、top_k、top_p以平衡多样性与连贯性;4. 提供合适的prompt引导生成内容;5. 考虑部署时的资源消耗、生成速度、内容安全及依赖管理问题。整个过程依托于gpt-2的自回归预测机制,基于已有文本预测下一个词,循环生成完整文本。

要用Python实现文本生成,特别是利用像GPT-2这样的模型,核心在于理解其预训练模型和微调(如果需要)的流程。简单来说,就是加载一个预训练好的GPT-2模型,然后通过它来预测下一个词,循环往复,直到生成一段完整的文本。Hugging Face的transformers库是这里的关键工具,它极大地简化了模型的加载和使用。

说实话,第一次接触文本生成这东西,我感觉既兴奋又有点摸不着头脑。特别是像GPT-2这种大型模型,光是“生成”这两个字就充满了想象空间。在Python里实现它,其实比我想象的要直接一些,多亏了Hugging Face的transformers库,它真的把很多底层复杂性给封装好了。

我的做法通常是这样:

立即学习“Python免费学习笔记(深入)”;

你得确保环境里有transformers和torch(或者tensorflow,看你偏好哪个后端)。

# pip install transformers torch

然后就是加载模型和分词器。这一步,我个人觉得是最有意思的,因为你就在这里决定了你要用哪个“大脑”来生成文本。GPT-2有不同大小的版本,比如gpt2、gpt2-medium、gpt2-large,甚至gpt2-xl。选哪个,得看你的计算资源和对生成质量的要求。我通常会从gpt2开始,因为它相对轻量,适合快速实验。

from transformers import pipeline, set_seed

# 方式一:使用pipeline,最简单

generator = pipeline('text-generation', model='gpt2')

# 如果你想保持生成结果的一致性,调试时可以设置随机种子

# set_seed(42)加载完模型,接下来就是生成文本了。这里面有很多参数可以玩,比如max_length(生成文本的最大长度)、num_return_sequences(生成多少个不同的序列)、do_sample(是否采样,设为True通常能得到更多样化的结果,否则会倾向于重复)、top_k、top_p(这些是控制采样多样性的策略,挺有意思的,可以避免生成过于离谱或过于重复的词)。

我通常会给它一个“引子”(prompt),然后让它自由发挥。比如说,我想让它写一段关于未来科技的文字:

prompt_text = "在未来,人工智能将彻底改变我们的生活方式,"

generated_texts = generator(prompt_text, max_length=100, num_return_sequences=3, do_sample=True, top_k=50, top_p=0.95)

for i, gen_text in enumerate(generated_texts):

print(f"--- 生成结果 {i+1} ---")

print(gen_text['generated_text'])

print("\n")

# 如果你需要更精细的控制,可以手动加载分词器和模型,然后进行生成:

# from transformers import AutoTokenizer, AutoModelForCausalLM

# tokenizer = AutoTokenizer.from_pretrained('gpt2')

# model = AutoModelForCausalLM.from_pretrained('gpt2')

# inputs = tokenizer(prompt_text, return_tensors='pt')

# # 如果有GPU,可以把模型和输入移到GPU上:

# # if torch.cuda.is_available():

# # model.to('cuda')

# # inputs = {k: v.to('cuda') for k, v in inputs.items()}

# outputs = model.generate(inputs.input_ids, max_length=100, num_return_sequences=3, do_sample=True, top_k=50, top_p=0.95)

# for i, output in enumerate(outputs):

# print(f"--- 生成结果 {i+1} ---")

# print(tokenizer.decode(output, skip_special_tokens=True))

# print("\n")这里头有个小细节,就是do_sample=True和top_k、top_p的组合。如果你不设置do_sample=True,模型会倾向于每次都选择概率最高的词,结果就是生成的内容可能非常死板,甚至重复。而top_k和top_p则是为了在采样的基础上,进一步控制生成的“随机性”和“质量”。top_k是只从概率最高的K个词中选择,top_p则是从累积概率达到P的词中选择。我个人比较喜欢调整top_p,它能更好地平衡生成的多样性和连贯性。

有时候生成的文本会有点奇怪,或者逻辑上不通,这很正常。毕竟GPT-2是基于互联网海量文本训练的,它学习的是语言模式,而不是真正的“理解”世界。所以,把它当成一个非常高级的“语言预测机”会更准确。

GPT-2文本生成的核心原理是什么?

谈到GPT-2,它最核心的原理其实就是“预测下一个词”。听起来很简单,对吧?但这个简单背后,蕴含的是一种非常强大的自回归(autoregressive)模型结构。GPT-2是一个基于Transformer架构的解码器(decoder-only)模型。这意味着它在生成文本时,只关注已经生成的部分,并利用这些信息来预测下一个词。它不像传统的循环神经网络(RNN)那样,需要从头到尾地处理序列,Transformer的自注意力机制(self-attention mechanism)让它能同时关注输入序列中的所有词,并理解它们之间的复杂关系。

我记得第一次深入了解Transformer的时候,感觉像打开了新世界的大门。那种并行处理能力,以及对长距离依赖的捕捉,确实是革命性的。GPT-2正是凭借这种强大的结构,在海量无监督文本数据上进行了预训练。它并没有被明确告知“这是猫,那是狗”,而是通过预测文本中缺失的词、或者根据上文预测下文,从而学习到了语言的统计规律、语法结构,甚至是一些常识性的知识。

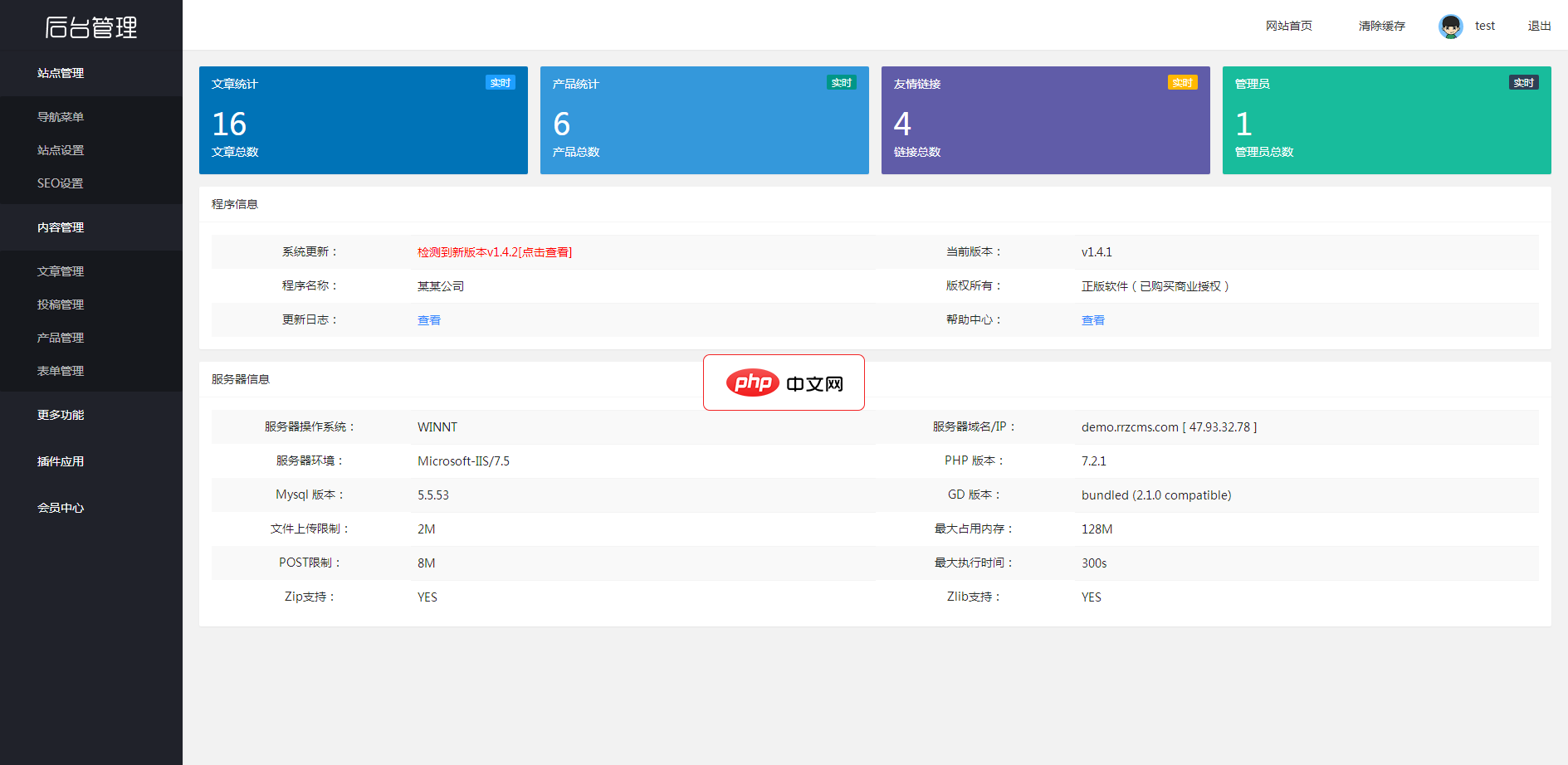

响应式黑色展台设计整站模板,自带内核安装即用,图片文本实现可视化,方便修改,支持多种内容模型及自定义功能,可根据需要自行添加。模板特点: 1、安装即用,自带人人站CMS内核及企业站展示功能(产品,新闻,案例展示等),并可根据需要增加表单 搜索等功能(自带模板) 2、支持响应式 3、前端banner轮播图文本均已进行可视化配置 4、伪静态页面生成 5、支持内容模型、多语言、自定义表单、筛选、多条件搜

所以,当你给GPT-2一个开头,比如“天空是蓝色的,因为...”,它会根据训练中学到的模式,预测接下来最可能出现的词。这个预测过程是概率性的,它会给每个可能的词分配一个概率值。通过重复这个过程,一个词接一个词地生成,最终就形成了一段完整的文本。这个过程有点像我们人类在填空或者续写故事,只不过GPT-2的速度和知识广度远超我们。但它没有“理解”这个概念,它只是一个极其优秀的模式识别器。这也是为什么有时候它会生成一些听起来很合理但细究起来又很荒谬的内容。

如何优化GPT-2的文本生成效果?

优化GPT-2的文本生成效果,这可是一个实践性很强的话题,也是我经常会去琢磨的地方。单纯地运行模型,你可能会得到一些“看起来像那么回事”但质量不高的文本。要让它真正好用,需要一些策略。

首先,也是最直接的,是调整生成参数。前面提到的max_length、num_return_sequences、do_sample、top_k、top_p这些,就是你的“调音台”。

- 如果你想要更连贯、更保守的文本,可以尝试把

top_p设得低一些(比如0.7或0.8),或者干脆不使用do_sample(虽然这样文本会比较死板)。 - 如果想追求多样性和创意,

top_p可以设高一些(比如0.95),top_k也适当放宽。但要注意,太高的top_p可能会导致生成一些不着边际的内容。我通常会尝试不同的组合,看看哪种最符合我的预期。

其次,精心设计你的“引子”(prompt)至关重要。GPT-2是一个条件生成模型,它会根据你给的开头来续写。一个好的引子,应该包含足够的信息,明确你想要生成的主题、风格甚至语气。比如,如果你想生成一篇科幻小说,你的引子可以这样写:“在一个遥远的星系,名为泽塔-9的星球上,人类发现了一种前所未见的能量晶体,它散发着幽蓝的光芒,预示着一场即将到来的变革...” 相比于简单的“科幻小说”,这样的引子能给模型提供更多上下文和方向。

再来,微调(Fine-tuning)是一个更高级的优化手段。如果你有特定领域的数据,比如医学文本、法律文书或者特定风格的小说,你可以用这些数据在预训练的GPT-2模型基础上进行二次训练。这会让模型更好地适应你的特定领域和风格。不过,微调需要更多的数据、计算资源和专业知识,而且训练过程中可能会遇到过拟合(overfitting)的问题,需要仔细调整学习率和训练步数。我个人在尝试微调时,发现数据质量和数量是决定成败的关键。哪怕是几千条高质量的领域文本,也比几十万条泛泛的通用文本效果好。

最后,后处理也是不可忽视的一环。即使模型生成了不错的文本,它可能仍然包含一些重复的短语、不通顺的句子,或者与预期不符的内容。这时候,人工的筛选、编辑和润色就显得尤为重要了。对于一些自动化场景,你可能还需要编写一些规则或使用另一个模型来过滤掉低质量的生成结果。这就像一个编辑,最终决定哪些内容可以呈现给读者。

在Python中部署GPT-2文本生成有哪些注意事项?

在Python里把GPT-2跑起来进行文本生成,表面上看很简单,几行代码就能搞定。但如果真的要把它用在实际项目里,或者说部署起来,那可就得考虑不少事情了。我在这方面也踩过一些坑,所以有些心得想分享。

首先是模型大小和资源消耗。GPT-2模型不小,特别是gpt2-large或gpt2-xl,它们动辄几百兆甚至上G。这意味着加载模型本身就需要时间和内存。如果你在内存有限的环境(比如一些云函数的免费层)里运行,很可能直接OOM(Out Of Memory)。而且,每次生成文本,特别是max_length设得比较长、num_return_sequences比较多的时候,计算量也相当可观,CPU跑起来会很慢,有GPU的话会快很多。所以在部署前,一定要评估好你的硬件资源。

其次是生成速度与延迟。对于需要实时响应的应用,比如聊天机器人或者内容辅助写作工具,生成速度是关键。纯CPU环境下,生成一段几十个词的文本可能需要几秒甚至更长,这对于用户体验来说是不可接受的。这时候,考虑使用GPU加速是必然选择。如果无法使用GPU,可以考虑一些优化手段,比如模型量化(quantization)来减小模型大小和计算量,或者使用ONNX Runtime等工具进行推理优化。但这些优化通常会增加部署的复杂性。

再来就是模型的安全性与偏见。GPT-2是在海量互联网数据上训练的,这意味着它可能会学习到数据中存在的偏见、不当言论甚至仇恨言论。当你让它生成文本时,这些偏见可能会被放大并体现出来。所以,在生产环境中部署时,必须有严格的内容审核机制。这可能包括关键词过滤、敏感词检测,甚至使用另一个分类模型来判断生成内容的安全性。我个人在测试时就遇到过模型生成一些不那么“政治正确”的内容,这确实是一个严肃的问题,需要开发者高度重视。

还有就是版本管理和依赖。Python项目,特别是涉及到深度学习库的,依赖管理是个老大难问题。transformers库、PyTorch或TensorFlow的版本兼容性,以及CUDA版本(如果用GPU)等等,都可能导致各种奇怪的错误。我通常会使用