BlenderFusion简介

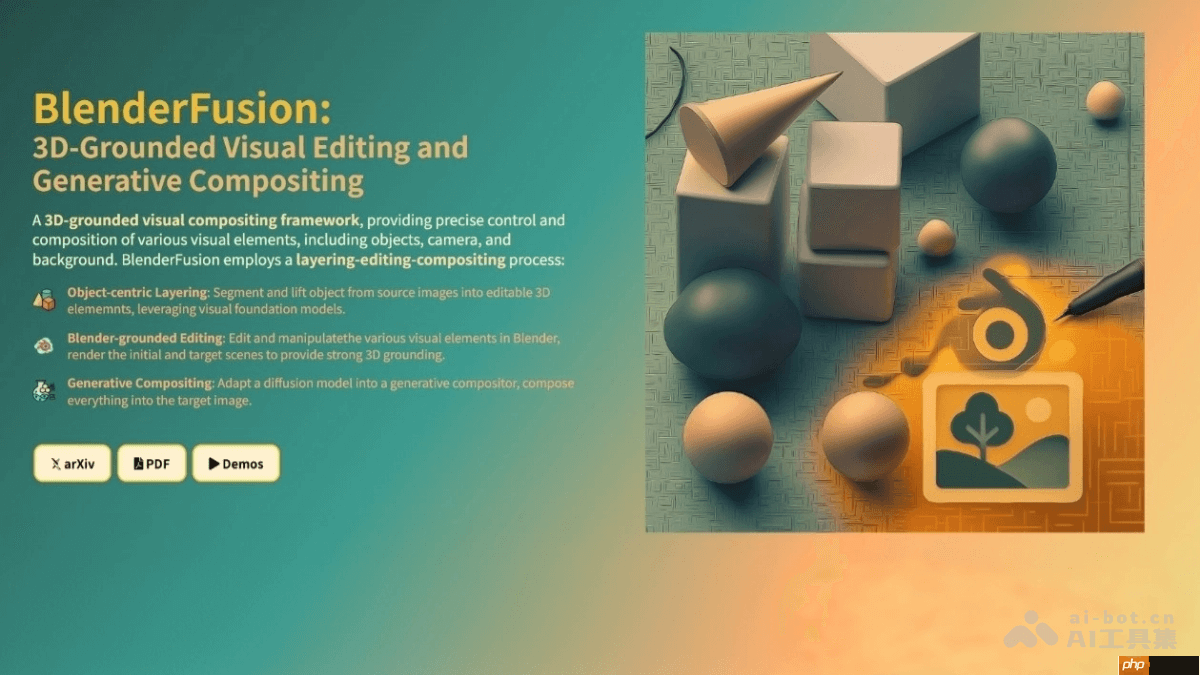

blenderfusion是由google deepmind开发的一种生成式视觉合成框架,它将传统的3d建模工具blender与ai模型整合,实现对几何结构的精准编辑以及多样化的视觉内容合成。该框架主要通过三个步骤完成任务:首先从源图像中提取目标对象,并将其转换为可操作的3d元素(对象中心化分层);接着在blender中对这些对象进行多种方式的编辑(基于blender的编辑);最后利用生成式合成器将修改后的元素无缝融合,生成高质量的最终图像(生成合成)。blenderfusion在复杂的视觉合成任务中表现出色,能够灵活、独立地控制对象、相机和背景,并具备3d感知能力。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

BlenderFusion的核心功能

BlenderFusion的核心功能

- 高精度的3D几何调整:借助Blender的强大功能,实现对对象的位置、旋转角度、缩放比例等变换操作,同时支持颜色、材质及形状等属性的精细调节。

- 自由的相机视角操控:允许用户独立于对象操作来调整相机视角,实现多变的视觉呈现。

- 高级场景合成能力:将修改后的对象自然融合到背景中,生成逼真的图像,支持多个对象的同时操作以及复杂场景的构建。

- 解耦的对象与视角控制:可在固定相机的前提下调整对象位置,或在对象不变的情况下改变相机参数,提供高度灵活的操作方式。

- 广泛的适用性:适用于各种未曾训练过的场景与对象,满足从简单到复杂的各类编辑需求,包括多阶段渐进式编辑。

BlenderFusion的技术机制

- 对象中心化分层处理:通过视觉基础模型(如SAM2用于分割,Depth Pro用于深度估计)从输入图像中识别并提取对象,转化为可编辑的3D元素。也可以选用图像转3D模型(例如Rodin、Hunyuan3D)生成完整的3D网格,并与2.5D表面网格对齐,便于后续灵活编辑。

- 基于Blender的编辑流程:将前一步得到的3D对象导入Blender软件中,利用其强大功能进行全方位编辑,包括基本变换、属性调整、非刚性形变等。此外还支持相机参数设置和背景替换,为合成过程提供精确的3D控制信号。

- 生成式合成技术:采用扩散模型驱动的合成器,将Blender渲染的结果与背景融合,输出高质量图像。该合成器采用双流架构,分别处理原始场景(编辑前)与目标场景(编辑后),并通过交叉视图注意力机制融合两者信息。结合源遮罩(source masking)和模拟对象抖动(simulated object jittering)两种训练策略,增强模型在复杂编辑任务中的灵活性和控制解耦能力。

BlenderFusion的相关链接

- 官方网站:https://www.php.cn/link/a5a922ea078f7e063b2fde0fc5cd3e08

- 论文地址:https://www.php.cn/link/27cd72a0f1d3cd199480de09512d9612

BlenderFusion的实际应用

- 影视特效制作:用于电影和电视剧的视觉效果创作,如添加虚拟角色、调整布景布局、更换背景等,打造真实感十足的合成画面。

- 游戏环境设计:帮助游戏开发者快速构建和修改游戏场景,灵活调整游戏元素和视角,创造沉浸式的游戏体验。

- 广告视觉设计:协助设计师制作高质量的产品展示图,突出产品卖点,提升视觉吸引力。

- 建筑可视化设计:供建筑师和室内设计师使用,用于家具和装饰品的布置与调整,生成高质量的室内外效果图。

- 数字艺术创作:艺术家可以利用其3D编辑与图像合成能力,创作独特的数字艺术作品,实现创意表达。