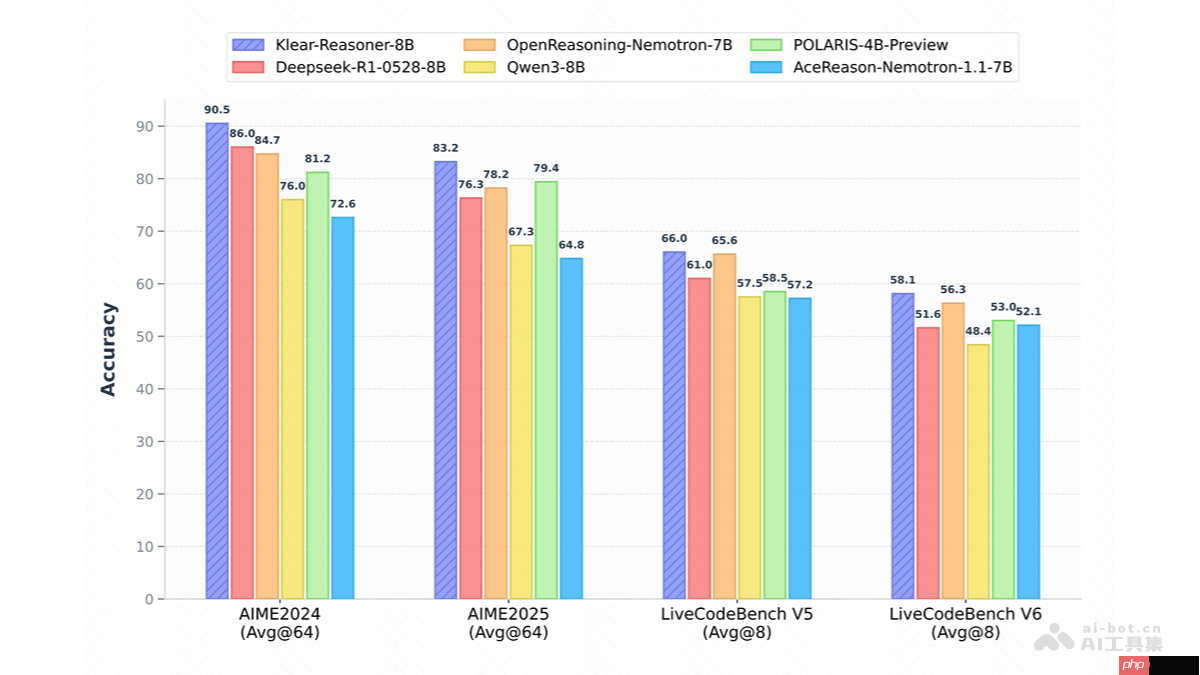

klear-reasoner 是由快手团队推出的一款基于 qwen3-8b-base 的推理优化模型,专注于增强数学解题与代码生成方面的深度推理能力。该模型通过长思维链监督微调(long cot sft)和强化学习(rl)策略进行训练,其核心创新在于提出了一种名为 gppo 的新型优化算法。该算法通过保留传统剪裁操作中被丢弃的梯度信息,有效缓解了传统方法在探索能力受限和负样本收敛缓慢上的问题,在 aime、livecodebench 等权威评测中表现卓越,达到当前 8b 规模模型的领先水平。值得一提的是,klear-reasoner 的完整训练流程与技术细节均已公开,为后续推理模型的研究与复现提供了宝贵参考。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

Klear-Reasoner的核心功能

Klear-Reasoner的核心功能

- 数学问题求解:在处理复杂数学任务方面表现突出,能够应对高难度数学竞赛题目,展现出强大的逻辑推理与多步演算能力。

- 代码生成与理解:具备高效的代码生成能力,在 LiveCodeBench V5 和 V6 测试中分别取得了 66.0% 和 58.1% 的准确率,验证了其在编程任务中的实用性。

- 长链推理支持:通过引入长思维链监督微调与强化学习机制,显著提升了模型在多阶段、长链条推理任务中的连贯性与准确性。

- 高质量数据训练策略:训练过程中优先采用高可信度的数据源,减少噪声干扰;同时保留部分错误样本,以增强模型在复杂场景下的探索与纠错能力。

Klear-Reasoner的底层技术架构

- 长思维链监督微调(long CoT SFT):利用高质量、结构清晰的思维链数据进行监督训练,确保模型掌握正确的推理路径。精选少数优质数据源,避免低质数据污染模型学习过程。同时,有选择地保留部分错误样本,尤其在高难度任务中,提升模型的试错与探索潜力。

- 强化学习优化(RL):在监督微调基础上引入强化学习,进一步提升模型在数学与编程任务中的推理表现。采用软奖励机制,根据测试用例的通过比例给予梯度反馈,有效缓解奖励稀疏问题,提高训练稳定性。

- GPPO(Gradient-Preserving Clipping Policy Optimization)算法:针对传统 PPO 和 GRPO 中因梯度剪裁导致高熵 token 梯度丢失、探索受限的问题,GPPO 创新性地将剪裁操作与反向传播解耦。通过 stop-gradient 机制,保留所有 token 的梯度信息:对高熵 token 限制梯度范围以维持探索,对负样本 token 保留梯度并控制更新幅度,从而加速错误纠正过程。

- 软奖励机制设计:在代码生成任务中,采用基于测试用例通过率的连续型奖励(软奖励),相比传统的“全有或全无”硬奖励,能提供更密集的训练信号,降低梯度方差,使模型学习更加平稳高效。

Klear-Reasoner的开源资源

- GitHub 项目地址:https://www.php.cn/link/a1ff59c9fcd256be3695bb06465e1011

- HuggingFace 模型页面:https://www.php.cn/link/340906ef68f7888651490d4b3798ec70

- arXiv 技术论文链接:https://www.php.cn/link/4c1f53116d73ff13367ffbfd35d8a105

Klear-Reasoner的实际应用方向

- 智能教育辅助:作为虚拟数学导师,为学生提供详尽的解题思路与分步推导,帮助理解抽象概念,提升学习效率。

- 程序开发支持:自动完成代码编写、函数生成与逻辑补全,协助开发者快速构建功能模块,并提供潜在错误提示与优化建议。

- 金融分析决策:应用于金融领域的数据建模与风险预测,通过严谨的逻辑推理支持投资策略制定与市场趋势判断。

- 科研与数据分析:胜任复杂的科学计算与数据推理任务,为研究人员提供可解释的分析路径,加速实验设计与结果验证。

- 智能客服系统:用于处理用户提出的复杂咨询问题,结合清晰的推理过程给出精准回答,提升服务响应质量与用户体验。