Wan2.2-S2V是什么

wan2.2-s2v 是一款开源的多模态视频生成模型,仅需一张静态图像和一段音频输入,即可生成电影级别的数字人视频,支持分钟级长视频输出,并兼容多种图片类型与画面比例。用户还可通过文本提示(prompt)对生成画面进行灵活控制,实现更丰富的视觉表现。该模型融合多项前沿技术,支持音频驱动下的复杂场景建模、长时间稳定生成以及多分辨率训练与推理,在数字人直播、影视创作、ai教育等多个领域具备广泛应用前景。

☞☞☞AI 智能聊天, 问答助手, AI 智能搜索, 免费无限量使用 DeepSeek R1 模型☜☜☜

Wan2.2-S2V的主要功能

-

高质量视频生成:结合单张静态图与音频,生成细节逼真、动作自然的数字人视频,时长可达数分钟。

-

多样化图像兼容:支持真人、卡通角色、动物、虚拟数字人等多种图像类型,涵盖头像、半身、全身等不同构图。

-

文本引导控制:通过输入文本提示,调控视频中人物动作、表情及背景变化,增强画面动态表现力。

-

长时视频稳定生成:采用层次化帧压缩机制,显著提升长时间视频生成的连贯性与稳定性。

-

多分辨率适配:支持从低清到高清等多种分辨率输出,满足不同平台和设备的应用需求。

Wan2.2-S2V的技术原理

-

多模态协同建模:基于通义万相视频生成底座,融合文本引导的全局动作规划与音频信号驱动的局部精细运动。

-

AdaIN 与 CrossAttention 控制机制:引入自适应实例归一化(AdaIN)和交叉注意力(CrossAttention),实现对复杂表情与姿态的精准控制。

-

层次化帧压缩技术:将历史参考帧数量扩展至73帧,有效维持长时间生成过程中的时序一致性。

-

大规模混合并行训练:构建包含超60万音视频片段的数据集,利用全参数微调与分布式训练策略提升模型泛化能力。

-

多分辨率训练与推理架构:设计灵活的分辨率适配方案,支持不同尺寸输入输出,适应多样化应用场景。

Wan2.2-S2V的项目地址

如何使用Wan2.2-S2V

-

本地部署运行

-

获取源码:前往 HuggingFace 模型库下载项目代码。

-

安装依赖环境:依据项目文档配置 Python 环境及所需第三方库。

-

准备输入素材:准备一张人物或角色图片、一段语音音频,以及可选的文本控制指令。

-

执行生成脚本:按照说明运行生成脚本,输出定制化视频内容。

-

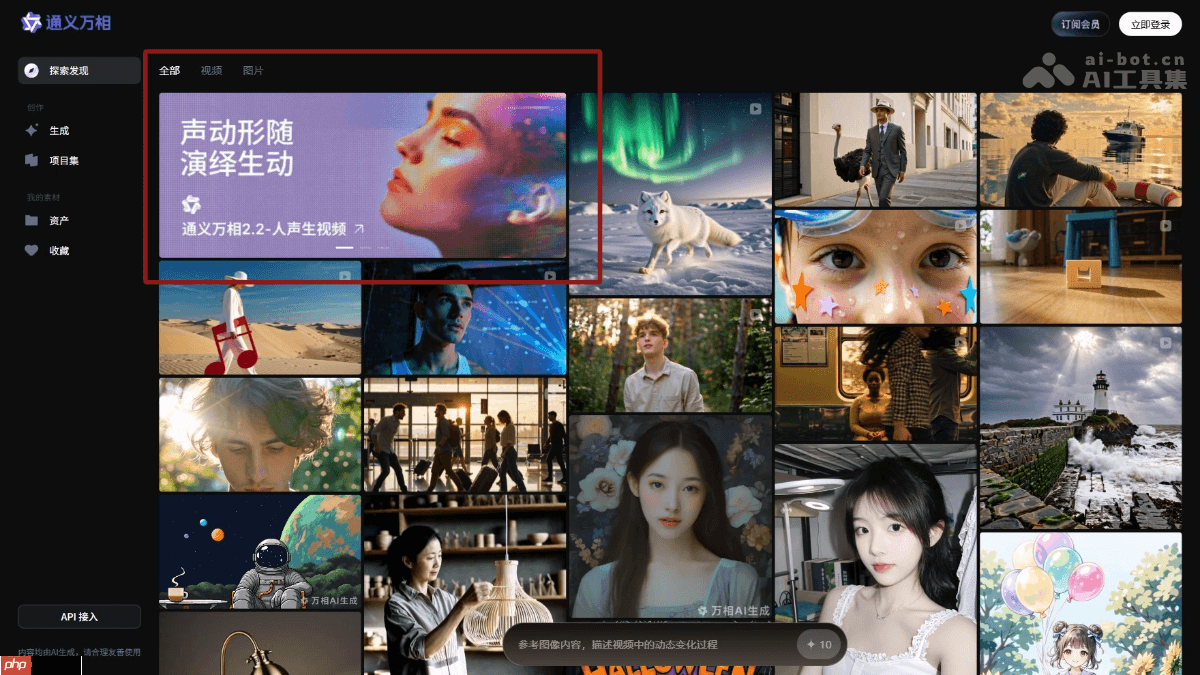

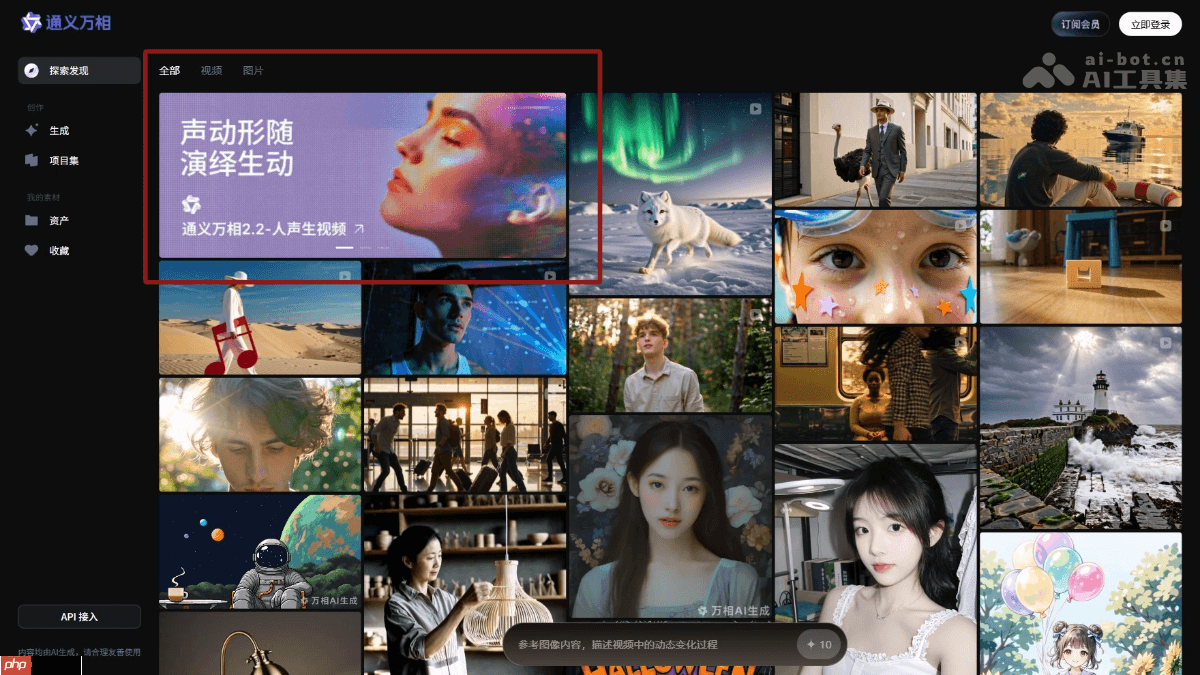

在线平台体验

-

访问官网:进入通义万相官方网站。

-

上传素材:上传图片与音频文件,并填写文本提示词。

-

启动生成:点击“生成”按钮,等待系统处理完成后下载结果视频。

Wan2.2-S2V的应用场景

-

数字人直播:快速生成表情自然、口型同步的虚拟主播视频,降低人力成本,提升直播效率。

-

影视内容制作:为动画、短剧等提供高效的虚拟角色表演方案,减少实拍投入与后期制作周期。

-

AI辅助教学:生成个性化讲解视频,使课程内容更具吸引力,提升学习体验与参与度。

-

社交内容创作:帮助创作者高效产出短视频内容,增强账号互动性与粉丝粘性。

-

智能客服系统:打造拟人化的虚拟客服形象,实现24小时自动化服务,优化用户体验。

以上就是Wan2.2-S2V— 阿里通义开源的多模态视频生成模型的详细内容,更多请关注php中文网其它相关文章!

Wan2.2-S2V的主要功能

Wan2.2-S2V的主要功能